Материалы по тегу: nvidia

|

26.04.2024 [11:46], Сергей Карасёв

HPE построила самый мощный в Польше суперкомпьютер Helios производительностью 35 ПфлопсКомпания HPE сообщила о создании нового суперкомпьютера под названием Helios для Академического компьютерного центра Cyfronet Научно-технического университета AGH в Кракове (Польша). Вычислительный комплекс будет использоваться для решения ресурсоёмких задач, связанных с ИИ. На сегодняшний день Helios — самая высокопроизводительная система в Польше. Она обеспечивает теоретическую пиковую производительность на уровне 35 Пфлопс, что более чем в четыре раза превосходит показатель предыдущего флагманского суперкомпьютера Cyfronet. Пиковое быстродействие на ИИ-операциях достигает 1,8 Эфлопс. В основу Helios положены узлы HPE Cray EX. Комплекс состоит из трёх сегментов. Один из них предназначен для традиционных вычислений, еще один — для рабочих нагрузок, связанных с обработкой больших данных. Третий сегмент оптимизирован для ИИ-задач: он использует суперчипы NVIDIA. Суперкомпьютер планируется применять при реализации проектов в области химии, медицины, создания передовых материалов, астрономии и защиты окружающей среды. Раздел общего назначения использует процессоры AMD EPYC поколения Genoa. Общее количество вычислительных ядер Zen 4 составляет 75 264, объём оперативной памяти DDR5 — 200 Тбайт. Сегмент для работы с большими данными основан на платформе HPE Cray Supercomputing XD665 с чипами EPYC Genoa, памятью DDR5-4800, быстрыми накопителями NVMe и ускорителями NVIDIA H100, суммарное количество которых равно 24.

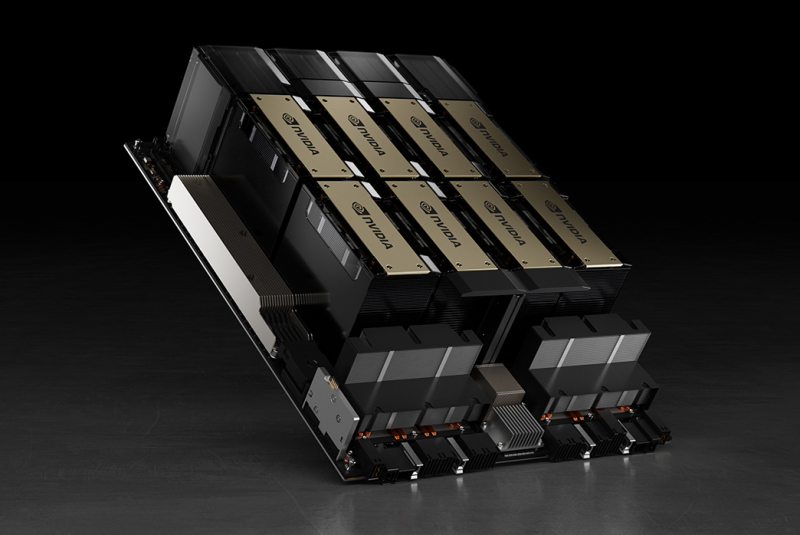

Источник изображения: HPE Наконец, ИИ-раздел объединяет 440 суперчипов NVIDIA GH200 Grace Hopper для компьютерного моделирования с интенсивным использованием графики, поддержки приложений на основе генеративного ИИ и пр. Все компоненты вычислительного комплекса связаны друг с другом посредством 200G-интерконнекта HPE Slingshot. Комплекс Helios оснащён Lustre-хранилищем общей вместимостью 17,5 Пбайт на базе HPE Cray ClusterStor E1000.

24.04.2024 [23:45], Владимир Мироненко

NVIDIA приобрела за $700 млн платформу оркестрации ИИ-нагрузок Run:aiКомпания NVIDIA объявила о приобретении стартапа Run:ai из Тель-Авива (Израиль), занимающегося разработкой ПО для управления рабочими нагрузками и оркестрации на базе Kubernetes, которое позволяет более эффективно использовать вычислительные ресурсы при работе с ИИ-приложениями. Стоимость сделки не раскрывается. По данным TechCrunch, покупка обошлась NVIDIA в $700 млн. Это одно из крупнейших приобретений Nvidia с момента покупки Mellanox за $6,9 млрд в марте 2019 года. Два года назад NVIDIA купила Bright Computing, разработчика решений для управления НРС-кластерами. NVIDIA отметила, что развёртывание ИИ-приложениЙ становится всё более сложным. Оркестрация генеративного ИИ, рекомендательных и поисковых систем, а также других рабочих нагрузок требует сложного планирования для оптимизации производительности. ПО Run:ai позволяет управлять и оптимизировать вычислительную инфраструктуру как локально, так и в облаке или в гибридных средах.

Источник изображения: NVIDIA Созданная стартапом открытая платформа поддерживает все популярные варианты Kubernetes и интегрируется со сторонними инструментами и платформами ИИ. Компании из различных отраслей используют платформу Run:ai для управления кластерами ускорителей в масштабе ЦОД. Как сообщается, на относительно раннем этапе деятельности Run:ai удалось создать большую клиентскую базу из компаний из списка Fortune 500, что позволило привлечь венчурные инвестиции. Перед сделкой Run:ai привлекла капитал в размере $118 млн от ряда инвесторов, включая Insight Partners, Tiger Global, S Capital и TLV Partners. NVIDIA заявила, что в ближайшем будущем продолжит предлагать продукты Run:ai в рамках той же бизнес-модели, а также продолжит инвестировать в развитие Run:ai в рамках платформы NVIDIA DGX Cloud, предоставляющей корпоративным клиентам доступ к вычислительной инфраструктуре и ПО для обучения моделей генеративного и других форм ИИ. Решения Run:ai уже интегрированы с NVIDIA DGX, NVIDIA DGX SuperPOD, NVIDIA Base Command, контейнерами NGC, ПО NVIDIA AI Enterprise и другими продуктами. По словам NVIDIA, пользователи серверов и рабочих станций NVIDIA DGX, а также DGX Cloud также получат доступ к возможностям Run:ai, что особенно полезно при развёртывании генеративного ИИ в нескольких ЦОД.

22.04.2024 [21:30], Сергей Карасёв

Microsoft к концу 2024 года планирует использовать до 1,8 млн ИИ-ускорителей на базе GPUКорпорация Microsoft, по сообщению ресурса Business Insider, в течение 2024 года намерена утроить количество ускорителей на базе GPU в составе своей вычислительной ИИ-инфраструктуры. В результате, как ожидается, к декабрю общее количество таких изделий, находящихся в распоряжении редмондского гиганта, может достичь 1,8 млн. Два года назад у Microsoft было несколько сотен тысяч ускорителей, в том числе FPGA и ASIC. Microsoft в партнёрстве с OpenAI реализует комплексную программу по развитию ИИ-систем. В частности, планируется строительство масштабного кампуса ЦОД под названием Stargate стоимостью $100 млрд. Средства, как уточняет Business Insider, пойдут в том числе на закупку GPU-ускорителей. Аналитики DA Davidson подсчитали, что в прошлом году Microsoft потратила приблизительно $4,5 млрд на приобретение ИИ-ускорителей NVIDIA. Один из руководителей Microsoft подтвердил, что эта цифра близка к фактическим расходам корпорации в рассматриваемом сегменте. Microsoft также проектирует собственные ИИ-чипы, которые помогут снизить зависимость от сторонних поставщиков. Так, она уже представила свой первый ИИ-ускоритель Maia 100, который спроектирован под задачи облачного обучения и инференса в сценариях с использованием моделей OpenAI, Bing, GitHub Copilot и ChatGPT в инфраструктуре Azure. Однако некоторые специалисты относятся скептически к этим усилиям Microsoft, поскольку корпорация на годы отстаёт от NVIDIA в плане создания мощных ИИ-решений. Business Insider со ссылкой на документацию Microsoft сообщает, что во II половине 2023-го корпорация развернула «рекордные мощности GPU». Однако конкретные цифры и тип ускорителей не раскрываются. Другие крупные IT-компании и облачные провайдеры также продолжают наращивать ИИ-ресурсы. Например, Meta✴, как ожидается, к концу 2024 года будет иметь в своём распоряжении около 350 тыс. NVIDIA H100 и неназванное количество ускорителей собственной разработки MTIA v1 и MTIA v2. Некоторые игроки рынка присматриваются к конкурирующим решениям. Так, Dell намерена использовать ИИ-ускорители Intel Gaudi3, а стартап TensorWave разворачивает ИИ-облако из 20 тыс. ускорителей AMD Instinct MI300X.

18.04.2024 [13:23], Сергей Карасёв

Eviden и CEA анонсировали второй суперкомпьютер EXA1 — HE на базе Arm-суперчипов NVIDIA Grace HopperКомпания Eviden (дочерняя структура Atos) и Комиссариат по атомной и альтернативным видам энергии Франции (СЕА) объявили о реализации второй фазы суперкомпьютерной программы EXA1. Она предусматривает ввод в эксплуатацию НРС-комплекса EXA1 HE (High Efficiency) на платформе Eviden BullSequana XH3000. Первая очередь системы — EXA1 HF (High-Frequency) — была запущена в 2021 году. Основой послужила платформа BullSequana XH2000. Изначально машина включала 12 960 процессоров AMD EPYC 7763 (64C/128T, 2,45 ГГц), а её производительность на момент анонса составляла 23,2 Пфлопс. Комплекс EXA1 HE использует 477 вычислительных узлов на базе суперчипов NVIDIA Grace Hopper. Применяется жидкостное охлаждение тёплой водой. Заявленная производительность в тесте Linpack составляет приблизительно 60 Пфлопс, а пиковое быстродействие достигает 104 Пфлопс. Задействован фирменный интерконнект BXI (BullSequana eXascale Interconnect). Сеть основана на топологии DragonFly и состоит из 156 коммутаторов. Отмечается, что суперкомпьютер EXA1 соответствует требованиям оборонных программ, реализуемых военным отделом CEA.

Источник изображения: Eviden Отметим, что в марте нынешнего года компания Eviden заключила соглашение о модернизации французского НРС-комплекса Jean Zay. Суперкомпьютер получит 1456 ускорителей NVIDIA H100 в дополнение к 416 картам NVIDIA A100 и 1832 ускорителям NVIDIA V100, которые задействованы в настоящее время. В результате, пиковая производительность Jean Zay поднимется с нынешних 36,85 до 125,9 Пфлопс.

16.04.2024 [16:20], Сергей Карасёв

Завершено строительство Arm-суперкомпьютера Venado на базе суперчипов NVIDIA Grace HopperЛос-Аламосская национальная лаборатория (LANL) Министерства энергетики США объявила о завершении сборки НРС-комплекса Venado, предназначенного для решения сложных ресурсоёмких задач в области ИИ. В создании системы приняли участие компании HPE и NVIDIA. Проект Venado был анонсирован в мае 2022 года. Система смонтирована в Центре моделирования и симуляции Николаса К. Метрополиса (Nicholas C. Metropolis) в составе LANL. В церемонии открытия комплекса приняли участие представители Министерства энергетики США, Администрации по национальной ядерной безопасности США и других организаций. Venado — первый в США суперкомпьютер, построенный на суперчипах NVIDIA Grace и Grace Hopper с ядрами Arm. Суперкомпьютер построен на платформе HPE Cray EX. В общей сложности задействованы 2560 гибридных суперчипов Grace Hopper с прямым жидкостным охлаждением: эти изделия объединяют ядра Arm v9 и ускорители на архитектуре Hopper. Кроме того, в состав НРС-системы входят 920 суперчипов Grace. Узлы объединены интерконнектом HPE Slingshot 11.

Источник изображений: LANL На суперкомпьютере используется специализированное ПО HPE Cray, которое, как утверждается, позволяет оптимизировать рабочие нагрузки по моделированию и симуляции. Систему планируется использовать в таких областях, как материаловедение, возобновляемые источники энергии, астрофизика и пр. ИИ-производительность системы (FP8) составит около 10 Эфлопс. Машина также получит Lustre-хранилище.  «Являясь первым в США суперкомпьютером на базе NVIDIA Grace Hopper, система Venado обеспечивает революционную производительность и энергоэффективность для ускорения научных открытий», — говорит Ян Бак (Ian Buck), вице-президент HPC-подразделения NVIDIA. При этом Venado относится к классу экспериментальных суперкомпьютеров и будет использоваться для переноса и оптимизации имеющихся кодов, а также для создания нового ПО и проверки различных концепций.

16.04.2024 [15:17], Сергей Карасёв

Akamai запустила облако с ускорителями NVIDIA RTX для обработки видеоCDN-провайдер Akamai Technologies объявил о запуске нового облачного сервиса, оптимизированного для задач по обработке видеоматериалов. Услуга ориентирована прежде всего на компании в сфере медиа и развлечений, которым необходимы ресурсы для быстрого и эффективного создания контента. В основу системы положены ускорители NVIDIA RTX 4000 поколения Ada. Согласно результатам тестирования Akamai, использование этих GPU позволяет повысить производительность при кодировании и транскодировании видео примерно в 25 раз по сравнению с CPU. Akamai отмечает, что в настоящее время облачные инфраструктуры на базе ускорителей NVIDIA ориентированы в первую очередь на большие языковые модели (LLM) и приложения ИИ, тогда как медиасегменту уделяется недостаточное внимание. Новое облако как раз и призвано удовлетворить потребности заказчиков, которые работают с мультимедийным контентом, включая потоковое видео. Утверждается, что ускорители NVIDIA RTX 4000 обеспечивают скорость и энергоэффективность, необходимые для решения сложных творческих и инженерных задач по созданию цифрового контента, 3D-моделированию, рендерингу и пр.

Источник изображения: NVIDIA Отмечается, что GPU-ускорители позволяют выполнять транскодирование видеоматериалов со скоростью, превышающей потребности сервисов реального времени: благодаря этому значительно улучшается качество потоковой передачи. Кроме того, может осуществляться одновременное кодирование и декодирование материалов. Новый облачный сервис также подходит для работы с приложениями виртуальной (VR) и дополненной (AR) реальности. Хотя Akamai оптимизировала платформу для медиарынка, она может применяться для анализа данных и научных вычислений, рендеринга графики, задач ИИ и машинного обучения, моделирования и других ресурсоёмких операций. При этом Akamai всё быстрее превращается в распределённого облачного провайдера, а не просто оператора CDN.

15.04.2024 [14:23], Сергей Карасёв

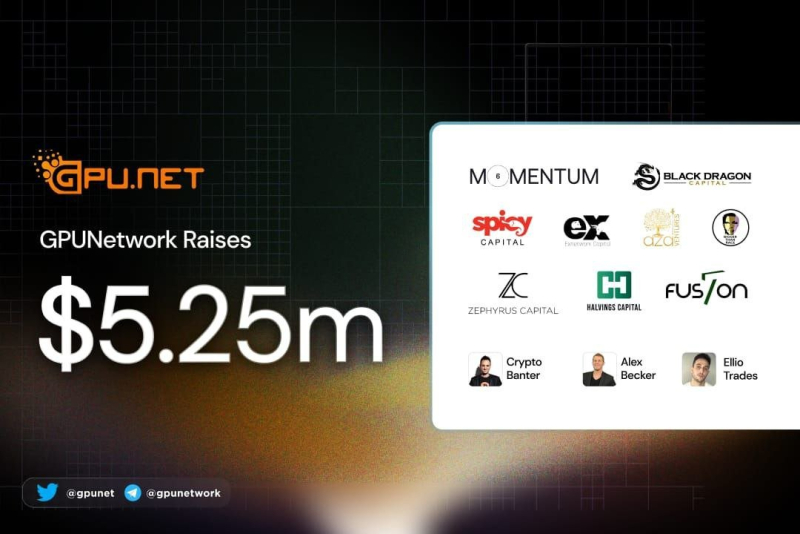

Стартап в области децентрализованных облачных ИИ-вычислений GPUnet получил на развитие $5,25 млнМолодая компания GPUnet, занимающаяся технологиями облачных вычислений, сообщила о проведении раунда финансирования Series A, в ходе которого привлечено $5,25 млн. В число инвесторов вошли Momentum6, Spicy Capital, Exnetwork, Blackdragon, Zephyrus Capital, Aza Ventures, F7 Foundation, Halvings Capital и Bigger than Race. Стартап GPUnet создаёт платформу децентрализованных облачных вычислений на базе GPU. Отмечается, что в свете стремительного развития технологий ИИ ускорители на базе GPU превратились в дефицитный ресурс. Вместе с тем в мировом масштабе четыре крупнейших поставщика облачных услуг — Amazon, Google, Microsoft и Oracle — контролируют 80 % соответствующих мощностей. В результате компании и исследовательские организации вынуждены либо подписываться на сервисы по значительной цене, либо закупать собственное оборудование. Но во втором случае требуются навыки управления ЦОД, а поставки ускорителей занимают много времени. GPUnet рассчитывает решить перечисленные проблемы путём объединения в единую сеть ресурсов независимых операторов дата-центров, которые специализируются на «вычислениях для проектов Web3», в частности, для майнинга. Отмечается, что такие операторы зачастую располагают ценными вычислительными ресурсами в небольших кластерах. GPUnet планирует использовать архитектуру распределённых вычислений, чтобы объединить кластеры в единую экосистему, создав удобную облачную среду для разработчиков и исследователей. На веб-сайте GPUnet говорится, что посредством новой платформы клиенты получают доступ к ускорителям NVIDIA. В частности, стоимость аренды H100 составляет $5/час, A100 — $1,5/час, А10 — $1/час. К 2030 году GPUnet рассчитывает объединить в своей экосистеме до 1 млн GPU.

13.04.2024 [23:25], Сергей Карасёв

Разработчик ИБ-решений Cohesity привлёк $150 млн, в том числе от IBM и NVIDIAПоставщик решений по обеспечению безопасности данных Cohesity сообщил о завершении раунда финансирования Series F: в качестве стратегических инвесторов выступили NVIDIA и IBM, а полученные средства будут направлены на повышении защиты и устойчивости гибридных облачных сред. Объём финансирования не раскрывается. Но ресурс SiliconANGLE, ссылаясь на информацию, полученную от Cohesity, уточняет, что инвесторы предоставили $150 млн. До этого компания привлекла на развитие $805 млн. Таким образом, на сегодняшний день общий объём финансирования приближается к $1 млрд. В начале года Cohesity приобрела у Veritas Technologies подразделение по защите данных. Ожидается, что капитализация объединённой компании составит порядка $7 млрд.

Источник изображения: Cohesity Одновременно Cohesity объявила о расширении сотрудничества с IBM в области кибербезопасности. Это партнёрство сосредоточено прежде всего на борьбе с утечками данных. Инструменты Cohesity интегрированы в платформу IBM Storage Defender, которая предназначена для борьбы с различными угрозами, включая программы-вымогатели, инсайдерские атаки и пр. По оценкам, в 2023 году средний убыток предприятий в связи с утечками данных составил $4,45 млн — это на 15 % больше по сравнению с тремя предыдущими годами. Ожидается, что решения Cohesity помогут корпоративным клиентам в восстановлении систем в случае деструктивных кибератак или утечек информации. В рамках сотрудничества в состав платформы IBM Storage Defender интегрировано решение Cohesity DataProtect — специализированный высокопроизводительный инструмент для резервного копирования и восстановления. Он предназначен для защиты данных от сложных киберугроз, предлагая комплексную защиту на основе политик для облачных и традиционных сред.

12.04.2024 [21:28], Сергей Карасёв

Dell сумела сократить сроки поставок ИИ-серверов, но теперь компания полагается не только на ускорители NVIDIA, но и на Intel Gaudi3Компании Dell, по сообщению The Register, удалось сократить сроки поставок серверов для задач ИИ в несколько раз. Речь идёт о высокопроизводительных системах с ускорителями на основе GPU, в том числе NVIDIA H100. Спрос на них настолько высок, что производители не справляются с потоком заказов. О текущей ситуации в отрасли рассказал руководитель тайваньского подразделения Dell Теренс Ляо (Terence Liao). В конце 2023 года срок поставок серверов Dell, оборудованных ускорителями H100, составлял в среднем 39 недель, или около 8–9 месяцев. По словам Ляо, с февраля 2024-го отгрузки продукции NVIDIA значительно улучшились, и Dell смогла уменьшить сроки поставок серверов до 8–12 недель, или 2–3 месяцев. Таким образом, время выполнения заказов уменьшилось в три–четыре раза. Тем не менее, дефицит высокопроизводительных ИИ-ускорителей сохраняется. Связано это в том числе с возможностями TSMC по выпуску чипов с применением технологии CoWoS (Chip on Wafer on Substrate). Именно компоновка CoWoS применяется при изготовлении Н100. В сентябре 2023 года спрос на передовые технологии упаковки чипов был настолько высоким, что TSMC заявила о способности удовлетворить только 80 % заказов. Вместе с тем TSMC сообщила о намерении расширить производственные мощности CoWoS на 20 % — это поможет смягчить проблему дефицита ИИ-ускорителей. Между тем Dell приходится искать альтернативы ускорителям NVIDIA. В частности, она намерена использовать ИИ-ускорители Intel Gaudi3. Поддержка Gaudi3 заявлена для сервера Dell XE9680, который также поддерживает ускорители AMD Instinct MI300X. Эта ИИ-платформа наделена 32 слотами для модулей памяти DDR5, восемью разъёмами PCIe 5.0 и шестью портами OSFP 800GbE. Возможна установка 16 накопителей EDSFF3.

11.04.2024 [15:23], Сергей Карасёв

Студенты США первыми в мире получили собственный ИИ-суперкомпьютер NVIDIAИнженерный колледж Технологического института Джорджии (Georgia Tech) объявил о заключении соглашения о сотрудничестве с NVIDIA с целью создания первого в мире суперкомпьютерного центра ИИ, предназначенного для обучения студентов. Проект получил название AI Makerspace. Отмечается, что AI Makerspace позволит демократизировать доступ к вычислительным ресурсам, которые традиционно были доступны только исследователям и технологическим компаниям. В рамках проекта студенты смогут использовать возможности НРС-комплекса для углубления своих навыков работы с ИИ. Это поможет в выполнении курсовых работ и позволит учащимся получить ценный практический опыт. Фактически AI Makerspace — это выделенный вычислительный кластер. В создании системы приняли участие специалисты Penguin Solutions. Применяется платформа для работы с ИИ-приложениями NVIDIA AI Enterprise. На начальном этапе в составе ИИ-суперкомпьютера задействованы 20 систем NVIDIA HGX H100, насчитывающие в общей сложности 160 ускорителей NVIDIA H100. В качестве интерконнекта применяется NVIDIA Quantum-2 InfiniBand. В рамках сотрудничества с Georgia Tech компания NVIDIA окажет поддержку студентам и преподавателям Инженерного колледжа по программе NVIDIA Deep Learning Institute (Институт глубокого обучения NVIDIA). Данная инициатива предусматривает все виды практикумов по ИИ, ускоренным вычислениям, графике, моделированию и другим современным технологиям. AI Makerspace расширяет базовую теоретическую учебную программу Georgia Tech по ИИ, предлагая студентам практическую платформу для решения реальных задач, разработки передовых приложений и реализации своих идей. |

|