Материалы по тегу: ии

|

26.04.2024 [14:52], Владимир Мироненко

UserGate объявила о расширении портфеля услуг и продуктов, а также запуске центра мониторинга ИБРоссийский разработчик решений в сфере информационной безопасности UserGate объявил о расширении спектра услуг и продуктов. Портфель компании теперь включает не только решения для обеспечения безопасность сети и конечных устройств, но и средства обнаружения вторжений, услуги аудита и консалтинга, расследований кибер-инцидентов, а также центр мониторинга информационной безопасности. Новые решения были представлены компанией на V Ежегодной конференции UserGate. Также компания рассказала об обновлённой технологической стратегии и структуре корпоративного управления. Компании поделилась опытом модернизации технологических и бизнес-процессов, процедур разработки и промышленного дизайна, а также представило расширенную команду, отвечающую за новые направления развития бизнеса UserGate. Особое внимание компания уделила образовательным инициативам, направленным на ликвидацию кадрового голода в сфере ИБ и деятельности Академии UserGate, обеспечивающей обучение технических специалистов навыкам работы на оборудовании компании. Также компания объявила об открытии Технологической лаборатории UserGate, которая будет заниматься разработкой и развитием перспективных технологий. UserGate отметила, что ей удалось создать продукты, обладающие максимально возможной технологической независимостью и оптимальным сочетанием потребительских качеств, что обеспечило их коммерческий успех и возможность дальнейшего инвестирования в собственное развитие. «Мы постоянно модернизируем существующие решения, расширяем продуктовую линейку и сферу наших компетенций, чтобы обеспечить наиболее полную защиту цифровой инфраструктуры наших заказчиков от всех возможных видов угроз», — сообщил глава компании. В прошлом году UserGate выпустила два крупных обновления своей системы UGOS до версий 7.0 и 7.1, пополнила портфолио решениями UserGate SIEM и UserGate Client, представила технологию UserID, новый проприетарный движок системы обнаружения вторжений (IPS/СОВ), повысила уровень работы Центра мониторинга и реагирования (Monitoring and Response Center, MRC), включив в состав представляемых услуг аудит и консалтинг, а также расследование инцидентов. Также был значительно расширен штат инженеров, разработчиков, аналитиков, специалистов по информационной безопасности и технической поддержке. Кроме того, компания запустила собственный центр мониторинга информационной безопасности – SOC (Security Operations Center), услуги которого будут представляться по облачной модели SOC-as-a-Service.

26.04.2024 [11:56], Руслан Авдеев

Газировка с Copilot: Microsoft получила миллиардный контракт на обеспечение Coca-Cola облачными и ИИ-сервисамиCoca-Cola заключила контракт стоимостью $1,1 млрд на использование облачных и ИИ-сервисов Microsoft. По данным Datacenter Dynamics, речь идёт о соглашении сроком на пять лет, в рамках которого последняя будет отвечать за ключевые информационные технологии производителя напитков. В результате Microsoft станет «предпочтительным» облачным и ИИ-провайдером Coca-Cola. Приложения компании перенесут в облако Microsoft Azure — в прошлом году она уже использовала генеративные ИИ-системы и уже применяет Azure OpenAI в маркетинге, производстве и управлении цепочками поставок. Компании продолжат эксперименты с сервисом Azure OpenAI, включая оценку того, как Microsoft Copilot может способствовать повышению производительности сотрудников, улучшению клиентского опыта и оптимизации деятельности в целом. По словам представителей Coca-Cola, новое соглашение демонстрирует приверженность бизнеса к цифровой трансформации — партнёрство с Microsoft растёт экспоненциально, с соглашения на $250 млн, анонсированного в 2020 году, до $1,1 млрд сегодня. В компании заявляют, что возможности Microsoft помогают внедрению ИИ для повышения прибавочной стоимости. Ранее Coca-Cola располагала дата-центром в Атланте, где расположена штаб-квартира бизнеса. В 2009 году она обсуждала с HP передачу связанных с ЦОД операций на аутсорс, а в 2017 году продала свой центр компании Rackhouse в рамках плана по миграции в облако. На тот момент компания пользовалась сервисами AWS и Google Cloud. Coca-Cola косвенно причастна к индустрии ЦОД и в другом аспекте. В 2022 году появилась информация о том, что бывший завод компании в Мадриде превратится в крупнейший дата-центр с проектной мощностью до 100 МВт.

26.04.2024 [11:47], Сергей Карасёв

Meta✴ увеличит инвестиции в развитие инфраструктуры ИИ и готовит крупнейшие капиталовложения в истории компанииКомпания Meta✴, по сообщению ресурса Datacenter Dynamics, на фоне стремительного развития ИИ и больших языковых моделей (LLM) намерена увеличить инвестиции в дата-центры и серверное оборудование «на миллиарды долларов». Эти затраты, по заявлениям генерального директора Meta✴ Марка Цукерберга, жизненно необходимы, чтобы стать «ведущей ИИ-компанией в мире». По итогам I квартала текущего финансового года, который был завершён 31 марта, Meta✴ получила выручку в размере $36,46 млрд. Это на 27 % больше результата годичной давности, когда была зафиксирована сумма в $28,65 млрд. Чистая прибыль при этом подскочила на 117 % — с $5,71 млрд до $12,37 млрд.

Источник изображения: Meta✴ В финансовом отчёте говорится, что капитальные затраты по итогам квартала оказались на уровне $6,72 млрд, что несколько ниже по сравнению с прошлогодними $7,09 млрд. Тем не менее, Meta✴ намерена нарастить общие капвложения: ожидается, что в 2024 году в целом они достигнут $35–$40 млрд, тогда как ещё в феврале называлась цифра в диапазоне $30–$37 млрд. Это будут крупнейшие капиталовложения в истории компании. «Мы ожидаем, что капитальные затраты продолжат расти и в следующем году, поскольку мы активно инвестируем средства в исследования в области искусственного интеллекта», — отмечает финансовый директор Meta✴ Сьюзен Ли (Susan Li). По словам Цукерберга, в ближайшие годы компания будет наращивать инвестиции в создание и внедрение передовых ИИ-моделей, а также запуск ведущих мировых сервисов на базе ИИ. При этом Meta✴ намерена активно использовать собственные ИИ-ускорители Artemis в качестве альтернативы решениям NVIDIA и AMD.

25.04.2024 [22:19], Андрей Крупин

Состоялся релиз «Кибер Инфраструктуры» версии 5.5 с VDI, DRS и рядом других улучшенийКомпания «Киберпротект» сообщила о выходе новой версии «Кибер Инфраструктуры» 5.5 — универсального решения, которое представляет собой мультипротокольное программно-определяемое хранилище и платформу виртуализации в одном продукте. С выпуском обновлённого комплекса IT-администраторам стала доступна возможность развёртывания инфраструктуры виртуальных рабочих столов (VDI) для российских операционных систем Astra Linux 1.7.x, «Ред ОС» 7.3, «Альт Сервер» и «Альт рабочая станция» 10. Поддерживается подключение клиентов по протоколу RDP и через веб-браузер. Существенным улучшением стало появление возможности балансировки нагрузки (DRS) по CPU и RAM, которая позволяет автоматически и без остановки перемещать виртуальные машины между серверами виртуализации для повышения производительности ВМ. Администратор может исключить отдельные виртуальные машины из процесса, ограничивать частоту и график миграции. В дополнение к этому были реализованы средства балансировки уровней хранилищ.

Источник изображения: cyberprotect.ru/products/infrastructure Другие изменения коснулись повышения производительности хранилища, в которых используются диски NVMe, расширения функциональности объектного хранилища S3, поддержки сетевых карт Intel и Broadcom с использованием протокола RoСE. «Кибер Инфраструктура» может быть развёрнута на стандартном серверном оборудовании и обеспечивает централизованное управление всеми компонентами системы. Решение включено в реестр российских программ Минцифры России и подходит для замещения зарубежных продуктов.

25.04.2024 [17:25], Владимир Мироненко

Из Git в RuStore: «РеСолют» интегрировала платформу GitFlic с российским магазином приложенийКомпания «РеСолют» (входит в «Группу Астра»), создатель платформы для работы с исходным кодом GitFlic, сообщила о разработке механизма, который обеспечит разработчикам приложений для RuStore возможность использования репозитория GitFlic для хранения, распространения кода и сборки бинарных пакетов. После сборки приложения будут в автоматическом режиме размещаться в магазине RuStore, используя авторизацию через API. Как сообщает компания, в настоящее время на GitFlic опубликованы все SDK для работы с RuStore. Зарегистрироваться в GitFlic и RuStore можно с помощью VK ID. Технический директор «РеСолют» сообщил, что стратегической целью сервиса, насчитывающего более 40 тыс. разработчиков, является желание стать единым центром взаимодействия для всех российских разработчиков, позволяющим управлять полным жизненным циклом разработки ПО. Сервис имеет необходимые инструменты отечественной разработки, охватывающих ключевые процессы создания и дистрибуции ПО. В свою очередь директор по продукту RuStore заявил, что развитие современной инфраструктуры для разработчиков — одна из главных целей RuStore. Он сообщил, что у магазина есть все необходимые SDK, включая популярные инструменты разработки и сервисы продвижения, на которые перешло уже более 1000 компаний. А сотрудничество с GitFlic обеспечит разработчикам возможность комфортной работы с SDK магазина и использования привычных решений для разработки приложений и публикации их в RuStore.

25.04.2024 [12:00], Сергей Карасёв

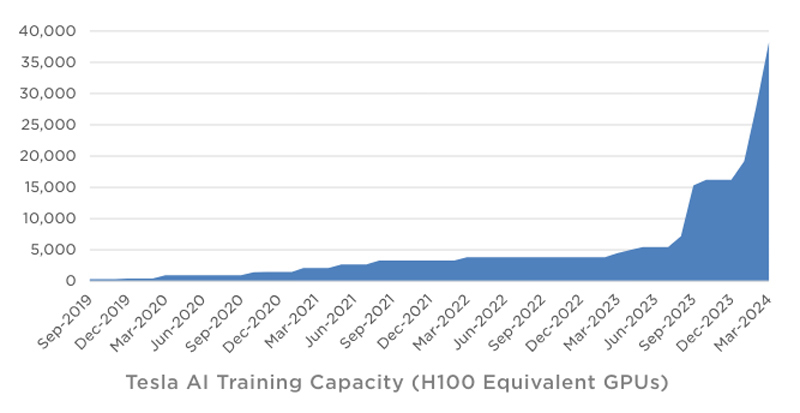

Tesla в течение квартала инвестировала в ИИ-инфраструктуру около $1 млрдКомпания Tesla обнародовала показатели деятельности в I квартале 2024 года. Выручка производителя электромобилей составила $21,3 млрд, что на 9 % меньше результата годичной давности. Предприятие Илона Маска не смогло оправдать ожидания аналитиков, которые называли сумму на уровне $22,34 млрд. Показатели ухудшаются на фоне сокращения продаж автомобилей под давлением китайских конкурентов. Чистая квартальная прибыль Tesla составила $1,13 млрд. Это на 55 % меньше по сравнению с показателем за I четверть 2023-го, когда компания заработала $2,51 млрд. Как отмечает ресурс Datacenter Dynamics, в январе–марте 2024 года Tesla инвестировала в развитие ИИ-инфраструктуры около $1 млрд. По словам Маска, компании удалось преодолеть трудности в плане расширения мощностей для обучения ИИ. На текущий момент Tesla ввела в эксплуатацию ресурсы, эквивалентные по производительности 35 тыс. ускорителей NVIDIA H100. К концу года, согласно заявлениям Маска, этот показатель приблизится к 85 тыс.

Источник изображения: Tesla Учитывая, что в презентации говорится об «эквиваленте Н100», компания может применять различные ИИ-решения, включая собственные чипы Tesla D1. В целом, Tesla увеличила мощности для обучения ИИ более чем на 130 % в I квартале 2024-го. Ожидается, что суперкомпьютер Dojo поможет увеличить рыночную стоимость Tesla на $500 млрд. Маск также сообщил, что в перспективе электромобили Tesla смогут выполнять функции распределённой edge-платформы для инференса. Идея заключается в том, чтобы задействовать вычислительные мощности автомобилей во время простоя для выполнения задач ИИ. Глава Tesla предлагает представить будущее, в котором по всему миру насчитывается 100 млн электромобилей компании. Каждый из них теоретически может обладать мощностью на уровне 1 кВт, что в сумме даёт 100 ГВт для инференса. Даже с учётом того, что каждая из этих машин будет эксплуатироваться около 7 часов ежедневно, остаётся более 100 часов в неделю для обслуживания ИИ-нагрузок.

24.04.2024 [23:45], Владимир Мироненко

NVIDIA приобрела за $700 млн платформу оркестрации ИИ-нагрузок Run:aiКомпания NVIDIA объявила о приобретении стартапа Run:ai из Тель-Авива (Израиль), занимающегося разработкой ПО для управления рабочими нагрузками и оркестрации на базе Kubernetes, которое позволяет более эффективно использовать вычислительные ресурсы при работе с ИИ-приложениями. Стоимость сделки не раскрывается. По данным TechCrunch, покупка обошлась NVIDIA в $700 млн. Это одно из крупнейших приобретений Nvidia с момента покупки Mellanox за $6,9 млрд в марте 2019 года. Два года назад NVIDIA купила Bright Computing, разработчика решений для управления НРС-кластерами. NVIDIA отметила, что развёртывание ИИ-приложениЙ становится всё более сложным. Оркестрация генеративного ИИ, рекомендательных и поисковых систем, а также других рабочих нагрузок требует сложного планирования для оптимизации производительности. ПО Run:ai позволяет управлять и оптимизировать вычислительную инфраструктуру как локально, так и в облаке или в гибридных средах.

Источник изображения: NVIDIA Созданная стартапом открытая платформа поддерживает все популярные варианты Kubernetes и интегрируется со сторонними инструментами и платформами ИИ. Компании из различных отраслей используют платформу Run:ai для управления кластерами ускорителей в масштабе ЦОД. Как сообщается, на относительно раннем этапе деятельности Run:ai удалось создать большую клиентскую базу из компаний из списка Fortune 500, что позволило привлечь венчурные инвестиции. Перед сделкой Run:ai привлекла капитал в размере $118 млн от ряда инвесторов, включая Insight Partners, Tiger Global, S Capital и TLV Partners. NVIDIA заявила, что в ближайшем будущем продолжит предлагать продукты Run:ai в рамках той же бизнес-модели, а также продолжит инвестировать в развитие Run:ai в рамках платформы NVIDIA DGX Cloud, предоставляющей корпоративным клиентам доступ к вычислительной инфраструктуре и ПО для обучения моделей генеративного и других форм ИИ. Решения Run:ai уже интегрированы с NVIDIA DGX, NVIDIA DGX SuperPOD, NVIDIA Base Command, контейнерами NGC, ПО NVIDIA AI Enterprise и другими продуктами. По словам NVIDIA, пользователи серверов и рабочих станций NVIDIA DGX, а также DGX Cloud также получат доступ к возможностям Run:ai, что особенно полезно при развёртывании генеративного ИИ в нескольких ЦОД.

24.04.2024 [20:50], Руслан Авдеев

Китайские телеком-гиганты потратят миллиарды долларов на оптовые закупки ИИ-серверовChina Mobile, одна из ключевых в Китае телеком-компаний, насчитывающая более миллиарда клиентов, намерена приобрести 8 тыс. ИИ-серверов. По информации The Register, представители IT-гиганта рассчитывают, что оборудование заработает до 2025 года. Приобретение планируют разбить на заказы для семи отдельных вендоров. Местные СМИ уже сообщают, что речь идёт о крупнейшей централизованной закупке ИИ-серверов в Китае за всю историю. Общая стоимость оборудования может перевалить за ¥15 млрд — $2 млрд. Причём компания не одинока в своём стремлении обзавестись передовыми аппаратными решениями. Спешно организуют закупки ИИ-серверов на фоне антикитайских санкций и другие телеком-гиганты Поднебесной. China Unicom, по слухам, в прошлом месяце занялась закупками 2,5 тыс. серверов, схожие действия предпринимались и China Telecom. Что именно компании намерены делать с полученными серверами, не уточняется. Впрочем, China Mobile выступает оператором крупного облака, поэтому ИИ-серверы компании безусловно пригодятся. Также не исключено, что бизнес будет использовать ИИ и для обслуживания клиентов, хотя нужно ли для этого такое количество серверов — вопрос отдельный. Главный интерес представляет даже не сфера применения ИИ-ускорителей, а их источники. В Китае пока не создано решений современного мирового уровня и даже передовые модели Huawei серии Ascend не способны на равных тягаться с новейшими решениями NVIDIA. Хотя в теории американские производители ускорителей могут получить от властей США экспортную лицензию, подав заявку в индивидуальном порядке, вряд ли такое разрешение получит подконтрольная государству China Mobile. Более того, она наряду с China Unicom и China Telecom отнесена Пентагоном к «структурам, идентифицированным как китайские военные компании», а санкции США декларировались именно как меры, призванные помешать военным КНР в получении передовых технологий. В числе официально доступных китайским телеком-компаниям вариантов — покупка западных ускорителей с искусственно ухудшенной функциональностью, не подпадающих под санкции. В числе неофициальных — обыкновенная контрабанда или, как ходят слухи, закупка через фирмы-прослойки готовых серверов с уже установленными ускорителями.

24.04.2024 [14:12], Андрей Крупин

Релиз СУБД Platform V Pangolin 6.1: упрощённая миграция с зарубежных решений и повышенная производительность«СберТех» (входит в экосистему «Сбера») сообщил о выпуске обновлённой системы управления базами данных СУБД Platform V Pangolin 6.1. Platform V Pangolin построена на базе свободной объектно-реляционной системы управления базами данных PostgreSQL и предназначена для использования в высоконагруженных системах крупных предприятий. СУБД зарегистрирована в реестре российского программного обеспечения и полностью подходит для задач импортозамещения. Платформа сертифицирована по четвёртому уровню доверия ФСТЭК России и может применяться в IT-инфраструктуре организаций, предъявляющих высокие требования к безопасности обрабатываемых данных.

Источник изображения: platformv.sber.ru СУБД Platform V Pangolin версии 6.1 получила поддержку глобальных индексов, реализация которых позволила не только упростить работу с большими объёмами данных, но и повысить быстродействие платформы (до 4 раз, по заверениям разработчика). Также в системе были произведены оптимизации под «1С:Предприятие», увеличена битность идентификаторов транзакций (XID) с 32 до 64 бит, добавлена функция трассировки сессии и реализована возможность бесшовной миграции с оригинальной PostgreSQL на Platform V Pangolin без остановки рабочих процессов. Platform V Pangolin 6.1 представлена в различных вариантах лицензий: Enterprise и Standard, а также Trial (временная лицензия уровня Enterprise). Отдельно доступны специальные лицензии Enterprise для ERP и Standard для ERP — под целевое использование СУБД совместно с платформой «1С:Предприятие».

24.04.2024 [12:25], Владимир Мироненко

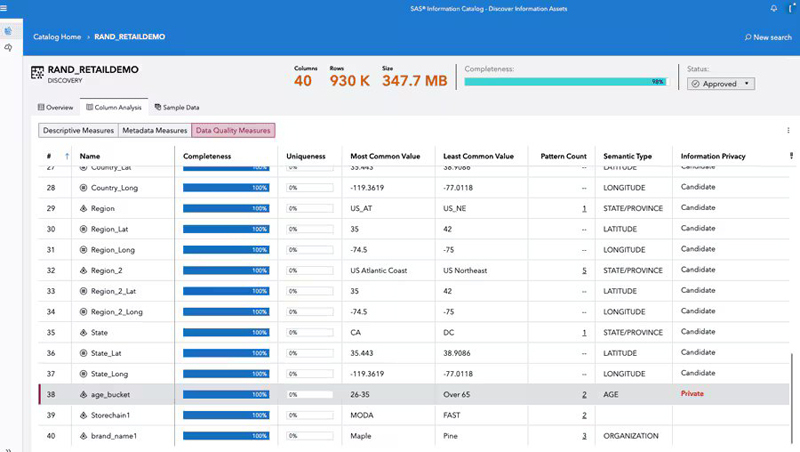

SAS Institute представила новые инструменты для разработчиков ИИ-приложений — Viya Copilot и SAS Viya WorkbenchSAS Institute Inc. сообщила о расширении ИИ-платформы SAS Viya, с помощью которой компании могут интегрировать самые мощные большие языковые модели (LLM), такие как GPT-4 и Gemini Pro 1.5, в свои существующие бизнес-процессы. Благодаря этому компании могут использовать LLM для создания индивидуальных моделей и агентов ИИ, точно настроенных на выполнение конкретных бизнес-задач с объяснимыми результатами и повышенной конфиденциальностью и безопасностью, а также гарантией, что они будут соответствовать определённым требованиям. В частности, SAS Viya пополнилась новым предложением Viya Copilot для разработчиков, специалистов по обработке данных и бизнес-пользователей. Решение Viya Copilot похоже на личного помощника, призванного ускорить выполнение различных бизнес-задач. По словам компании, для этого решение использует комплексный набор инструментов, включающий генерацию кода, очистку данных, исследование данных и анализ пробелов в знаниях.

Источник изображений: SAS Institute Обновление SAS Viya также улучшило флагманскую маркетинговую платформу компании SAS Customer Intelligence 360. Маркетологи теперь могут использовать генеративный ИИ для создания рекомендуемой аудитории на основе подсказок на естественном языке, подбора темы электронных писем и извлечения данных об аудитории. Компания также запустила для разработчиков ИИ-приложений новую платформу SAS Data Maker, целью которой является устранение проблемы конфиденциальности и решение проблем с нехваткой данных. SAS Data Maker может генерировать «высококачественные синтетические табличные данные» для обучения ИИ вместо использования конфиденциальных данных. В то же время новая платформа поможет в ситуациях, когда компаниям не хватает данных для обучения моделей. Вице-президент и главный аналитик Constellation Research, отметил в интервью ресурсу SiliconANGLE, что на данный момент SAS Data Maker может создавать синтетические данные только в табличных форматах, и поэтому вряд ли будет востребована многими компаниями.  Также была представлена SAS Viya Workbench — специализированная платформа для разработки ИИ в SAS Viya, предоставляющая вычислительную среду самообслуживания по требованию для таких задач, как подготовка данных, исследовательский анализ данных и построение аналитических моделей ИИ. Платформа будет запущена во II квартале на AWS Marketplace с поддержкой SAS и Python, а также поддержкой R к концу года. Пользователи получат доступ к двум вариантам среды разработки в SAS Viya Workbench, включая Visual Studio Code и Jupyter Notebooks. Для тех, кто по каким-то причинам не может разрабатывать собственные ИИ-модели и ищет готовые решения, которые можно просто подключить к своим бизнес-системам и сразу приступить к работе, SAS представила первую из целого каталога «облегчённых» отраслевых моделей ИИ, предназначенных для клиентов в сфере финансовых услуг, здравоохранения, государственных учреждений, производства и т.д. По словам SAS, пакетные ИИ-модели создаются с использованием запатентованных LLM и предназначены для пользователей нетехнологического сектора с целью оптимизации рабочих процессов и улучшения процесса принятия решений. SAS анонсировала свою первую комплексную модель — помощника с ИИ для оптимизации складских помещений, который может оценивать планировку складов клиентов и предлагать лучшие способы организации, чтобы максимизировать ёмкость или повысить эффективность. |

|