Материалы по тегу: hpc

|

26.04.2024 [11:47], Сергей Карасёв

Meta✴ увеличит инвестиции в развитие инфраструктуры ИИ и готовит крупнейшие капиталовложения в истории компанииКомпания Meta✴, по сообщению ресурса Datacenter Dynamics, на фоне стремительного развития ИИ и больших языковых моделей (LLM) намерена увеличить инвестиции в дата-центры и серверное оборудование «на миллиарды долларов». Эти затраты, по заявлениям генерального директора Meta✴ Марка Цукерберга, жизненно необходимы, чтобы стать «ведущей ИИ-компанией в мире». По итогам I квартала текущего финансового года, который был завершён 31 марта, Meta✴ получила выручку в размере $36,46 млрд. Это на 27 % больше результата годичной давности, когда была зафиксирована сумма в $28,65 млрд. Чистая прибыль при этом подскочила на 117 % — с $5,71 млрд до $12,37 млрд.

Источник изображения: Meta✴ В финансовом отчёте говорится, что капитальные затраты по итогам квартала оказались на уровне $6,72 млрд, что несколько ниже по сравнению с прошлогодними $7,09 млрд. Тем не менее, Meta✴ намерена нарастить общие капвложения: ожидается, что в 2024 году в целом они достигнут $35–$40 млрд, тогда как ещё в феврале называлась цифра в диапазоне $30–$37 млрд. Это будут крупнейшие капиталовложения в истории компании. «Мы ожидаем, что капитальные затраты продолжат расти и в следующем году, поскольку мы активно инвестируем средства в исследования в области искусственного интеллекта», — отмечает финансовый директор Meta✴ Сьюзен Ли (Susan Li). По словам Цукерберга, в ближайшие годы компания будет наращивать инвестиции в создание и внедрение передовых ИИ-моделей, а также запуск ведущих мировых сервисов на базе ИИ. При этом Meta✴ намерена активно использовать собственные ИИ-ускорители Artemis в качестве альтернативы решениям NVIDIA и AMD.

26.04.2024 [11:46], Сергей Карасёв

HPE построила самый мощный в Польше суперкомпьютер Helios производительностью 35 ПфлопсКомпания HPE сообщила о создании нового суперкомпьютера под названием Helios для Академического компьютерного центра Cyfronet Научно-технического университета AGH в Кракове (Польша). Вычислительный комплекс будет использоваться для решения ресурсоёмких задач, связанных с ИИ. На сегодняшний день Helios — самая высокопроизводительная система в Польше. Она обеспечивает теоретическую пиковую производительность на уровне 35 Пфлопс, что более чем в четыре раза превосходит показатель предыдущего флагманского суперкомпьютера Cyfronet. Пиковое быстродействие на ИИ-операциях достигает 1,8 Эфлопс. В основу Helios положены узлы HPE Cray EX. Комплекс состоит из трёх сегментов. Один из них предназначен для традиционных вычислений, еще один — для рабочих нагрузок, связанных с обработкой больших данных. Третий сегмент оптимизирован для ИИ-задач: он использует суперчипы NVIDIA. Суперкомпьютер планируется применять при реализации проектов в области химии, медицины, создания передовых материалов, астрономии и защиты окружающей среды. Раздел общего назначения использует процессоры AMD EPYC поколения Genoa. Общее количество вычислительных ядер Zen 4 составляет 75 264, объём оперативной памяти DDR5 — 200 Тбайт. Сегмент для работы с большими данными основан на платформе HPE Cray Supercomputing XD665 с чипами EPYC Genoa, памятью DDR5-4800, быстрыми накопителями NVMe и ускорителями NVIDIA H100, суммарное количество которых равно 24.

Источник изображения: HPE Наконец, ИИ-раздел объединяет 440 суперчипов NVIDIA GH200 Grace Hopper для компьютерного моделирования с интенсивным использованием графики, поддержки приложений на основе генеративного ИИ и пр. Все компоненты вычислительного комплекса связаны друг с другом посредством 200G-интерконнекта HPE Slingshot. Комплекс Helios оснащён Lustre-хранилищем общей вместимостью 17,5 Пбайт на базе HPE Cray ClusterStor E1000.

21.04.2024 [20:51], Сергей Карасёв

Власти Японии потратят $470 млн на создание ИИ-суперкомпьютера нового поколенияПравительство Японии, по сообщению ресурса Nikkei, профинансирует создание мощного НРС-комплекса, предназначенного для решения ресурсоёмких задач, связанных с ИИ. В общей сложности на проект будет выделено ¥72,5 млрд , или приблизительно $470 млн. В проектировании системы примут участие пять компаний, включая телекоммуникационного оператора KDDI и поставщика облачных услуг Sakura Internet. Отмечается, что Министерство экономики, торговли и промышленности Японии (METI) компенсируют до половины затрат, которые понесут разработчики суперкомпьютера. В частности, Sakura получит ¥50,1 млрд ($324 млн) государственных средств, а KDDI — ¥10,2 млрд (около $66 млн). В настоящее время японские компании и госорганизации в значительной степени полагаются на американских гиперскейлеров, таких как AWS и Microsoft Azure, которые сдавать позиции не собираются и активно инвестируют в развитие инфраструктуры в Японии, в том числе для ИИ. Предполагается, что создание собственного мощного ИИ-комплекса позволит снизить зависимость от иностранных технологий, а также улучшить конкурентоспособность Японии на мировом рынке. Технические детали проекта пока не раскрываются.

Источник изображения: pixabay.com В 2020 году японский суперкомпьютер Fugaku на базе процессоров с архитектурой Arm возглавил глобальный рейтинг TOP500 самых производительных НРС-систем мира. Сейчас его быстродействие составляет около 442 Пфлопс. Однако с момента запуска комплекс Fugaku опустился на четвёртое место в списке TOP500, уступив трём американским суперкомпьютерам — Frontier, Aurora и Eagle, у которых производительность достигает соответственно 1,19 Эфлопс, 585 Пфлопс и 561 Пфлопс. В июле 2023 года METI объявило о планах по развёртыванию суперкомпьютера для генеративного ИИ в новом исследовательском центре Японского национального института передовых технических наук и технологии (AIST). В создании этой системы также принимают участие специалисты Sakura Internet. Кроме того, в Японии запланировано строительство суперкомпьютера ABCI-Q с 2000 ускорителей NVIDIA H100 для исследований в области квантовых вычислений.

19.04.2024 [09:10], Сергей Карасёв

Tesla столкнулась с трудностями при строительстве дата-центра для ИИ-суперкомпьютера DojoКомпания Tesla, по сообщению ресурса The Information, не укладывается в намеченный график строительства ЦОД в Остине (Техас, США), в котором планируется разместить узлы ИИ-суперкомпьютера Dojo стоимостью $1 млрд. Эта площадка будет использоваться для решения сложных задач в области ИИ и машинного обучения, в частности, связанных с системами автопилотирования. К строительству дата-центра, о котором идёт речь, компания Илона Маска приступила в октябре 2023 года. Известно, что по своей конструкции этот ЦОД будет напоминать бункер. Однако, как стало известно, при возведении комплекса Tesla столкнулась с рядом трудностей. В середине апреля Маск посетил строительную площадку и «пришёл в ярость» из-за увиденного. Вопреки ожиданиям, у объекта отсутствуют большая часть первого этажа и крыша. Наблюдаются сложности с доставкой необходимых материалов, из-за чего возникают задержки при строительстве. Кроме того, ситуация усугубляется из-за того, что основанная Маском компания Boring Company должна проложить под площадкой ЦОД туннель для передвижения электрических пикапов Cybertruck, но эти работы не выполнены. Поэтому невозможно полноценное завершение возведения даже первого этажа.

Источник изображения: Tesla После своего визита Маск уволил директора по строительной инфраструктуре проекта. После этого Tesla сократила более 14 тыс. сотрудников — свыше 10 % от своего штата, насчитывавшего около 140 тыс. человек. Кроме того, компанию покинули несколько топ-менеджеров. О сроках завершения строительства ЦОД в Остине ничего не сообщается. Возникшие задержки, как считается, отражают более широкие проблемы в автомобильной отрасли.

19.04.2024 [07:46], Сергей Карасёв

«Росэлектроника» представила ПАК для суперкомпьютеров с интерконнектом «Ангара»Холдинг «Росэлектроника», входящий в госкорпорацию «Ростех», анонсировал отечественный программно-аппаратный комплекс (ПАК) под названием «Базис», предназначенный для развёртывания облачных сервисов и платформ НРС. Система, как утверждается, может масштабироваться до нескольких сотен узлов. ПАК разработан специалистами Научно-исследовательского центра электронной вычислительной техники (НИЦЭВТ) в составе «Росэлектроники». Решение состоит из трёх серверов общего назначения, каждый из которых может насчитывать до 128 вычислительных ядер и нести на борту до 2 Тбайт оперативной памяти. Отмечается, что системные платы для серверов имеют отечественное происхождение: они спроектированы и произведены в НИЦЭВТ. Более подробно характеристики не раскрываются. Платформа «Базис» использует обновлённую версию российского интерконнекта «Ангара». Достигается пропускная способность до 75 Гбит/с. Разработчики подчёркивают, что сетевое оборудование обеспечивает высокоинтенсивный обмен данными между серверами со сверхнизкой задержкой.

Источник изображения: «Росэлектроника» «Базис» включён в Единый реестр телекоммуникационного и радиоэлектронного оборудования российского происхождения Минпромторга России. На основе ПАК могут создаваться центры обработки и хранения данных, виртуализированные офисы, виртуальные машины, системы для обработки графических приложений, а также суперкомпьютеры для нестандартных расчётов, говорится в сообщении. Благодаря возможностям масштабирования платформа может поддерживать тысячи виртуальных рабочих мест. «Область применения нового программно-аппаратного комплекса очень широка. Например, наши технологии легко справятся с задачей создания виртуализированных инженерных рабочих мест с поддержкой аппаратной обработки 3D-графики. А высокая пропускная способность канала передачи данных и гибкая система масштабирования позволяют проводить сложнейшие вычислительные операции. Наши специалисты готовы рассчитать и адаптировать наш новый ПАК под конкретные задачи и потребности заказчика», — говорит генеральный директор НИЦЭВТ.

18.04.2024 [13:23], Сергей Карасёв

Eviden и CEA анонсировали второй суперкомпьютер EXA1 — HE на базе Arm-суперчипов NVIDIA Grace HopperКомпания Eviden (дочерняя структура Atos) и Комиссариат по атомной и альтернативным видам энергии Франции (СЕА) объявили о реализации второй фазы суперкомпьютерной программы EXA1. Она предусматривает ввод в эксплуатацию НРС-комплекса EXA1 HE (High Efficiency) на платформе Eviden BullSequana XH3000. Первая очередь системы — EXA1 HF (High-Frequency) — была запущена в 2021 году. Основой послужила платформа BullSequana XH2000. Изначально машина включала 12 960 процессоров AMD EPYC 7763 (64C/128T, 2,45 ГГц), а её производительность на момент анонса составляла 23,2 Пфлопс. Комплекс EXA1 HE использует 477 вычислительных узлов на базе суперчипов NVIDIA Grace Hopper. Применяется жидкостное охлаждение тёплой водой. Заявленная производительность в тесте Linpack составляет приблизительно 60 Пфлопс, а пиковое быстродействие достигает 104 Пфлопс. Задействован фирменный интерконнект BXI (BullSequana eXascale Interconnect). Сеть основана на топологии DragonFly и состоит из 156 коммутаторов. Отмечается, что суперкомпьютер EXA1 соответствует требованиям оборонных программ, реализуемых военным отделом CEA.

Источник изображения: Eviden Отметим, что в марте нынешнего года компания Eviden заключила соглашение о модернизации французского НРС-комплекса Jean Zay. Суперкомпьютер получит 1456 ускорителей NVIDIA H100 в дополнение к 416 картам NVIDIA A100 и 1832 ускорителям NVIDIA V100, которые задействованы в настоящее время. В результате, пиковая производительность Jean Zay поднимется с нынешних 36,85 до 125,9 Пфлопс.

16.04.2024 [16:20], Сергей Карасёв

Завершено строительство Arm-суперкомпьютера Venado на базе суперчипов NVIDIA Grace HopperЛос-Аламосская национальная лаборатория (LANL) Министерства энергетики США объявила о завершении сборки НРС-комплекса Venado, предназначенного для решения сложных ресурсоёмких задач в области ИИ. В создании системы приняли участие компании HPE и NVIDIA. Проект Venado был анонсирован в мае 2022 года. Система смонтирована в Центре моделирования и симуляции Николаса К. Метрополиса (Nicholas C. Metropolis) в составе LANL. В церемонии открытия комплекса приняли участие представители Министерства энергетики США, Администрации по национальной ядерной безопасности США и других организаций. Venado — первый в США суперкомпьютер, построенный на суперчипах NVIDIA Grace и Grace Hopper с ядрами Arm. Суперкомпьютер построен на платформе HPE Cray EX. В общей сложности задействованы 2560 гибридных суперчипов Grace Hopper с прямым жидкостным охлаждением: эти изделия объединяют ядра Arm v9 и ускорители на архитектуре Hopper. Кроме того, в состав НРС-системы входят 920 суперчипов Grace. Узлы объединены интерконнектом HPE Slingshot 11.

Источник изображений: LANL На суперкомпьютере используется специализированное ПО HPE Cray, которое, как утверждается, позволяет оптимизировать рабочие нагрузки по моделированию и симуляции. Систему планируется использовать в таких областях, как материаловедение, возобновляемые источники энергии, астрофизика и пр. ИИ-производительность системы (FP8) составит около 10 Эфлопс. Машина также получит Lustre-хранилище.  «Являясь первым в США суперкомпьютером на базе NVIDIA Grace Hopper, система Venado обеспечивает революционную производительность и энергоэффективность для ускорения научных открытий», — говорит Ян Бак (Ian Buck), вице-президент HPC-подразделения NVIDIA. При этом Venado относится к классу экспериментальных суперкомпьютеров и будет использоваться для переноса и оптимизации имеющихся кодов, а также для создания нового ПО и проверки различных концепций.

16.04.2024 [15:20], Сергей Карасёв

Испания и Бразилия займутся совместными разработками чипов RISC-V для HPC и ИИБарселонский суперкомпьютерный центр (Centro Nacional de Supercomputación, BSC-CNS) и бразильский институт Эльдорадо (Instituto Eldorado) объявили о заключении соглашения о сотрудничестве в области процессоров с открытой архитектурой RISC-V. Основная цель проекта — развитие направлений НРС и ИИ. Стороны намерены заняться совместной разработкой специализированного блока ускорения матричного умножения, который в перспективе планируется интегрировать в чипы RISC-V. В рамках соглашения о сотрудничестве BSC-CNS и институт Эльдорадо подписали меморандум о взаимопонимании. О размере инвестиций в проект пока ничего не сообщается. Но отмечается, что инициатива является частью Приоритетной программы национальных интересов Бразилии (PPI-Softex) и осуществляется при поддержке Министерства науки, технологий и инноваций страны. Речь идёт об установлении технологического партнёрства между Бразилией и Европейским союзом, укреплении обмена знаниями, а также о поддержке передовых исследований и разработок.

Источник изображения: BSC-CNS BSC-CNS и институт Эльдорадо намерены выполнять работы в сотрудничестве со специалистами Университета Кампинаса (UNICAMP) в штате Сан-Паулу (Бразилия). Ожидается, что в перспективе чипы с архитектурой RISC-V произведут революцию в области НРС. Новое партнёрство призвано ускорить внедрение инноваций в соответствующей области. Стоит отметить, что недавно центр BSC-CNS заключил многолетнее соглашение о сотрудничестве с NVIDIA. Этот проект нацелен на разработку инновационных решений, объединяющих технологии НРС и ИИ. Стороны, в частности, займутся созданием больших языковых моделей (LLM).

15.04.2024 [13:58], Сергей Карасёв

В Чили запущен суперкомпьютер Geryon 3 для астрономических исследованийПапский Католический университет Чили (UC Chile) объявил о вводе в эксплуатацию НРС-комплекса Geryon 3 на аппаратной платформе Intel. Суперкомпьютер предназначен прежде всего для решения задач в области астрономии, но будет также применяться и в других сферах — от физики до биологии. Проект по созданию Geryon 3 реализован при финансовой поддержке Центра передовых исследований в области астрофизики и связанных с ней технологий (CATA). Стоимость НРС-системы составляет $367,5 тыс. Суперкомпьютер смонтирован в Институте астрофизики в Сантьяго (UC Institute of Astrophysics), где занимает площадь приблизительно 36 м2. Отмечается, что появление Geryon 3 знаменует собой важную веху в развитии вычислительных мощностей для астрофизических исследований в Чили. В состав комплекса входят 12 узлов с процессорами Xeon Gold 6448H поколения Sapphire Rapids. Чипы объединяют 32 ядра (64 потока) с тактовой частотой 2,4–4,1 ГГц. Каждый узел содержит 512 Гбайт оперативной памяти. В общей сложности задействованы 768 ядер и 6,14 Тбайт памяти. Говорится об использовании специально разработанной системы охлаждения (подробности не раскрываются) и других технических решений, включая средства стабилизации питания.

Источник изображения: UC Chile К 2030-м годам Чили будет обладать самыми развитыми в мире возможностями астрономических наблюдений. К существующим научным инструментам добавятся новые обсерватории, такие как Гигантский Магелланов телескоп (GMT), Европейский чрезвычайно большой телескоп (E-ELT) и обсерватория Веры Рубин. Для обработки поступающих данных потребуются значительные вычислительные ресурсы. Например, обсерватория Веры Рубин получит самую мощную в мире цифровую камеру для оптической астрономии с разрешением 3200 Мп, которая будет фотографировать небо южного полушария каждые три–четыре ночи, формируя около 1000 гигантских изображений за цикл. Хотя основным предназначением Geryon 3 являются астрономические исследования, суперкомпьютер также будет применяться для обработки огромных объёмов данных в таких областях, как горное дело, возобновляемые источники энергии, биогенетика или лесное хозяйство. Ресурсы будут доступны как академическому, так и промышленному сектору.

13.04.2024 [23:00], Сергей Карасёв

«Ростех» начал поставки серверов и обновлённого интерконнекта «Ангара» для отечественных суперкомпьютеров

amd

epyc

hardware

hpc

ангара

импортозамещение

интерконнект

коммутатор

ницэвт

россия

ростех

сделано в россии

сервер

суперкомпьютер

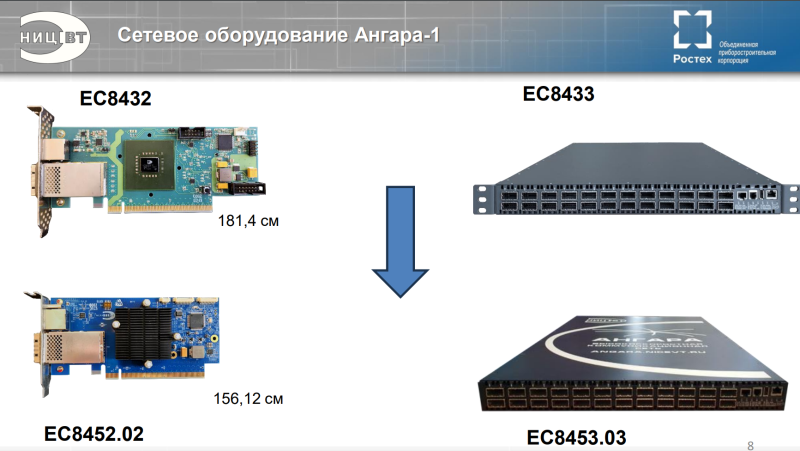

Государственная корпорация «Ростех» объявила о начале поставок оборудования нового поколения для создания отечественных суперкомпьютеров. Речь идёт о высокопроизводительных серверах, 24-портовых коммутаторах и адаптерах интерконнекта «Ангара». В сообщении «Ростеха» говорится, что оборудование стало более компактным по сравнению с предыдущими модификациями. Адаптеры «Ангара» обеспечивают объединение серверов в единый вычислительный кластер для проведения расчётов с высокоинтенсивным обменом информацией и низкими задержками. Новинка разработана специалистами Научно-исследовательского центра электронной вычислительной техники (НИЦЭВТ) в составе холдинга «Росэлектроника» госкорпорации «Ростех». На сайте НИЦЭВТ представлено изделие ЕС8431. Это FHFL-карта с интерфейсом PCIe 2.0 x16, которая обеспечивает до шести (или до восьми при использовании платы расширения) портов для соединения с соседними узлами. Пропускная способность достигает 75 Гбит/с на порт, задержка — 130 нс на хоп. Применяются Samtec-кабели. Поддерживаются топологии сети «кольцо», 2D, 3D и 4D-тор (либо решётка), причём возможно масштабирование до 32 тыс. узлов. Энергопотребление — 30 Вт. Также доступен низкопрофильный 15-Вт адаптер ЕС8432, который по характеристикам в целом повторяет ЕС8431, но имеет только один порт (CXP). Он ориентирован на работу с коммутаторами. И НИЦЭВТ как раз предлагает такое решение — изделие ЕС8433 типоразмера 1U. Оно располагает 24 портами с пропускной способностью до 75 Гбит/с. Возможно масштабирование до 2 тыс. узлов. Энергопотребление не превышает 150 Вт. На мероприятии «Суперкомпьютерные дни в России 2023» НИЦЭВТ также анонсировал более компактный вариант адаптера ЕС8452.02 и 24-портовый коммутатор ЕС8453.03. В сообщении «Ростеха» не уточняется, о каких именно продуктах идёт речь. В маркетплейсе госкорпорации рекомендованная розничная цена коммутатора ЕС8433 составляет 2,8 млн руб., а адаптеров ЕС8431 и ЕС8432 — 396 тыс. руб. и 300 тыс. руб. соответственно. В ассортименте НИЦЭВТ также значится сервер общего назначения Server-NICEVT-044 SP3 на платформе AMD. Он может оснащаться одним или двумя процессорами EPYC Naples/Rome/Milan (от 8 до 48 ядер), до 1 Тбайт RAM, двумя блоками питания с возможностью горячей замены. Возможна установка SSD суммарной вместимостью до 10 Тбайт и HDD общей ёмкостью до 80 Тбайт. Форм-фактор — 2U. Рекомендованная розничная цена составляет 1,2 млн руб. «Мы произвели первые поставки нового поколения сетевого оборудования линейки "Ангара", разработка которого завершилась в 2023 году. Техника установлена на территории двух научно-исследовательских организаций. Устройства позволяют ещё более эффективно выполнять задачи по созданию современных российских суперкомпьютеров для решения сложных научных задач. Сегодня именно от такого оборудования во многом зависит успех и скорость научных изысканий, а значит — и развитие отечественной промышленности», — говорит генеральный директор НИЦЭВТ. |

|