Материалы по тегу: hardware

|

22.02.2026 [17:01], Руслан Авдеев

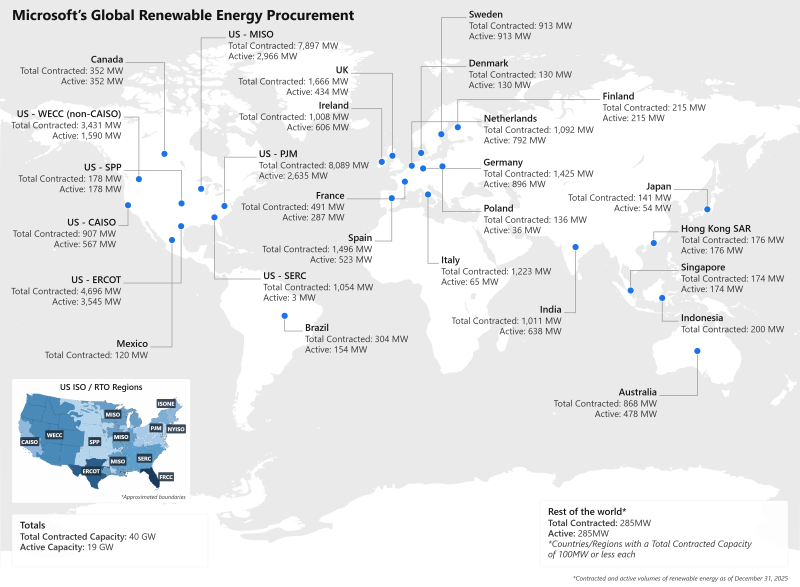

19 ГВт уже есть, ещё 21 ГВт на подходе: Microsoft на 100 % компенсировала свои энергозатраты «зелёными» контрактамиКомпания Microsoft объявила о том, что в 2025 году её удалось компенсировать 100 % своего потребления электричества с помощью возобновляемой энергетики. В 2020 году компания обещала добиться «отрицательных» углеродных выбросов к 2030 году, и возобновляемая энергетика была важной частью этого плана, сообщает Datacenter Dynamics. Согласно данным Microsoft, в 2013 году было подписано первое соглашение о покупке 110 МВт «зелёной» энергии (PPA) в Техасе. С 2020 года суммарно законтрактовано 40 ГВт новых мощностей в 26 странах в рамках 400 с лишним контрактов. Из них 19 ГВт уже работают, остальные должны ввести в эксплуатацию в следующие пять лет. Основные закупки осуществляются в Северной Америке и Западной Европе, где развитые энергорынки продолжают обеспечивать рост. В целом доминируют США, где лидирует коммунальная PJM Interconnection с 8089 МВт законтрактованных мощностей Microsoft, на втором месте — MISO с 7897 МВт и ERCOT с 4696 МВт. На европейском рынке лидирует Великобритания с 1666 МВт, Испания с 1496 МВт и Германия с 1425 МВт. Также компания законтрактовала крупные мощности возобновляемой энергии в Италии и Нидерландах. За пределами ключевых рынков компания активно закупает «зелёную» энергию в Азиатско-Тихоокеанском регионе. Индия стала крупнейшим для Microsoft игроком в своём регионе с 1011 МВт контрактных мощностей, растёт соответствующее портфолио и на австралийском рынке (868 МВт). За последние пять лет компания вышла на новые рынки, подписав первые PPA в Японии в 2023 году. При этом следует оговориться, что подобные контракты редко подразумевают непосредственное питание ЦОД, офисов и т.д. — чаще речь лишь о компенсации энергопотребления объектов компании путём поставок в энергосети «чистой» энергии. На прямые PPA приходится более 90 % всех закупок компанией возобновляемой энергии, оставшиеся 10 % — «зелёные» контракты с действующими коммунальными компаниями. Microsoft заявила, что цель по закупке 100 % возобновляемой энергии достигнута без учёта краткосрочных «кредитов» (REC) на возобновляемые энергоресурсы от уже действующих проектов «чистой» энергетики. Также компания отметила, что инвестировала в некоторые развивающиеся «низкоуглеродные» технологии, включая заключение первых PPA с компанией Helion о покупке термоядерной энергии. Кроме того, заключено соглашение с Constellation Energy о перезапуске АЭС Three Mile Island. Объявление о покрытии 100 % энергетических потребностей за счёт возобновляемой энергии последовало вскоре после того, как выяснилось, что углеродные выбросы компании увеличились с 2020 года на 23 %, в первую очередь благодаря росту ИИ-проектов. В отчёте 2025 Environmental Sustainability Report компания Microsoft связала этот рост с «факторами роста вроде ИИ и масштабирования облаков», но назвала его «скромным» в сравнении с увеличением расхода энергии на 168 % и ростом выручки на 71 % в тот же период.

22.02.2026 [16:03], Сергей Карасёв

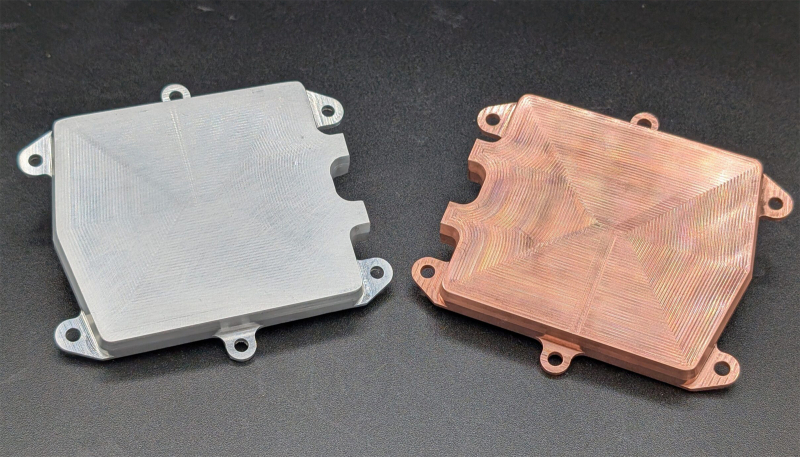

Johnson Controls купила разработчика СЖО Alloy EnterprisesПроизводитель климатического оборудования, средств автоматизации, безопасности и пожаротушения Johnson Controls, по сообщению Datacenter Dynamics, заключил соглашение о приобретении Alloy Enterprises — бостонской компании, занимающейся разработкой компонентов для систем охлаждения. Стартап Alloy Enterprises основан в 2020 году. Он специализируется на решениях в области теплотехники, механики и материаловедения. Компания, в частности, производит компоненты для СЖО, такие как водоблоки, тепловые трубки и пр. В качестве материала используются алюминий и медь. При этом применяется фирменная технология Stack Forging: изделия сочетают особую внутреннюю микрогеометрию с монолитной конструкцией, благодаря чему обеспечивается эффективное охлаждение под высоким давлением без утечек. Финансовые условия сделки между Johnson Controls и Alloy Enterprises не раскрываются, но отмечается, что стороны намерены закрыть её в III квартале текущего года. Предполагается, что Johnson Controls будет использовать приобретённые разработки и технологии для развития своего ассортимента продуктов, ориентированных на дата-центры. Это позволит укрепить позиции на быстро расширяющемся рынке. Johnson Controls поставляет и внедряет решения для ЦОД в более чем 150 странах по всему миру. В 2024 году компания сформировала специализированное подразделение по разработке продуктов для дата-центров: речь идёт об интегрированных системах, которые предлагаются клиентам в глобальном масштабе. Кроме того, в составе Johnson Controls действует структура Silent-Aire, специализирующаяся на модульных ЦОД, а также на системах кондиционирования, вентиляции и охлаждения для дата-центров.

22.02.2026 [15:58], Владимир Мироненко

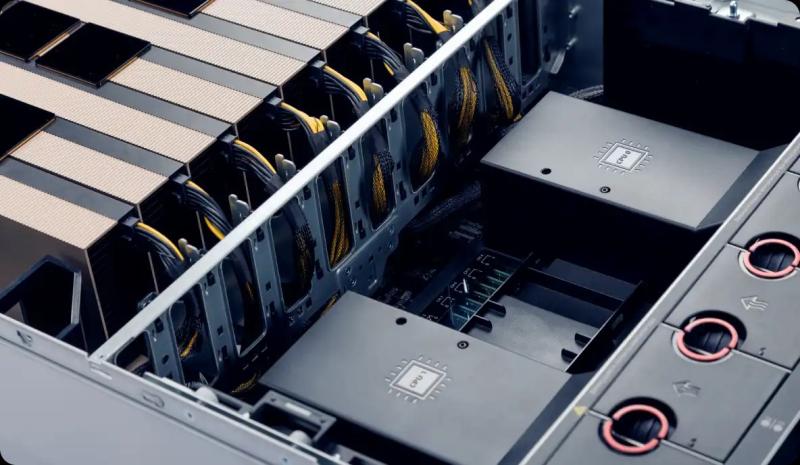

Российский бизнес распробовал ИИ: рынок ИИ-серверов достиг 60 млрд рублейВ 2025 году в России на закупку ИИ-серверов компании потратили около 60 млрд руб., без учёта аренды вычислительных мощностей, обслуживания и модернизации сообщил коммерческий директор YADRO (входит в «ИКС холдинг») Александр Бакулин на цифровом форуме «Инфраструктурные вызовы для развития ИИ в России» в рамках Недели российского бизнеса, о чём пишут «Ведомости». Он добавил, что рынок находится «в стадии перелома» — за последние два года ИИ перестал быть «надстройкой» над IT-инфраструктурой, а стал менять правила проектирования вычислительных систем. Формируется новая инфраструктурная ниша, сравнимая с энергетикой и телекоммуникациями. Ключевые заказчики переходят от экспериментов к промышленной эксплуатации, начинают встраивать решение машинного обучения больших языковых моделей в свои бизнес-процессы и планы. И при этом на ИИ наблюдается большой спрос, сообщил Бакулин. По словам Бакулина, мировой рынок ИИ-серверов, который во многом формируют облачные провайдеры и крупные технологические компании, оценивается в сотни миллиардов долларов, демонстрируя устойчивую высокую динамику. Как и на мировом рынке основной спрос в России формируют крупные компании, работающие с большими массивами данных и развивающие собственные языковые модели, например крупные игроки e-commerce, финтеха и интернет-сервисов. Ранее «АТК консалтинг» сообщила, что закупки программных продуктов с ИИ в 2025 выросли год к году в 7,4 раза до 1,8 млрд руб. Как отметили тогда «Ведомости», рынок «железа» для ИИ в деньгах вырос значительно больше. В частности, это связано с подорожанием чипов памяти, на которую в современных серверах может приходиться до двух третей себестоимости. В «Группе Астра» считают, что 60 млрд руб. на ИИ-серверы звучит реалистично, но важнее динамика. Так, совокупный российский рынок серверов и СХД в 2025 году в целом составил 280 млрд руб. против 155 млрд руб. в 2024-м, сообщали «Ведомости» со ссылкой на данные YADRO и Fplus. Наибольшая часть рынка — около 55–60 % от суммы — пришлась на госзакупки по 44-ФЗ и 223-ФЗ, уточнили тогда в YADRO. По оценкам «Группы Астра», к концу 2026 года госзакупки, связанные с ИИ, вырастут на 20–30 %, а год к году — вполовину. Рынок действительно идёт к промышленной эксплуатации ИИ, считают в ЦКНТИ по направлению «Технологии хранения и анализа больших данных» МГУ, отметив, что банки, телеком, ретейл встраивают ИИ-модели в скоринг, поддержку, операционные процессы. До конца года рынок может вырасти за счёт дооснащения и повторных закупок, а год к году — на 25–40 %, если не будет жёстких ограничений по поставкам ускорителей и финансированию.

22.02.2026 [00:24], Владимир Мироненко

AMD подстрахует Crusoe, продаст ей свои чипы и сама же арендует их, если что-то пойдёт не такСогласно данным ресурса The Information, AMD предоставит гарантию по кредиту в размере $300 млн неооблаку Crusoe для покупки и развёртывания своих ИИ-чипов. Благодаря этому стартап получит кредит под 6 %, что гораздо ниже, чем было бы без поддержки AMD. Кредит для Crusoe, организованный Goldman Sachs, будет обеспечен чипами AMD и соответствующим оборудованием. Сделка позволит Crusoe приобрести ИИ-чипы AMD, чтобы развернуть их в новом ЦОД в Огайо, строящемся канадским девелопером 5C, поддерживаемым Brookfield. По данным источников, AMD обязуется арендовать собственные чипы у Crusoe, если ей не удастся привлечь достаточное количество клиентов, особенно среди разработчиков ИИ. Генеральный директор Crusoe Чейз Лохмиллер (Chase Lochmiller) в прошлом году сообщил Reuters, что компания планирует приобрести чипы AMD на сумму $400 млн. Эта сделка подчеркивает усиление конкуренции среди производителей полупроводников за поддержку развития инфраструктуры, ориентированной на ИИ, отметил ресурс MarketScreener. В данном случае AMD придерживается стратегии лидера ИИ-рынка компании NVIDIA, готовой предоставить заимствования для покупки своей продукции, арендовать собственные чипы, выступить в качестве гаранта партнёра в сделках аренды ЦОД, а также гарантировать выкуп вычислительных мощностей партнёра в случае, если те останутся невостребованными. NVIDIA также является ключевым инвестором Crusoe. Компания участвовала в раунде финансирования серии D компании Crusoe на сумму $600 млн в конце 2024 года, а затем в раунде серии E на сумму $1,375 млрд в октябре 2025 года, что увеличило оценку Crusoe до более чем $10 млрд. Несмотря на циклический характер заключаемых NVIDIA сделок, что вызывает опасения экспертов в растущем пузыре на ИИ-рынке, инвесторы пока сохраняют оптимизм. Акции NVIDIA выросли за 2025 год более чем на 34 %, а акции AMD за тот же период — на 76 %, пишет MSN.

21.02.2026 [15:03], Сергей Карасёв

G42 из ОАЭ и Cerebras построят в Индии национальный ИИ-суперкомпьютер с царь-ускорителями WSE-3Холдинг G42 из Абу-Даби (ОАЭ) и компания Cerebras в партнёрстве с Университетом искусственного интеллекта им. Мохаммеда бин Зайеда (MBZUAI) и Индийским центром развития передовых вычислительных технологий (C-DAC) развернут в Индии национальный ИИ-суперкомпьютер. Технические подробности проекта не раскрываются. Отмечается лишь, что система обеспечит ИИ-производительность на уровне 8 Эфлопс (точность вычислений не указана). Комплекс, размещённый на территории Индии, будет эксплуатироваться в соответствии с местными требованиями к безопасности, а все обрабатываемые данные останутся в национальной юрисдикции. Иными словами, речь идёт о формировании суверенной вычислительной платформы. Как отмечает The Register, в основу суперкомпьютера лягут ускорители Cerebras WSE-3. Эти изделия содержат 4 трлн транзисторов, 900 тыс. ядер и 44 Гбайт SRAM. Суммарная пропускная способность встроенной памяти достигает 21 Пбайт/с. Производительность составляет до 125 Пфлопс на операциях FP16. Таким образом, в составе НРС-системы могут быть задействованы 64 экземпляра Cerebras WSE-3.

Источник изображения: G42 После ввода в эксплуатацию новый суперкомпьютер станет доступен широкому кругу пользователей в Индии — от ведущих научных организаций, институтов и государственных структур до стартапов, малых и средних предприятий. Ожидается, что появление системы позволит ускорить инновации в области ИИ. «Суверенная инфраструктура ИИ становится важнейшим компонентом национальной конкурентоспособности. Новый проект предоставит Индии такую платформу, позволив местным исследователям и предприятиям внедрять ИИ, обеспечивая при этом полную безопасность данных», — заявил Ману Джайн (Manu Jain), генеральный директор G42 India. Нужно отметить, что в Индии активно развивается инфраструктуры для ИИ-вычислений. В частности, индийские Tata Group, Tata Consultancy Services (TCS) и OpenAI намерены развернуть в стране ИИ ЦОД мощностью до 1 ГВт. Вместе с тем индийский конгломерат Adani вложит $100 млрд в создание ЦОД общей мощностью 5 ГВт, снабжаемых возобновляемой энергией.

21.02.2026 [14:38], Сергей Карасёв

Nautilus представила универсальный 4-МВт CDUКомпания Nautilus анонсировала блок распределения охлаждающей жидкости EcoCore FCD CDU, разработанный специально для крупномасштабных дата-центров, ориентированных на нагрузки ИИ и НРС. Утверждается, что новинка может быть интегрирована с СЖО любого типа, в том числе прямого и погружного. Мощность решения в зависимости от модификации варьируется от 2 до 4 МВт. Герметичная конструкция исключает риск утечек; говорится о возможности использования пресной, морской и промышленной воды. Опционально доступны дополнительные фильтры. Система спроектирована для бесшовной интеграции в существующие машинные залы: это обеспечивает максимально эффективное использование доступного пространства без ущерба для производительности, говорит компания. Допускается подача воды сверху и снизу, что позволяет адаптировать решение к конструктивным особенностям конкретного ЦОД. Благодаря точному контролю температуры достигается стабильное и надёжное охлаждение с учётом предъявляемых требований. Возможно масштабирование: в единой инфраструктуре могут быть объединены до шести модулей EcoCore FCD CDU. Реализованы протоколы Modbus RT, Modbus TCP, OPC UA для удалённого управления и мониторинга. Блок оснащён датчиками расхода, температуры и давления в первичном и вторичном контурах. Поддерживается резервирование по схеме N+2. Используются два источника питания; максимальное заявленное энергопотребление составляет 42 кВт. Габариты системы — 2,7 × 1,7 × 2,1 м, «сухая» масса — 3520–3550 кг.

20.02.2026 [22:30], Владимир Мироненко

Не $100 млрд, а $30 млрд, и не выиграл, а переиграл — NVIDIA и OpenAI готовят новую инвестиционную сделкуМноголетняя сделка между NVIDIA и OpenAI, в рамках которой производитель ИИ-ускорителей обязался инвестировать в разработчика ИИ-моделей $100 млрд, так и не была подписана. Вместо неё компании готовят более простую схему с инвестициями NVIDIA в акционерный капитал OpenAI в размере $30 млрд в обмен на её акции, сообщил ресурс The Financial Times. По данным источников The Financial Times, переговоры по этому поводу находятся на завершающей стадии, решение может быть принято уже в эти выходные. Инвестиции NVIDIA в акционерный капитал OpenAI в размере $30 млрд являются частью более крупного раунда финансирования, который, как ожидается, позволит OpenAI привлечь более $100 млрд с оценкой её рыночной стоимости в $730 млрд, не считая новых средств, сообщили источники. OpenAI реинвестирует большую часть нового капитала в оборудование NVIDIA, но компании откажутся от прежней сделки на $100 млрд, о которой было объявлено в сентябре, добавили источники. По словам источников, это финансирование поддержит создание новых вычислительных мощностей и, вероятно, со временем приведет к заключению новых сделок. Как отметил ресурс eWeek, на практике ничего не поменяется: OpenAI по-прежнему нуждается в огромных вычислительных мощностях, а NVIDIA по-прежнему находится в центре цепочки поставок оборудования, обеспечивающей работу современной экономики ИИ. Меняется лишь то, как формируются риски, сроки и обязательства. Ранее руководители OpenAI и NVIDIA попытались развеять слухи об охлаждении отношений между их компаниями в связи с замораживанием сделки на $100 млрд. «Нам нравится работать с NVIDIA, и они производят лучшие в мире чипы для ИИ. Мы надеемся оставаться их ключевым клиентом очень долгое время», — заявил генеральный директор OpenAI Сэм Альтман (Sam Altman). Следом глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил CNBC, что любые предположения о «спорах» — это «ерунда». «Нам нравится работать с OpenAI», — сказал он. Тем не менее, OpenAI подписала в начале года крупную сделку с Cerebras и уже начала использовать её царь-чипы. Кроме того, у OpenAI есть и сделка с AMD. По словам источников The Financial Times, OpenAI также находится на заключительном этапе переговоров с SoftBank по поводу инвестиций около $30 млрд, и Amazon, которая может инвестировать до $50 млрд в рамках более широкого партнёрства, предполагающего использование ИИ-моделей GPT. Ожидается, что MGX, государственный инвестиционный фонд Абу-Даби в сфере технологий, и Microsoft также инвестируют крупные суммы, а руководители OpenAI на этой неделе встречаются с венчурными капиталистами и другими инвесторами по поводу дальнейших инвестиционных проектов, добавили источники.

20.02.2026 [16:55], Руслан Авдеев

OpenAI и Tata договорились о строительстве 1 ГВт ИИ ЦОД в ИндииИндийские Tata Group, Tata Consultancy Services (TCS) и OpenAI анонсировали новое стратегическое партнёрство. Подразделение HyperVault компании TCS и OpenAI займутся строительством ИИ-инфраструктуры в Индии, сообщает Datacenter Dynamics. Многолетнее партнёрство предусматривает реализацию совместного проекта в несколько этапов. Для начала TCS построит ИИ-инфраструктуру на 100 МВт, в будущем возможно её масштабирование до 1 ГВт. По словам главы OpenAI Сэма Альтмана (Sam Altman), Индия уже является лидером по внедрению искусственного интеллекта. С её талантами, амбициями и сильной правительственной поддержкой у неё очень хорошие позиции для того, чтобы самой творить своё будущее. OpenAI при сотрудничестве с Tata Group работают над строительством инфраструктуры, подготовкой специалистов и заключением локальных соглашений для создания «ИИ с Индией, для Индии и в Индии» таким образом, что многие люди в стране смогут получить доступ к ИИ-инструментам и получать от этого выгоду. Создание ЦОД HyperVault анонсировали в ходе квартального отчёта в прошлом октябре. В планах значится постройка в стране дата-центров Stargate с жидкостным охлаждением общей мощностью 1 ГВт. В предприятие инвестировала частная инвестиционная компания TPG. Как заявляют в Tata, глубокое сотрудничество между OpenAI и Tata Group знаменует важную веху в планах Индии по превращению в глобального лидера в сфере искусственного интеллекта с подготовкой местной молодёжи для преуспевания в новую эру. Согласно договорённости, сотрудники Tata получат доступ к корпоративной версии бота OpenAI — Enterprise ChatGPT. Кроме того, компании будут совместно разрабатывать специальные ИИ-решения. Ранее HyperVault заявляла, что будет применять ускорители AMD на своих объектах, OpenAI также ранее обязалась внедрить оборудование на основе решений AMD. Помимо аренды больших облачных мощностей у гиперскейлеров, OpenAI строит и собственные дата-центры в разных локациях мира в рамках инициативы Stargate. Компания рассчитывает на объекты в многочисленных городах США, а также на локации в Норвегии, Великобритании, ОАЭ и Южной Корее. Имеются планы строительства ЦОД в Аргентине и Канаде. Слухи о том, что OpenAI рассматривает Индию для реализации своих проектов, появились в сентябре 2025 года.

20.02.2026 [15:59], Сергей Карасёв

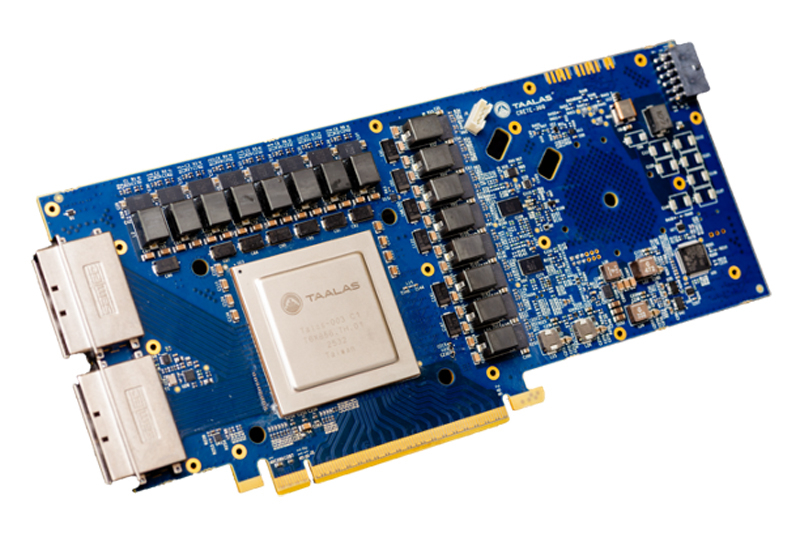

Узкие специалисты: Talaas, разрабатывающая оптимизированные под конкретные ИИ-модели ускорители, получила на развитие $169 млнСтартап Taalas, разрабатывающий чипы, специально оптимизированные для работы с конкретными ИИ-моделями, провел раунд финансирования на сумму в $169 млн. В число инвесторов вошли Quiet Capital и Fidelity, а также венчурный капиталист Пьер Ламонд (Pierre Lamond). Таким образом, на сегодняшний день компания получила на развитие в общей сложности более $200 млн. Фирма Taalas вышла из крытого режима (stealth mode) в марте 2023 года. Стартап занимается созданием чипов, предназначенных для определённых LLM. Первым продуктом компании стало изделие, ориентированное на ИИ-модель Llama 3.1 8B. Утверждается, что этот процессор способен генерировать до 17 тыс. выходных токенов в секунду, что в 73 раза больше по сравнению с NVIDIA H200. При этом решение Taalas потребляет в 10 раз меньше энергии.

Источник изображения: Taalas Оптимизация аппаратных ускорителей под конкретную ИИ-модуль повышает производительность и эффективность благодаря отказу от избыточных компонентов. Однако разработка таких узкоспециализированных изделий представляет собой сложный и дорогостоящий процесс. Компании Taalas удалось решить проблему, создав архитектуру, при которой для «тонкой» настройки требуется кастомизация только двух из более чем 100 слоев, из которых состоят её чипы. Кроме того, Taalas не использует в своих изделиях дорогостоящую память HBM. Это также упрощает конструкцию, позволяя упразднить компоненты, которые необходимы для обеспечения взаимодействия с HBM-модулями. В настоящее время Taalas работает над чипом, предназначенным для запуска ИИ-модели Llama с 20 млрд параметров: выпуск этого решения намечен на лето нынешнего года. Затем появится более мощный чип, ориентированный на LLM высокого уровня.

20.02.2026 [15:23], Владимир Мироненко

Anthropic планирует увеличить к 2029 году расходы на облака до $80 млрдК 2029 году затраты на облачные сервисы ИИ-стартапа Anthropic, согласно его собственным прогнозам, достигнут $80 млрд, сообщил ресурс The Information со ссылкой на свои источники. Расходы будут распределены между Google, Microsoft и Amazon. Помимо оплаты аренды серверов для моделей Claude, Anthropic также делится с облачными провайдерами частью прибыли от продаж своих ИИ-сервисов на их платформах. The Information сообщил со ссылкой на данные стартапа, что в 2024 году эта сумма составила $1,3 млн, и, согласно «самым оптимистичным прогнозам» ресурса, в 2025 году она составила $360 млн, в 2026 году вырастет до $1,9 млрд, а в 2027 году — до $6,4 млрд. Также, по словам источника, Anthropic отчисляет клиентам до 50 % своей валовой прибыли от продаж ИИ-решений на AWS, рассчитываемой на основе выручки за вычетом расходов на облачные ресурсы. Для сравнения, Google обычно получает от 20 % до 30 % чистой выручки после вычета затрат на инфраструктуру от перепродажи ПО своих партнёров. Как утверждает генеральный директор Anthropic Дарио Амодеи (Dario Amodei), компания тратит меньше средств на вычислительные мощности ЦОД по сравнению с другими компаниями в сфере ИИ. Он отметил, что чрезмерные расходы могут быть «разорительными» в случае, когда выручка не гарантирована. Anthropic давно пользуется услугами Google Cloud, и в октябре прошлого года заключила сделку, обеспечивающую ей доступ к облачным ресурсам провайдера мощностью более 1 ГВт с возможностью использования до 1 млн TPU от Google. С этим проектом может быть связана сделка Anthropic по поводу $50 млрд инвестиций в вычислительную инфраструктуру в США в сотрудничестве с Fluidstack. Кроме того, у Anthropic очень тесные отношения с AWS, которая много инвестировала в стартап и развернула для него один из крупнейших в мире ИИ-кластеров Project Rainier. Наконец, в прошлом году компания подписала крупное соглашение с Microsoft Azure. |

|