Материалы по тегу: openai

|

23.04.2024 [13:19], Руслан Авдеев

Глава OpenAI инвестировал в Exowatt, которая поможет запитать ИИ ЦОД от солнечных модулей нового поколенияЗанимающаяся разработкой и выпуском солнечных элементов питания компания Exowatt получила финансирование от руководителя OpenAI Сэма Альтмана (Sam Altman), а также двух других инвесторов. The Register сообщает, что точных данных об объёмах инвестиций Альтмана нет, но вкладывает деньги не его компания, а он лично. Доля вложений Альтмана в Exowatt неизвестна, но есть данные, что двумя другими инвесторами выступили Andreessen Horowitz и Atomic. Общий объём инвестиций составляет $20 млн. В Exowatt рассчитывают генерировать экобезопасное электричество, стоимость которого со временем упадёт до $0,01/кВт·ч. Серьёзные проекты начнут реализовать уже в 2024 году. Exowatt разрабатывает солнечные панели, сохраняющие энергию в виде тепла, которое конвертируется в электричество. Интеграция довольно больших «тепловых аккумуляторов» с собственно солнечными линзами в одном блоке, как заявляют в компании, и является ключевым отличием от других решений. Утверждается, что новое солнечное решение для питания ИИ и дата-центров будущего обеспечит меньшую стоимость энергии, чем у электростанций на ископаемом топливе.

Источник изображения: Exowatt Высокие энергетические показатели чрезвычайно важны, когда речь идёт о дата-центрах, не говоря о ЦОД для ИИ-систем — дефицит электричества является серьёзной проблемой для гиперскейлеров вроде AWS, Microsoft или Google. Сам Альтман ещё в январе 2024 года говорил о проблемах с электроснабжением и подчёркивал, что для развития ИИ потребуется «прорыв» в энергетических технологиях. Считается, что причиной инвестиций Альтмана отчасти стала дружба с главой Atomic Джеком Абрахамом (Jack Abraham), хотя глава OpenAI не впервые вкладывает деньги в энергетические проекты. Например, он поддерживает «атомные» стартапы Helion и Oklo. Примечательно, что первым потенциальным клиентом Helion является Microsoft, имеющая тесные связи с OpenAI — компания намерена получить доступ к электричеству, полученному за счёт термоядерного синтеза, уже в 2028 году. Впрочем, в краткосрочной перспективе будут применяться более привычные источники электричества — солнечная и атомная энергии. Exowatt и другие экзотические энергетические компании всё ещё находятся на стадии стартапов. В то же время Amazon, например, использует традиционную АЭС для питания недавно купленного кампуса ЦОД.

30.03.2024 [13:56], Сергей Карасёв

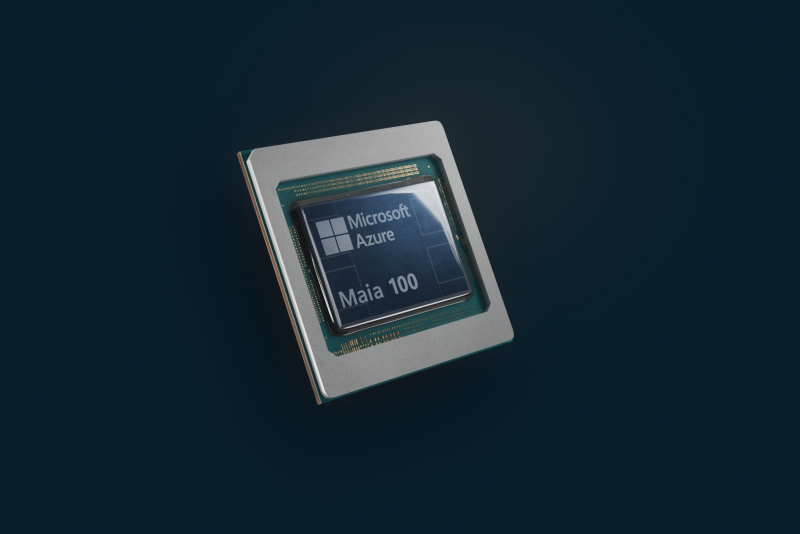

Microsoft и OpenAI хотят создать ИИ ЦОД Stargate мощностью 5 ГВт за $100 млрдКомпании Microsoft и OpenAI, по сообщению ресурса The Information, обсуждают проект строительства масштабного кампуса ЦОД для решения самых сложных и ресурсоёмких задач в области ИИ. Проект получил кодовое название Stargate, а ввод комплекса в эксплуатацию состоится не ранее 2028 года. Скорее всего, речь всё же идёт о сети ЦОД, а не об одном-единственном объекте. По имеющимся сведениям, Microsoft и OpenAI реализуют комплексную программу по развитию ИИ-инфраструктуры, охватывающую период до 2030 года. Инициатива разделена на несколько этапов. В частности, в 2026-м должен быть запущен новый ИИ-суперкомпьютер, после чего планируется развернуть комплекс Stargate стоимостью около $100 млрд. Отмечается, что мощность объектов в составе Stargate может достигать суммарно 5 ГВт. Для их питания рассматриваются альтернативные источники, включая ядерную энергию. В январе нынешнего года стало известно, что Microsoft формирует команду для работы над малыми атомными реакторами. В свою очередь, глава OpenAI Сэм Альтман (Sam Altman) поддерживает компанию Oklo, которая занимается проектами в области атомной энергетики, в том числе для ЦОД. Архитектура Stargate пока не раскрывается. Могут быть задействованы ускорители NVIDIA или AMD следующего поколения или изделия собственной разработки. Ранее говорилось, что Microsoft и OpenAI создают свои ИИ-чипы с тем, чтобы уменьшить зависимость от продукции сторонних поставщиков. В частности, Microsoft уже представила фирменный ИИ-ускоритель Maia 100. Кроме того, редмондская корпорация проектирует DPU для ИИ-серверов. Вместе с тем OpenAI назначила бывшего руководителя Google TPU Ричарда Хо (Richard Ho) главой отдела аппаратного обеспечения. Помимо ИИ-чипов и сетевых компонентов, для проекта Stargate также потребуются серверные стойки высокой плотности, способные поддерживать большую мощность. Что касается ИИ-суперкомпьютера, который планируется запустить в 2026 году, то он расположится в Маунт Плезант (Висконсин, США). В 2023-м Microsoft начала здесь строительство ЦОД стоимостью $1 млрд. В совокупности все предстоящие проекты Microsoft и OpenAI могут стоить около $115 млрд.

22.03.2024 [16:43], Руслан Авдеев

«Атомный» стартап Oklo, поддерживаемый главой OpenAI, ищет главу ЦОД-направленияЗанимающийся проектами в области атомной энергетики стартап Oklo подыскивает директора, готового заняться решениями для ЦОД. Компактные реакторы, разрабатываемы Oklo, способны генерировать до 15 МВт и автономно работать более 10 лет до того, как их понадобится «перезарядить». По данным Datacenter Dynamics, потенциальный директор должен привлечь к продуктам компании корпоративных клиентов и гиперскейлеров. В описании вакансии сообщается, что передовые АЭС Oklo обеспечат дата-центрам энергетическую независимость, которая важна для развёртывания облачных и ИИ-инфраструктур. От кандидата ожидают глубокие знания в области планирования энергоснабжения ЦОД, достаточную квалификацию для выбора площадок, организации строительства, закупок и эксплуатации ЦОД, а также опыт ведения переговоров о покупке энергии (PPA) с крупными потребителями. Изюминка в том, что стартап поддерживает глава OpenAI Сэм Альтман (Sam Altman). Весьма вероятно, что компания, лидирующая в сфере ИИ, очень рассчитывает на подобные технологии, поскольку нынешние ЦОД для ИИ потребляют огромное количество энергии и воды.

Источник изображения: Oklo Oklo находится в процессе обратного слияния со SPAC AltC Acquisition, что позволит выйти ей на публичные торги в июле 2024 года. При нынешней оценке бизнеса в $850 млн компания рассчитывает привлечь $500 млн. Правда, в прошлом году ВВС США отменили выделение $100 млн на один из микрореакторов Oklo. Кроме того, компания ещё не получили одобрения со стороны Комиссии по ядерному регулированию США, хотя и успешно завершила вторую фазу тестов совместно с Аргоннской национальной лабораторией. С некоторых пор дата-центры рассматриваются компанией в качестве потенциального рынка для своих решений, а появление новой вакансии косвенно свидетельствует о том, что теперь она хотела бы привлечь клиентов в этой сфере. Индустрия ЦОД, испытывавшая недостаток электроэнергии ещё до ИИ-бума, рассматривает микрореакторы или малые модульные реакторы (SMR) в качестве потенциального решения проблемы питания. Ранее в этом году Microsoft, также рассматривающая использование SMR для питания своих ЦОД, наняла ветеранов атомной отрасли. Amazon же пошла более традиционным путём, потратив $650 млн на покупку ЦОД, запитанного от полноценной АЭС. А в России уже более пяти лет работает дата-центр «Калининский», расположенный у одноимённой АЭС.

16.11.2023 [02:43], Алексей Степин

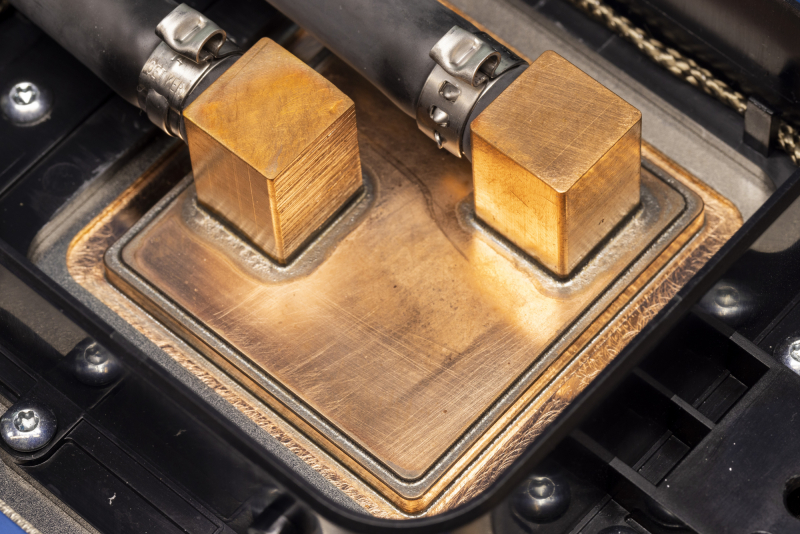

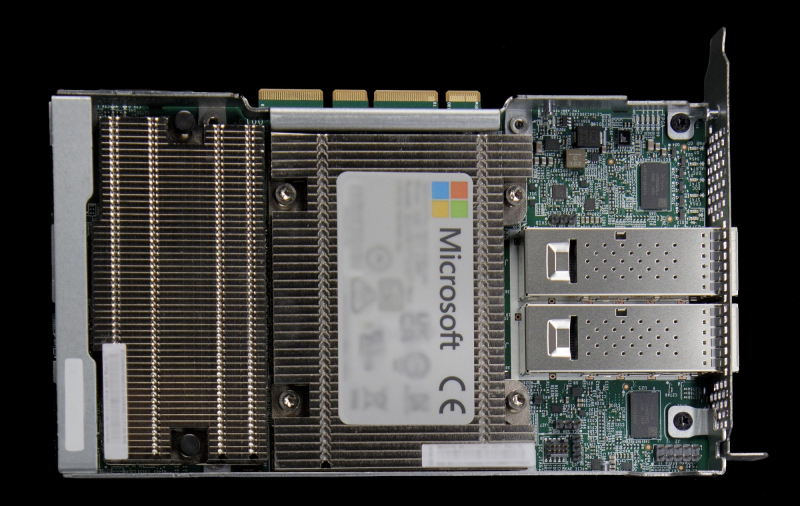

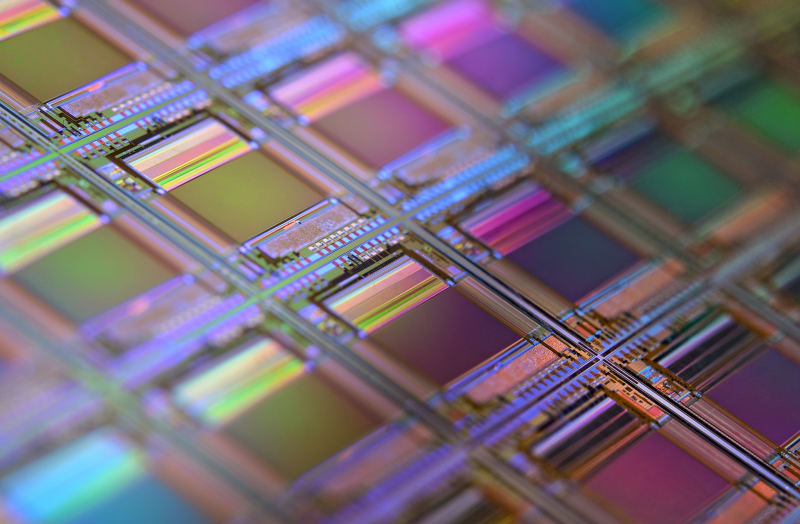

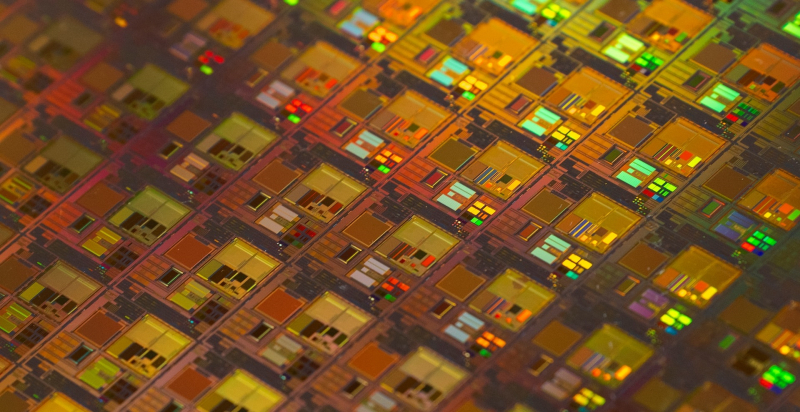

Microsoft представила 128-ядерый Arm-процессор Cobalt 100 и ИИ-ускоритель Maia 100 собственной разработкиГиперскейлеры ради снижения совокупной стоимости владения (TCO) и зависимости от сторонних вендоров готовы вкладываться в разработку уникальных чипов, изначально оптимизированных под их нужды и инфраструктуру. К небольшому кругу компаний, решившихся на такой шаг, присоединилась Microsoft, анонсировавшая Arm-процессор Azure Cobalt 100 и ИИ-ускоритель Azure Maia 100. Первопроходцем в этой области стала AWS, которая разве что память своими силами не разрабатывает. У AWS уже есть три с половиной поколения Arm-процессоров Graviton и сразу два вида ИИ-ускорителей: Trainium для обучения и Inferentia2 для инференса. Крупный китайский провайдер Alibaba Cloud также разработал и внедрил Arm-процессоры Yitian и ускорители Hanguang. Что интересно, в обоих случаях процессоры оказывались во многих аспектах наиболее передовыми. Наконец, у Google есть уже пятое поколение ИИ-ускорителей TPU. Microsoft заявила, что оба новых чипа уже производятся на мощностях TSMC с использованием «последнего техпроцесса» и займут свои места в ЦОД Microsoft в начале следующего года. Как минимум, в случае с Maia 100 речь идёт о 5-нм техпроцессе, вероятно, 4N. В настоящее время Microsoft Azure находится в начальной стадии развёртывания инфраструктуры на базе новых чипов, которая будет использоваться для Microsoft Copilot, Azure OpenAI и других сервисов. Например, Bing до сих пор во много полагается на FPGA, а вся ИИ-инфраструктура Microsoft крайне сложна. Microsoft приводит очень мало технических данных о своих новинках, но известно, что Azure Cobalt 100 имеет 128 ядер Armv9 Neoverse N2 (Perseus) и основан на платформе Arm Neoverse Compute Subsystem (CSS). По словам компании, процессоры Cobalt 100 до +40 % производительнее имеющихся в инфраструктуре Azure Arm-чипов, они используются для обеспечения работы служб Microsoft Teams и Azure SQL. Oracle, вложившаяся в своё время в Ampere Comptuing, уже перевела все свои облачные сервисы на Arm. Чип Maia 100 (Athena) изначально спроектирован под задачи облачного обучения ИИ и инференса в сценариях с использованием моделей OpenAI, Bing, GitHub Copilot и ChatGPT в инфраструктуре Azure. Чип содержит 105 млрд транзисторов, что больше, нежели у NVIDIA H100 (80 млрд) и ставит Maia 100 на один уровень с Ponte Vecchio (~100 млрд). Для Maia организован кастомный интерконнект на базе Ethernet — каждый ускоритель располагает 4,8-Тбит/с каналом для связи с другими ускорителями, что должно обеспечить максимально эффективное масштабирование. Сами Maia 100 используют СЖО с теплообменниками прямого контакта. Поскольку нынешние ЦОД Microsoft проектировались без учёта использования мощных СЖО, стойку пришлось сделать более широкой, дабы разместить рядом с сотней плат с чипами Maia 100 серверами и большой радиатор. Этот дизайн компания создавала вместе с Meta✴, которая испытывает аналогичные проблемы с текущими ЦОД. Такие стойки в настоящее время проходят термические испытания в лаборатории Microsoft в Редмонде, штат Вашингтон. В дополнение к Cobalt и Maia анонсирована широкая доступность услуги Azure Boost на базе DPU MANA, берущего на себя управление всеми функциями виртуализации на манер AWS Nitro, хотя и не целиком — часть ядер хоста всё равно используется для обслуживания гипервизора. DPU предлагает 200GbE-подключение и доступ к удалённому хранилищу на скорости до 12,5 Гбайт/с и до 650 тыс. IOPS. Microsoft не собирается останавливаться на достигнутом: вводя в строй инфраструктуру на базе новых чипов Cobalt и Maia первого поколения, компания уже ведёт активную разработку чипов второго поколения. Впрочем, совсем отказываться от партнёрства с другими вендорами Microsoft не намерена. Компания анонсировала первые инстансы с ускорителями AMD Instinct MI300X, а в следующем году появятся инстансы с NVIDIA H200.

08.10.2023 [17:08], Владимир Мироненко

OpenAI и Microsoft заняты созданием собственных ИИ-чипов, чтобы уменьшить зависимость от NVIDIAКомпания OpenAI, создавшая чат-бот на базе искусственного интеллекта ChatGPT, изучает возможность выпуска собственных ИИ-чипов, сообщает Reuters. По словам источников агентства, изучение этого вопроса продвинулось настолько далеко, что OpenAI даже провела оценку возможности покупки одного из производителей чипов, имя которого выяснить не удалось. На фоне бума ИИ на рынке наблюдается нехватка специализированных ускорителей, в первую очередь NVIDIA. Как утверждают источники, в прошлом году OpenAI рассматривала ряд вариантов решения этой проблемы, включая разработку собственного ИИ-чипа, более тесное сотрудничество с другими производителями ИИ-чипов, в том числе, NVIDIA, а также расширение круга поставщиков ускорителей. Впрочем, даже если OpenAI приобретёт производителя чипов, на создание ИИ-ускорителя уйдёт несколько лет, в течение которых она всё равно будет зависеть от сторонних поставщиков, таких как NVIDIA и AMD. Гендиректор Open AI Сэм Альтман (Sam Altman), назвавший приобретение большего количества ИИ-чипов главным приоритетом, публично жаловался на нехватку ускорителей вычислений на рынке, порядка 80 % которого контролирует NVIDIA. Помимо нехватки чипов Альтман назвал ещё одну проблему, имеющуюся у компании — высокие затраты на эксплуатацию аппаратного обеспечения, необходимого для реализации проектов и продуктов компании. Microsoft, которой принадлежит 49 % OpenAI, повторяет те же тезисы и ищет более экономичные альтернативы GPT-4. С 2020 года OpenAI использует для разработки ИИ-решений мощный суперкомпьютер, построенный Microsoft на базе 10 тыс. ускорителей NVIDIA. Работа ChatGPT обходится компании в немалую сумму. Согласно данным аналитика Bernstein Стейси Расгон (Stacy Rasgon), затраты на выполнение каждого запроса составляют примерно $0,04. Даже при росте количества запросов до десятых долей от объёма поисковых запросов Google, для запуска чат-бота потребуется потратить $48 млрд на первичную закупку ИИ-чипов, а для дальнейшего поддержания работы придётся тратить на ускорители ещё по $16 млрд ежегодно. В случае выпуска собственных чипов OpenAI пополнит небольшую группу крупных IT-игроков вроде Google и Amazon, которые стремятся взять под свой контроль разработку «кремния», лежащего в основе их бизнеса. OpenAI пока не решила, готова ли она тратить сотни миллионов долларов в год на создание чипа без каких либо гарантий на успех. Например, Meta✴ при разработке ASIC столкнулась с проблемами, из-за которых пришлось отказаться от дальнейшей работы над некоторыми ИИ-чипами, а выход первого ИИ-ускорителя MTIA задержался на два года. Из-за этого, в частности, Meta✴ была вынуждена приостановить строительство ряда своих дата-центров, чтобы адаптировать их для размещения ускорителей NVIDIA. По данным The Information, Microsoft тоже разрабатывает собственный ИИ-чип, а OpenAI тестирует его. Впервые об ИИ-ускорителях Athena, которые компания якобы разрабатывала с 2019 года, стало известно в апреле этого года. Они должны помочь Microsoft снизить зависимость от продукции NVIDIA, дефицит которых компания признала угрозой бизнесу. Ранее Microsoft, по слухам, подписала соглашения с CoreWeave и Lambda Labs, а также обсуждала с Oracle совместное использования ускорителей NVIDIA. Причина кроется в политике NVIDIA, которая, как считается, гораздо охотнее продаёт «железо» малым провайдерам, которые не пытаются создавать собственные ИИ-чипы, т.е. не опасны для бизнеса «зелёных».

01.10.2023 [20:55], Руслан Авдеев

Microsoft ищет более дешёвые в эксплуатации и простые альтернативы языковым моделям OpenAIХотя Microsoft принадлежит 49 % OpenAI, занимающейся разработкой популярных и производительных языковых моделей вроде GPT-4, интересы компаний не всегда совпадают. Как сообщает Silicon Angle, Bing Chat Enterprise первой и ChatGPT Enterprise второй, по сути, конкурируют за одну и ту же целевую аудиторию. Кроме того, Microsoft, стремящаяся внедрить ИИ почти во все свои программные продукты, готовит новые, более простые и менее ресурсоёмкие модели, чем GPT-4. По данным источников в OpenAI, в Microsoft обеспокоены высокой стоимостью эксплуатации передовых ИИ-моделей. Microsoft пытается встроить ИИ во многие продукты, включая Copilot для Windows на базе GPT-4. С учётом того, что пользователей Windows в мире больше 1 млрд, в компании опасаются, что повсеместное распространение ИИ-инструментов приведёт к неконтролируемому росту расходов. По некоторым данным, компания уже поручила части из своих 1,5 тыс. сотрудников ИИ-департамента заняться более экономичными альтернативами — пусть даже они будут не столь «сообразительными». Хотя реализация соответствующих проектов всё ещё находится на ранних стадиях, уже появилась информация, что компания начала внутренние тесты моделей собственной разработки. В частности, «творческий» и «точный» режимы Bing Chat опираются на GPT-4, тогда как «сбалансированный» использует новые модели Prometheus и Turing. Последняя может отвечать только на простые вопросы, а более каверзные она всё равно вынуждена передавать на обработку творению OpenAI. Для программистов у Microsoft есть модель Phi-1 с 1,3 млрд параметров, которая может эффективно генерировать код, но в остальном отстаёт от GPT-4. Ещё одной альтернативой стала разработанная Microsoft модель Orca на основе Meta✴ Llama-2, принадлежащей Meta✴. По некоторым данным, Orca близка по возможностям к моделям OpenAI, но компактнее и требует значительно меньше ресурсов. Считается, что подразделение Microsoft использует около 2 тыс. ускорителей NVIDIA, большинство из которых сегодня и применяется для тренировки более эффективных моделей, имеющих узкую специализацию в отличие от многопрофильной GPT-4. Если раньше состязание на рынке шло за создание ИИ с наибольшими возможностями, то теперь одним из важнейших факторов становится стоимость разработки и обслуживания таких инструментов.

11.09.2023 [19:35], Руслан Авдеев

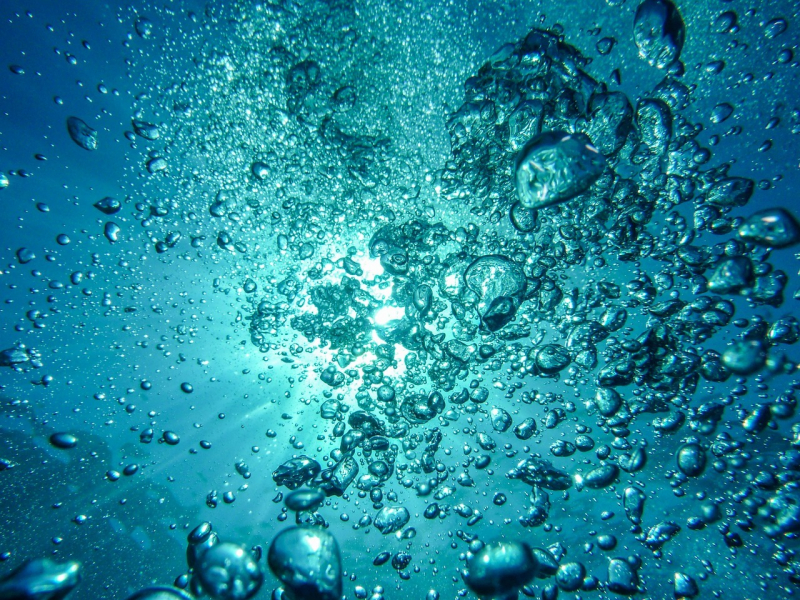

GPT-3 «выпила» более 320 тыс. литров: ЦОД тратят огромное количество воды для охлаждения ИИ-серверовМногие знают, что ИИ-модели в процессе работы потребляют огромное количество энергии, но не всем известно, что им нужно ещё и очень много чистой воды. Как сообщает Silicon Angle, выяснилось, что ЦОД стоящих за работой ИИ-систем компаний тратят очень много воды, а у техногигантов вроде Google и Microsoft водопотребление только растёт. Как следует из доклада Associated Press, использование ЦОД Microsoft воды выросло с 2021 по 2022 гг. на 34 %, в прошлом году компания потратила 6,4 млрд литров. В тот же период водопотребление Google выросло на 20 %. По данным экспертов, занимавшихся исследованием воздействия генеративных ИИ-систем на окружающую среду, в большей части рост потребления вызван увеличением связанных с ИИ нагрузок. По некоторым оценкам, модель GPT-3 компании OpenAI, стоящая за чат-ботом ChatGPT, ответственна за трату более 320 тыс. л во время тренировки, а ChatGPT и вовсе «выпивает» 0,5 л воды каждую чат-сессию, состоящую из 25-50 запросов. Учитывается и непрямое использование воды, включающее затраты электростанций, питающих ЦОД.

Источник изображения: MartinStr/pixabay.com Для Google статистика оказалась крайне неоднородной и разнится от ЦОД к ЦОД — многое зависит от местоположения, сезона, технологии охлаждения и уровня потребления воды электростанциями. Впрочем, многие специалисты отрасли уверены, что рост потребления воды имеет важное значение, но большие опасения вызывает рост энергопотребления. Дело в том, что значительная часть используемой воды перерабатывается и применяется снова, тогда как об энергии нельзя сказать того же. Кроме того, Microsoft, Google и другие операторы ЦОД сами заинтересованы в сокращении потребления воды, поэтому будут принимать все необходимые меры для этого. Ранее Microsoft сообщала, что намерена стать «водно-положительной», «углеродно-отрицательной» и безотходной уже к 2030 году, а к 2024 году снизить потребление ЦОД воды на 95 % (в сравнении с 2021 годом). Впрочем, до сих пор нет точных определений некоторым терминам, например, никто детально не говорил, о какой «водно-положительности» идёт речь. Можно только предполагать, что компания намерена отдавать в природу больше воды, чем потребляет. Примером может служить Pepsi, которая, пропустив воду сквозь снековое оборудование в районе Мехико, очищает её до уровня питьевой и отправляет на другой завод — для мытья картофеля для чипсов. Таким образом, воды действительно поступает «в оборот» больше, чем изначально забирается из природных источников. В OpenAI, крупнейшим инвестором которой является Microsoft, подчеркнули, что осознают высокие уровни потребления ИИ энергии и воды и активно работают над повышением эффективности в этой сфере. Решением может стать создание для ИИ более эффективных алгоритмов и оборудования, хотя на это уйдёт некоторое время.

29.08.2023 [17:07], Руслан Авдеев

OpenAI представила сервис ChatGPT Enterprise с расширенной функциональностью и инструментами киберзащитыКомпания OpenAI продолжает расширять номенклатуру решений на основе ChatGPT. Как сообщает Silicon Angle, теперь в её портфолио появилась версия ChatGPT Enterprise, обеспечивающая корпоративным пользователям дополнительную функциональность и усиленную защиту, а в будущем появится ещё и версия ChatGPT Business. Речь идёт о решении, целевой аудиторией которого являются крупные организации и бизнес-структуры. ChatGPT Enterprise построен на основе расширенной версии большой языковой модели (LLM) GPT-4 и вдвое быстрее стандартного варианта при выдаче ответов.

Источник изображения: OpenAI Одной из главных отличительных функций ChatGPT Enterprise является безлимитный доступ к инструменту Advanced Data Analysis. Ранее он был известен, как Code Interpreter и позволяет, например, осуществлять математические вычисления, визуализировать результаты или, например, менять форматы файлов обычными языковыми командами. В компании уже работают над усовершенствованной версией Advanced Data Analysis, а также намерены добавить боту и другие инструменты для анализа информации, маркетинга и поддержки клиентов. При этом разработчики увеличили максимальный объём запроса до 32 тыс. токенов за раз. Дополнительно предусматривается расширение набора данных, которые сможет использовать ChatGPT Enterprise для обучения. Например, в обозримом будущем станет возможны безопасное подключение к боту приложений, которые уже используются компаниями.

Источник изображения: OpenAI Поскольку целевая аудитория ChatGPT Enterprise уделяет особое внимание защите своих данных, новый ИИ-бот соответствует стандарту кибербезопасности SOC 2, предусматривающему шифрование данных пользователей при передаче. Дополнительно защититься помогает консоль управления, интегрированная в интерфейс ChatGPT Enterprise. Например, с её помощью можно будет централизованно управлять аккаунтами сотрудников компаний и отслеживать их работу с чат-ботом. OpenAI сообщила, что ChatGPT Enterprise уже используется в тестовом режиме некоторыми компаниями, включая Canva Pty Ltd и Klarna Bank AB, а в ближайшие недели разработчик постарается привлечь как можно больше клиентов. Пока достоверно неизвестно, когда именно станут общедоступными анонсированные функции. Дополнительно в будущем планируется представить и ещё одну платную версию — ChatGPT Business для «команд любых размеров». Продукты OpenAI уже довольно активно используются корпоративными клиентами при содействии партнёров компании. Например, доступ к ChatGPT ещё в марте появился в облачной службе Microsoft Azure OpenAI Service.

10.05.2023 [22:35], Владимир Мироненко

Microsoft и Oracle обсуждают возможность совместного использования облачных серверов из-за нехватки ИИ-ускорителейMicrosoft и Oracle изучают возможность аренды серверов друг у друга на случай, если у них вдруг не будет хватать вычислительных мощностей для выполнения ИИ-нагрузок крупных облачных клиентов, пишет DataCenter Dynamics со ссылкой на The Information. Уточняется, что решение по сделке Oracle и Microsoft, которая позволила бы решить проблему нехватки серверов с высокопроизводительными ускорителями, пока не принято. Компании заключили соглашение о сотрудничестве ещё в 2019 году, чтобы предоставить клиентам возможность совместно выполнять вычисления в их облачных сервисах. Это потребовало создания прямых оптоволоконных каналов между ЦОД Oracle и Microsoft. Сформированная инфраструктура может быть использована для совместного использования серверных мощностей, сообщил ресурсу The Information источник, знакомый с этим вопросом. Microsoft уже некоторое время работает над собственным ИИ-чипами Athena, а пока вынуждена скупать ускорители NVIDIA, которых, судя по всему, ей уже не хватает. У Oracle тоже достаточно тесные отношения с NVIDIA — последняя выбрала именно облако Oracle Cloud Infrastructure (OCI) для первичного запуска сервиса DGX Cloud. Причём зарабатывает на этом сервисе в первую очередь сама NVIDIA.

Источник изображения: Microsoft Ранее сообщалось, что Microsoft ограничивала доступ к ИИ-серверам для ряда своих внутренних команд, чтобы отдать ресурсы своим клиентам. Одна из таких компаний — OpenAI, разработавшая ИИ-чат-бот ChatGPT и нейронную сеть Dall-E. Microsoft инвестировала в OpenAI миллиарды долларов, получив взамен эксклюзивную лицензию на предоставление её услуг в облаке Azure. Как сообщают источники, Oracle выясняла, возможна ли перепродажа решений OpenAI напрямую её клиентам по аналогии с тем, как она перепродаёт пакет приложений Microsoft 365.

22.03.2023 [12:38], Сергей Карасёв

Microsoft обеспечила облачный доступ к GPT-4 в Azure OpenAI ServiceКорпорация Microsoft сообщила о том, что новейшая версия большой языковой ИИ-модели компании OpenAI стала доступна в облачной службе Azure OpenAI Service. Речь идёт о модели GPT-4, которая была официально представлена немногим более недели назад. Изначально Microsoft объявила об интеграции чат-бота ChatGPT в состав Azure OpenAI Service в начале марта нынешнего года. Тогда говорилось, что заявки на использование наиболее передовых ИИ-моделей, включая Dall-E 2, GPT-3.5 и Codex, подали более 1000 клиентов. Теперь же клиенты могут подать заявку на использование GPT-4. Стоимость услуги составляет от $0,03 до $0,12 за обработку 1 тыс. токенов — элементов, на которые разбивается текст при работе.

Источник изображения: pixabay.com «Недавно анонсированные новые продукты Bing и Microsoft 365 Copilot уже работают на GPT-4, и теперь компании получат возможность использовать те же базовые расширенные модели для создания собственных приложений с применением службы Azure OpenAI Service», — говорится в публикации Microsoft. С помощью GPT-4 корпоративные пользователи смогут оптимизировать взаимодействие как внутри компании, так и со своими клиентами. На базе Azure OpenAI Service, например, можно быстро создавать виртуальных помощников. В целом, как утверждается, технологии генеративного ИИ открывают принципиально новые возможности для бизнеса в каждой отрасли. |

|