Материалы по тегу: mi300

|

27.02.2024 [21:44], Сергей Карасёв

Gigabyte представила новые серверы для ИИ, 5G и периферийных вычисленийКомпания Gigabyte Technology на MWC 2024 анонсировала новые серверы для ИИ-задач, 5G-сетей, облачных и периферийных вычислений. Дебютировали модели на процессорах AMD и Intel, оснащённые мощными ускорителями. В частности, представлены серверы G593-ZX1/ZX2, оборудованные восемью картами AMD Instinct MI300X для ресурсоёмких вычислений. Кроме того, демонстрируются сервер высокой плотности H223-V10 с поддержкой суперчипа NVIDIA Grace Hopper, модель G383-R80 с четырьмя APU AMD Instinct MI300A и сервер серии G593, оснащённый восемью ускорителями NVIDIA HGX H100. Ещё одна новинка — сервер хранения S183-SH0. Он допускает использование 32 SSD формата E1.S (NVMe), благодаря чему подходит для обработки сложных рабочих нагрузок, таких как большие языковые модели (LLM). Эти серверы также могут быть интегрированы в суперкомпьютерные кластеры и инфраструктуру 5G. На edge-сегмент рассчитан сервер E263-S30 с модульной архитектурой: он может быть адаптирован под различные сценарии использования путём установки необходимых аппаратных компонентов. А модель R163-P32 комплектуется процессором AmpereOne с архитектурой Arm (до 192 ядер Arm с частотой до 3,0 ГГц), что обеспечивает высокую энергетическую эффективность.

На ИИ-приложения и облачные периферийные вычисления ориентированы серверы R243-EG0 и R143-EG0, которые оснащены чипами AMD EPYC 8004 Siena. Для сегмента малого и среднего бизнеса Gigabyte предлагает серверы R113-C10 и R123-X00, наделённые процессорами AMD Ryzen 7000 и Intel Xeon E-2400: эти модели подходят для веб-хостинга, создания гибридных облаков и хранилищ данных.

21.12.2023 [14:51], Сергей Карасёв

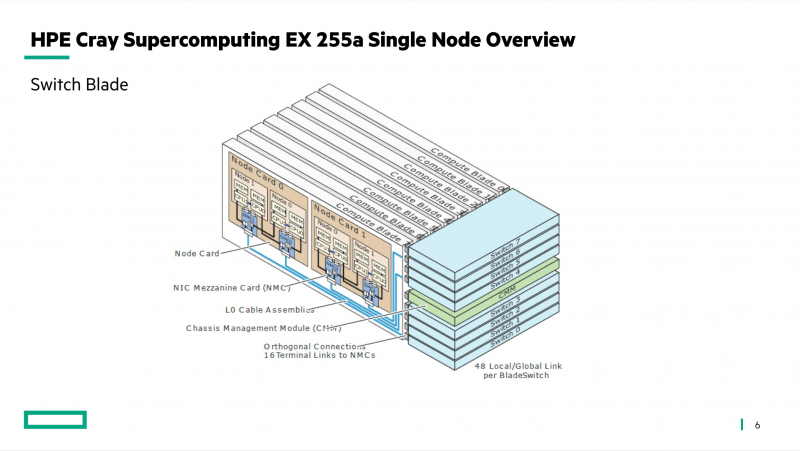

Германия построит суперкомпьютер Herder экзафлопсного уровняЦентр высокопроизводительных вычислений HLRS в Штутгарте (Германия) объявил о заключении соглашения с компанией HPE по созданию двух новых суперкомпьютеров — систем Hunter и Herder. Они, как утверждается, предоставят «инфраструктуру мирового класса» для моделирования, ИИ, анализа данных и других ресурсоёмких задач в различных областях. Hunter заменит нынешний флагманский суперкомпьютер HLRS под названием Hawk. В основу Hunter ляжет платформа HPE Cray EX4000: в общей сложности планируется задействовать 136 таких узлов, каждый из которых будет оснащён четырьмя адаптерами HPE Slingshot. Архитектура Hunter предусматривает применение СХД нового поколения Cray ClusterStor, специально разработанной с учётом жёстких требований к вводу/выводу. Кроме того, будет задействована среда HPE Cray Programming Environment, которая предоставляет полный набор инструментов для разработки, портирования, отладки и настройки приложений.

Источник изображения: HLRS Суперкомпьютер Hunter получит ускорители AMD Instinct MI300A. Утверждается, что это позволит сократить энергопотребление по сравнению с Hawk примерно на 80 % при пиковой производительности. Быстродействие Hunter составит около 39 Пфлопс против 26 Пфлопс у Hawk. Систему планируется ввести в эксплуатацию в 2025 году. Суперкомпьютер экзафлопсного класса Herder заработает не ранее 2027 года. Архитектура предусматривает применение ускорителей, но окончательная конфигурация комплекса будет определена только к концу 2025-го. Общая стоимость Hunter и Herder оценивается в €115 млн. Финансирование будет осуществляться через Центр суперкомпьютеров Гаусса (GCS), альянс трёх национальных суперкомпьютерных центров Германии. Половину средств предоставит Федеральное министерство образования и исследований Германии (BMBF), оставшуюся часть — Министерство науки, исследований и искусств земли Баден-Вюртемберг. Нужно отметить, что в 2024 году в Юлихском исследовательском центре (FZJ) в Германии заработает вычислительный комплекс Jupiter — первый европейский суперкомпьютер экзафлопсного класса. Кроме того, систему такого уровня намерена создать Великобритания.

09.12.2023 [23:16], Сергей Карасёв

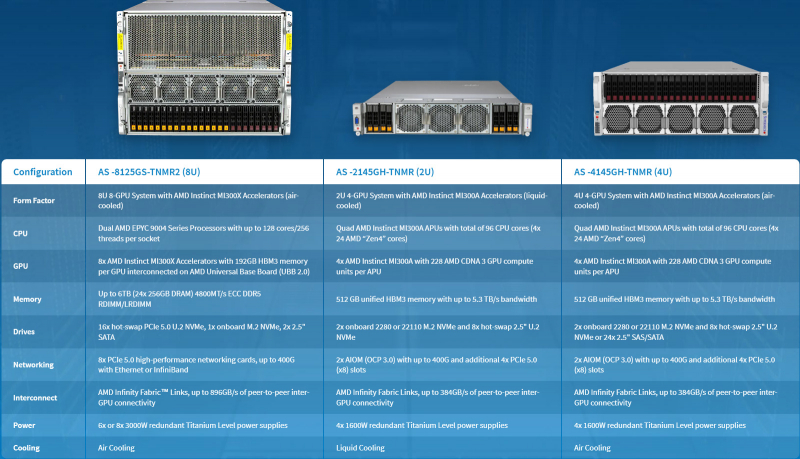

Supermicro представила ИИ-серверы с ускорителями AMD Instinct MI300 и СЖОКомпания Supermicro анонсировала серверы AS-8125GS-TNMR2, AS-4145GH-TNMR и AS-2145GH-TNMR, предназначенные для задач НРС и ИИ, в том числе для обучения больших языковых моделей (LLM). Новинки выполнены на аппаратной платформе AMD и оборудованы ускорителями серии Instinct MI300. Модель AS-8125GS-TNMR2 соответствует типоразмеру 8U. Она оснащена двумя процессорами AMD EPYC Genoa с показателем TDP до 400 Вт и восемью ускорителями Instinct MI300X со 192 Гбайт памяти HBM3. Объём оперативной памяти DDR5-4800 RDIMM/LRDIMM может достигать 6 Тбайт (24 слота). Доступны 18 отсеков для SFF-накопителей NVMe/SATA и коннектор M.2 NVMe. Предусмотрены восемь слотов для карт PCIe 5.0 x16 LP и два слота для карт PCIe 5.0 x16 FHFL. Задействована система воздушного охлаждения. Питание обеспечивают шесть или восемь блоков мощностью 3000 Вт с сертификатом 80 Plus Titanium.

Источник изображений: Supermicro Серверы AS-4145GH-TNMR и AS-2145GH-TNMR выполнены в форм-факторе 4U и 2U соответственно. Первый наделён системой воздушного охлаждения, второй — жидкостного. При этом оба получили четыре чипа Instinct MI300A (24 ядра EPYC Genoa, ускоритель CDNA 3 и 128 Гбайт памяти HBM3). Устройство AS-4145GH-TNMR располагает 24 отсеками для накопителей SFF NVMe/SAS/SATA с возможностью горячей замены и двумя разъёмами для модулей M.2 NVMe или SATA. Есть шесть слотов PCIe 5.0 x16 FHHL и два разъёма PCIe 5.0 x16 AIOM. Задействованы четыре блока питания на 1600 Вт с сертификатом 80 Plus Titanium. Сервер AS-2145GH-TNMR получил восемь посадочных мест для накопителей SFF NVMe/SAS/SATA и два разъёма для SSD M.2 NVMe или SATA. Доступны четыре слота PCIe 5.0 x16 FHHL и два слота PCIe 5.0 x16 AIOM. За питание отвечают четыре блока на 1600 Вт с сертификатом 80 Plus Titanium.

08.12.2023 [16:31], Сергей Карасёв

Gigabyte представила серверы с ускорителями AMD Instinct MI300 для задач ИИ и HPCКомпания Giga Computing (Gigabyte) анонсировала серверы G383-R80, G593-ZX1 и G593-ZX2 на аппаратной платформе AMD, предназначенные для решения ресурсоёмких задач: это могут быть приложения ИИ и HPC. Все новинки оборудованы ускорителями серии Instinct MI300. Модель G383-R80, выполненная в формате 3U, несёт на борту четыре чипа Instinct MI300A (24 ядра EPYC Genoa, ускоритель CDNA 3 и 128 Гбайт памяти HBM3). Во фронтальной части расположены 8 отсеков для SFF-накопителей NVMe SSD.

Источник изображений: Gigabyte Могут быть задействованы до 12 слотов расширения для карт FHFL с интерфейсом PCIe 5.0. Есть слот для SSD стандарта М.2 2280/22110 с интерфейсом PCIe 5.0 x4, два сетевых порта 10GbE (Broadcom BCM57416), выделенный порт управления 1GbE, контроллер Aspeed AST2600, два порта USB 3.2 Gen1 и разъём D-Sub. Питание обеспечивают четыре блока мощностью 2200 Вт каждый с сертификатом 80 Plus Titanium. Серверы G593-ZX1 и G593-ZX2, в свою очередь, имеют типоразмер 5U. Они комплектуются двумя процессорами AMD EPYC Genoa с показателем TDP до 300 Вт и восемью ускорителями Instinct MI300X OAM со 192 Гбайт памяти HBM3. Для модулей ОЗУ стандарта DDR5-4800 доступны 24 разъёма. Спереди находятся восемь отсеков для SFF-накопителей NVMe SSD.  Эти серверы оборудованы двумя слотами для SSD формата М.2 2280/22110 с интерфейсом PCIe 3.0 (по одному х1 и х4), двумя портами 10GbE (Intel X710-AT2), выделенным сетевым портом управления 1GbE, контроллером Aspeed AST2600, двумя портами USB 3.2 Gen1 и разъёмом D-Sub. Предусмотрены четыре слота PCIe 5.0 x16 для карт FHHL и восемь слотов PCIe 5.0 x16 для LP-карт. Версия G593-ZX1 получила восемь root-портов, модель G593-ZX2 — четыре. Установлены шесть блоков питания на 3000 Вт с сертификатом 80 Plus Titanium.

07.12.2023 [16:54], Сергей Карасёв

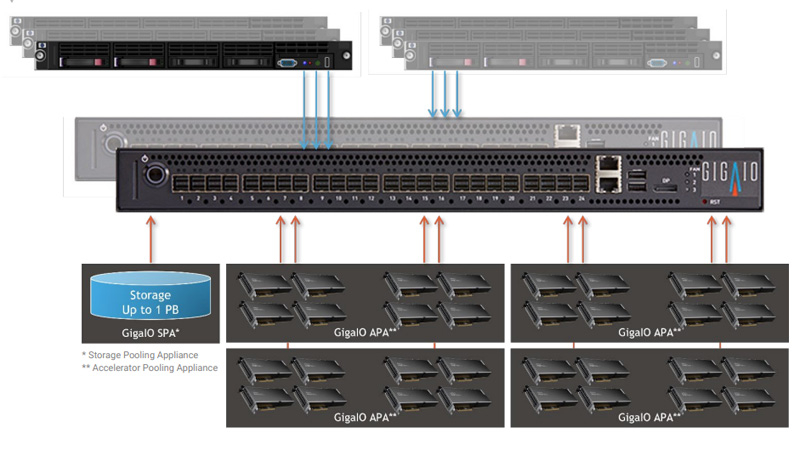

GigaIO создаст уникальное ИИ-облако с тысячами ускорителей AMD Instinct MI300XКомпания GigaIO объявила о заключении соглашения по созданию инфраструктуры для специализированного ИИ-облака TensorNODE, которое создаётся провайдером TensorWave. В составе платформы будут применяться ускорители AMD Instinct MI300X, оснащённые 192 Гбайт памяти HBM3. Основой TensorNODE послужат мини-кластеры SuperNODE, дебютировавшие летом уходящего года. Особенность этого решения заключается в том, что оно позволяет связать воедино 32 и даже 64 ускорителя посредством распределённого интерконнекта на базе PCI Express. TensorWave будет использовать FabreX для формирования пулов памяти петабайтного масштаба. На первом этапе в начале 2024 года платформа TensorNODE объединит до 5760 ускорителей Instinct MI300X в одном домене. Таким образом, при решении сложных задач можно будет получить доступ более чем к 1 Пбайт памяти с любого узла. Это, как отмечается, позволит обрабатывать даже самые ресурсоёмкие нагрузки в рекордно короткие сроки.

Источник изображения: GigaIO В течение следующего года планируется развернуть несколько систем TensorNODE. Архитектура GigaIO обеспечит улучшенную гибкость по сравнению с традиционными решениями: инфраструктуру можно будет оптимизировать «на лету» для удовлетворения как текущих, так и будущих потребностей в области ИИ и больших языковых моделей (LLM). Отмечается, что TensorNODE полностью базируется на ключевых компонентах AMD. Помимо ускорителей Instinct MI300X, это процессоры EPYC Genoa. Облако TensorWave обеспечит снижение энергозатрат и общей стоимости владения благодаря исключению из конфигурации избыточных серверов и связанного с ними сетевого оборудования.

16.11.2023 [15:29], Сергей Карасёв

В Microsoft Azure появились инстансы ND MI300X v5 с восемью ускорителями AMD Instinct и процессорами Intel XeonКомпания Microsoft анонсировала инстансы Azure ND MI300X v5 на основе ускорителей AMD Instinct MI300X, представленных летом нынешнего года. Эти ВМ ориентированы на ресурсоёмкие ИИ-нагрузки, в частности, на решение задач инференса. Изделия Instinct MI300X несут на борту 192 Гбайт памяти HBM3 с пропускной способностью до 5,2 Тбайт/с. В составе одной виртуальной машины ND MI300X v5 объединены восемь ускорителей, соединённых между собой посредством Infinity Fabric 3.0, а с хостом — по PCIe 5.0. В сумме это даёт 1,5 Тбайт памяти HBM3, что, как отмечает Microsoft, является самой большой ёмкостью HBM, доступной в облаке. Виртуальные машины Azure ND — это дополнение к семейству решений на базе GPU, такие машины специально предназначены для рабочих нагрузок ИИ и глубокого обучения. Microsoft подчёркивает, что в случае ND MI300X v5 используется та же аппаратная платформа, которая применяется и для других ВМ семейства. Она включает процессоры Intel Xeon Sapphire Rapids, 16 каналов оперативной памяти DDR5, а также подключение NVIDIA Quantum-2 CX7 InfiniBand с пропускной способностью 400 Гбит/с на каждый ускоритель и 3,2 Тбит/с на виртуальную машину.

Источник изображения: AMD По заявлениям Microsoft, на базе ND MI300X v5 могут запускаться самые крупные модели ИИ. Клиенты могут быстро перейти на новые инстансы с других решений серии ND благодаря тому, что открытая платформа AMD ROCm содержит все библиотеки, компиляторы, среды выполнения и инструменты, необходимые для ускорения ресурсоемких приложений.

22.10.2023 [14:06], Сергей Карасёв

Видео дня: строительство 2-Эфлопс суперкомпьютера El CapitanЛиверморская национальная лаборатория им. Э. Лоуренса (LLNL) Министерства энергетики США опубликовала видео (см. ниже), демонстрирующее процесс сборки вычислительного комплекса El Capitan, которому предстоит стать самым мощным суперкомпьютером мира. В текущем рейтинге TOP500 лидирует система Frontier, установленная в Национальной лаборатории Окриджа (ORNL), также принадлежащей Министерству энергетики США. Быстродействие Frontier достигает 1,194 Эфлопс. Суперкомпьютер El Capitan сможет демонстрировать производительность более 2 Эфлопс (FP64). Сборка комплекса началась в июле нынешнего года, а ввод в эксплуатацию запланирован на середину 2024-го. Стоимость проекта оценивается приблизительно в $600 млн. В основе El Capitan — платформа HPE Cray Shasta. Применена гибридная архитектура AMD с APU Instinct MI300A: изделие содержит 24 ядра с микроархитектурой Zen 4 общего назначения, блоки CDNA 3 и 128 Гбайт памяти HBM3.

Источник изображения: LLNL Отмечается, что в проекте El Capitan задействованы сотни сотрудников LLNL и отраслевых партнёров. Суперкомпьютер состоит из тысяч вычислительных узлов и требует столько же энергии, сколько город среднего размера. В течение нескольких лет специалисты готовили инфраструктуру для El Capitan, создавая подсистемы электропитания и охлаждения, устанавливая компоненты и монтируя сетевые соединения. После запуска суперкомпьютер будет использоваться для решения задач в сферах ядерной энергетики, национальной безопасности, здравоохранения, изменений климата и пр.

06.07.2023 [20:49], Владимир Мироненко

Начата сборка 2-Эфлопс суперкомпьютера El Capitan на базе серверных APU AMD Instinct MI300AЛиверморская национальная лаборатория (LLNL) объявила о получении первой партии компонентов суперкомпьютера El Capitan, которые сразу же начала устанавливать. Система будет запущена в середине 2024 года и, согласно данным LLNL, будет обеспечивать производительность более 2 Эфлопс. Стоимость El Capitan составляет около $600 млн. El Capitan будет использоваться для выполнения задач лабораторий Национальной администрации по ядерной безопасности США, чтобы они «могли поддерживать уверенность в национальных силах ядерного сдерживания», — сообщила LLNL. «На момент принятия проекта в следующем году El Capitan, вероятно, станет самым мощным суперкомпьютером в мире», — указано в заявлении LLNL. Он заменит машину Sierra на базе IBM POWER 9 и NVIDIA Volta, обойдя её производительности более чем на порядок.

Источник изображений: LLNL El Capitan базируется на платформе HPE Cray Shasta, как и две другие экзафлопсные системы, Frontier и Aurora. В отличие от этих систем, использующих традиционную конфигурацию дискретных CPU и ускорителей, El Capitan станет первым суперкомпьютером на базе гибридной архитектуры AMD. APU Instinct MI300A включает 24 ядра с микроархитектурой Zen 4 общего назначения, блоки CDNA 3 и 128 Гбайт памяти HBM3. Правда, пока не уточняется, устанавливаются ли узлы уже с финальной конфигурации «железа» или же пока что предсерийные образцы.

14.06.2023 [03:00], Игорь Осколков

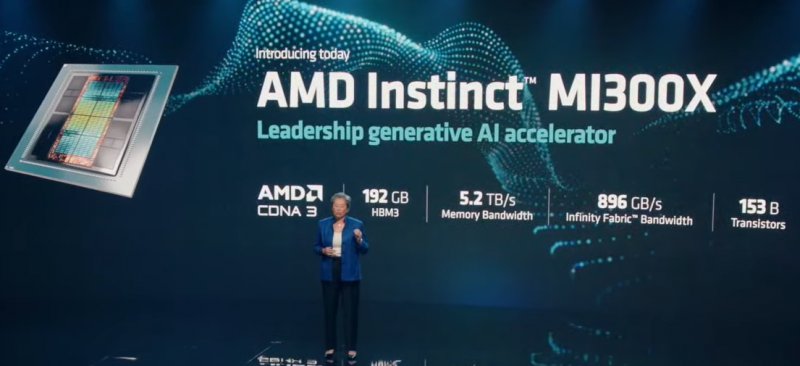

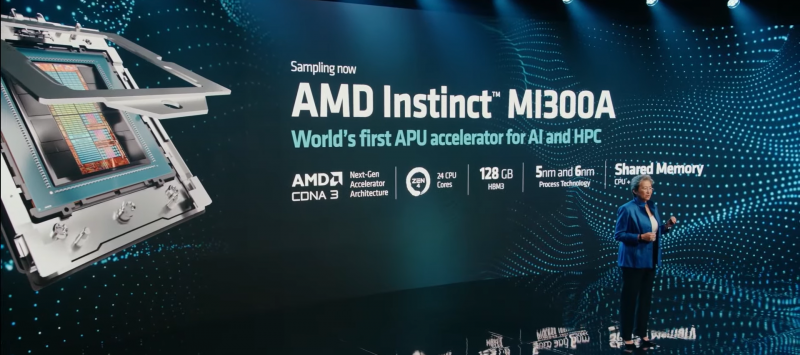

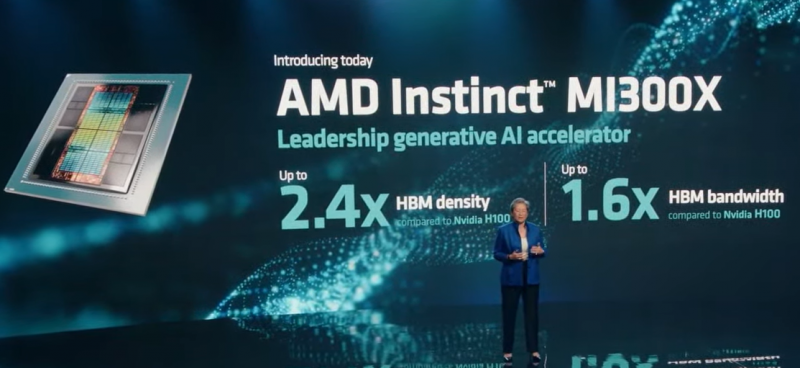

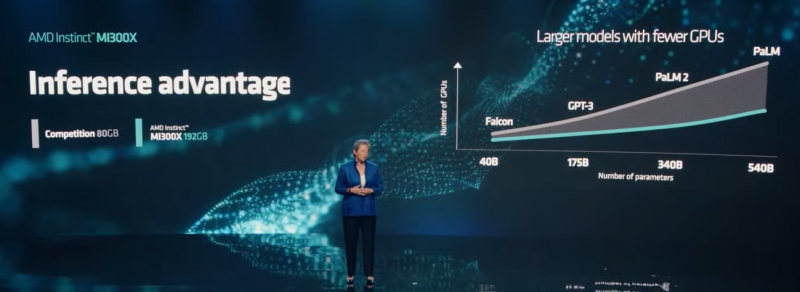

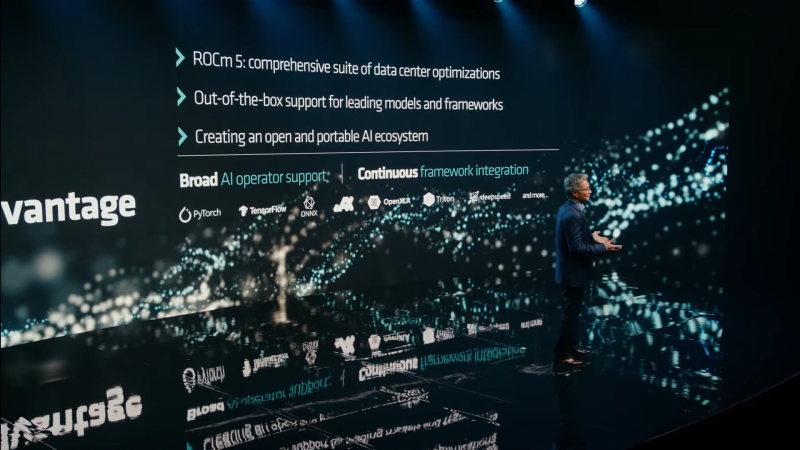

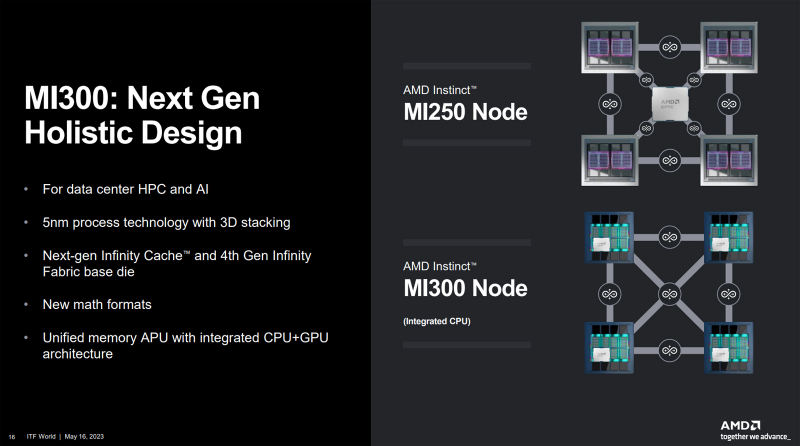

AMD представила ИИ-ускорители Instinct MI300X: 192 Гбайт HBM3 и 153 млрд транзисторовВместе с Bergamo и Genoa-X компания AMD представила и новый ИИ-ускоритель, а точнее два варианта одного и того же продукта — Instinct MI300A и MI300X. Как и в случае с EPYC, модульный подход к построению чипов позволил компании с минимумом усилий расширить портфолио. Об Instinct MI300A компания рассказывала неоднократно. Это самодостаточный APU (или XPU), объединяющий 24 ядра EPYC Genoa (три CCD), ускоритель на базе CDNA3 и 128 Гбайт общей памяти HBM3. Конкурировать он будет с решением NVIDIA Grace Hopper, которое включает 72-ядерный Arm-процессор NVIDIA Grace и ускоритель NVIDIA H100 с 96 Гбайт HBM3. Intel же из гонки гибридов временно выбыла, отказавшись в Falcon Shores от блока CPU. Правда, подход у компаний разный. NVIDIA предпочитает использовать NVLink и для объединения кристаллов внутри Grace Hopper (C2C), и для связи между узлами, что упрощает масштабирование. AMD в случае Instinct MI300 использует большую подложку-интерпозер, которая объединяет HBM-стеки (8 шт.) и блоки Zen 4/CDNA3 (4 шт.), что даёт определённую гибкость в выборе конфигурации чипа. Этим компания и воспользовалась, представив OAM-ускорители MI300X, которые напрочь лишены CPU-блоков. Весьма своевременное появление 24-Гбайт модулей HBM3 позволило поднять общий объём памяти до 192 Гбайт, а её пропускную способность (ПСП) — до 5,2 Тбайт/с. Впрочем, о характеристиках новинки AMD больше ничего и не говорит, если не считать упоминания ПСП шины Infinity Fabric (896 Гбайт/с) и количества транзисторов (153 млрд шт.). Столь большой объём памяти выгодно отличает MI300X от SXM-версии NVIDIA H100, которая может предложить только 80 Гбайт HBM3 и ПСП 3,35 Тбайт/с. Да, у NVIDIA есть «сендвич» H100 NVL, у которого имеется уже 188 Гбайт HBM3 (7,8 Тбайт/с). Но это всё же совсем иной форм-фактор, хотя, как и MI300X, ориентированный на работу с действительно большими ИИ-моделями. Больший объём набортной памяти позволяет избавиться от лишних перемещений данных между ускорителем и основной памятью системы или несколькими ускорителями. Как и полагается, AMD анонсировала Instinct Platform — плату наподобие NVIDIA HGX, которая объединяет восемь ускорителей MI300X и, по-видимому, соответствует стандарту OCP UBB, что упрощает создание узлов на её основе. Первые образцы Instinct MI300X появятся в следующем квартале, а образцы MI300A уже поставляются заказчикам. Впрочем, одним «железом» сыт не будешь — компания активно развивает программную платформу, в том числе ROCm, поскольку в области ПО для ИИ догнать, а уж тем более перегнать NVIDIA будет непросто. Это настолько важный пункт для AMD, что даже в презентации речь сначала долго шла о ПО, а уж потом были представлены новые ускорители.

24.05.2023 [14:14], Сергей Карасёв

AMD рассказала об архитектуре гигантского APU Instinct MI300: 24 ядра EPYC Genoa, ускоритель CDNA 3 и 128 Гбайт HBM3Компания AMD на суперкомпьютерной конференции ISC 2023, по сообщению ресурса Tom's Hardware, раскрыла дополнительную информацию о гибридном изделии Instinct MI300. Новый APU найдёт применение в HPC-системах, а также в высокопроизводительных серверах для дата-центров. Как говорилось ранее, MI300 — это самый крупный и сложный чип, когда-либо созданный специалистами AMD. Он содержит в общей сложности около 146 млрд транзисторов. Конструкция включает ядра CPU (Zen 4) и GPU (CDNA 3), вспомогательную логику, I/O-контроллер, а также память HBM3. В общей сложности задействованы 13 чиплетов, четыре из которых изготавливаются по 6-нм технологии, а ещё девять — по 5-нм. По сравнению с Instinct MI250 новинка получила ряд архитектурных изменений. В частности, узел с Instinct MI250 (как у Frontier) имеет отдельные блоки CPU и GPU, дополненные единственным процессором EPYC для координации рабочих нагрузок. В свою очередь, узел Instinct MI300 содержит интегрированный 24-ядерный чип EPYC Genoa, а поэтому необходимость во внешнем CPU отпадает. Вместе с тем сохранена топология, позволяющая каждому из блоков обмениваться данными со всеми другими. Причём в случае Instinct MI300 снижается задержка и повышается общая производительность. Компоненты чипа объединены посредством Infinity Fabric четвёртого поколения. В оснащение ходят 128 Гбайт общей для CPU и GPU памяти HBM3. Похожий подход реализован в чипах NVIDIA Grace Hopper, а вот Intel от гибридности в ускорителях Falcon Shores пока отказалась. |

|