Материалы по тегу: h100

|

29.09.2023 [22:57], Руслан Авдеев

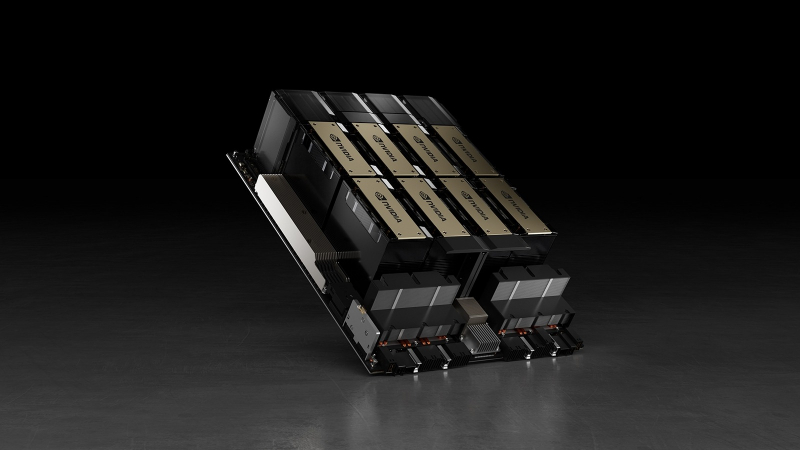

Французская iliad Group приобрела ИИ-кластер NVIDIA DGX SuperPOD из 1016 ускорителей H100 и задумала создать универсальный ИИФранцузская ГК iliad Group заявила о приобретении системы NVIDIA DGX SuperPOD для предоставления участникам европейского рынка IT «самого мощного» в регионе облачного ИИ-суперкомпьютера, включающего 1016 ускорителей H100 (127 систем DGX последнего поколения). За покупку отвечал облачный провайдер Scaleway, а сама машина разместилась в ЦОД Datacenter 5 в окрестностях Парижа. Это только первый шаг компании на пути к достижению краткосрочной цели по предоставлению новых вычислительных мощностей клиентам. Для того, чтобы удовлетворить любые запросы клиентов, Scaleway обеспечила предоставление вычислительных мощностей небольшими блоками, по паре связанных серверов DGX H100 в каждом. В ближайшие месяцы Scaleway продолжит наращивать вычислительные способности платформы. Кроме того, iliad анонсировала создание в Париже ИИ-лаборатории, в которую уже инвестировано более €100 млн. Её главой стал миллиардер Ксавье Ниль (Xavier Niel), фактически контролирующий iliad Group. Лаборатория, как сообщается, привлекла известных исследователей из крупнейших международных компаний. Основной целью лаборатории станет помощь в создании универсального ИИ, а результаты исследований в этом направлении будут доступны публично.

28.09.2023 [02:09], Владимир Мироненко

Oracle запустила bare-metal инстансы с NVIDIA H100Несмотря на нехватку на рынке ускорителей NVIDIA H100 ещё один провайдер представил продукты на их основе. Облачная служба Oracle Cloud Infrastructure (OCI) объявила о доступности bare-metal инстансов OCI Compute на базе NVIDIA H100, предназначенных для крупномасштабных приложений искусственного интеллекта (ИИ) и высокопроизводительных вычислений (HPC). Инстанс OCI Compute BM.GPU.H100.8 содержит восемь ускорителей H100, каждый из которых имеет 80 Гбайт памяти HBM2, 16 локальных накопителей NVMe ёмкостью 3,84 Тбайт каждый, два 56-ядерных процессора Intel Xeon Sapphire Rapids (2,0/3,8 ГГц), 2 Тбайт памяти DDR5, а также восемь 400G-адаптеров. Также в этом году компании смогут воспользоваться OCI Supercluster для создания кластеров, включающих до 50 тыс. ускорителей H100. Эта опция поначалу будет доступна в регионах Лондона и Чикаго, а в будущем число регионов с её поддержкой будет увеличено. При этом в OCI доступен и сервис NVIDIA DGX Cloud, который также включает кластеры на базе H100.

Изображение: Oracle Oracle также сообщила, что в начале 2024 года представит инстансы с новейшими ускорителями NVIDIA L40S. Например, инстанс BM.L40S.4 предложит четыре L40S с двумя 56-ядерными процессорами Intel Xeon, 1 Тбайт RAM, 15,36 Тбайт NVMe-хранилища и сетевое подключение 400 Гбит/с.

22.09.2023 [12:29], Сергей Карасёв

Цукерберг создаст суперкомпьютер для биомедицинских исследований на ускорителях NVIDIA H100«Инициатива Чан Цукерберг» (CZI), благотворительная организация основателя Facebook✴ Марка Цукерберга (Mark Zuckerberg), намерена создать высокопроизводительный вычислительный кластер с ускорителями NVIDIA. Об этом сообщает ресурс Datacenter Dynamics. Говорится, что в основу платформы лягут более тысячи изделий NVIDIA H100. Кластер планируется использовать для биомедицинских исследований с применением средств ИИ. Суперкомпьютер будет использоваться для разработки открытых моделей человеческих клеток. При этом планируется применять прогностические методы, обученные на больших наборах данных, таких как те, которые интегрированы в программный инструмент Chan Zuckerberg CELL by GENE (CZ CELLxGENE). Модели также будут обучаться на данных, полученных исследовательскими институтами CZ Science, таких как атлас расположения и взаимодействия белков OpenCell и клеточный атлас Tabula Sapiens, созданный Биоцентром Чана Цукерберга в Сан-Франциско (Biohub San Francisco).

Источник изображения: pixabay.com Разработка цифровых моделей, способных предсказывать поведение различных типов клеток, поможет исследователям лучше понять здоровое состояние организма и изменения, происходящие при различных заболеваниях.

17.09.2023 [19:04], Сергей Карасёв

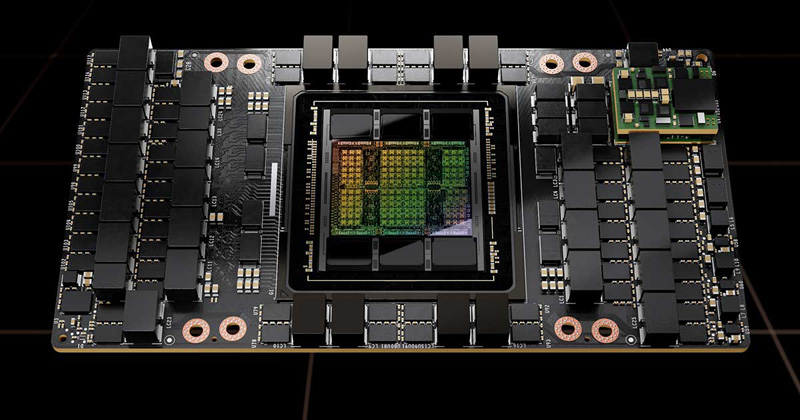

NVIDIA за квартал отгрузила 900 тонн ускорителей H100Во II четверти 2024 финансового года, которая была закрыта 30 июля, компания NVIDIA реализовала продукцию для дата-центров на сумму около $10,32 млрд — это на 171 % больше результата за предыдущий год. Аналитики Omdia, как сообщает ресурс Tom's Hardware, подсчитали, что за эти три месяца NVIDIA отгрузила свыше 300 тыс. флагманских ускорителей H100. Изделия H100 на архитектуре Hopper предназначены для ресурсоёмких приложений ИИ, а также задач НРС. Однако из-за стремительного развития платформ генеративного ИИ такие ускорители оказались в дефиците: выполнение новых заказов откладывается до 2024 года.

Источник изображения: NVIDIA По оценкам Omdia, во II квартале NVIDIA поставила более 900 тонн ускорителей H100. В своих расчётах аналитики полагают, что вес одного устройства с радиатором охлаждения превышает 3 кг. Таким образом, получается, что в течение рассматриваемого периода компания реализовала более 300 тыс. изделий. Ускорители H100 предлагаются в нескольких вариантах исполнения — в виде карты расширения PCIe и в формате модуля SXM. При этом масса (с учётом радиатора) различается: так, например, для карты она указана на отметке 1,2 кг. В случае SXM-изделий показатель не приводится, но, как отмечает Tom's Hardware, он не превышает 2 кг. Если предположить, что 80 % поставок H100 составляют модули, а 20 % — карты, то средний вес одного ускорителя должен составить около 1,84 кг. Omdia заявляет, что оценила общую массу в 900 тонн на основе количества H100, которые, по её мнению, NVIDIA поставила во II квартале. Таким образом, как отмечается, фактически суммарный вес может оказаться меньше, но речь всё равно идёт о сотнях тонн. Omdia прогнозирует, что до конца 2023 года темпы отгрузок Н100 сохранятся. Иными словами, NVIDIA сможет за год поставить около 1,2 млн таких ускорителей, а их суммарный вес достигнет 3600 тонн.

11.09.2023 [19:00], Сергей Карасёв

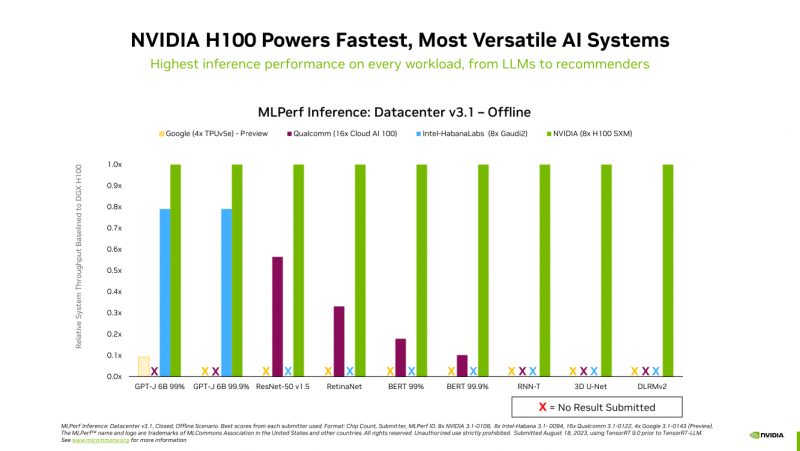

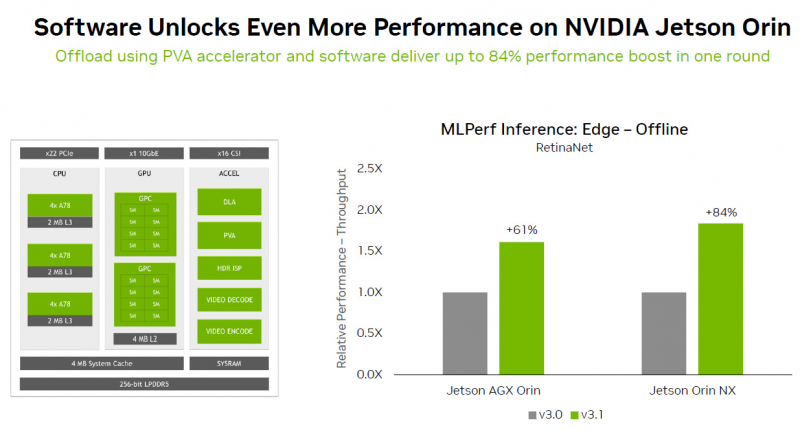

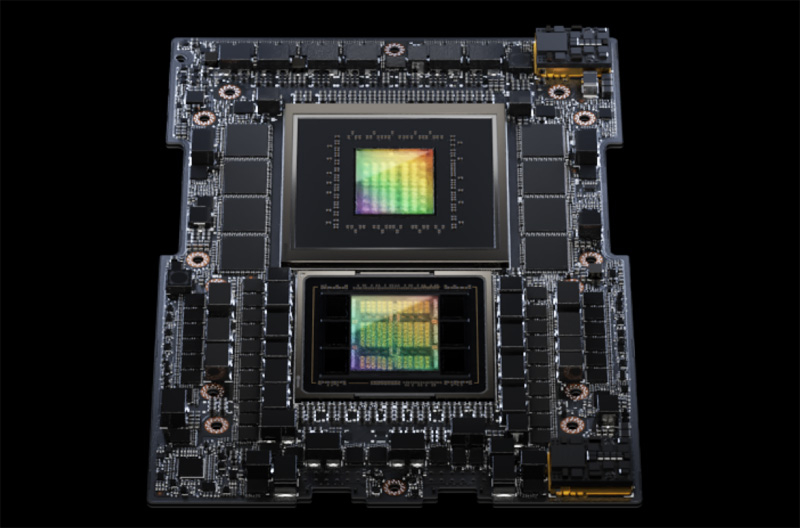

Много памяти, быстрая шина и правильное питание: гибридный суперчип GH200 Grace Hopper обогнал H100 в ИИ-бенчмарке MLPerf InferenceКомпания NVIDIA сообщила о том, что суперчип NVIDIA GH200 Grace Hopper и ускоритель H100 лидируют во всех тестах производительности ЦОД в бенчмарке MLPerf Inference v3.1 для генеративного ИИ, который включает инференс-задачи в области компьютерного зрения, распознавания речи, обработки медицинских изображений, а также работу с большими языковыми моделями (LLM). Ранее NVIDIA уже объявляла о рекордах H100 в новом бенчмарке MLPerf. Теперь говорится, что суперчип GH200 Grace Hopper впервые прошёл все тесты MLPerf. Вместе с тем системы, оснащенные восемью ускорителями H100, обеспечили самую высокую пропускную способность в каждом тесте MLPerf Inference. Решения NVIDIA прошли обновленное тестирование в области рекомендательных систем (DLRM-DCNv2), а также выполнили первый эталонный тест GPT-J — LLM с 6 млрд параметров. Примечательно, что GH200 оказался до 17 % быстрее H100, хотя чип самого ускорителя в обоих продуктах один и тот же. NVIDIA объясняет это несколько факторами. Во-первых, у GH200 больше набортной памяти — 96 Гбайт против 80 Гбайт. Во-вторых, ПСП составляет 4 Тбайт/с, а сам чип является гибридным, так что для передачи данных между LPDDR5x и HBM3 не используется PCIe. В-третьих, GH200 при низкой нагрузке на CPU умеет отдавать часть энергии ускорителю, оставаясь в заданных рамках энергопотребления. Правда, в тестах GH200 работал на полную мощность, т.е. с TDP на уровне 1 кВт (UPD: NVIDIA уточнила, что реально потребление GH200 под полной нагрузкой составляет 750–800 Вт).

Источник изображений: NVIDIA Отдельно внимание уделено оптимизации ПО — на днях NVIDIA анонсировала открый программный инструмент TensorRT-LLM, предназначенный для ускорения исполнения LLM на продуках NVIDIA. Этот софт даёт возможность вдвое увеличить производительность ускорителя H100 в тесте GPT-J 6B (входит в состав MLPerf Inference v3.1). NVIDIA отмечает, что улучшение ПО позволяет клиентам с течением времени повышать производительность ИИ-систем без дополнительных затрат. Также отмечается, что модули NVIDIA Jetson Orin благодаря новому ПО показали прирост производительности до 84 % на задачах обнаружения объектов по сравнению с предыдущим раундом тестирования MLPerf. Ускорение произошло благодаря задействованию Programmable Vision Accelerator (PVA), отдельного движка для обработки изображений и алгоритмов компьютерного зрения работающего независимо от CPU и GPU. Сообщается также, что ускоритель NVIDIA L4 в последних тестах MLPerf выполнил весь спектр рабочих нагрузок, показав отличную производительность. Так, в составе адаптера с энергопотреблением 72 Вт этот ускоритель демонстрирует в шесть раз более высокое быстродействие, нежели CPU, у которых показатель TDP почти в пять раз больше. Кроме того, NVIDIA применила новую технологию сжатия модели, что позволило продемонстрировать повышение производительности в 4,4 раза при использовании BERT LLM на ускорителе L4. Ожидается, что этот метод найдёт применение во всех рабочих нагрузках ИИ. В число партнёров при проведении тестирования MLPerf вошли поставщики облачных услуг Microsoft Azure и Oracle Cloud Infrastructure, а также ASUS, Connect Tech, Dell Technologies, Fujitsu, Gigabyte, Hewlett Packard Enterprise, Lenovo, QCT и Supermicro. В целом, MLPerf поддерживается более чем 70 компаниями и организациями, включая Alibaba, Arm, Cisco, Google, Гарвардский университет, Intel, Meta✴, Microsoft и Университет Торонто.

30.08.2023 [17:09], Владимир Мироненко

Google объявила о скорой доступности инстансов A3 на базе NVIDIA H100Google Cloud сообщила, что в следующем месяце станут доступны инстансы Google Compute Engine A3 на базе платформы NVIDIA HGX H100 с восемью ускорителями H100, двумя процессорами Intel Xeon Sapphire Rapids, 2 Тбайт, а также интерконнектом NVLink и адаптерами Google Titanium. Платформ обеспечивает высокую производительность для всех видов ИИ-приложений, в том числе для обучения и обслуживания особенно требовательных рабочих нагрузок ИИ и больших языковых моделей (LLM). В блоге Google Cloud отмечено, что сочетание ускорителей NVIDIA с ведущими инфраструктурными технологиями Google Cloud обеспечивает масштабируемость и производительность и является огромным шагом вперёд в возможностях ИИ: обучение происходит в 3 раза быстрее, а пропускная способность сети в 10 раз выше, чем у предыдущего поколения. Инстансы A3 также поддерживают масштабирование до 26 тыс. ускорителей H100.

Изображение: NVIDIA Незадолго до этого Google Cloud объявила NVIDIA партнёром года по генеративному ИИ (Generative AI Partner of the Year). Компании сотрудничают по разным направлениям: от проектирования инфраструктуры до реализации программного обеспечения, чтобы упростить создание и развёртывание приложений ИИ на платформе Google Cloud. PaxML, платформа Google для создания больших языковых моделей, теперь оптимизирована для решений NVIDIA и доступна в реестре NVIDIA NGC. Google использовала PaxML для создания внутренних моделей, включая DeepMind, а также исследовательских проектов. Кроме того, компании сервис Google Dataproc позволяет задействовать решения NVIDIA для ускорения работы Apache Spark. H100 вскоре также появятся на платформе Vertex AI. Наконец, было обещано, что в облаке Google появятся NVIDIA DGX Cloud и новейшие гибридные чипы GH200. Впрочем, вместе с анонсом A3 Google представила ИИ-инстансы на базе собственных ускорителей TPU v5e.

29.08.2023 [17:50], Сергей Карасёв

10 тыс. ускорителей NVIDIA H100: Tesla запустила один из мощнеших ИИ-суперкомпьютеров в миреКомпания Tesla, по сообщению Tom's Hardware, в минувший понедельник, 28 августа 2023 года, запустила вычислительный кластер для решения ресурсоемких задач, связанных с ИИ. В основу платформы положены 10 тыс. ускорителей NVIDIA H100. Отмечается, что система обеспечивает пиковую производительность в 340 Пфлопс FP64 для технических вычислений и 39,58 Эфлопс INT8 для приложений ИИ. Таким образом, по производительности FP64 кластер превосходит суперкомпьютер Leonardo, который располагается на четвёртой позиции в нынешнем рейтинге Тор500 с показателем 304 Пфлопс. Фактически кластер Tesla на базе NVIDIA H100 является одной из самых мощных платформ в мире. Он подходит не только для обработки алгоритмов ИИ, но и для НРС-задач. Благодаря данной системе Tesla значительно расширит свои ресурсы для создания полноценного автопилота. А это поможет компании Илона Маска получить конкурентные преимущества перед другими разработчиками умных транспортных средств. На формирование кластера потрачено около $300 млн. Однако на рынке сформировался дефицит ускорителем NVIDIA H100. На этом фоне Tesla создаёт ИИ-суперкомпьютер Dojo, в основу которого лягут специализированные чипы собственной разработки — Tesla D1. К концу следующего года, по словам Илона Маска, производительность ИИ-систем Tesla может быть доведена до 100 Эфлопс. Стоимость проекта оценивается в $1 млрд. На обучение ИИ-моделей Tesla намерена потратить более $2 млрд в текущем году и примерно такую же сумму в 2024-м.

14.08.2023 [21:37], Сергей Карасёв

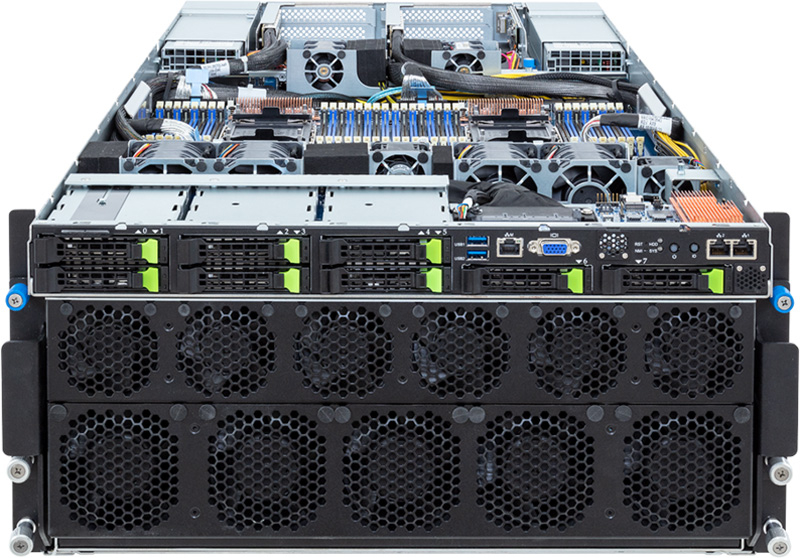

С СЖО и без: Giga Computing (Gigabyte) выпустила новые серверы на базе Xeon Sapphire Rapids и NVIDIA HGX H100Компания Giga Computing (Gigabyte), серверное подразделение Gigabyte, анонсировала стоечные серверы G363-SR0 и G593-SD2, выполненные в форм-факторе 3U и 5U соответственно. В основу положены процессоры Intel Xeon Sapphire Rapids и платформа NVIDIA HGX H100. Обе новинки допускают установку двух процессоров в исполнении LGA 4677 (Socket E) с показателем TDP до 350 Вт. Диапазон рабочих температур — от 0 до +35 °C. Модель G363-SR0 оснащена системой прямого жидкостного охлаждения (DLC). Доступны 16 слотов для модулей оперативной памяти DDR5-4800 ёмкостью до 256 Гбайт каждый. Могут быть подключены восемь SFF-накопителей NVMe/SATA/SAS с возможностью горячей замены. Поддерживаются массивы SATA RAID 0/1/10/5. В оснащение входят по два сетевых порта 1GbE и 10GbE, выделенный порт управления 1GbE, два порта USB 3.2 Gen1 и интерфейс Mini-DP. За возможности расширения отвечают шесть слотов PCIe 5.0 x16 (два спереди, четыре сзади), коннекторы OCP 3.0 и М.2 (PCIe 4.0 x4). Задействованы четыре ускорителя NVIDIA H100 (SXM5). Установлены три блока питания мощностью 3000 Вт с сертификатом 80 PLUS Titanium.

Источник изображений: Giga Computing Сервер G593-SD2, ориентированный на задачи ИИ и НРС, располагает 32 слотами для модулей DDR5-4800 и восемью ускорителями NVIDIA H100 (SXM5). Спереди есть восемь отсеков для SFF-накопителей NVMe/SATA/SAS. Данная модель использует воздушное охлаждение и шесть блоков питания мощностью 3000 Вт с сертификатом 80 PLUS Titanium. Предусмотрены 12 слотов PCIe 5.0 x16, два сетевых порта 10GbE, выделенный порт управления 1GbE, два порта USB 3.2 Gen1 и интерфейс D-Sub.

13.08.2023 [16:46], Руслан Авдеев

Придётся подождать: новые заказы на поставку NVIDIA H100 будут выполнены не раньше 2024 годаЕщё в прошлом месяце контрактный производитель полупроводников TSMC заявил о том, что спрос на чипы упал во всех сегментах рынка, за одним исключением — чипы для ИИ по-прежнему пользуются высоким спросом. Как сообщает Barron’s, в первую очередь речь идёт о чипах NVIDIA, доминирующих на рынке соответствующих решений. Растущий спрос на генеративные ИИ-системы привёл к тому, что ускорители H100 стали самым ценным ресурсом. Как заявляют в Amazon Web Services (AWS), спрос на них устойчиво превышает предложение. Своей точкой зрения на проблему поделился и технический директор облачного ИИ-провайдера CoreWeave Брайан Вентуро (Brian Venturo). Компания одной из первых начала предлагать доступ к H100 и имеет тесные связи с NVIDIA — последняя инвестировала в стартап не менее $100 млн. По словам Вентуро, если в I квартале 2023 года можно было довольно легко получить новые ускорители, то уже в апреле ситуация кардинально изменилась буквально за неделю — сроки выполнения заказов стали переноситься на конец года. H100 потребовались облачным провайдерам, крупным корпорациям и лабораториям, занимающимся ИИ-решениями. Сейчас H100 практически невозможно приобрести. Желающие сделать заказ сегодня могут рассчитывать на поставки в I или II квартале 2024 года. CoreWeave уже оформляет заказы, которые NVIDIA должна выполнить во II и III кварталах 2024 года.

Источник изображения: NVIDIA При этом решения других компаний, включая AMD, по данным CoreWeave, не пользуются таким спросом. Продукты NVIDIA не просто имеют лучшую аппаратную составляющую, но и развитое и повсеместно распространённое ПО — у стартапов просто нет времени для внедрения решений AMD или Google TPU. NVIDIA годами инвестировала в программную платформу CUDA и теперь, как считает Вентуро, на 10 лет опережает конкурентов. В кратко- и среднесрочной перспективе CoreWeave не видит появления значимых конкурентов NVIDIA. Так, TPU или AWS Trainium являются весьма специфическими решениями, не подходящими для обычных стартапов, которым требуются быстрые результаты. В этом в CoreWeave видят преимущество для своего бизнеса — компания не только имеет довольно стабильный доступ к ускорителям NVIDIA, но и готова предложить соответствующую вычислительную инфраструктуру малым игрокам. Сама CoreVeawe активно приобретает всё больше продуктов NVIDIA, привлекая в долг средства для покупки чипов под залог уже имеющихся ускорителей. Как сообщалось в июле, в Техасе компания намерена потратить $1,6 млрд на создание дата-центра для своего ИИ-супероблака. Тем временем NVIDIA инвестирует не только в CoreVeawe — она поддержала конкурента компании, вложив средства в развитие ИИ-стартапа Lambda Labs.

08.08.2023 [15:10], Сергей Карасёв

В Microsoft Azure стали доступны инстансы ND H100 v5 для ИИ-нагрузокКорпорация Microsoft открыла доступ к инстансам ND H100 v5 в облаке Azure. Эти масштабируемые виртуальные машины предназначены для решения сложных задач, связанных с ИИ и большими языковыми моделями. В основу ND H100 v5 положены NVIDIA H100: восемь таких ускорителей объединены посредством NVSwitch и NVLink 4.0. Возможно масштабирование до тысяч ускорителей при помощи сети на базе NVIDIA Quantum-2 InfiniBand с пропускной способностью до 400 Гбит/с в расчёте на ускоритель (до 3,2 Тбит/с на виртуальную машину). В составе ND H100 v5 применяются процессоры Intel Xeon Sapphire Rapids, обеспечивающие поддержку PCIe 5.0 и DDR5-4800.

Источник изображения: Microsoft Отмечается, что инстансы ND H100 v5 являются одними из самых мощных вычислительных решений, которые Microsoft предлагала до сих пор. Они доступны в регионах Azure на востоке и западе США. Заказы на ND H100 v5 принимаются уже сейчас, а к началу 2024 года Microsoft обещает сделать доступными для клиентов «сотни тысяч» ускорителей NVIDIA H100. |

|