Материалы по тегу: ускоритель

|

28.02.2024 [15:54], Руслан Авдеев

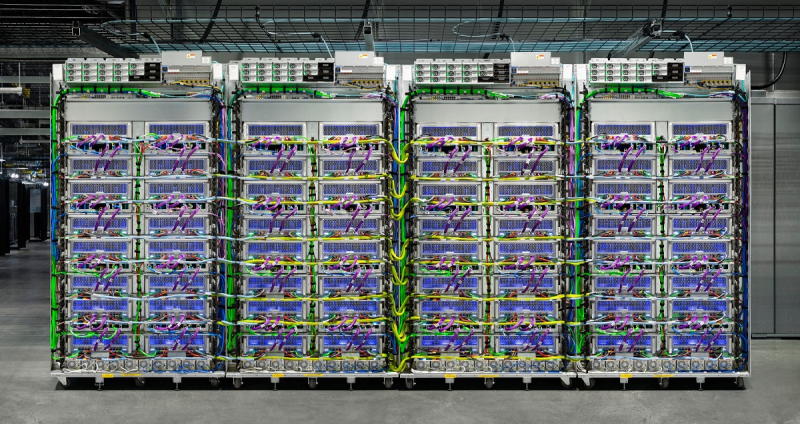

Доступность ускорителей NVIDIA H100 повысилась, что привело к появлению вторичного рынкаСроки поставок ускорителей NVIDIA H100 значительно сократилось, с 8–11 мес. до всего 3-4. По данным Tom’s Hardware, в результате многие компании, ранее сделавшие огромные запасы, пытаются продать излишки. Кроме того, стало намного легче арендовать ускорители в облаках Amazon, Google и Microsoft. Впрочем, разработчики ИИ-моделей до сих пор испытывают проблемы с доступом к ресурсам ускорителей, поскольку спрос превышает предложение. Как сообщают СМИ, некоторые компании пытаются перепродать доставшиеся им H100, а другие стали заказывать меньше в связи с высокой стоимостью обслуживания складских запасов и окончанием паники на рынке. В прошлом году приобрести подобные ускорители было чрезвычайно сложно. Отчасти улучшение ситуации на рынке связано с тем, что провайдеры облачных сервисов вроде Amazon (AWS) и других крупных игроков упростили аренду H100. Несмотря на то, что доступ к H100 упростился, желающим обучать LLM добраться до ресурсов по-прежнему непросто, во многом потому, что им требуются ускорители в невероятных количествах, в некоторых случаях речь идёт о сотнях тысяч экземпляров, поэтому цены на них до сих пор не упали, а NVIDIA продолжает получать сверхприбыли. При этом рост доступности привёл к тому, что компании всё чаще пытаются сэкономить, ведут себя более избирательно при выборе предложений продажи или аренды, стараются приобрести более мелкие кластеры и внимательнее оценивают их экономическую целесообразность для бизнеса. Кроме того, альтернативные решения становятся все более распространёнными и всё лучше поддерживаются ПО. Это ведёт к формированию сбалансированной ситуации на рынке. Так или иначе, спрос на ИИ-чипы по-прежнему высок, а с учётом того, что LLM становятся всё масштабнее, требуется больше вычислительных мощностей. Поэтому крупные игроки, которые зависят от поставок решений NVIDIA, занялись созданием собственных ускорителей. Среди них Microsoft, Meta✴ и OpenAI.

28.02.2024 [15:31], Сергей Карасёв

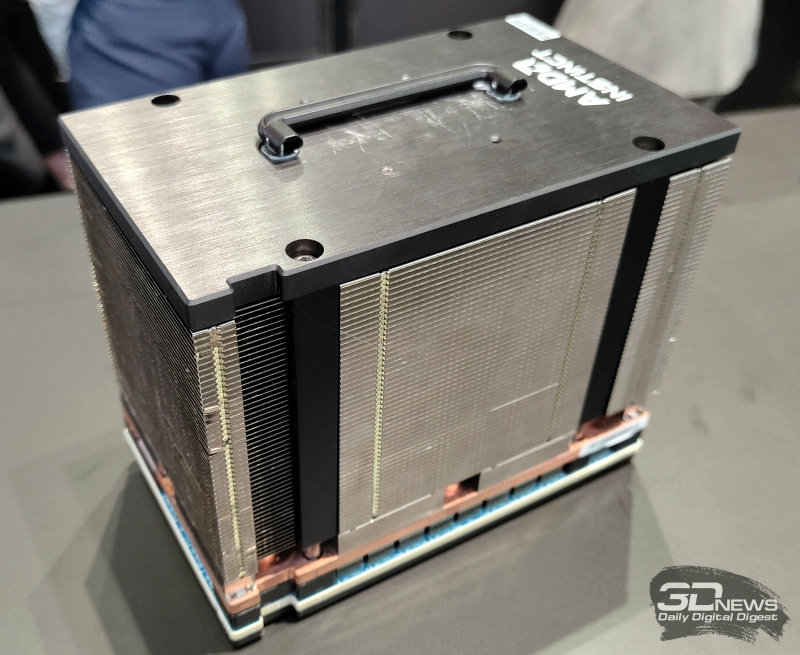

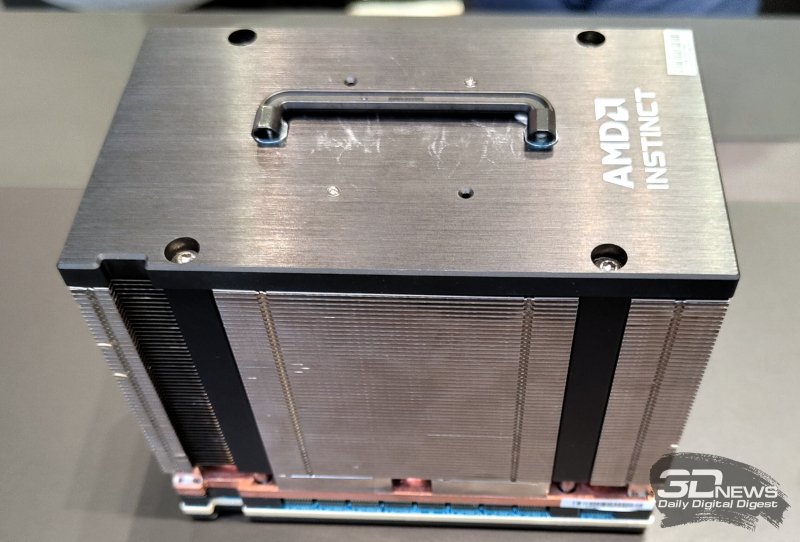

На MWC 2024 замечен первый образец ускорителя AMD Instinct MI300X с 12-слойной памятью HBM3EКомпания AMD готовит новые модификации ускорителей семейства Instinct MI300, которые ориентированы на обработку ресурсоёмких ИИ-приложений. Изделия будут оснащены высокопроизводительной памятью HBM3E. Работу над ними подтвердил технический директор AMD Марк Пейпермастер (Mark Papermaster), а уже на этой неделе на стенде компании на выставке MWC 2024 был замечен образец обновлённого ускорителя. На сегодняшний день в семейство Instinct MI300 входят модификации MI300A и MI300X. Первая располагает 228 вычислительными блоками CDNA3 и 24 ядрами Zen4 на архитектуре x86. В оснащение входят 128 Гбайт памяти HBM3. На более интенсивные вычисления ориентирован ускоритель MI300X, оборудованный 304 блоками CDNA3 и 192 Гбайт HBM3. Но у этого решения нет ядер Zen4. Недавно компания Micron сообщила о начале массового производства 8-слойной памяти HBM3E ёмкостью 24 Гбайт с пропускной способностью более 1200 Гбайт/с. Эти чипы будут применяться в ИИ-ускорителях NVIDIA H200, которые выйдут на коммерческий рынок во II квартале нынешнего года. А Samsung готовится к поставкам 12-слойных чипов HBM3E на 36 Гбайт со скоростью передачи данных до 1280 Гбайт/с. AMD подтвердила намерение применять память HBM3E в обновлённых ускорителях Instinct MI300, но в подробности вдаваться не стала. В случае использования 12-слойных чипов HBM3E ёмкостью 36 Гбайт связка из восьми модулей обеспечит до 288 Гбайт памяти с высокой пропускной способностью. Наклейка на демо-образце недвусмысленно указывает на использование именно 12-слойной памяти. Впрочем, это может быть действительно всего лишь стикер, поскольку представитель AMD уклонился от прямого ответа на вопрос о спецификациях представленного изделия. Ожидается также, что в 2025 году AMD выпустит ИИ-ускорители следующего поколения серии Instinct MI400. Между тем NVIDIA готовит ускорители семейства Blackwell для ИИ-задач: эти изделия, по заявлениям самой компании, сразу после выхода на рынок окажутся в дефиците.

26.02.2024 [23:34], Владимир Мироненко

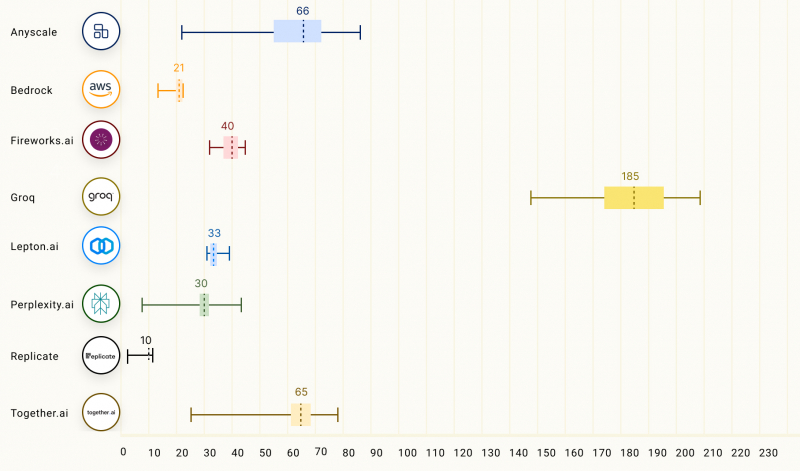

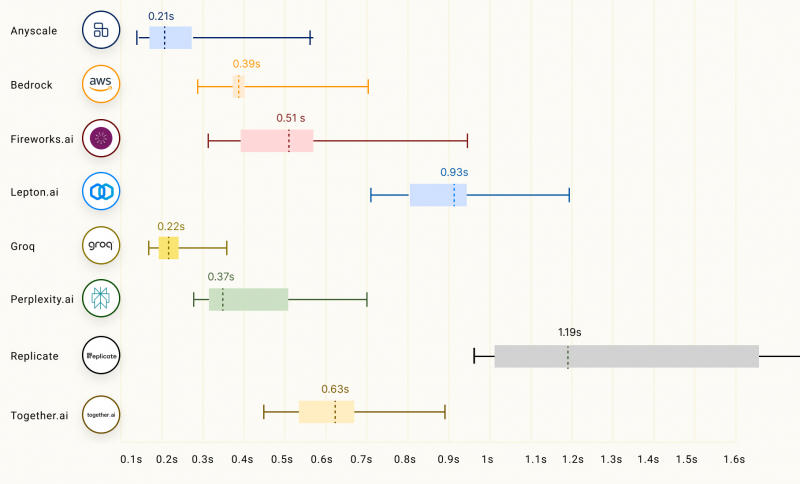

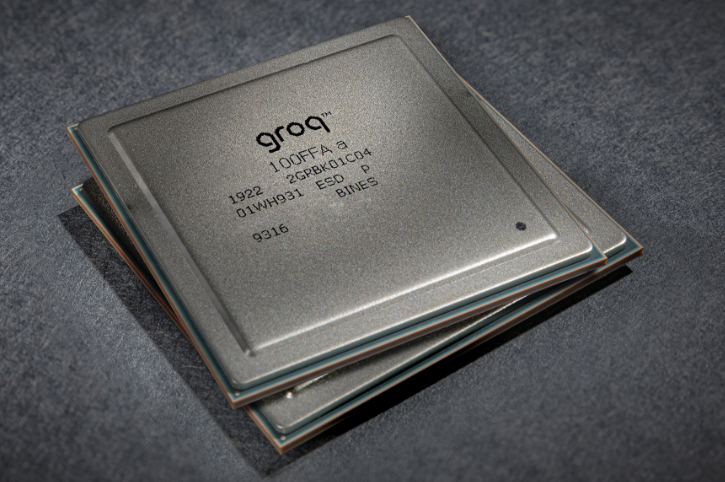

Groq LPU способен успешно конкурировать с ускорителями NVIDIA, AMD и IntelСтартап Groq сообщил о значительных достижениях в области инференса с использованием ускорителя LPU, разработанного для запуска больших языковых моделей (LLM), таких как GPT, Llama и Mistral. Groq LPU имеет один массивно-параллельный тензорный процессор TSP, который обеспечивает производительность до 750 TOPS INT8 и до 188 Тфлопс FP16. LPU Groq оснащён локальной SRAM объемом 230 Мбайт с пропускной способностью 80 Тбайт/с. Как сообщает компания, при запуске модели Mixtral 8x7B ускоритель LPU обеспечил скорость инференса 480 токенов в секунду, что является одним из ведущих показателей инференса в отрасли. В таких моделях, как Llama 2 70B с длиной контекста 4096 токенов, Groq может обеспечить скорость инференса 300 токенов/с, тогда как в меньшей модели Llama 2 7B с 2048 токенами контекста скорость инференса составляет 750 токенов/с.

Изображение: Groq Согласно рейтингу бенчмарка LLMPerf, LPU Groq превосходит результаты систем облачных провайдеров на базе традиционных ИИ-ускорителей в деле запуска LLM Llama в конфигурациях от 7 до 70 млрд параметров. Groq лидирует по скорости инференса и занимает второе место по показателю задержки. Для сравнения, бесплатный чат-бот ChatGPT на базе GPT-3.5 обеспечивает обработку около 40 токенов/с. Текущие LLM с открытым исходным кодом, такие как Mixtral 8x7B, могут превосходить GPT 3.5 в большинстве тестов, и теперь могут работать со скоростью почти 500 токенов/с. Опубликованные данные наглядно подтверждают, что предлагаемый Groq ускоритель LPU Groq значительно превосходит системы для инференса, предлагаемые NVIDIA, AMD и Intel, говорит компания. Groq не раскрывает имена своих заказчиков, но в настоящее время её ИИ-решения используются, например, Аргоннской национальной лабораторией Министерства энергетики США.

24.02.2024 [19:46], Сергей Карасёв

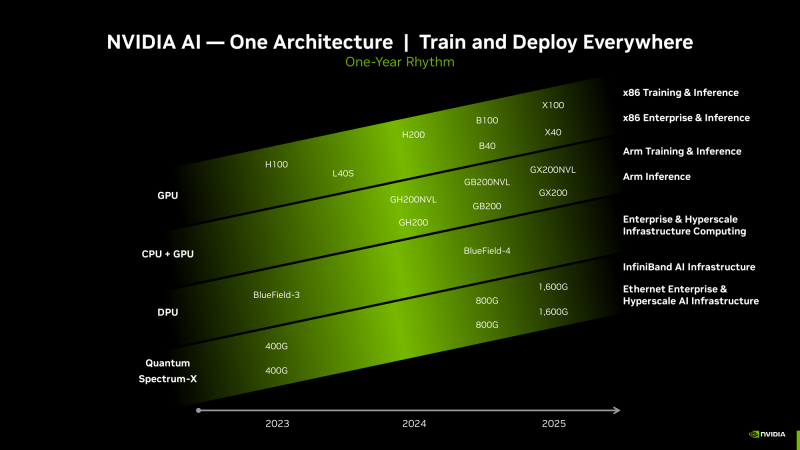

ИИ-ускорители NVIDIA Blackwell сразу будут в дефицитеКомпания NVIDIA, по сообщению ресурса Seeking Alpha, прогнозирует высокий спрос на ИИ-ускорители следующего поколения Blackwell. Поэтому сразу после выхода на рынок эти изделия окажутся в дефиците, и их поставки будут ограничены. «На все новые продукты спрос превышает предложение — такова их природа. Но мы работаем так быстро, как только можем, чтобы удовлетворить потребности заказчиков», — говорит глава NVIDIA Дженсен Хуанг (Jensen Huang). Из-за стремительного развития генеративного ИИ на рынке сформировалась нехватка нынешних ускорителей NVIDIA H100 поколения Hopper. Срок выполнения заказов на серверы с этими изделиями достигает 52 недель. Аналогичная ситуация, вероятно, сложится и с ускорителями Blackwell, анонс которых ожидается в течение нынешнего года. «Полагаем, что отгрузки наших продуктов следующего поколения будут ограниченными, поскольку спрос намного превышает предложение», — сказала Колетт Кресс (Colette Kress), финансовый директор NVIDIA. Главный вопрос заключается в том, насколько быстро NVIDIA сможет организовать массовое производство Blackwell B100, а также серверов DGX на их основе. Дело в том, что это совершенно новые продукты, в которых используются другие компоненты. По имеющейся информации, Blackwell станет первой архитектурой NVIDIA, предусматривающей чиплетную компоновку. Это может упростить производство ускорителей на уровне кремния, но в то же время усложнит процесс упаковки. В дополнение к флагманскому чипу B100 для ИИ и HPC-задач компания готовит решение B40 для корпоративных заказчиков, гибридный ускоритель GB200, сочетающий ускоритель B100 и Arm-процессор Grace, а также GB200 NVL для обработки больших языковых моделей.

23.02.2024 [19:06], Сергей Карасёв

Meta✴ ищет в Индии и США специалистов для разработки ИИ-ускорителей и SoC для дата-центровКомпания Meta✴, по сообщению The Register, опубликовала множество объявлений о поиске специалистов для разработки интегральных схем специального назначения (ASIC). Речь идёт о создании собственных ускорителей для машинного обучения и ИИ, а также SoC для дата-центров. Сейчас для ИИ-задач Meta✴ массово применяет решения NVIDIA. Кроме того, компания присматривается к ускорителям AMD Instinct MI300. С целью снижения зависимости от сторонних поставщиков и сокращения расходов Meta✴ также проектирует собственные аппаратные компоненты. В частности, весной прошлого года Meta✴ анонсировала свой первый кастомизированный процессор, разработанный специально для ИИ-нагрузок. Изделие под названием MTIA v1 (Meta✴ Training and Inference Accelerator) представляет собой ASIC в виде набора блоков, функционирующих параллельно. Задействованы 64 вычислительных элемента в виде матрицы 8 × 8, каждый из которых объединяет два ядра RISC-V. Кроме того, компания создала чип MSVP (Meta✴ Scalable Video Processor) для обработки видеоматериалов. В разработке также находятся собственные ИИ-ускорители Artemis.

Источник изображения: Meta✴ Как теперь сообщается, Meta✴ ищет ASIC-инженеров с опытом работы в области архитектуры, дизайна и тестирования. Необходимы специалисты в Бангалоре (Индия) и Саннивейле (Калифорния, США). В некоторых вакансиях работодателем указана собственно Мета✴, тогда как в других случаях указан Facebook✴. От кандидатов в числе прочего требуется «глубокий опыт в одной или нескольких ключевых сферах, связанных с созданием сложных SoC для дата-центров». Тестировщикам необходимо иметь опыт проверки проектов для ЦОД, связанных с машинным обучением, сетевыми технологиями и пр. Некоторые вакансии были впервые опубликованы в соцсети LinkedIn в конце декабря 2023 года и обновлены в феврале нынешнего года. Претендентам обещаны неплохие зарплаты. Для каких именно задач компании Meta✴ требуются аппаратные решения, не уточняется. Но сетевые источники отмечают, что это может быть инференс, создание новых ИИ-платформ и т.п.

04.02.2024 [21:02], Сергей Карасёв

Meta✴ намерена активно внедрять собственные ИИ-ускорители Artemis в качестве альтернативы решениям NVIDIA и AMDВ 2024 году компания Meta✴, по сообщению The Register, после многих лет разработки может начать массовое внедрение собственных ИИ-чипов. Они станут альтернативой ускорителям NVIDIA и AMD, что поможет снизить зависимость от продукции сторонних поставщиков. В 2024 году компания намерена потратить до $37 млрд на развитие своей инфраструктуры. В настоящее время для поддержания ИИ-нагрузок Meta✴ применяет такие решения, как NVIDIA H100. Ожидается, что к концу 2024 года компания будет иметь в своём распоряжении 350 тыс. этих ускорителей. Вместе с тем Meta✴ проявляет интерес и к изделиям AMD Instinct MI300. Ранее компания высоко оценила возможности Qualcomm Cloud AI 100, но отказалась от них из-за несовершенства ПО. Не приглянулись Meta✴ и чипы Esperanto. Сейчас Meta✴ ведёт разработку собственных ИИ-ускорителей.

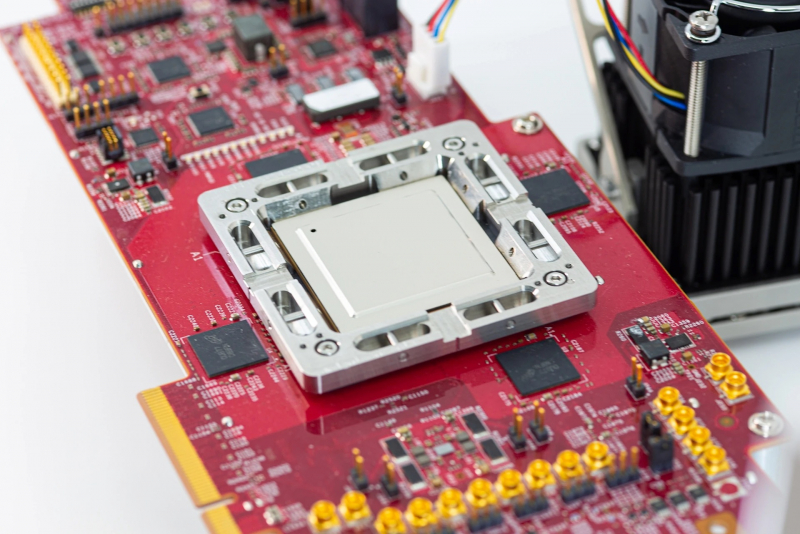

Источник изображения: Meta✴ Весной 2023 года стало известно, что компания создала свой первый ИИ-процессор. Чип под названием MTIA (Meta✴ Training and Inference Accelerator; на изображении) представляет собой ASIC в виде набора блоков, функционирующих в параллельном режиме. Задействованы 64 вычислительных элемента в виде матрицы 8 × 8, каждый из которых объединяет два ядра с архитектурой RISC-V. Конструкция включает 128 Мбайт памяти SRAM, а также до 64/128 Гбайт памяти LPDDR5. Показатель TDP равен 25 Вт. Заявленная производительность на операциях INT8 достигает 102,4 TOPS, на операциях FP16 — 51,2 Тфлопс. Процессор производится по 7-нм технологии TSMC.

Источник изображения: Meta✴ Как теперь сообщается, в 2024-м Meta✴ намерена начать активное использование собственных ИИ-ускорителей с кодовым именем Artemis. В их основу лягут компоненты MTIA первого поколения. Чип Artemis, оптимизированный для инференса, будет применяться наряду с ускорителями сторонних поставщиков. При этом, как отметили представители компании, изделия Artemis обеспечат «оптимальное сочетание производительности и эффективности при рабочих нагрузках, специфичных для Meta✴».

Источник изображения: Meta✴ Компания пока не раскрывает ни архитектуру Artemis, ни конкретные рабочие нагрузки, которые будет поддерживать чип. Участники рынка полагают, что Meta✴ будет запускать готовые ИИ-модели на собственных специализированных ASIC, чтобы высвободить ресурсы ускорителей для развивающихся приложений. По данным SemiAnalysis, Artemis получит улучшенные ядра, а компоненты LPDDR5 уступят место более быстрой памяти, использующей технологию TSMC CoWoS. Нужно добавить, что Amazon и Google уже несколько лет используют собственные чипы для ИИ-задач. Например, Amazon недавно ИИ-ускорители Trainium2 и Inferenetia2, тогда как Google в 2023 году представила сразу два новых ускорителя: Cloud TPU v5p и TPU v5e. А Microsoft сообщила о создании ИИ-ускорителя Maia 100.

02.02.2024 [13:13], Сергей Карасёв

Цена ИИ-ускорителя NVIDIA H20 для Китая составляет $12–$15 тыс.Компания NVIDIA, по сообщению Reuters, начала принимать предварительные заказы на новый ИИ-ускоритель H20, разработанный специально для Китая. Утверждается, что данное изделие стоит примерно столько же, сколько конкурирующий продукт Huawei — Ascend 910B. Отмечается, что в последние недели NVIDIA оценивает решение H20 в диапазоне от $12 тыс. до $15 тыс. Некоторые китайские дистрибьюторы уже предлагают этот ускоритель за $15 500. Для сравнения: Ascend 910B на местном рынке стоит приблизительно $16 900. Ради обхода санкционных ограничений, введённых властями США, компании NVIDIA пришлось снизить производительность H20 по сравнению со своими флагманскими чипами. По некоторым ключевым параметрам H20 уступает карте Ascend 910B. Вместе с тем, согласно имеющимся данным, H20 превосходит конкурирующее изделие Huawei с точки зрения скорости передачи данных между ускорителями внутри готовой системы.

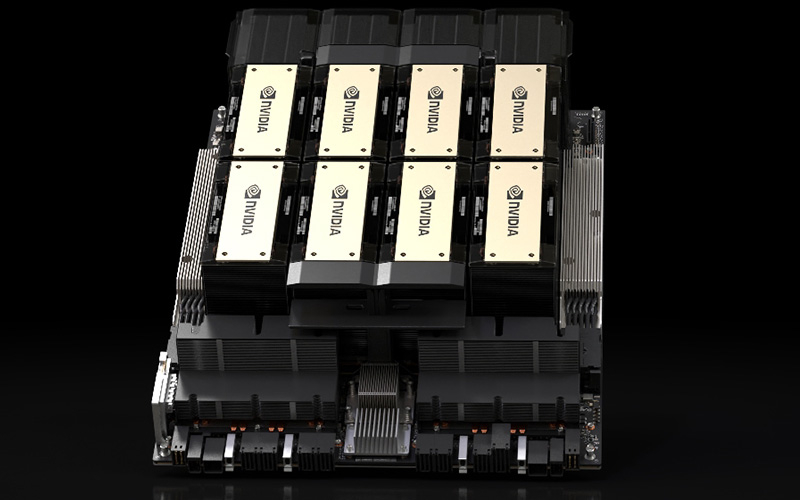

Источник изображения: NVIDIA Reuters также сообщает, что серверы, оснащённые восемью ускорителями H20, доступны в Китае для заказа по цене примерно $197 тыс. Это практически на треть меньше по сравнению с системами, оборудованными восемью чипами H800: такие устройства в прошлом году стоили около $282 тыс. Китайские дистрибьюторы сообщили, что смогут начать поставлять ускорители H20 небольшими партиями в текущем квартале, тогда как массовые отгрузки запланированы на II четверть 2024 года. При этом любое ужесточение санкций со стороны США может поставить крест на продажах новинок.

25.01.2024 [18:03], Руслан Авдеев

Singular Computing отозвала многомиллиардный иск к Google, обвинявшейся в краже технологий ИИ-чиповКомпания Singular Computing отозвала иск к Google на сумму в несколько миллиардов долларов — техногиганта обвиняли в нарушении патентных прав, связанных с чипами для ИИ-вычислений. Как сообщает The Register, в Google согласились на компенсацию, а сам иск уже отозван. В Google выразили удовлетворение тем, что пятилетнее разбирательство завершилось. В материалах суда, касающихся мирового соглашения, информация о сумме отсутствует, но в предшествовавших судебному разбирательству документах упоминалось требование Singular выплатить $1,6–5,2 млрд в качестве компенсации ущерба за использование патентованных технологий без лицензий при разработке и тензорных процессоров (TPU) второй и третьей версий.

Источник изображения: Google Cloud Singular ещё в 2010–2014 гг. предлагала техногиганту патентованные технологии и прототипы своих процессоров с раскрытием соответствующей информации. Впоследствии Singular обвинила Google в краже разработок и их использовании для создания тензорных ускорителей. Хотя Google отрицала любые контакты с Singular, в ходе разбирательства выяснилось, что во внутренней переписке Джефф Дин (Jeff Dean), главный учёный Google, упоминал разработки Singular как «очень хорошо подходящие» для задач техногиганта. В то же время Google неоднократно заявляла, что с разработками Singular её TPU никак не связаны, а исследования велись совершенно независимо многие годы. Тем не менее, компания, похоже, решила отделаться малой кровью — сейчас основу её ИИ-инфраструктуры составляет уже пятое поколение TPU, так что проблемы с патентами способны вылиться в ещё больший ущерб, чем скромная компенсация. Даже если разработка действительно велась независимо, наличие чужого патента всё равно накладывает обязательства по лицензированию.

13.01.2024 [21:37], Сергей Карасёв

Началось рассмотрение иска на $1,67 млрд о нарушении патентов в ИИ-ускорителях Google TPUВ США, по сообщению The Register, начался суд по иску компании Singular Computing в отношении Google: IT-корпорация обвиняется в незаконном использовании запатентованных разработок в своих ИИ-ускорителях TPU (Tensor Processing Unit). В случае победы Singular может получить компенсацию от $1,67 млрд до $5,19 млрд. Singular была основана в 2005 году доктором Джозефом Бейтсом (Joseph Bates). Согласно его профилю на LinkedIn, более 30 лет Бейтс занимал исследовательские и преподавательские должности в университетах Корнелла (Cornell University), Карнеги-Меллона (Carnegie Mellon University) и Джона Хопкинса (Johns Hopkins University), а также в Массачусетском технологическом институте (MIT) в США. Созданная Бейтсом компания Singular, как говорится на её сайте, «разрабатывает и лицензирует аппаратные и программные технологии для высокопроизводительных и энергоэффективных вычислений». Иск против Google был подан в 2019 году в федеральный суд Массачусетса. Утверждается, что в период с 2010-го по 2014 год Бейтс трижды делился с Google своими технологиями, обсуждая, в частности, как решать проблемы, связанные с ИИ-нагрузками. При этом якобы было заключено соглашение о неразглашении конфиденциальной информации. Кроме того, как утверждается, Бейтс заранее предупредил Google, что рассматриваемые технологии защищены патентами. В иске говорится, что Google незаконно использовала разработки Бейтса в ИИ-ускорителях TPU v2 и v3. Singular утверждает, что Google намеренно внедрила архитектуру Бейтса в свои чипы без разрешения или приобретенияя лицензии и тем самым сознательно нарушила патенты. Речь идёт о разработках, связанных с архитектурой, предназначенной для выполнения большого количества вычислений низкой точности в каждом цикле. Истцы утверждают, что данная технология хорошо подходит для использования в сфере ИИ. Соответствующие патентные заявки были оформлены и опубликованы в 2009–2010 гг. В деле упоминается внутреннее электронное письмо, в котором главный научный сотрудник Google якобы написал, что идеи Бейтса могут «очень хорошо подойти» для того, что разрабатывает Google. Кроме того, истцы упоминают письмо от другого неназванного работника Google, в котором говорится, что сотрудники компании «подкуплены идеями Джозефа». Google отвергает обвинения в нарушении прав. Корпорация заявляет, что патентные претензии Singular «сомнительны» и «в настоящее время находятся на апелляции».

12.01.2024 [19:04], Руслан Авдеев

Индия охотно купит ускорители NVIDIA, не доставшиеся Китаю из-за санкцийСтремящаяся ускорить технологическое развитие Индия, вероятно, сместит Китай на пьедестале крупного покупателя передовых ускорителей NVIDIA. Как сообщает The Register, это поможет производителю сохранить приемлемые финансовые результаты даже на фоне соблюдения антикитайских санкций. Тем более, что с рынка КНР компания полностью не уходит. Индийские IT-гиганты активно осваивают рынок ИИ. Например, индийская Yotta готовится к 2025 году получить 32 тыс. ускорителей NVIDIA на сумму порядка $1 млрд, в первую очередь H100 и наиболее современные H200, для создания облачной ИИ-платформы Shakti Cloud. Yotta полагается на оценки экспертов, по прогнозам которых ещё до конца текущего десятилетия на системы машинного обучения в Индии потратят $14 млрд. Кроме того, Reliance Jio закупит ускорители H200 и вместе с NVIDIA создаст большую языковую модель, а Tata и NVIDIA развернут ИИ-инфраструктуру на базе H200. После очередного санкционного удара США по Китаю в октябре 2023 года бизнес NVIDIA в КНР оказался под угрозой, но индийский рынок может скомпенсировать вероятные потери. Хотя финансовые эксперты NVIDIA полны оптимизма и ожидают, что рост спроса на ускорители покроет убытки от сокращения китайского рынка, полностью уходить из Поднебесной компания не планирует. Ранее NVIDIA подготовила для Китая урезанные по возможностям ускорители A800 и H800 суммарной стоимостью порядка $5 млрд. Впоследствии компании пришлось создать для Китая три новые модели ускорителей, соответствующие обновлённым санкционным требованиям, а уже выпущенные решения пристраивать на других рынках. Впрочем, по слухам, в Китае восприняли идею дальнейшего ухудшения ИИ-чипов для страны весьма прохладно. К тому же некоторые заказчики успели накопить запасы ускорителей. |

|