Материалы по тегу: gh200

|

14.11.2023 [19:04], Владимир Мироненко

Ускорители NVIDIA GH200 появились во всех облачных регионах VultrVultr, крупнейший в мире частный облачный провайдер, объявил о доступности суперчипа NVIDIA GH200 Grace Hopper во всех своих 32 облачных регионах. Портфолио провайдера также включает предложения на базе HGX H100, A100, L40S, A40 и A16. Vultr видит свою миссию в том, чтобы сделать HPC-решения простыми в использовании и доступными для предприятий и разработчиков по всему миру. Ускорители NVIDIA интегрированы с широким спектром предложений Vultr в области виртуализированных облачных платформ и bare metal, а также с управляемыми кластерами Kubernetes, управляемыми базами данных, блочными и объектными хранилищами и многим другим. Этот комплексный набор продуктов и услуг делает Vultr предпочтительным универсальным облачным поставщиком для предприятий любого размера с критически важными инициативами в области ИИ и машинного обучения, считает компания.

Источник изображения: Vultr Vultr также объявила о получении статуса NVIDIA Elite в партнёрской сети NVIDIA в области вычислений — NVIDIA Partner Network for Compute Competency. Статус ориентирован на партнёров, которые предоставляют вычислительные платформы с ускорителями NVIDIA для корпоративных заказчиков. Партнёры по Compute должны обеспечивать высокую производительность, масштабируемость и безопасность для каждой платформы.

13.11.2023 [22:05], Сергей Карасёв

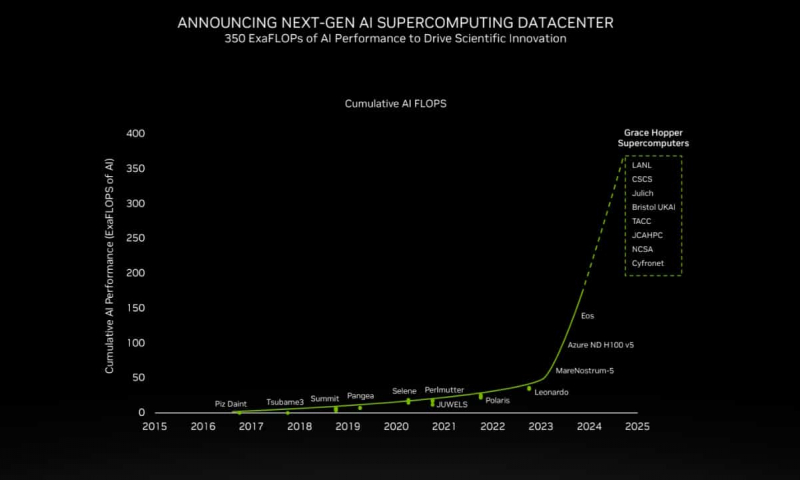

200+ Эфлопс: суперчип NVIDIA Grace Hopper ляжет в основу более 40 ИИ-суперкомпьютеровКомпания NVIDIA сообщила о том, что её суперчип GH200 Grace Hopper ляжет в основу более чем 40 ИИ-суперкомпьютеров по всему миру, которые используются в исследовательских центрах, на облачных площадках и пр. Отмечается, что в скором времени станут доступны десятки новых НРС-систем на базе GH200. Этот суперчип позволяет решать самые сложные научные задачи на базе ИИ, которые требуют обработки терабайт данных. В совокупности вычислительные системы на базе GH200, как сообщается, обеспечат ИИ-производительность около 200 Эфлопс. В частности, HPE объявила, что интегрирует GH200 в суперкомпьютеры HPE Cray. Узлы EX254n оснащаются двумя модулями Quad GH200 с четырьмя суперчипами в каждом, обеспечивая возможность масштабирования до десятков тысяч узлов. Аналогичный подход используется и в платформе Eviden BullSequana XH3000, которую Юлихский исследовательский центр (FZJ) в Германии получит в составе Jupiter — первого европейского суперкомпьютера экзафлопсного класса. Объединённый центр передовых высокопроизводительных вычислений в Японии (JCAHPC) намерен использовать суперчип в своём суперкомпьютере следующего поколения. Техасский центр передовых вычислений при Техасском университете в Остине (США) оборудует суперчипами НРС-систему Vista. Национальный центр суперкомпьютерных приложений при Университете Иллинойса в Урбане-Шампейне будет использовать решения GH200 в составе ИИ-платформы DeltaAI. А Британия получит ИИ-суперкомпьютер Isambard-AI на основе этого суперчипа, который разместится в Бристольском университете. Все эти системы присоединяются к ранее анонсированным платформам на базе GH200 от Швейцарского национального суперкомпьютерного центра (CSCS) и SoftBank Corp. GH200 уже доступен у некоторых поставщиков облачных услуг, таких как Lambda и Vultr. CoreWeave объявила о планах открыть инстансы GH200 в I квартале 2024 года. Другие производители систем, такие как ASRock Rack, ASUS, Gigabyte и Ingrasys, начнут поставки серверов с этими суперчипами к концу года.

13.11.2023 [17:00], Игорь Осколков

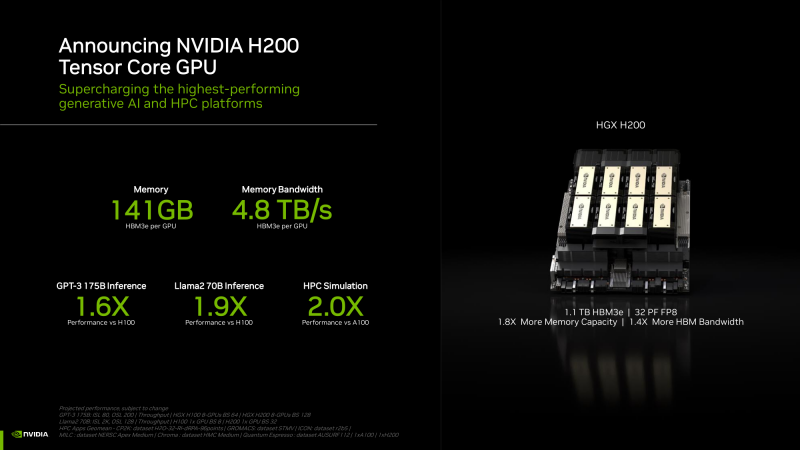

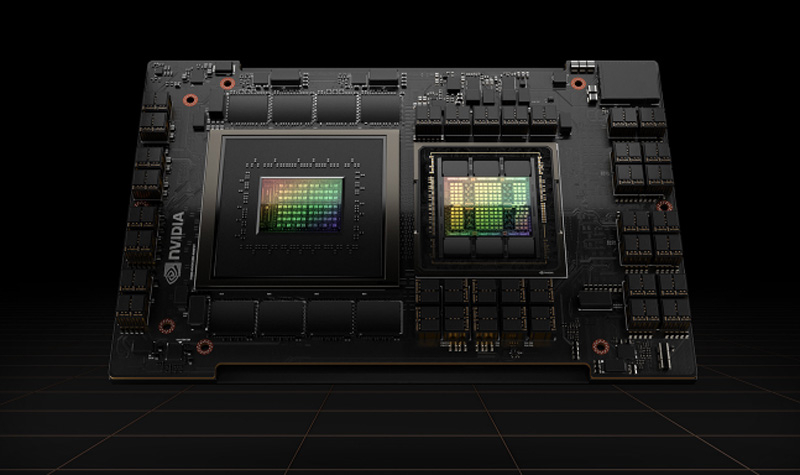

NVIDIA анонсировала ускорители H200 и «фантастическую четвёрку» Quad GH200NVIDIA анонсировала ускорители H200 на базе всё той же архитектуры Hopper, что и их предшественники H100, представленные более полутора лет назад. Новый H200, по словам компании, первый в мире ускоритель, использующий память HBM3e. Вытеснит ли он H100 или останется промежуточным звеном эволюции решений NVIDIA, покажет время — H200 станет доступен во II квартале следующего года, но также в 2024-м должно появиться новое поколение ускорителей B100, которые будут производительнее H100 и H200.

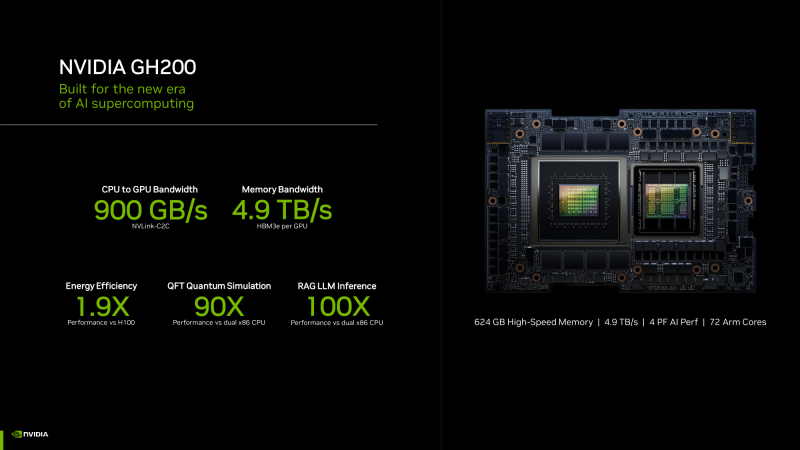

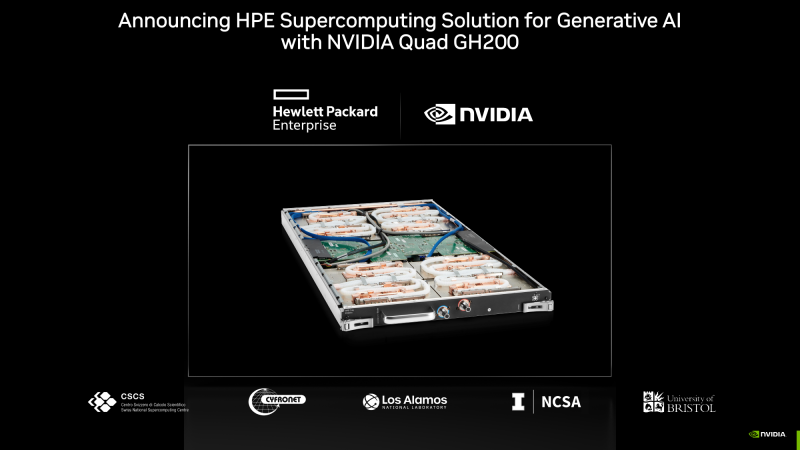

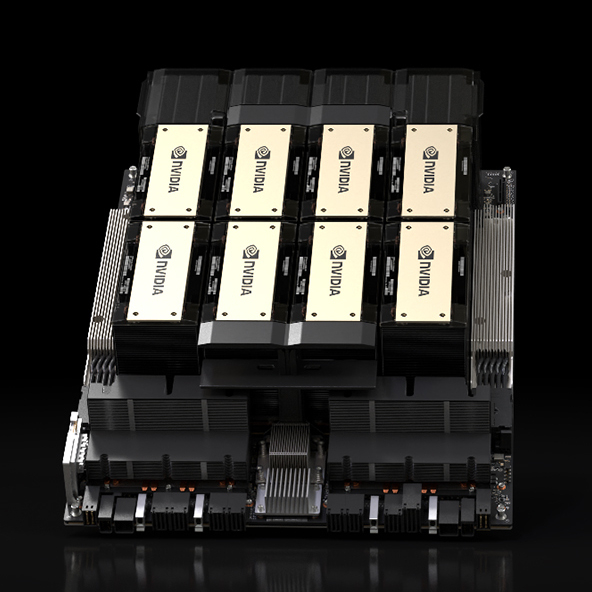

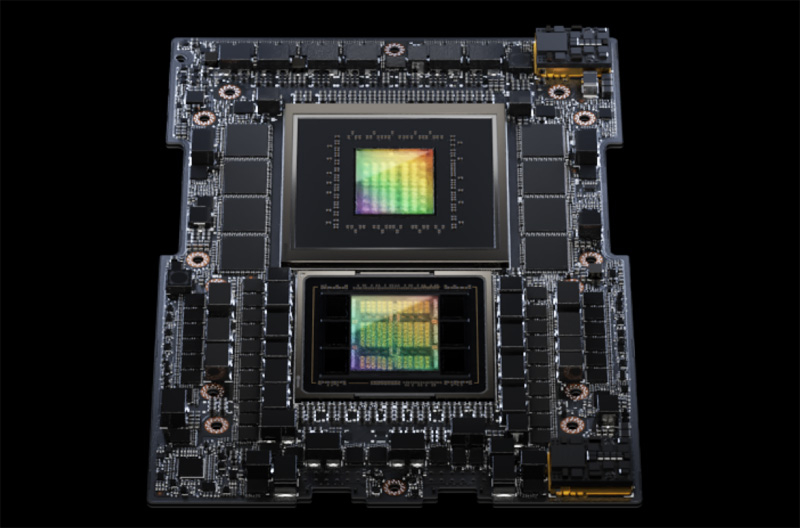

HGX H200 (Источник здесь и далее: NVIDIA) H200 получил 141 Гбайт памяти HBM3e с суммарной пропускной способностью 4,8 Тбайт/с. У H100 было 80 Гбайт HBM3, а ПСП составляла 3,35 Тбайт/с. Гибридные ускорители GH200, в состав которых входит H200, получат до 480 Гбайт LPDDR5x (512 Гбайт/с) и 144 Гбайт HBM3e (4,9 Тбайт/с). Впрочем, с GH200 есть некоторая неразбериха, поскольку в одном месте NVIDIA говорит о 141 Гбайт, а в другом — о 144 Гбайт HBM3e. Обновлённая версия GH200 станет массово доступна после выхода H200, а пока что NVIDIA будет поставлять оригинальный 96-Гбайт вариант с HBM3. Напомним, что грядущие конкурирующие AMD Instinct MI300X получат 192 Гбайт памяти HBM3 с ПСП 5,2 Тбайт/с. На момент написания материала NVIDIA не раскрыла полные характеристики H200, но судя по всему, вычислительная часть H200 осталась такой же или почти такой же, как у H100. NVIDIA приводит FP8-производительность HGX-платформы с восемью ускорителями (есть и вариант с четырьмя), которая составляет 32 Пфлопс. То есть на каждый H200 приходится 4 Пфлопс, ровно столько же выдавал и H100. Тем не менее, польза от более быстрой и ёмкой памяти есть — в задачах инференса можно получить прирост в 1,6–1,9 раза. При этом платы HGX H200 полностью совместимы с уже имеющимися на рынке платформами HGX H100 как механически, так и с точки зрения питания и теплоотвода. Это позволит очень быстро обновить предложения партнёрам компании: ASRock Rack, ASUS, Dell, Eviden, GIGABYTE, HPE, Lenovo, QCT, Supermicro, Wistron и Wiwynn. H200 также станут доступны в облаках. Первыми их получат AWS, Google Cloud Platform, Oracle Cloud, CoreWeave, Lambda и Vultr. Примечательно, что в списке нет Microsoft Azure, которая, похоже, уже страдает от недостатка H100. GH200 уже доступны избранным в облаках Lamba Labs и Vultr, а в начале 2024 года они появятся у CoreWeave. До конца этого года поставки серверов с GH200 начнут ASRock Rack, ASUS, GIGABYTE и Ingrasys. В скором времени эти чипы также появятся в сервисе NVIDIA Launchpad, а вот про доступность там H200 компания пока ничего не говорит. Одновременно NVIDIA представила и базовый «строительный блок» для суперкомпьютеров ближайшего будущего — плату Quad GH200 с четырьмя чипами GH200, где все ускорители связаны друг с другом посредством NVLink по схеме каждый-с-каждым. Суммарно плата несёт более 2 Тбайт памяти, 288 Arm-ядер и имеет FP8-производительность 16 Пфлопс. На базе Quad GH200 созданы узлы HPE Cray EX254n и Eviden Bull Sequana XH3000. До конца 2024 года суммарная ИИ-производительность систем с GH200, по оценкам NVIDIA, достигнет 200 Эфлопс.

13.11.2023 [17:00], Сергей Карасёв

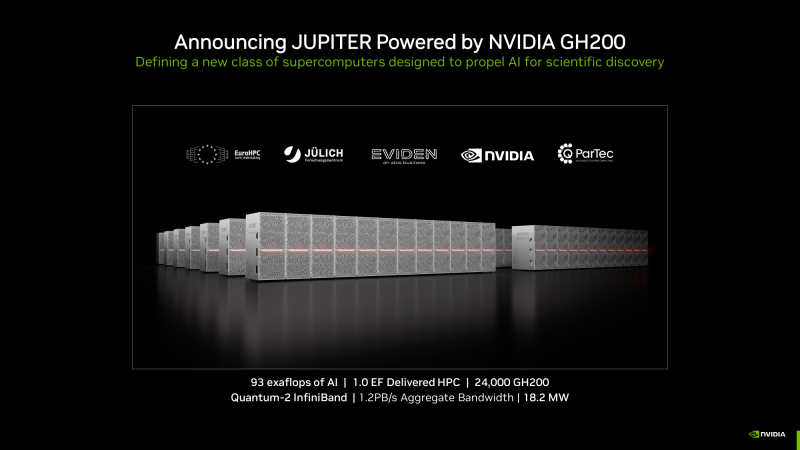

Первый в Европе экзафлопсный суперкомпьютер Jupiter получит 24 тыс. гибридных суперчипов NVIDIA Grace HopperКомпания NVIDIA в ходе конференции по высокопроизводительным вычислениям SC23 сообщила о том, что её суперчип GH200 Grace Hopper станет одной из ключевых составляющих НРС-системы Jupiter — первого европейского суперкомпьютера экзафлопсного класса.

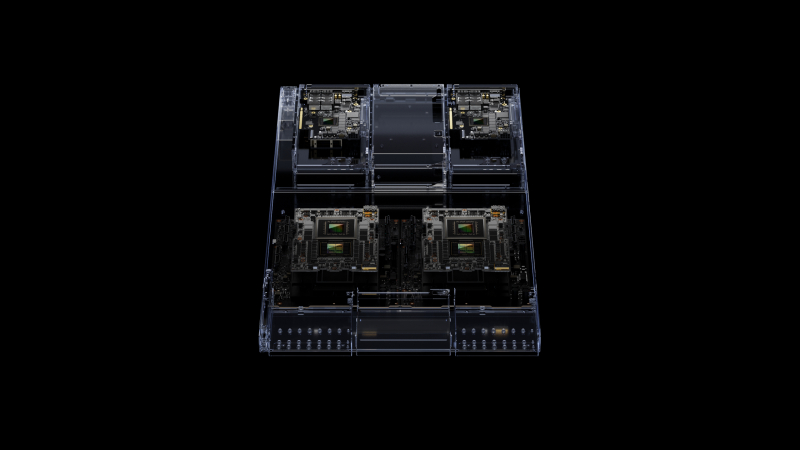

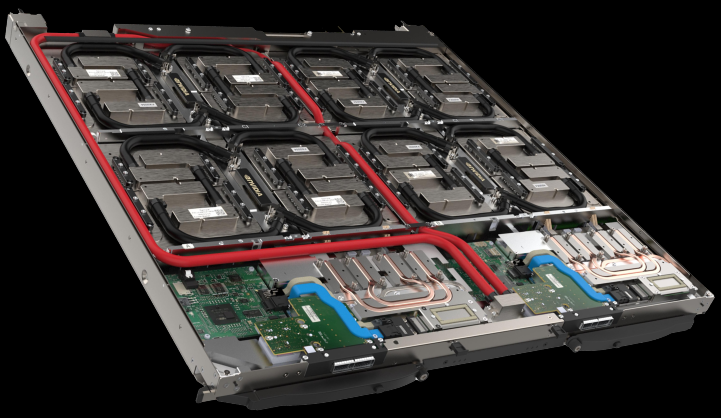

Узел BullSequana XH3000 (Источник здесь и далее: NVIDIA) Jupiter — проект Европейского совместного предприятия по развитию высокопроизводительных вычислений (EuroHPC JU). Комплекс расположится в Юлихском исследовательском центре (FZJ) в Германии. В создании суперкомпьютера участвуют NVIDIA, ParTec, Eviden и SiPearl. Архитектура системы модульная, что позволяет адаптировать её под разные классы задач. В основу одного из основных блоков Jupiter ляжет платформа Eviden BullSequana XH3000 с прямым жидкостным охлаждением, а в состав каждого узла войдут модули Quad GH200. Общее количество суперчипов составит 23752. В качестве интерконнекта будет применяться NVIDIA Quantum-2 InfiniBand. Быстродействие на операциях обучения ИИ составит до 93 Эфлопс, а FP64-производительность должна достичь 1 Эфлопс. При этом общая потребляемая мощность Jupiter составит всего 18,2 МВт. Применять систему Jupiter планируется для решения наиболее сложных задач. Среди них — моделирование климата и погоды в высоком разрешении (на базе NVIDIA Earth-2), создание новых лекарственных препаратов (NVIDIA BioNeMo и NVIDIA Clara), исследования в области квантовых вычислений (NVIDIA cuQuantum и CUDA Quantum), промышленное проектирование (NVIDIA Modulus и NVIDIA Omniverse). Ввод Jupiter в эксплуатацию запланирован на 2024 год.

02.11.2023 [21:49], Руслан Авдеев

Британия получит 200-Пфлопс ИИ-суперкомпьютер Isambard-AI на гибридных Arm-чипах NVIDIA GH200Правительство Великобритании о выделении £225 млн ($273 млн) на строительство самого мощного в стране суперкомпьютера Isambard производительностью более 200 Пфлопс в FP64-вычислениях и более 21 Эфлопс в ИИ-задачах. Как сообщает The Register, новая машина на базе тысяч гибридных Arm-суперчипов NVIDIA Grace Hopper (GH200) разместится в Бристольском университете и будет построена HPE. Ожидается, что машина будет введена в эксплуатацию в следующем году и поможет в выполнении самых разных задач, от автоматизированной разработки лекарств до анализа климатических изменений, от изучения и внедрения нейросетей в робототехнике до задач, связанных с обеспечением национальной безопасности и обработкой больших данных. Isambard-AI войдёт в десятку самых быстрых суперкомпьютеров мира. Пока что самый быстрый суперкомпьютер Великобритании — это 20-Пфлопс система Archer2, занимающая 30-ю позицию в рейтинге TOP500 и введённая в строй всего пару лет назад. Isambard-AI получит 5448 гибридных чипов NVIDIA GH200 GraceHopper с 96/144 Гбайт HBM-памяти. Используется платформа HPE Cray EX с интерконнектом Slingshot 11 и СЖО. 25-Пбайт хранилище использует СХД Cray ClusterStor E1000. Система будет размещена в ЦОД с автономным охлаждением, а система утилизации избыточного тепла позволит обогревать близлежащие здания. Первыми выгодоприобретателями проекта Isambard-AI станут команды Frontier AI Task Force и AI Safety Institute, намеренные смягчить угрозу со стороны ИИ национальной безопасности Великобритании. Компанию Isambard-AI составит ранее анонсированный Arm-суперкомпьютер Isambard-3, который также построит HPE. Эту машину введут в эксплуатацию следующей весной, она обеспечит британским учёным ранний доступ к вычислительным мощностям на первом этапе реализации проекта Isambard-AI. Isambard-3 получит 384 суперчипа NVIDIA Grace, а его пиковое быстродействие в FP64-вычислениях составит 2,7 Пфлопс. Всего в различные ИИ-проекты британские власти вложат порядка £900 млн ($1,1 млрд). В частности, вместе с Isambard-AI был объявлен и суперкомпьютер Dawn, который разместится в Кембридже. Хотя ранее NVIDIA описывала Isambard-AI как самый быстрый в стране, создатели Dawn утверждают, что быстрейшим будет именно он. Система будет полагаться на серверы Dell PowerEdge XE9640 с процессорами Sapphire Rapids и ускорителями Max.

19.10.2023 [21:34], Сергей Карасёв

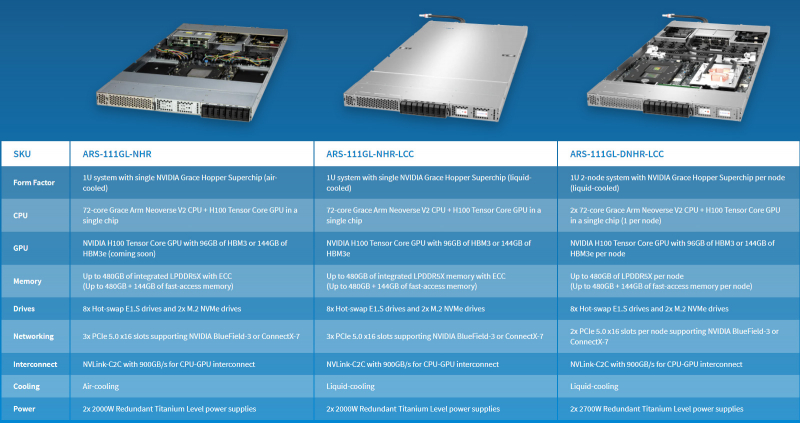

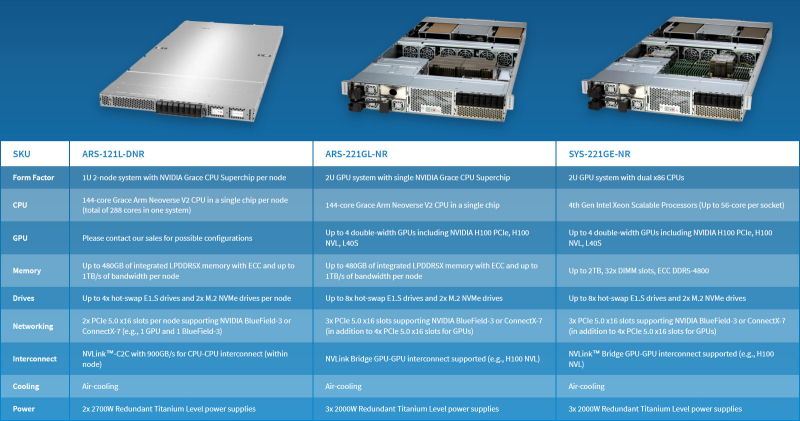

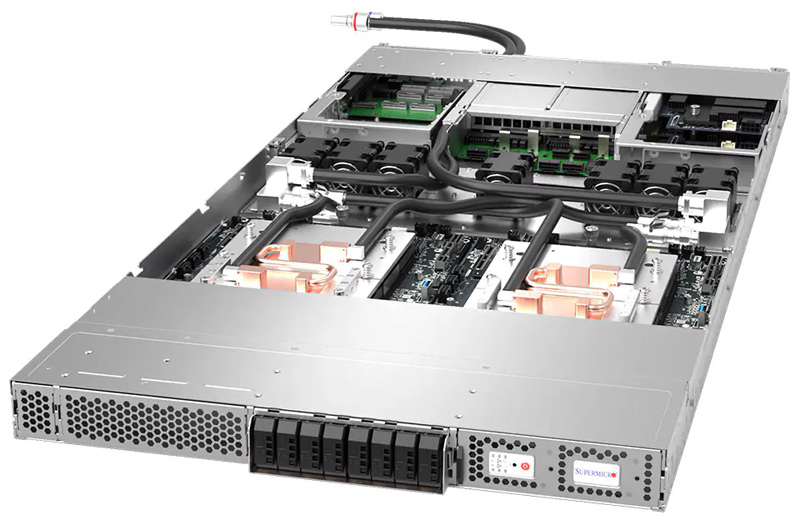

Supermicro выпустила первые в отрасли ИИ-системы NVIDIA MGX на базе гибридных суперчипов GH200 Grace HopperКомпания Supermicro сообщила о начале поставок первых в отрасли серверов на базе суперчипа NVIDIA GH200 Grace Hopper, предназначенных для поддержания ресурсоёмких нагрузок ИИ. Дебютировали стоечные решения в форм-факторах 1U и 2U с воздушным и жидкостным охлаждением. Серверы используют модульную платформу NVIDIA MGX, которая специально разработана для упрощения создания ИИ-систем. Разработчики на этапе проектирования выбирают базовую архитектуру для шасси, после чего добавляются CPU, GPU и DPU в той или иной конфигурации для решения определённых задач. В общей сложности выпущены шесть систем (см. характеристики в таблицах ниже). Все они допускают установку накопителей стандарта E1.S с возможностью горячей замены и SSD формата M.2. Есть слоты PCIe 5.0 x16 с поддержкой NVIDIA BlueField-3 и ConnectX-7. Питание обеспечивают два или три блока мощностью 2000 или 2700 Вт.

Источник изображений: Supermicro В список анонсированных серверов входят:

Supermicro отмечает, что заказчики могут использовать новые серверы в комплексе с софтом NVIDIA, включая NVIDIA AI Enterprise, для решения разнообразных задач в области генеративного ИИ, компьютерного зрения, речевых приложений и машинного обучения. А набор NVIDIA HPC SDK содержит компиляторы, библиотеки и программные инструменты, необходимые для организации высокопроизводительных вычислений.

11.09.2023 [19:00], Сергей Карасёв

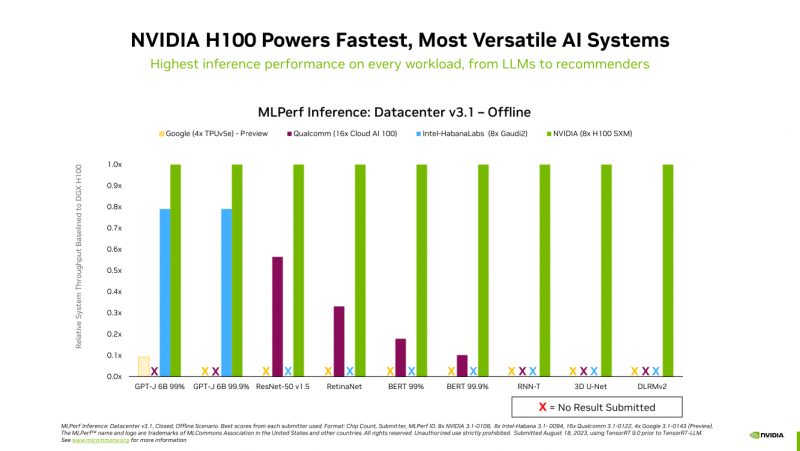

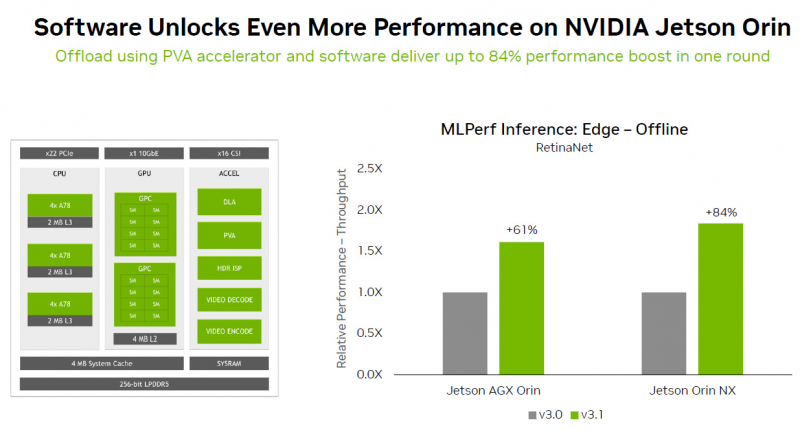

Много памяти, быстрая шина и правильное питание: гибридный суперчип GH200 Grace Hopper обогнал H100 в ИИ-бенчмарке MLPerf InferenceКомпания NVIDIA сообщила о том, что суперчип NVIDIA GH200 Grace Hopper и ускоритель H100 лидируют во всех тестах производительности ЦОД в бенчмарке MLPerf Inference v3.1 для генеративного ИИ, который включает инференс-задачи в области компьютерного зрения, распознавания речи, обработки медицинских изображений, а также работу с большими языковыми моделями (LLM). Ранее NVIDIA уже объявляла о рекордах H100 в новом бенчмарке MLPerf. Теперь говорится, что суперчип GH200 Grace Hopper впервые прошёл все тесты MLPerf. Вместе с тем системы, оснащенные восемью ускорителями H100, обеспечили самую высокую пропускную способность в каждом тесте MLPerf Inference. Решения NVIDIA прошли обновленное тестирование в области рекомендательных систем (DLRM-DCNv2), а также выполнили первый эталонный тест GPT-J — LLM с 6 млрд параметров. Примечательно, что GH200 оказался до 17 % быстрее H100, хотя чип самого ускорителя в обоих продуктах один и тот же. NVIDIA объясняет это несколько факторами. Во-первых, у GH200 больше набортной памяти — 96 Гбайт против 80 Гбайт. Во-вторых, ПСП составляет 4 Тбайт/с, а сам чип является гибридным, так что для передачи данных между LPDDR5x и HBM3 не используется PCIe. В-третьих, GH200 при низкой нагрузке на CPU умеет отдавать часть энергии ускорителю, оставаясь в заданных рамках энергопотребления. Правда, в тестах GH200 работал на полную мощность, т.е. с TDP на уровне 1 кВт (UPD: NVIDIA уточнила, что реально потребление GH200 под полной нагрузкой составляет 750–800 Вт).

Источник изображений: NVIDIA Отдельно внимание уделено оптимизации ПО — на днях NVIDIA анонсировала открый программный инструмент TensorRT-LLM, предназначенный для ускорения исполнения LLM на продуках NVIDIA. Этот софт даёт возможность вдвое увеличить производительность ускорителя H100 в тесте GPT-J 6B (входит в состав MLPerf Inference v3.1). NVIDIA отмечает, что улучшение ПО позволяет клиентам с течением времени повышать производительность ИИ-систем без дополнительных затрат. Также отмечается, что модули NVIDIA Jetson Orin благодаря новому ПО показали прирост производительности до 84 % на задачах обнаружения объектов по сравнению с предыдущим раундом тестирования MLPerf. Ускорение произошло благодаря задействованию Programmable Vision Accelerator (PVA), отдельного движка для обработки изображений и алгоритмов компьютерного зрения работающего независимо от CPU и GPU. Сообщается также, что ускоритель NVIDIA L4 в последних тестах MLPerf выполнил весь спектр рабочих нагрузок, показав отличную производительность. Так, в составе адаптера с энергопотреблением 72 Вт этот ускоритель демонстрирует в шесть раз более высокое быстродействие, нежели CPU, у которых показатель TDP почти в пять раз больше. Кроме того, NVIDIA применила новую технологию сжатия модели, что позволило продемонстрировать повышение производительности в 4,4 раза при использовании BERT LLM на ускорителе L4. Ожидается, что этот метод найдёт применение во всех рабочих нагрузках ИИ. В число партнёров при проведении тестирования MLPerf вошли поставщики облачных услуг Microsoft Azure и Oracle Cloud Infrastructure, а также ASUS, Connect Tech, Dell Technologies, Fujitsu, Gigabyte, Hewlett Packard Enterprise, Lenovo, QCT и Supermicro. В целом, MLPerf поддерживается более чем 70 компаниями и организациями, включая Alibaba, Arm, Cisco, Google, Гарвардский университет, Intel, Meta✴, Microsoft и Университет Торонто.

09.09.2023 [11:27], Сергей Карасёв

NVIDIA и индийская Tata развернут масштабную ИИ-инфраструктуруКомпания NVIDIA и индийский транснациональный конгломерат Tata Group объявили о заключении расширенного соглашения о сотрудничестве, в рамках которого планируется создание масштабной инфраструктуры и платформ для реализации проектов в области ИИ. Говорится, что благодаря партнёрству тысячи организаций, предприятий и научных коллективов, а также сотни стартапов в Индии получат доступ к передовым ресурсам для создания ИИ-приложений. Проектом предусмотрено развёртывание НРС-системы на основе суперчипов NVIDIA GH200 Grace Hopper. Речь идёт о создании в Индии облачной инфраструктуры, использующей глобальную сеть Tata Communications для обеспечения высокоскоростной передачи данных. Платформа позволит решать ресурсоёмкие задачи в области генеративного ИИ и больших языковых моделей. Похожий проект реализуется и с Reliance.

Источник изображения: NVIDIA Новую систему, в частности, намерена применять компания Tata Consultancy Services (TCS), предоставляющая услуги в области IT и консалтинга. На базе готовящейся облачной среды TCS планирует разворачивать приложения генеративного ИИ. Сотрудничество с NVIDIA, как ожидается, поможет TCS повысить квалификацию своих сотрудников, штат которых насчитывает около 600 тыс. человек. В целом, партнёрство будет способствовать ИИ-трансформации различных компаний в составе Tata Group — от производства до потребительского бизнеса.

09.09.2023 [11:27], Сергей Карасёв

NVIDIA и Reliance создадут большую языковую модель для Индии и развернут ИИ-инфраструктуру мощностью до 2 ГВтКомпании NVIDIA и Reliance Industries сообщили о заключении соглашения о сотрудничестве, которое предусматривает разработку большой языковой модели для Индии. Она будет обучена на различных языках страны и адаптирована для приложений генеративного ИИ. Кроме того, будет построена отдельная ИИ-инфраструктура мощностью до 2000 МВт. Внедрением системы займутся специалисты компании Jio. Партнёры намерены развернуть аппаратную ИИ-инфраструктуру, которая по производительности более чем на порядок превзойдёт самый мощный суперкомпьютер Индии. Для этого планируется задействовать суперчипы NVIDIA GH200 Grace Hopper, а также облачный сервис DGX Cloud. Говорится, что платформа NVIDIA станет основой ИИ-вычислений для Reliance Jio Infocomm, телекоммуникационного подразделения Reliance Industries. В рамках партнёрства Reliance будет создавать приложения и услуги на основе ИИ для примерно 450 млн клиентов Jio, а также предоставит энергоэффективную ИИ-инфраструктуру учёным, разработчикам и стартапам по всей Индии.

Источник изображения: Reliance Industries Применять ИИ планируется в самых разных отраслях — в сельском хозяйстве, медицине, климатологии и пр. В частности, приложения нового типа помогут предсказывать циклонические штормы, а также улучшат экспертную диагностику симптомов тех или иных заболеваний. Похожий проект реализуется и с Tata Group.

08.08.2023 [23:15], Игорь Осколков

NVIDIA представила обновлённый вариант гибридного ускорителя GH200 с 141 Гбайт памяти HBM3eВсего два с небольшим месяца назад NVIDIA объявила о начале массового производства гибридных суперчипов Grace Hopper GH200 и анонсировала 1-Эфлопс ИИ-суперкомпьютер на их основе. Первые решения на базе этих чипов станут доступны до конца текущего года, а уже во II квартале 2024 года появится новая версия Grace Hopper, которая получит 141 Гбайт набортной памяти HBM3e. В этом и заключается их отличие от оригинальных GH200, которые оснащаются 96 Гбайт HBM3. Помимо увеличения объёма памяти выросла и её пропускная способность, с 4 до 5 Тбайт/с. Ну и если заявленный объём LPDDR5x в 500 Гбайт не является округлением исходных 480 Гбайт, то и здесь тоже есть небольшой прирост. При этом производительность новой версии осталась на прежнем уровне — 4 Пфлопс с Transformer Engine (без явного указания точности вычислений). Тем не менее, прирост ПСП и объёма памяти положительно скажется как на процессе обучения ИИ-моделей, так и, что особенно важно, на инференсе. Прочие технические характеристики новинок компания пока не раскрыла, но сообщила о сохранении совместимости с платформой NVIDIA MGX и возможности объединения множества суперчипов и узлов посредством NVLink. Новинке придётся соревноваться с ускорителями AMD Instinct MI300A, которые должны появиться на рынке чуть раньше. |

|