Материалы по тегу: hardware

|

03.05.2024 [10:15], Владимир Мироненко

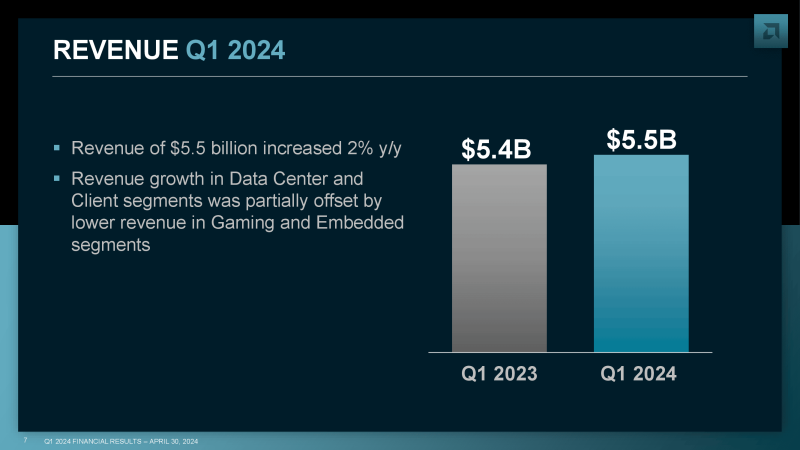

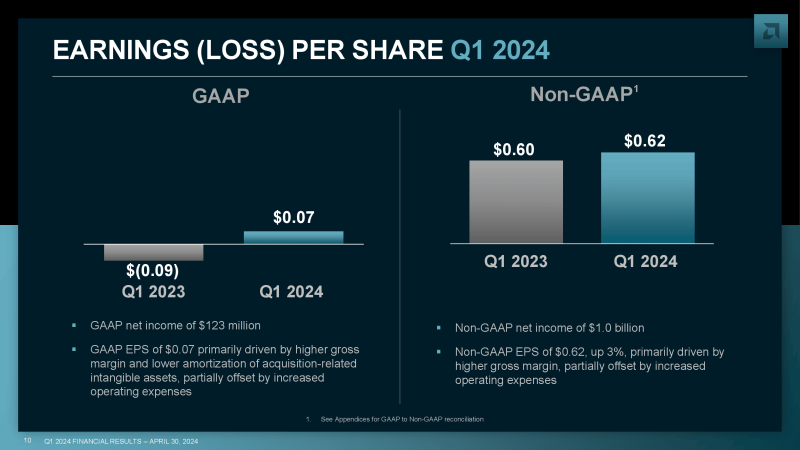

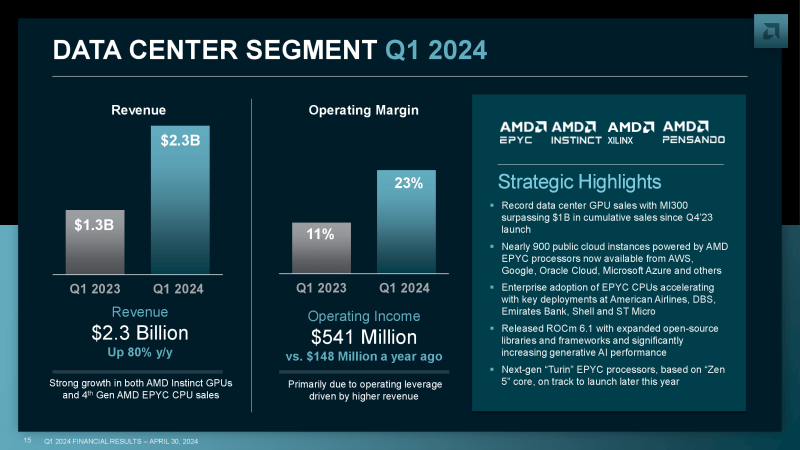

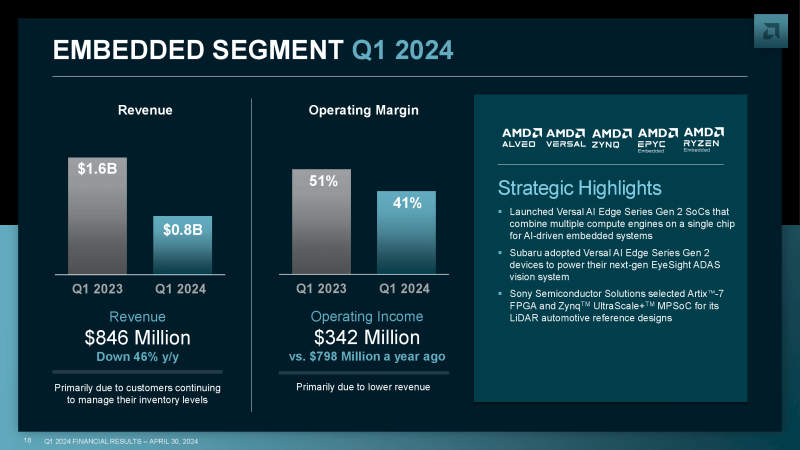

Результаты AMD в I квартале оправдали прогнозы аналитиков, но акции упали — инвесторы ожидают большего ростаAMD объявила результаты I квартала 2024 года. Несмотря на то, что основные показатели компании были выше или в рамках прогнозов Уолл-стрит, её акции упали более чем на 7 % после закрытия торговой сессии, поскольку прогноз на год по выпуску ускорителей ИИ оказался ниже ожиданий инвесторов. Выручка AMD выросла год к году на 2 % до $5,47 млрд, что чуть выше прогноза аналитиков Уолл-стрит в размере $5,46 млрд. Чистая прибыль (GAAP) компании составила $123 млн, или $0,07 на акцию, тогда как годом ранее у неё были убытки в $139 млн, или –$0,09 на акцию. Большую часть выручки компания получила благодаря подразделениям по выпуску продуктов для ЦОД, включая серверные процессоры и ИИ-ускорители, и клиентских решений, увеличившим показатели год к году на 80 % и 85 % до $2,3 млрд и $1,4 млрд соответственно. По обеим категориям компания превысила прогноз аналитиков Уолл-стрит, ожидавших выручку по сегменту продуктов для ЦОД в размере $2,27 млрд и $1,29 млрд по сегменту клиентских решений. Компания сообщила, что рост выручки в сегменте продукции для ЦОД был достигнут благодаря высокому спросу на ускорители AMD Instinct и серверные процессоры EPYC. Гендиректор AMD Лиза Су (Lisa Su) отметила высокий спрос на ИИ-ускоритель MI300, который, по её словам, продолжает расти. Она добавила, что значительно выросли поставки MI300 гиперскейлерам Microsoft, Meta✴ и Oracle. «В долгосрочной перспективе мы всё более тесно сотрудничаем с нашими облачными и корпоративными клиентами, поскольку мы расширяем и ускоряем наши планы по аппаратному и программному обеспечению для ИИ, а также увеличиваем выпуск GPU для ЦОД», — заявила Лиза Су. Су добавила, что AMD также совместно с такими производителями серверов, как Dell, HPE, Supermicro и Lenovo, занимается разработкой новых систем на базе MI300. По её словам, выпуск этих систем в текущем квартале будет увеличен. В связи с высоким спросом на ускорители для ИИ-серверов компания увеличила прогноз по их выпуску в 2024 году до $4 млрд с предыдущего прогноза в $3,5 млрд, но, по всей видимости, инвесторы ожидали ещё большего повышения, что привело к падению акций AMD. В других сегментах бизнеса AMD отмечен более слабый спрос. Выручка игрового сегмента, поставляющего чипы для игровых консолей, упала на 48 % до $922 млн, что ниже прогноза аналитиков, опрошенных StreetAccount, равного $969 млн. Выручка сегмента встраиваемых систем, в основном поставляющего продукты Xilinx, приобретённой в 2022 году, упала на 46 % до $846 млн при прогнозе Уолл-стрит в $942 млн. AMD заявила, что ожидает получить в текущем квартале выручку $5,4–$6 млрд, что соответствует прогнозу Уолл-стрит и означает рост год к году примерно на 6 %.

02.05.2024 [20:09], Руслан Авдеев

Microsoft развернёт в Таиланде облачную и ИИ-инфраструктуруКомпания Microsoft объявила о намерении построить облачную и ИИ-инфраструктуру в Таиланде, в том числе ЦОД, передаёт Datacenter Dynamics. Меры приняты в ответ на растущие потребности страны в облачных решениях, хотя подробности о планируемом регионе пока не разглашаются. На мероприятии Microsoft Build AI Day в Бангкоке глава Microsoft Сатья Наделла (Satya Nadella) заявил, что страна имеет невероятную возможность построить будущее на основе ИИ-технологий. По мнению главы Microsoft, новый регион в совокупности с инвестициями в местную облачную и ИИ-инфраструктуру, а также обучение ИИ-технологиям, обеспечит долговременное сотрудничество со страной и поможет её государственным и частным организациям получить новый импульс к росту. Власти страны подтверждают, что стратегия Ignite Thailand нацелена на превращения Таиланда в цифровой экономический хаб, который позволит значительно ускорить инновации и расширить возможности исследований и развития, заодно усилив и кадровый состав. Microsoft официально пригласили инвестировать в цифровую инфраструктуру страны в сентябре прошлого года. Компания уж заключила меморандум о взаимопонимании с госорганами, обязавшись помочь в реализации стратегии цифрового развития страны. В прошлом году сообщалось, что AWS, Microsoft и Google намерены инвестировать в дата-центры Таиланда $8,5 млрд. Например, в августе 2022 года Google анонсировала планы построить в стране собственный облачный регион, с аналогичными планами выступила в октябре того же года и AWS. Последняя запустила зону периферийных вычислений Local Zone в Бангкоке в декабре 2022 года. Стараются не отставать и азиатские инвесторы. Tencent имеет две зоны доступности в Бангкоке, открыла ЦОД в столице Таиланда и Alibaba в мае 2022 года. Наконец, ранее в этом году NTT начала в Бангкоке строительство ЦОД её 12 МВт, который должен заработать в 2025 году. Предложение Microsoft для Таиланда перекликается с инвестициями компании в объёме $1,7 млрд в облачную и ИИ-инфраструктуру Индонезии, анонс которых состоялся буквально на днях. Компания также намерена инвестировать в аналогичные объекты в Малайзии.

02.05.2024 [20:02], Владимир Мироненко

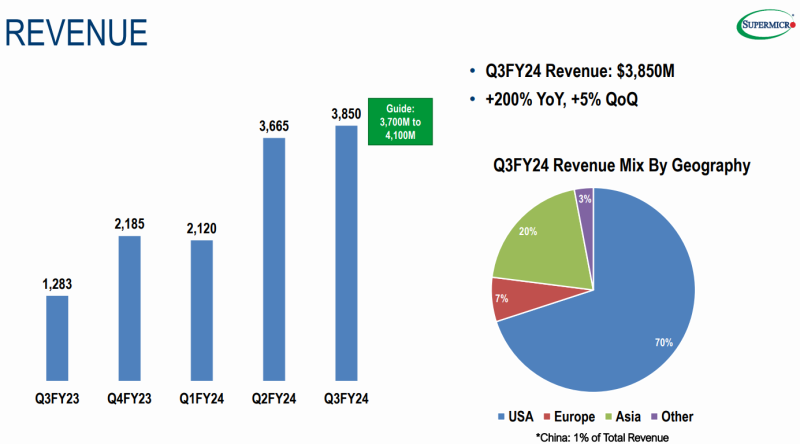

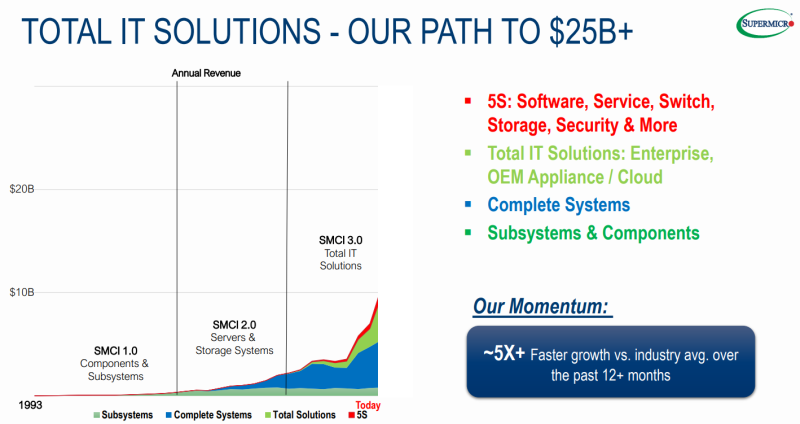

Не оправдала ожиданий: Supermicro нарастила выручку на 200 %, но её акции всё равно упали на 15 %Supermicro, американский поставщик серверов, СХД и комплексных ИТ-решений, объявил результаты III квартала 2024 финансового года, завершившегося 31 марта 2024 года. Несмотря на значительный рост выручки, превысившей на 200 % показатель аналогичного квартала в предыдущем финансовом году, акции Supermicro упали на 15 %, поскольку показатели оказались ниже прогнозов.

Источник изображений: Supermicro Выручка Supermicro за III квартал составила $3,85 млрд, что ниже прогноза опрошенных LSEG аналитиков Уолл-стрит, равного $3,95 млрд, хотя и выше на 200 % год к году. Чистая прибыль равняется $402,5 млн или $6,56 на акцию, по сравнению с $85,8 млн или $1,53 на акцию. Скорректированная чистая прибыль на акцию (non-GAAP) составила $6,65, тогда как годом ранее этот показатель был равен $1,63. По этому показателю компания превысила как собственный прогноз, составляющий $5,20–$6,01 на акцию (non-GAAP), так и консенсус-прогноз аналитиков в $5,80 на акцию (non-GAAP). Глава SuperMicro Чарльз Лян (Charles Liang) заявил, что поставки серверов могли быть ещё больше, если бы не нехватка ключевых компонентов. Он отметил, что ИИ будет способствовать ещё большему росту компании в течение «многих кварталов, если не лет». Чарльз Лян также заявил, что стремительный рост побудил SuperMicro провести в начале года вторичное размещение акций, чтобы получить дополнительный капитал. В IV квартале 2024 финансового года, заканчивающемся 30 июня, компания прогнозирует объём продаж в пределах от $5,1 до $5,5 млрд, чистую прибыль на разводненную акцию (GAAP) в пределах от $7,20 до $8,05 и чистую прибыль (non-GAAP) на разводненную акцию в диапазоне от $7,62 до $8,42. Аналитики Уолл-стрит прогнозируют объём продаж в IV квартале 2024 финансового года всего в $4,9 млрд и прибыль в $7,18 на акцию (non-GAAP). SuperMicro также повысила прогноз на весь 2024 финансовый год. Теперь компания ожидает, что её выручка составит от $14,7 до $15,1 млрд за год, а прибыль — от $23,29 до $24,09 на акцию. Ранее компания планировала выручку в диапазоне от $14,3 до $14,7 млрд и более низкую прибыль на акцию. Согласно консенсус-прогнозу аналитиков Уолл-стрит, годовая выручка SuperMicro составит $14,6 млрд, а прибыль — $21,95 на акцию. Как отметил ресурс SiliconANGLE, у Supermicro достаточно причин для оптимизма. На прошлой неделе корпорация Microsoft и Alphabet продемонстрировали более сильный, чем ожидалось, рост доходов от облачных сервисов, обусловленный ростом спроса на ИИ-технологии. Они также объявили о планах увеличить расходы на инфраструктуру ИИ, что сулит выгоду Supermicro, поскольку обе компании входят в число её крупнейших клиентов. Акции Supermicro в последнее время были одними из самых прибыльных в технологической отрасли, увеличившись в цене более чем на 700 % за последние 12 месяцев. Благодаря их росту рыночная стоимость компании превысила $50 млрд, и она заменила в индексе S&P 500 производителя бытовой техники Whirlpool. Supermicro является одной из немногих компаний, которая выпускает под заказ индивидуальные ИИ-серверы на базе ускорителей NVIDIA. Ее главными конкурентами являются Dell Technologies, Hewlett Packard Enterprise (HPE) и Lenovo Group, каждая из которых тоже является выгодополучателем бума на ИИ. Но именно акции Supermicro продемонстрировали наибольший рост благодаря фокусу на выпуск ИИ-серверов.

02.05.2024 [15:33], Алексей Разин

Micron начала поставки RDIMM-модулей DDR5 объёмом 128 Гбайт на базе 32-Гбит чиповПредставив чипы памяти типа DDR5 ёмкостью 32 Гбит ещё прошлой осенью, компания Micron Technology только сейчас сертифицировала модули RDIMM объёмом 128 Гбайт на основе этих чипов на совместимость с оборудованием ключевых игроков серверного рынка. Клиенты Micron смогут получить такие модули памяти в июне. Также компания объявила о поставках восьмиярусных стеков памяти HBM3E. Американский производитель памяти подчёркивает, что и 128-Гбайт модули DDR5-5600 RDIMM, и HBM3E-память Hi-8 наилучшим образом проявят себя в серверной инфраструктуре, ориентированной на обслуживание ИИ-систем. Кого именно из производителей ускорителей вычислений Micron снабжает памятью типа HBM3E, не уточняется, но конкурирующие Samsung и SK hynix уже готовы поставлять клиентам 12-ярусные чипы HBM3E. Впрочем, ещё в феврале Micron сообщил о готовности начать во II квартале поставки чипов HBM3E объёмом 24 Гбайт для ускорителей NVIDIA H200.

Источник изображения: Micron Technology Серверные модули DDR5 объёмом 128 Гбайт со скоростью 5600 МТ/с на основе монолитных 32-Гбит чипов памяти, по данным Micron, позволяют на 45 % поднять плотность хранения данных в пересчёте на один контакт, на 22 % поднять энергетическую эффективность, и на 16 % снизить задержки при передаче информации по сравнению с немонолитными чипами DDR5. Micron отметила, что в этом году начнёт поставки модулей со скоростью 4800, 5600 и 6400 MT/с, а в будущем намерена предложить решения со скоростью до 8000 MT/с. AMD и Intel подтвердили совместимость новых модулей Micron со своими современными серверными платформами. Со следующего месяца Micron начнёт продавать новую память через своих торговых партнёров.

02.05.2024 [14:02], Руслан Авдеев

10 ГВт за $10 млрд: Microsoft подписала крупнейшее соглашение на поставку «зелёной» энергииMicrosoft заключила с Brookfield крупнейшее среди корпораций рамочное соглашение в области «зелёной» энергетики. По данным Financial Times, IT-гигант согласился вложить $10 млрд в решения по генерации энергии из возобновляемых источников — проекты будут разрабатываться Brookfield Asset Management, а поставками займётся Brookfield Renewable Partners. Соглашение предусматривает строительство в 2026–2030 гг. крупных ветряных и солнечных электростанций суммарной мощностью до 10,5 ГВт. В Brookfield сообщили, что сделка приблизительно в восемь раз масштабнее, чем предыдущее крупнейшее соглашение о покупках возобновляемой энергии — в своё время его заключили горноперерабатывающая Rio Tinto и австралийский оператор солнечных электростанций. А по количеству PPA лидирует, судя по всему, Amazon. У Brookfield большие планы по расширению уже имеющихся 33 ГВт, а партнёрство с Microsoft будет значительно способствовать этому. Microsoft объявила, что намерена использовать своё влияние и средства для создания длительного положительного эффекта для всех потребителей электричества. По некоторым данным, в сделке участвует и испанская компания X-Elio, занимающаяся проектами, посвящёнными возобновляемой энергии. Ёмкость действующих ЦОД Microsoft превышает 5 ГВт, ещё 1 ГВт должен добавиться в следующие полгода, и ещё 1,5 ГВт — в I половине 2025 года. Компания является одним из крупнейших корпоративных покупателей возобновляемой энергии, а в описании одной из вакансий указывается, что уже заключены соответствующие контракты на более 20 ГВт. Кроме того, по слухам, компания рассчитывает в скором времени развернуть ИИ-инфраструктуру мощностью 5 ГВт совместно с OpenAI.

02.05.2024 [12:32], Сергей Карасёв

США ввели санкции против крупных российских интеграторов и IT-компанийУправление по контролю над иностранными активами (OFAC), входящее в Министерство финансов США, обнародовало новый санкционный список, затрагивающий российские IT-компании. В него в числе прочих попали «Ланит», «Астра» и группа компаний IBS. В частности, ограничительные меры введены в отношении IBS Expertise, IBS Soft, IBS Infinisoft и IBS IT Services. В число направлений деятельности входят внедрение бизнес-решений, консалтинг, системная интеграция, разработка и тестирование ПО, разработка веб-сервисов и мобильных приложений и пр.

Источник изображения: pixabay.com В свою очередь, «Ланит» — многопрофильная группа IT-компаний, работающих в области цифровизации и импортозамещения. Предоставляются консалтинговые услуги, решения для ключевых потребностей бизнеса (управление персоналом, управление предприятием, CRM- и BPM-системы), IaaS/PaaS/ВaaS- и SaaS-решения и пр. Группа «Астра» — российский разработчик ПО и средств защиты информации. Ключевым продуктом является платформа Astra Linux. Все решения компании включены в «Единый реестр российских программ для ЭВМ и баз данных» Минцифры. В группе «Астра» сообщили, что санкции не повлияют на бизнес-операции: компания, как утверждается, не использует ни одного проприетарного компонента, развивая своё собственное хранилище кода. При этом все технологические процессы «абсолютно независимы от других юрисдикций». «Мы не рассматриваем страны ЕС и США в качестве направлений для зарубежной экспансии и продолжаем развивать технологический стек российского ПО, способный заменить западные решения на российском рынке и рынке дружественных стран»,— сообщили в группе «Астра». Ранее под санкции попало НПО «РусБИТех». Как отмечает газета «Коммерсантъ», Минфин США ввел санкционные ограничения против компаний — разработчиков решений для кибербезопасности «Аладдин» («Аладдин Р.Д.») и Secret Technologies (ООО «Сикрет Технолоджис»), а также разработчика средств оцифровки документов корпорации ЭЛАР (ООО «Электронный архив»). В список попала фирма «Сисофт Девелопмент», занимающаяся разработкой инженерного ПО.

01.05.2024 [17:00], Сергей Карасёв

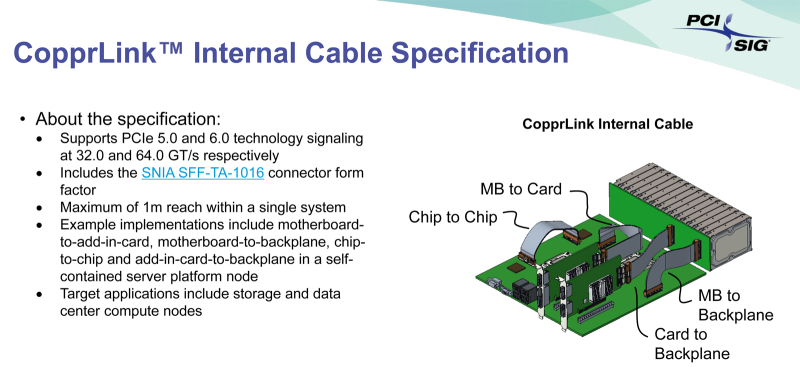

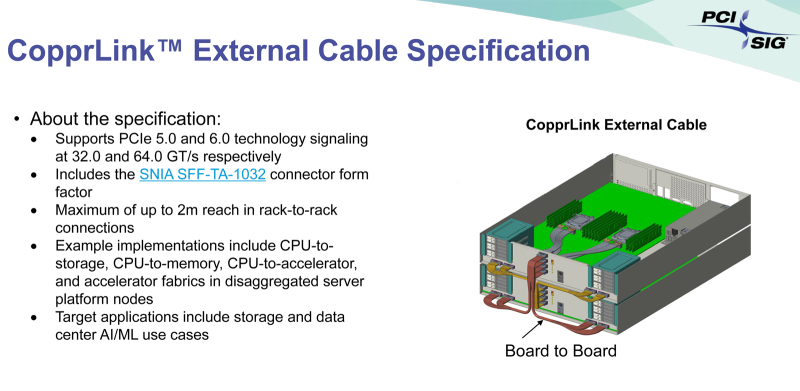

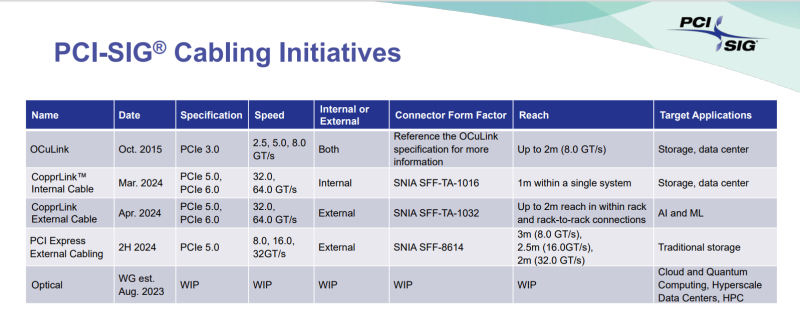

Внутри и снаружи: PCI-SIG обнародовала спецификации кабелей CopprLink для PCIe 5.0/6.0Организация PCI Special Interest Group (PCI-SIG) обнародовала спецификации электрических кабелей и разъёмов CopprLink для внешних и внутренних подключений PCIe 5.0/6.0. Новые соединения на основе меди позволят заменить существующие кабели OCuLink в тех случаях, когда требуется более высокая пропускная способность. Стандарт CopprLink был анонсирован в конце 2023 года. Кабели данного типа обеспечат высокоскоростные подключения в пределах отдельных систем, а также между различными узлами в составе стойки. Кроме того, как отмечалось ранее, разрабатываются варианты для межстоечного соединения. Спецификация CopprLink для внутренних подключений:

Спецификация CopprLink для внешних подключений:

Отмечается, что в дальнейшем кабели CopprLink будут развиваться с учётом возможностей интерфейса PCIe следующих поколений. Технология CopprLink, как ожидается, будет востребована в сферах, где необходимы небольшие задержки, включая дата-центры, производительные СХД, сети и пр. В будущем ожидается появление оптических кабелей PCIe.

30.04.2024 [22:17], Руслан Авдеев

Data4 намерена построить в Милане 100-МВт ЦОД стоимостью €500 млнФранцузский оператор дата-центров Data4 намерен потратить €500 млн ($535 млн) на новый кампус ЦОД в Италии. По данным Datacenter Dynamics, кампус Mil2 в Милане построят на западе города — на территории 77 тыс. м2 разместят четыре объекта. Data4 уже управляет восемью ЦОД в Италии, все из них находятся в районе Милана. Строительство нового кампуса осуществляется в рамках плана по инвестициям €1 млрд ($1,07 млрд) в цифровую инфраструктуру страны. Ожидается, что первый ЦОД будет готов в 2027 году, а его ёмкость составит 14 МВт. После того, как строительство закончат полностью, общая ёмкость кампуса вырастет до 100 МВт. Новый кампус в Милане, как ожидается, будет полностью обеспечиваться «зелёной» энергией. По словам Data4, стратегические инвестиции в объёме €1 млрд позволят укрепить лидерскую позицию на рынке ЦОД Италии и Европы в целом. Data4 основана в 2006 году компанией Colony Capital (ныне DigitalBridge), а теперь принадлежит Brookfield Infrastructure, которая выкупила оператора за, как считается, $3,8 млрд. На сегодня Data4 выступает оператором трёх десятков дата-центров во Франции, Италии, Польше и Люксембурге, а в Германии ведёт подготовительные работы к формированию кампуса, площадь которого может составить 200 тыс. м2, а ёмкость — 180 МВт. В 2023 году для Data4 получила заёмное финансирование на €2,2 млрд с возможностью увеличения долга до €3,2 млрд.

30.04.2024 [21:59], Руслан Авдеев

Водородные элементы запитают суперкомпьютерный центр Texas Advanced Computing CenterДемонстрационная платформа на водородных топливных элементах, запущенаная в Остине (Техас), запитает ЦОД суперкомпьютерного центра Texas Advanced Computing Center (TACC). Проект стал частью инициативы H2@Scale и будет моделью для будущих масштабных водородных проектов, объединяющих производство, распределение, хранение и использование данного вида топлива, передаёт Datacenter Dynamics. Объект, расположенный в одном из кампусов Техасского университета, представляет собой плод сотрудничества GTI Energy, её «дочки» Frontier Energy, университетского Центра электромеханики, а также пары десятков акционеров, представляющих промышленные предприятия. Площадка будет генерировать водород, путём электролиза, используя энергию солнца и ветра, а также переработку метана с хранилищ отходов. Полученный водород будет применяться в топливных ячейках и для заправки парка электромобилей Toyota Mirai и БПЛА, тоже применяющих водородные топливные элементы. Техасский университет не первое десятилетие работает над соответствующими технологиями и намерен поставлять для проекта квалифицированные кадры и инженерные данные. Помимо текущего проекта, исследовательская площадка пригодится и для развития других решений в «зелёной» водородной индустрии. А основанный в 2001 году центр TACC стал пристанищем для нескольких суперкомпьютеров, включая Frontera, JetStream2, Lonestar6, Maverick2 и Stampede3. Не так давно анонсировано строительство кластера Vista на ускорителях NVIDIA.

Источник изображения: Техасский университет Инициативу H2@Scale в Техасском университете начали реализовать в 2020 году. В задачи входит продвижение пилотных проектов, связанных с «возобновляемым» водородом в качестве экологически чистого и экономически эффективного источника топлива. В числе промышленных партнёров университета есть Air Liquide, CenterPoint Energy, Chart Industries, Chevron, ConocoPhillips, Hitachi Energy, Low-Carbon Resources Initiative, McDermott, Mitsubishi Heavy Industries America, OneH2, ONE Gas, ONEOK, Shell, SoCalGas, Texas Commission on Environmental Quality, Toyota и WM. Государственно-частные проекты в рамках инициативы H2@Scale поддерживает Министерство энергетики США. Техасский университет отмечает, что штат имеет оптимальные условия для реализации водородных проектов, уже имея значительную водородную инфраструктуру, включая около 1500 км подходящих трубопроводов. Но эксперименты H2@Scale ведутся и в других местах. Так, в январе Caterpillar Electric Power и Microsoft объявили об успешном эксперименте, в ходе которого для питания дата-центра применялись исключительно водородные топливные ячейки в течение 48 часов.

30.04.2024 [13:02], Сергей Карасёв

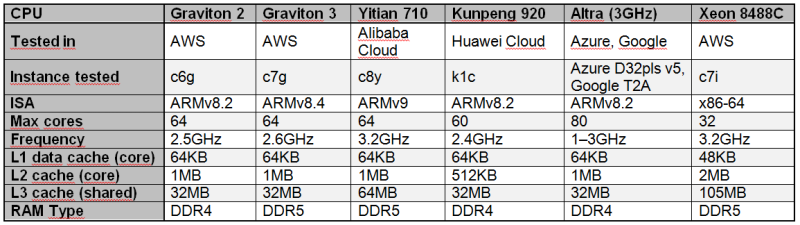

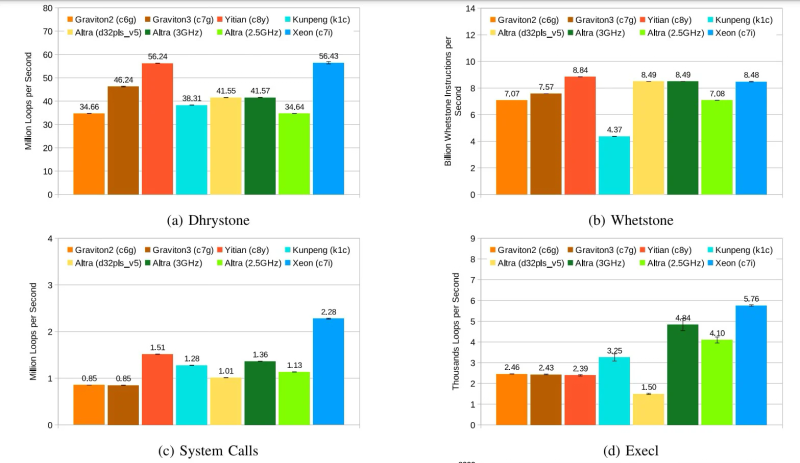

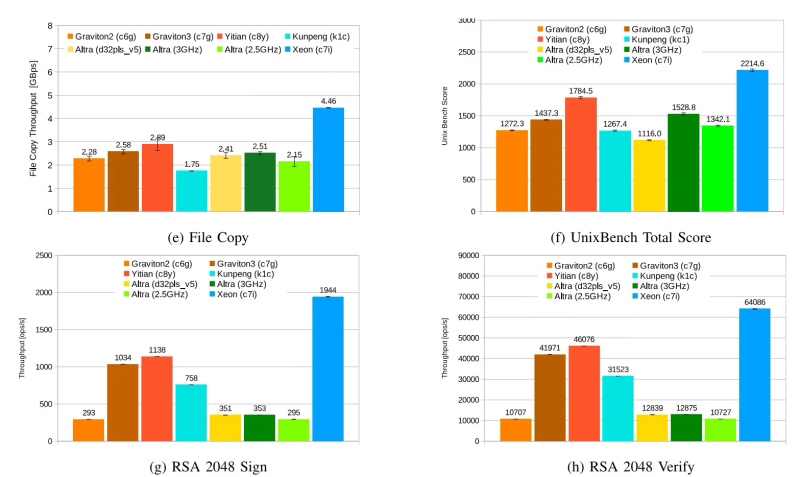

Alibaba Yitian 710 признан самым быстрым облачным Arm-процессором в ряде бенчмарковСогласно результатам исследования, обнародованным Институтом инженеров электротехники и электроники (IEEE) в журнале Transactions on Cloud Computing, процессор Alibaba Yitian 710 на сегодняшний день является самым производительным серверным чипом с архитектурой Arm из тех, которые доступны в составе различных облачных платформ, передаёт The Register. Изделие Yitian 710 было создано подразделением T-Head специально для нужд Alibaba Cloud и дебютировало в 2021 году. Этот 5-нм процессор на базе Armv9 насчитывает до 128 ядер с частотой до 3,2 ГГц. Обеспечивается поддержка восьми каналов памяти DDR5 и 96 линий PCIe 5.0. При этом чипы отличаются высокой энергетической эффективностью. Alibaba Cloud рассчитывала перенести пятую часть своих мощностей на собственные Arm-чипы к 2025 году. В ходе исследования чип Yitian 710 в конфигурации с 64 ядрами сравнивался с Arm-процессорами Amazon Graviton 2/3 (64 ядра), Huawei Kunpeng 920 (60 ядер) и Ampere Altra (80 ядер), а также с х86-чипом Intel Xeon Platinum 8488C поколения Sapphire Rapids. Тестирование проводилось в различных облачных средах, включая Amazon Web Services (AWS), Alibaba Cloud, Huawei Cloud, Microsoft Azure, Google Cloud Platform. Оценивалось быстродействие при выполнении различных задач: классические бенчмарки Dhrystone и Whetstone, ряд системных вызовов ядра и вызовов execl, скорость копирования файлов, показатель UnixBench, подписи и аутентификация с использованием криптографического алгоритма RSA 2048, а также работа с СУБД. Как отмечается, практически во всех перечисленных тестах процессор Alibaba опережал конкурирующие чипы с архитектурой Arm. В задачах Whetstone изделие Yitian 710 также превзошло процессор Xeon Platinum и чип Altra. Вместе с тем Graviton 3 показал превосходство в тесте Redis. Тем не менее, Yitian 710 сохранил своё преимущество в двух из трёх задач RocksDB. В плане эффективности чипам Arm требуется больше системных вызовов, чем их конкурентам Intel. Но в некоторых сценариях использования решения Arm всё равно оказываются более предпочтительными. |

|