Материалы по тегу: ram

|

16.01.2023 [21:37], Алексей Степин

Weebit Nano получила первые 22-нм кристаллы ReRAM, выполненные по технологии FD-SOIС закатом 3D XPoint и потерей интереса Intel и Micron к данному проекту, на передний план выходят другие технологии энергонезависимой памяти, лишённые недостатков классической NAND. Среди них — резистивная память с произвольным доступом (ReRAM), способная посоперничать в быстродействии с обычной DRAM. Компания Weebit Nano объявила об успешном выпуске (tape out) первых чипов с интегрированной памятью ReRAM, выполненных с использованием 22-нм техпроцесса FD-SOI. Данная разработка является плодом сотрудничества компании с французским институтом CEA-Leti.

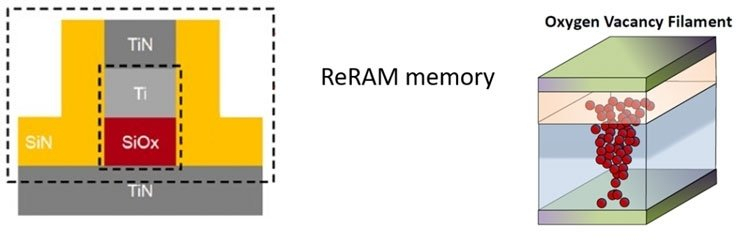

Структура ячейки ReRAM. Виден несколько хаотичный характер токопроводящей нити. Источник здесь и далее: Weebit Nano Это достаточно серьёзный прорыв, поскольку интегрированная флеш-память плохо масштабируется для техпроцессов тоньше 28 нм. Первый модуль Weebit Nano содержит массив ReRAM объёмом 8 Мбит, управляющую логику, декодеры, I/O-блок и систему коррекции ошибок (ECC). За управление отвечает микроконтроллер с архитектурой RISC-V. Чип являет собой законченный демонстратор технологии, содержащий всё необходимое для всестороннего её тестирования и оценки. В запатентованной схемотехнике используются гибридные аналого-цифровые цепи и алгоритмы, улучшающие параметры массива ReRAM. Поскольку в основе самих ячеек такой памяти лежит резистивный эффект, ReRAM нечувствительна к электромагнитным полям и радиации, а также хорошо переносит повышенные температуры и радиационное излучение. За подробностями можно обратиться к самой Weebit Nano.

Блок-схема демонстрационного модуля ReRAM, выпущенного компанией Weebit Nano На фоне гигабитных чипов «традиционной» памяти ёмкость ReRAM в тестовом варианте не выглядит впечатляющей, но, во-первых, это пока демонстрационное решение, а, во-вторых, речь идет о памяти с параметрами, делающими её привлекательной для использования в экономичных встраиваемых системах, работающих в суровой внешней среде — IoT-решениях, в том числе, промышленных, контроллерах сетей 5G или автономном транспорте. Сам факт выпуска таких чипов позволяет говорить о том, что разработчикам удалось решить проблемы с хаотичным образованием токопроводящих нитей в структуре ReRAM, создав структуры с нужными параметрами, поддерживаемыми более совершенными алгоритмами коррекции ошибок. Впрочем, под вопросом остаётся дальнейшее масштабирование технологии, а также то, что Weebit Nano пока ни словом не обмолвилась о массовом производстве.

15.01.2023 [01:54], Алексей Степин

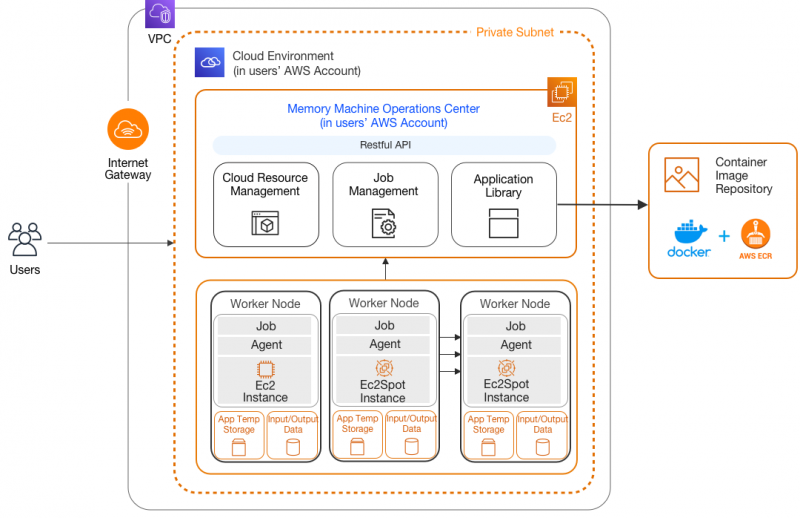

MemVerge наделила Memory Machine поддержкой Sapphire RapidsПроизводители серверного оборудования и разработчики специализированного программного обеспечения один за другим объявляют о поддержке новых процессоров Xeon Sapphire Rapids. Компания MemVerge, известная своей технологией виртуализации массивов памяти Memory Machine, заявила, что её разработка станет первой в своём роде программной платформой для разработки CXL-решений, поддерживающей новые Xeon. Эти процессоры обладают рядом интересных возможностей, делающих их привлекательными в качестве новой серверной платформы. В частности, это поддержка DDR5, PCI Express 5.0, а также наличие специфических ускорителей, в частности, Data Streaming Accelerator (DSA), ускоряющего процессы перемещения данных между ядрами, кешами, подсистемами хранения данных и сетью. С учётом поддержки CXL выбор MemVerge понятен: компания одной из первых поддержала инициативу, разработав унифицированное средство для виртуализации крупных массивов RAM, включая гибридные. Memory Machine позволяет создавать единое когерентное пространство памяти, включающее в себя как локальные ресурсы каждого процессора, так и CXL-экспандеры. Memory Viewer Demo Напомним, что программно-определяемая платформа MemVerge работает полностью прозрачно для пользовательского ПО, вне зависимости от того, использует ли массив памяти из DRAM или же является гибридным и включает в себя CXL-модули. При этом наиболее востребованные данные автоматически размещаются в самом производительном сегменте пула Memory Machine. Также компания объявила о поддержке новых процессоров инструментарием Memory Viewer, помогающего определять наилучшее сочетание цены и производительности при расширении памяти посредством CXL-памяти. Компания не без оснований полагает, что сочетание её технологий и платформы Sapphire Rapids идеально для сценариев HPC, в частности, в генетических исследованиях при секвенировании геномов.

06.01.2023 [15:06], Алексей Степин

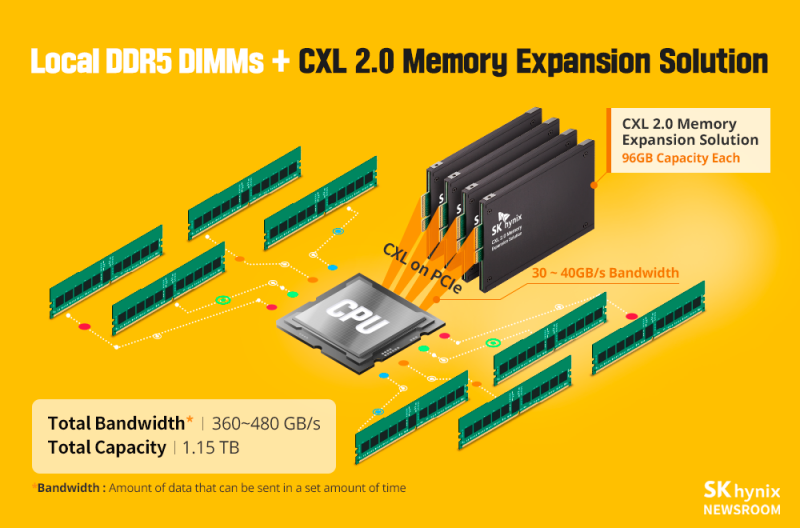

«Небинарные» чипы DDR5 позволят сократить расходы на память в серверах и ЦОДНаращивание объёмов памяти в современных серверных системах может вылиться в серьёзные затраты — от модулей ёмкостью 32 Гбайт приходится переходить сразу к 64-Гбайт модулям или 128-Гбайт. Модулей с промежуточной ёмкостью не существует, вернее, не существовало до недавних пор. Новые чипы DDR5 должны помочь в создании модулей с меньшим шагом: 24, 48, 96 Гбайт или т.д. Это так называемая «небинарная» память. В отличие от обычных DIMM, в основе которых лежат микросхемы DRAM ёмкостью 16 Гбит, в новых модулях DDR5 применяются чипы ёмкостью 24 Гбит. Использование таких чипов позволяет получить и 768 Гбайт на модуль DIMM. К настоящему времени все крупные производители памяти, включая Samsung, SK-Hynix и Micron уже анонсировали «небинарные» чипы DDR5 ёмкостью 24 Гбит, сообщает The Register. У современных серверов стоимость памяти может достигать 14 % от стоимости всего сервера, а в облачных средах даже приближается к 50 %. Но если, например, реальная потребность в памяти составляет 3 Гбайт на поток, то системе с 96-ядерным процессором AMD EPYC 9004 нужно 576 Гбайт памяти. Использование 32-Гбайт модулей в 12 имеющихся каналов даст только 384 Гбайт RAM (недостача 192 Гбайт), а 64-Гбайт — сразу 768 Гбайт (избыток 192 Гбайт). При этом за «ненужные» гигабайты всё равно придётся заплатить. Сокращение числа активных каналов с 12 до 10 может оказаться неприемлемым, как, впрочем, и использование 2DPC (в случае Genoa этого режима пока всё равно нет). А вот модули ёмкостью 48 Гбайт для такой системы окажутся идеальными: не придётся переплачивать за лишнюю память или терять в производительности при сокращении числа активных каналов. Существуют и другие методы решения этой проблемы — например, использование CXL (впрочем, SK hynix уже предлагает 96-Гбайт CXL-модули как раз на базе 24-Гбит чипов DDR5) или процессоров с интегрированной высокоскоростной памятью. Однако ничто не мешает сочетать эти технологии, добиваясь, таким образом, ещё большей гибкости.

14.12.2022 [20:39], Алексей Степин

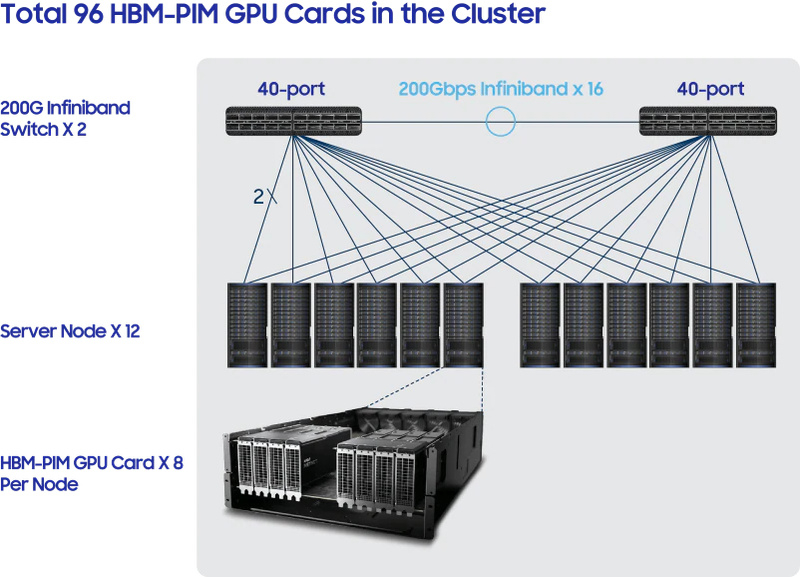

AMD и Samsung создали уникальный экспериментальный ИИ-суперкомпьютер, скрестив «умную» память HBM-PIM и ускорители InstinctКонцепция вычислений в памяти (in-memory computing) имеет ряд преимуществ при построении HPC-систем, и компания Samsung сделала в этой области важный шаг. Впервые на практике южнокорейский гигант совместил в экспериментальном суперкомпьютере свои чипы in-memory с ускорителями AMD Instinct. Согласно заявлениям Samsung, такое сочетание даёт существенный прирост производительности при обучении «тяжёлых» ИИ-моделей. При этом улучшаются и показатели энергоэффективности. Новая система насчитывает 96 ускорителей AMD Instinct MI100, каждый из которых дополнен фирменной памятью HBM-PIM с функциями processing-in-memory. В состав системы входит 12 вычислительных узлов с 8 ускорителями в каждом. Шестёрка узлов связана с другой посредством коммутаторов InfiniBand. Используется 16 линков со скоростью 200 Гбит/с. Здесь и далее источник изображений: Samsung Кластер Samsung нельзя назвать рекордсменом, но результаты получены весьма обнадёживающие: в задаче обучения языковой модели Text-to-Test Transfer Transformer (T5), разработанной Google, использование вычислительной памяти позволило снизить время обучения в 2,5 раза, а потребление энергии при этом сократилось в 2,7 раза.  Технология весьма дружественна к экологии: по словам Samsung, такой кластер с памятью HBM-PIM способен сэкономить 2100 ГВт·час в год, что в пересчёте на «углеродный след» означает снижение выбросов на 960 тыс. т за тот же период. Для поглощения аналогичных объёмов углекислого газа потребовалось бы 10 лет и 16 млн. деревьев. Компания уверена в своей технологии вычислений в памяти и посредством SYCL уже подготовила спецификации, позволяющие разработчикам ПО использовать все преимущества HBM-PIM. Также Samsung активно работает над похожей концепцией PNM (processing-near-memory), которая найдёт своё применение в модулях памяти CXL.

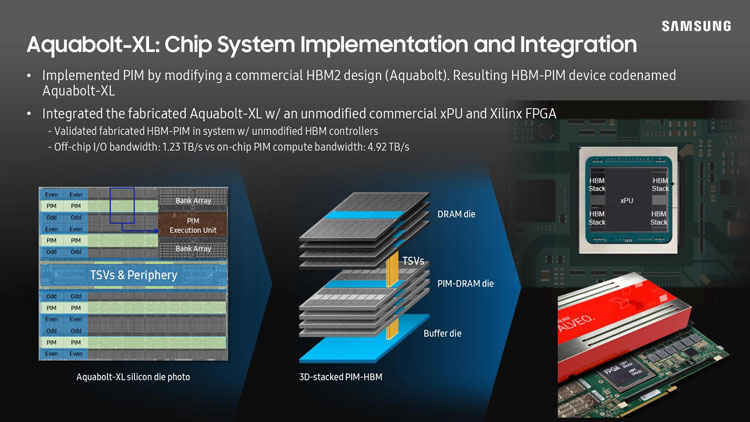

Устройство Samsung HBM-PIM Работы по внедрению PIM и PNM Samsung ведёт давно, ещё на конференции Hot Chips 33 в прошлом году она объявила, что намерена оснастить вычислительными ускорителями все типы памяти — не только HBM2/3, но и DDR4/5. Тогда же впервые был продемонстрирован рабочий образец HBM-PIM, где каждый чип был оснащён ускорителем с FP16-производительностью 1,2 Тфлопс. Таким образом, первая HPC-система с технологией PIM полностью доказала работоспособность концепции вычислений в памяти. Samsung намеревается активно продвигать технологии PIM и PNM как в ИТ-индустрии, так и в академической среде, главном потребителе ресурсов суперкомпьютеров и кластерных систем.

08.12.2022 [16:07], Сергей Карасёв

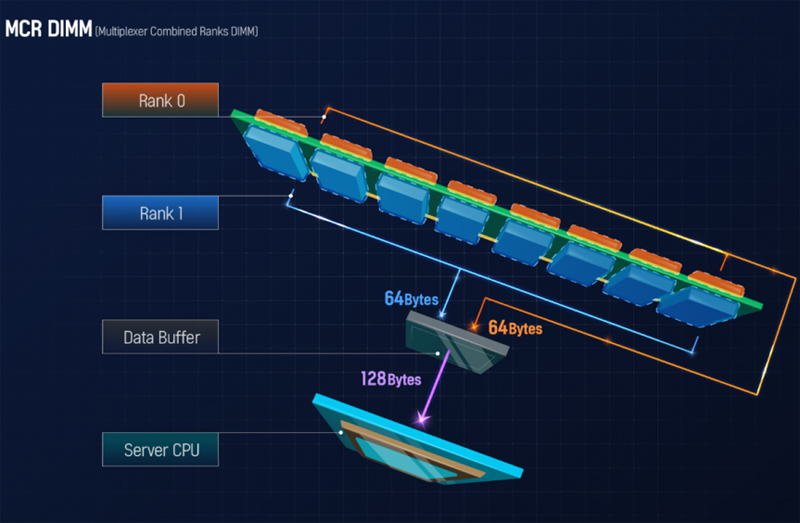

SK hynix представила DDR5 MCR DIMM — самую быструю в мире серверную памятьКомпания SK hynix объявила о создании рабочих образцов памяти DDR5 MCR (Multiplexer Combined Ranks) DIMM: это, как утверждается, самые производительные модули DRAM для серверов на сегодняшний день. Изделия имеют эквивалентную производительность DDR5-8000, что значительно больше по сравнению с широко распространёнными продуктами DDR5-4800. MCR DIMM — двухранговая память, спроектированная совместно со специалистами Intel и Renesas. В модулях обеспечивается одновременное использование двух рангов, для чего служит специальный буфер данных между DRAM и CPU. Данный подход напоминает DDIMM/OMI и FB-DIMM.

Источник изображений: SK hynix Такая архитектура даёт возможность одновременно направлять вдвое больше информации в сторону CPU по сравнению с обычными модулями DRAM. В результате, достигается значительное повышение скорости работы модулей без увеличения быстродействия собственно чипов памяти.

Говорится, что достижение стало возможным благодаря сочетанию опыта SK hynix по проектированию модулей DRAM, передовых технологий Intel, используемых в процессорах Xeon, и буферной технологии Renesas. Для стабильной работы модулей MCR DIMM необходимо согласованное взаимодействие между буфером данных и CPU. SK hynix ожидает, что новая память будет востребована в HPC-сегменте, но сроков начала массового производства не называет.

18.11.2022 [15:26], Сергей Карасёв

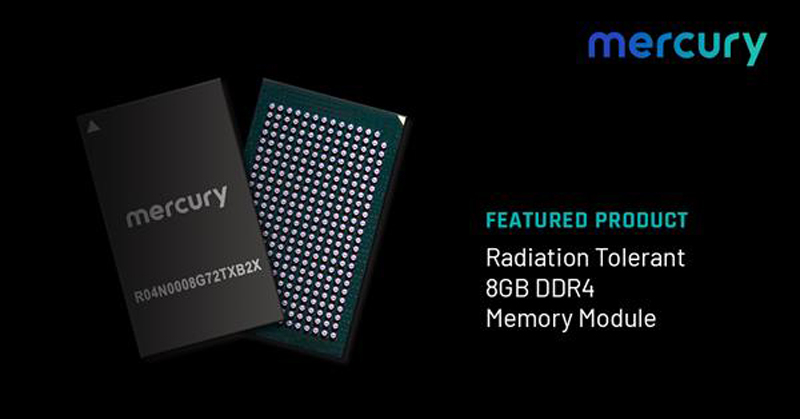

Mercury представила радиационно-устойчивые чипы DDR4 для космической техникиКомпания Mercury Systems объявила о создании новых микрочипов памяти DDR4, рассчитанных на эксплуатацию в самых суровых условиях. Это могут быть пилотируемые и непилотируемые космические корабли, спутники различного назначения, в том числе военные, авиационная техника и пр. Отмечается, что по мере развития космической отрасли растут требования к бортовым вычислительным комплексам. А это, в частности, порождает необходимость в модулях оперативной памяти высокой плотности. Именно такие изделия и анонсировала компания Mercury.

Источник изображения: Mercury Systems Новые чипы DDR4-2666 имеют ёмкость 8 Гбайт. Решения устойчивы к радиации, а диапазон рабочих температур простирается от -55 до +125 °C. Размеры упаковки составляют 13 × 20 × ≤2,36 мм. Память проходит интенсивное тестирование, что гарантирует надёжность и долговечность. Чипы производятся на предприятии, которое имеет аккредитацию категории DMEA (Defense Microelectronics Activity), лаборатории Министерства обороны США. Утверждается, что новые 8-Гбайт DDR4-модули Mercury обеспечивают экономию занимаемого пространства на 75 % по сравнению с альтернативными вариантами памяти. «Модули памяти Mercury предназначены для работы в самых сложных условиях и используются в критически важных системах в воздушной, наземной и морской сферах», — отметил вице-президент и генеральный директор Mercury.

25.10.2022 [14:28], Сергей Карасёв

В OCP сформирована группа Composable Memory Systems для работы над новыми технологиями памятиОрганизация Open Compute Project Foundation (OCP) объявила о создании группы Composable Memory Systems (CMS), участники которой займутся работой над архитектурами памяти для ЦОД следующего поколения. Отмечается, что исследования в рамках нового проекта формально начались ещё в феврале 2021 года, когда была запущена инициатива Future Technologies — Software Defined Memory (SDM). ОСР отмечает, что по мере внедрения технологий ИИ и машинного обучения растёт востребованность систем с большим объёмом памяти, которая играет важную роль в энергопотреблении, производительности и общей стоимости владения ЦОД. Поэтому необходима разработка новых технологий интерконнекта вроде CXL (Compute Express Link). CXL позволяет избавиться от жёсткой привязки к CPU и вывести дезагрегацию ресурсов для повышения эффективности их использования на новый уровень.

Источник изображения: OCP Проект CMS предусматривает использование стратегии совместной разработки аппаратных и программных решений с целью внедрения технологий многоуровневой и гибридной памяти. Инициатива призвана объединить сообщество операторов ЦОД, разработчиков приложений, производителей оборудования и полупроводниковых изделий для создания архитектуры и номенклатуры, которые будут опубликованы группой в качестве части спецификации компонуемой памяти. Кроме того, будут предложены эталонные тесты. К проекту уже присоединились многие члены ОСР, включая Meta✴, Microsoft, Intel, Micron, Samsung, AMD, VMware, Uber, ARM, SMART Modular, Cisco и MemVerge.

23.10.2022 [00:42], Алексей Степин

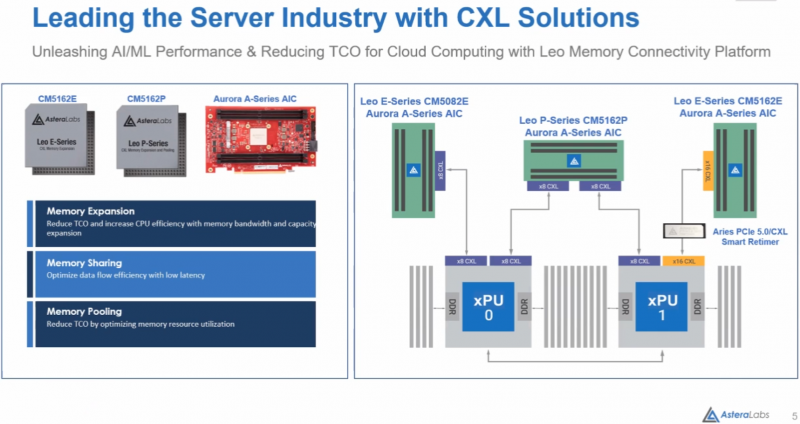

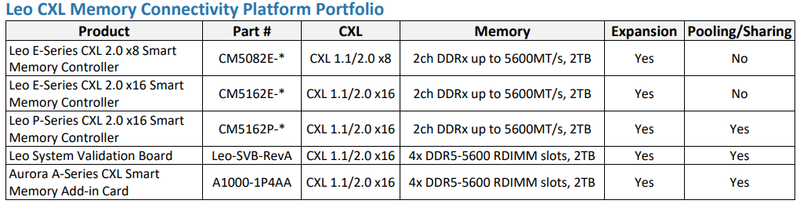

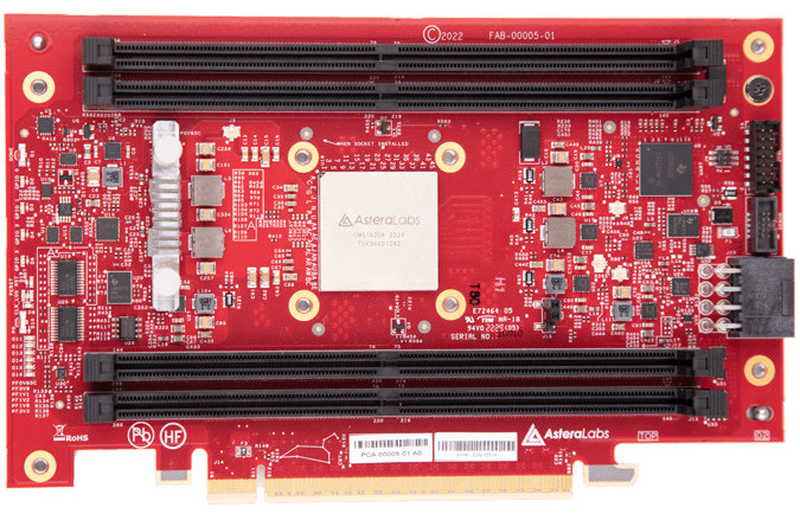

Astera Labs представила портфолио решений для CXL-памятиНа саммите OCP 2022 компанией Astera Labs озвучены любопытные цифры: уже к 2025 году 49% данных и 59% всех серверов в мире будут располагаться в публичных облаках. Серьёзную лепту в этот рост привносит рынок ИИ — размеры моделей удваиваются каждые 3,5 месяца, а в денежном выражении объём этого сектора рынка к тому же 2025 году должен превысить $60 млрд. А помочь в развитии подходящих аппаратных инфраструктур, по мнению Astera Labs, может CXL. Первым достаточно масштабным применением CXL станут системы расширения памяти, которые полезны уже в системах с поддержкой лишь CXL 1.1, тогда как создание пулов DRAM потребует CXK 2.0. Однако у Astera Labs уже есть полноценные ASIC для этих задач — решения серий Leo E и Leo P. Leo E представляет собой экспандер, связующее звено между PCI Express и DDR. На основе этого чипа компания разработала платы расширения Aurora c 8 и 16 линиями CXL на базе чипов CM5082E и CM5162E, соответственно. В отличие от решений некоторых других разработчиков, осваивающих CXL, Astera Labs предлагает не FPGA-реализацию, а полноценную платформу, которую можно использовать в практических целях уже сейчас. В серии Leo наибольший интерес представляет чип CM5162P — это уже не просто мост между процессором, PCIe и банками DRAM на плате расширения, а полноценное решение для пулинга памяти с поддержкой CXL 2.0. Оно включает в себя контроллеры физических уровней CXL 2.0 и JEDEC DDRx, блоки обеспечения функций безопасности и кастомизации. Контроллеры совместимы с любой стандартной памятью со скоростями до 5600 МТ/с.  Плата Aurora на базе CM5162P может использовать физический интерфейс PCIe x16 как два интерфейса CXL x8 и, таким образом, общаться одновременно с обоими процессорами в классическом двухпроцессорном сервере. Максимальный объём пула DRAM составляет 2 Тбайт в четырёх модулях DDR5 RDIMM — солидная прибавка к возможностям контроллеров памяти в CPU.  Кроме того, в арсенале компании есть и подходящие ретаймеры серии Aries, совместимые с PCIe 4.0/5.0 и CXL. Эти чипы поддерживают гибкую бифуркацию шины и соответствуют спецификациям Intel PCIe Standard Retimer Footprint. А возможности интегрированных приёмопередатчиков заведомо превышают минимальные требования PCIe Base Specification, что позволяет создавать на базе Aries действительно разветвлённые системы расширения и пулинга DRAM. Таким образом, Astera Labs уже можно назвать одним из пионеров практического освоения рынка CXL-решений: у компании есть законченное портфолио, включающее в себя всё необходимое, от ASIC и ретаймеров до плат расширения, готовых к использованию в ИИ-платформах и облачных системах.

21.10.2022 [22:28], Сергей Карасёв

TrendForce: темпы роста поставок серверов в 2023 году замедлятсяКомпания TrendForce опубликовала свежий прогноз по мировому рынку серверов и компонентов для них — модулей оперативной памяти DRAM, а также SSD. По мнению аналитиков, в 2023 году отрасль продемонстрирует смешанные результаты, что объясняется сложившейся в мире ситуацией и рядом других факторов. Ожидается, что в следующем году темпы роста отгрузок серверов в глобальном масштабе снизятся до 3,7 % против 5,1 % в 2022-м. TrendForce объясняет это тремя основными причинами. Во-первых, по мере улучшения ситуации с дефицитом чипов и материалов покупатели начали корректировать ранее размещенные заказы на поставку оборудования, поэтому объёмы ODM-заказов сократились. Во-вторых, на фоне инфляции и нестабильной экономической обстановки корпоративные пользователи уменьшают IT-затраты, частично переходя в облака. В-третьих, геополитические изменения создают потребность в небольших ЦОД, тогда как развёртывание дата-центров гиперскейл-класса замедляется. На фоне перехода на аппаратные платформы Intel Xeon Sapphire Rapids и AMD EPYC Genoa, а также использование памяти DDR5, которая на 30–40 % дороже DDR4, увеличится общая стоимость серверов. А поэтому средний установленный объём памяти DRAM в серверах в 2023 году поднимется только на 7 %: данный показатель окажется ниже 10 % впервые с 2016-го. Впрочем, существует вероятность роста на 12 %, если цены на DRAM будут снижаться, а поставщики предложат скидки на 64-Гбайт модули. Что касается SSD, то благодаря уменьшению стоимости NAND-памяти и появлению устройств с PCIe 5.0 средняя вместимость установленных твердотельных накопителей корпоративного класса поднимется на 26,4 %.

16.10.2022 [00:49], Алексей Степин

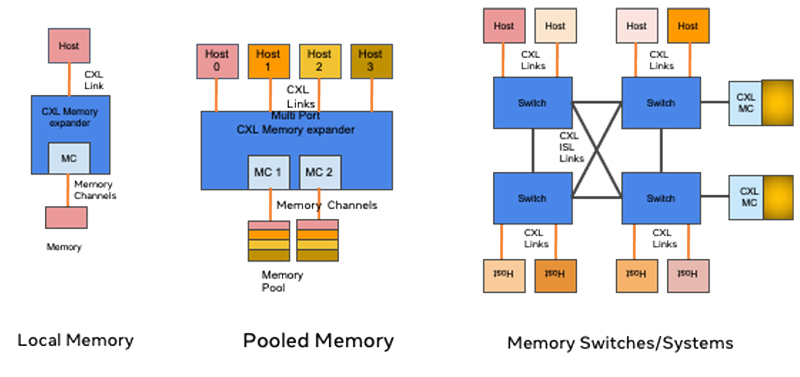

TrendForce: производители памяти сфокусируют свои усилия на создании CXL-экспандеровСогласно опубликованному исследовательской компанией TrendForce отчёту, изначальной целью создания CXL было объединение вычислительных ресурсов различных процессоров, сопроцессоров, ускорителей и иных компонентов с целью оптимизации стоимости «больших» систем, кластеров и суперкомпьютеров. Однако пока поддержка этого стандарта остаётся привязана к CPU. Кроме того, Intel Xeon Sapphire Rapids и AMD EPYC Genoa смогут похвастаться только поддержкой CXL 1.1, тогда как как ряд критически важных особенностей, позволяющих достичь вышеупомянутой цели и значительно расширить спектр возможностей CXL, доступен только в версии CXL 2.0. Поэтому основным продуктом на первой стадии внедрения CXL станут экспандеры оперативной памяти (CXL Memory Expander), считает TrendForce. Чипы для CXL-экспандеров уже производят Montage, Marvell, Microchip и некоторыми другими, поэтому массовое внедрение CXL со временем положительно отразится на их прибыли.

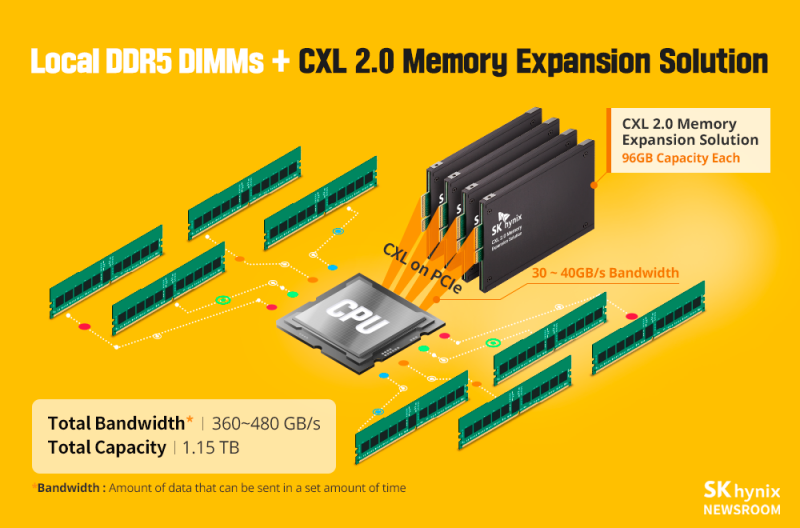

CXL-экспандеры используют PCIe для наращивания объёма памяти. Источник: SK hynix О полноценной дезагрегации, подразумевающей, например, создание выделенных пулов памяти речи в силу ограничений версии 1.1 не идёт. Особой популярности экспандеры памяти в обычных серверах не найдут: если верить исследованию, типовой двухпроцессорный сервер обычно использует 10-12 модулей RDIMM при максимуме в 16 модулей. Таким образом, реальная востребованность CXL-экспандеров сейчас есть на рынке ИИ и HPC, но на общий рынок DRAM это влияние не окажет.

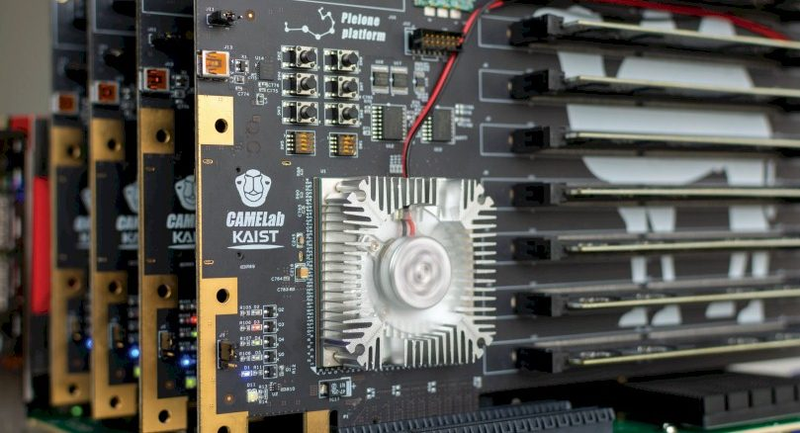

CXL-экспандеры, продемонстрированные Корейским институтом передовых технологий (KAIST). Источник: KAIST/CAMELab Тем не менее, в будущем при распространии CXL-пулинга возможно снижение спроса на модули RDIMM. В настоящее время CXL-экспандеры поддерживают DDR5, но их скорость ограничивается возможностями PCI Express 5.0. Полностью потенциал DDR5 можно будет реализовать лишь с распространением PCIe 6.0. Об этом уже упоминалось в материале, посвящённом анонсу спецификаций CXL 3.0. Со временем, тем не менее, основными потребителями CXL-продуктов, как ожидается станут крупные провайдеры облачных услуг и гиперскейлеры. В итоге, приходят к выводу исследователи TrendForce, внедрение CXL позволит переломить ситуацию со стагнацией производительности серверов, а переход к CXL 2.0 — избавиться от узких мест традиционной архитектуры. Такого рода реформа откроет путь новым, ещё более сложным архитектурам, активно использующим различные сопроцессоры и массивные общие пулы памяти. Это, в свою очередь, поспособствует не только к появлению новых сервисов, но и к снижению TCO. |

|