Материалы по тегу: aws

|

28.11.2023 [22:20], Игорь Осколков

NVIDIA анонсировала суперускоритель GH200 NVL32 и очередной самый мощный в мире ИИ-суперкомпьютер Project CeibaAWS и NVIDIA анонсировали сразу несколько новых совместно разработанных решений для генеративного ИИ. Основным анонсом формально является появление ИИ-облака DGX Cloud в инфраструктуре AWS, вот только облако это отличается от немногочисленных представленных ранее платформ DGX Cloud тем, что оно первом получило гибридные суперчипах GH200 (Grace Hoppper), причём в необычной конфигурации.

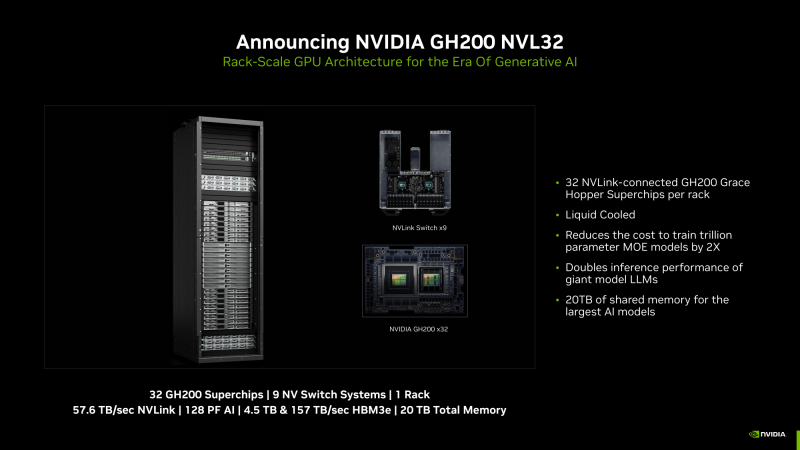

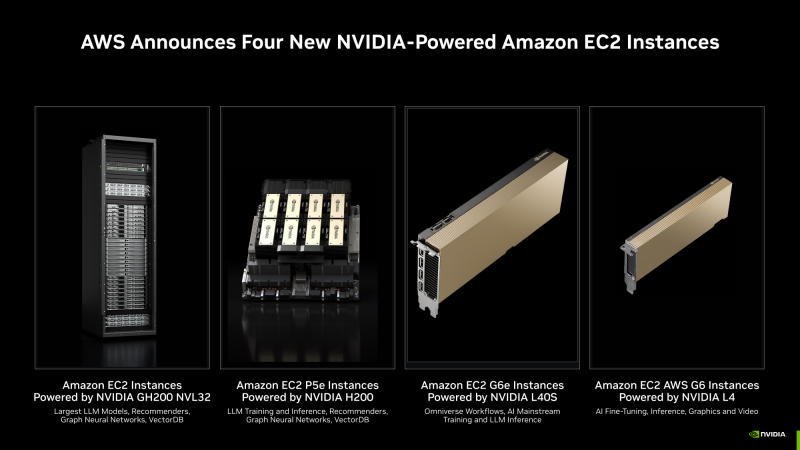

Изображения: NVIDIA В основе AWS DGX Cloud лежит платформа GH200 NVL32, но это уже не какой-нибудь сдвоенный акселератор вроде H100 NVL, а целая, готовая к развёртыванию стойка, включающая сразу 32 ускорителя GH200, провязанных 900-Гбайт/с интерконнектом NVLink. В состав такого суперускорителя входят 9 коммутаторов NVSwitch и 16 двухчиповых узлов с жидкостным охлаждением. По словам NVIDIA, GH200 NVL32 идеально подходит как для обучения, так и для инференса действительно больших LLM с 1 трлн параметров. Простым перемножением количества GH200 на характеристики каждого ускорителя получаются впечатляющие показатели: 128 Пфлопс (FP8), 20 Тбайт оперативной памяти, из которых 4,5 Тбайт приходится на HBM3e с суммарной ПСП 157 Тбайтс, и агрегированная скорость NVLink 57,6 Тбайт/с. И всё это с составе одного EC2-инстанса! Да, новая платформа использует фирменные DPU AWS Nitro и EFA-подключение (400 Гбит/с на каждый GH200). Новые инстансы, пока что безымянные, можно объединять в кластеры EC2 UltraClasters. Одним из таких кластеров станет Project Ceiba, очередной самый мощный в мире ИИ-суперкомпьютер с FP8-производительность 65 Эфлопс, объединяющий сразу 16 384 ускорителя GH200 и имеющий 9,1 Пбайт памяти, а также агрегированную пропускную способность интерконнекта на уровне 410 Тбайт/с (28,8 Тбайт/с NVLink). Он и станет частью облака AWS DGX Cloud, которое будет доступно в начале 2024 года. В скором времени появятся и EC2-инстансы попроще: P5e с NVIDIA H200, G6e с L40S и G6 с L4.

28.11.2023 [16:28], Владимир Мироненко

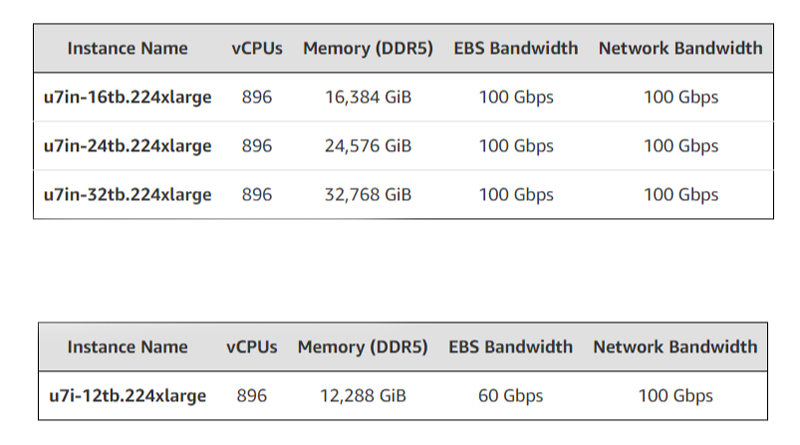

896 vCPU и 32 Тбайт RAM: AWS анонсировала самые крупные инстансы EC2 U7i для in-memory баз данныхОблачная платформа AWS представила инстансы Amazon EC2 U7i, предназначенные для поддержки крупных in-memory СУБД, включая SAP HANA, Oracle и SQL Server. Новые инстансы используют кастомные процессоры Intel Xeon Sapphire Rapids и обеспечивают по сравнению с инстансами EC2 High Memory первого поколения до 125 % большую вычислительную производительность и до 120 % большую производительность памяти. EC2 U7i также обеспечивают в 2,5 раза большую пропускную способность EBS-томов, позволяя наполнять базы данных in-memory со скоростью до 44 Тбайт/час. Инстанс U7i поддерживает подключение до 128 томов EBS gp2/gp3 или io1/io2. Каждый том io2 Block Express может иметь размер до 64 ТиБ и обеспечивать производительность до 256 тыс. IOPS со скоростью до 32 Гбит/с.  Инстансы поддерживают адаптеры ENA Express, обеспечивающем пропускную способность до 25 Гбит/с на каждый сетевой поток. Всего же каждый инстанс может получить 100-Гбит/с подключение для работы с сетью и EBS. Максимальная конфигурация включает 896 vCPU и 32768 ГиБ оперативной памяти. В число поддерживаемых U7i операционных систем входят Red Hat Enterprise Linux и SUSE Enterprise Linux Server. Инстансы U7i в виде превью доступны в регионах US West (Орегон), Азиатско-Тихоокеанском (Сеул) и Европейском (Франкфурт).

28.11.2023 [15:27], Сергей Карасёв

AWS и Kyndril помогут предприятиям во внедрении решений на основе генеративного ИИОблачная платформа Amazon Web Services (AWS) и компания Kyndryl, бывшее подразделение IBM, объявили о заключении многолетнего соглашения о сотрудничестве. Партнёры помогут корпоративным заказчикам в создании и внедрении решений на базе генеративного ИИ и передовых средств машинного обучения. Предполагается, что сотрудничество позволит клиентам AWS и Kyndril ускорить цифровую трансформацию, повысить эффективность работы и задействовать инновационные решения в рамках своего бизнеса.

Источник изображения: pixabay.com По условиям соглашения, Kyndril и AWS создадут площадку Innovation Factory для совместной разработки решений на основе генеративного ИИ и машинного обучения, ориентированных на конкретные сценарии использования. Данная инициатива призвана помочь заказчикам в модернизации облачной стратегии. Кроме того, партнёрство нацелено на расширение возможностей Kyndril по проектированию, внедрению, миграции, улучшению и управлению облачными сервисами AWS в комплексных IT-средах. Стороны помогут ускорить модернизацию систем планирования ресурсов предприятия и других приложений на площадке AWS: это позволит сократить финансовые и временные затраты. Kyndril также сможет увеличить количество своих сотрудников, имеющих сертификаты AWS, что поможет ускорить реализацию проектов по миграции рабочих нагрузок клиентов в облако и по развёртыванию сервисов генеративного ИИ.

27.11.2023 [19:40], Руслан Авдеев

AWS представила тонкий клиент Amazon WorkSpaces Thin Client на базе ТВ-приставки Fire TV CubeКомпания Amazon Web Services (AWS) впервые представила тонкий клиент Amazon WorkSpaces Thin Client — устройства такого рода представляют собой компьютеры с минимумом аппаратных возможностей, с помощью которых можно получать доступ к виртуальным рабочим столам в облаках. До этого у AWS не было собственных решений на рынке тонких клиентов. Компактное устройство подключается к VDI в облаке Amazon. Поддерживается и использование сервиса Amazon WorkSpaces Web, дающего возможность получать доступ к виртуальному рабочему столу непосредственно в браузере. Наконец, тонкий клиент можно интегрировать с сервисом Amazon AppStream. При этом можно использовать AppStream для доступа как ко множеству приложений, так и к единичным. Рабочие файлы не сохраняются локально, поэтому минимизирован риск кражи данных даже в случае хищения самого устройства. Тонкий клиент построен на базе ТВ-приставки Fire TV Cube с восьмиядерным процессором с частотой до 2,2 ГГц, 2 Гбайт RAM, 16 Гбайт постоянной памяти, а также USB- и HDMI-портами, которые оптимизированы для работы с мышью, клавиатурой и монитором, а не телевизором. Устройство продаётся с ОС, прошивкой и ПО, специально разработанными для использования VID. Руководители IT-департаментов смогут легко и централизованно управлять всем парком устройств в AWS Management Console.

Источник изображения: Amazon Новинка стоит $195, а за $280 предлагается комплект с хабом для подключения второго монитора. Продажи ведутся через корпоративный маркетплейс Amazon Business, причём в дальнейшем придётся платить по $6/мес. за обслуживание, мониторинг и поддержку каждого устройства. Amazon WorkSpaces Thin Client уже доступен в США, а в остальных странах он появится в начале 2024 года. Кроме того, консоль для управления парком тонких клиентов пока доступна только в североамериканских и некоторых европейских облачных регионах, а также в Индии.

24.11.2023 [17:17], Сергей Карасёв

AWS всё активнее использует оборотную воду для охлаждения дата-центровОблачная платформа Amazon Web Services (AWS), по сообщению ресурса Datacenter Dynamics, переводит системы охлаждения в своих ЦОД на сточные воды. Технология уже используется примерно на 20 площадках компании, а в перспективе её внедрение расширится. Дата-центры обычно расходуют воду из питьевых источников, которая многократно циркулирует в контурах охлаждения. Из-за накопления бактерий и известкового налёта воду обрабатывают специальными химическими веществами, что делает её непригодной для дальнейшего использования в обычных бытовых целях. Точное количество питьевой воды, используемой индустрией ЦОД, неизвестно, но, по оценкам, оно исчисляется миллиардами литров в год. Новая технология AWS предполагает повторное применение сточных вод, которые проходят трехэтапный процесс очистки: при этом удаляются 99 % всех примесей и бактерий. После того, как такая вода проходит через систему охлаждения, она снова попадает на станцию очистки для прохождения следующего цикла фильтрации.

Источник изображения: AWS На сегодняшний день AWS применят комплекс очистки сточных вод в 16 дата-центрах в Вирджинии и на нескольких объектах в Санта-Кларе (Калифорния). В целом, компания управляет более чем 100 площадками по всему миру, а ещё десятки находятся в разработке. В конце 2022 года AWS заявила о намерении добиться положительного водного баланса к 2030 году: компания будет отдавать больше чистой воды, чем потреблять. Аналогичные инициативы реализуют и другие гиперскейлеры. Так, Google ранее заявляла, что использует очищенную или непитьевую воду более чем в 25 % кампусов ЦОД. Microsoft также пообещала добиться положительного водного баланса к 2030-му: корпорация использует оборотную воду в своих дата-центрах в Сан-Хосе (Калифорния), Куинси (Вашингтон), Техасе и Сингапуре. К концу десятилетия отдавать больше чистой воды, чем расходовать рассчитывает и Meta✴. А европейские дата-центры планируют снизить потребление воды до 400 мл/кВт·ч к 2040 году.

23.11.2023 [01:50], Руслан Авдеев

Amazon задумала обучить 2 млн человек работе с ИИКомпания Amazon Web Services (AWS) представила новую инициативу AI Ready, благодаря которой она намерена привить 2 млн человек навыки работы с искусственным интеллектом (ИИ) к 2025 году. Как сообщает Silicon Angle, компания хочет обеспечить доступ к образованию в сфере ИИ всем, кто желает учиться. У компании уже есть более 80 курсов, связанных с ИИ. В компании уверены, что ИИ стал самой «преобразующей» технологией нынешнего поколения, поэтому AWS намерена раскрыть её полный потенциал для решения самых серьёзных мировых проблем. AWS создаст несколько бесплатных обучающих онлайн-курсов. Три разработаны для обучающихся без опыта программирования, а прочие предназначены для разработчиков. Большинство курсов включают материалы, помогающие ознакомиться с ИИ-сервисами самой AWS.

Источник изображения: Alexandra_Koch/pixabay.com Вводный курс Introduction to Generative Artificial Intelligence даёт представление об основных концепциях генеративного ИИ и сферах его применения. Ещё два курса для новичков связаны с более подробным изучением предмета. Один предназначен для обучения бизнес-лидеров планированию проектов в области генеративного ИИ, второй представляет собой введение в использование сервиса AWS CodeWhisperer, позволяющего писать программы с помощью речевых запросов. Пять курсов для разработчиков обещают углубленное изучение вопроса. Три связаны с коллекцией моделей Amazon Bedrock, сервисом Amazon Transcribe и набором инструментов Amazon SageMaker, которые разработчики смогут применять для создания, запуска и внедрения нейросетей. Ещё два курса для чуть более опытных слушателей посвящены тюнингу запросов к ИИ для получения оптимальных результатов и подготовке данных для обучения и внедрения ИИ-моделей. Кроме того, AWS представит ещё две программы обучения в партнёрстве с Udacity и Code.org. AWS Generative AI Scholarship предоставит стипендии старшеклассникам и студентам на общую сумму более $12 млн и доступ к разработанному AWS курсу на платформе Udacity. А Code.org получит «облачные кредиты» на сумму до $8 млн. Организация будет использовать инфраструктуру AWS для поддержки инициативы Hour of Code, призванной обучить слушателей навыкам программирования. В рамках сотрудничества AWS представит версию Hour of Code с акцентом на ИИ-навыки.

02.11.2023 [01:35], Владимир Мироненко

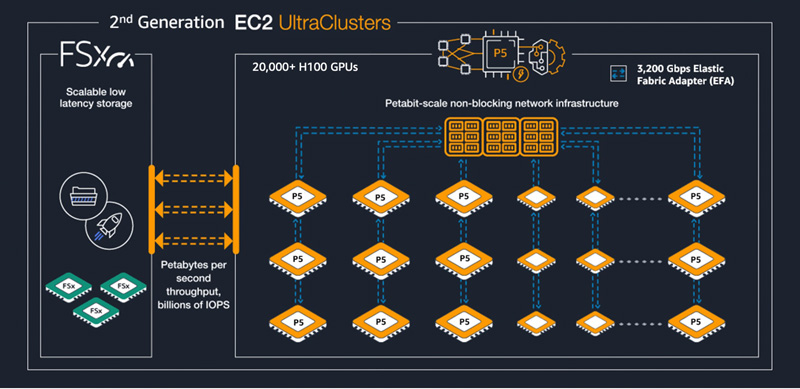

Бронь на ИИ: AWS предложила клиентам заранее заказывать кластеры с ускорителями NVIDIA H100Облачный провайдер Amazon Web Services (AWS) объявил о запуске новой модели потребления EC2 Capacity Blocks for ML, предназначенной для предприятий, желающих зарезервировать доступ к ускорителям вычислений для обработки кратковременных рабочих нагрузок ИИ. Решение Amazon EC2 Capacity Blocks for ML позволяет клиентам зарезервировать доступ к «сотням» ускорителей NVIDIA H100 в кластерах EC2 UltraClusters, которые предназначены для высокопроизводительных рабочих нагрузок машинного обучения. Клиенты просто указывают желаемый размер кластера, дату начала и окончания доступа. Таким образом повышается предсказуемость доступности ИИ-ресурсов и в то же время нет необходимости оплачивать доступ к мощностям, когда они не используются. AWS тоже в выигрыше, поскольку такой подход позволяет более полно использовать имеющиеся ресурсы.

Источник изображения: AWS В рамках EC2 Capacity Blocks предлагаются кластеры, включающие от 1 до 64 инстансов EC2 P5 с подключением на базе Elastic Fabric Adapter (EFA) второго поколения. Кластеры можно зарезервировать на срок от 1 до 14 дней, но не позднее чем за восемь недель до начала использования. Это делает их идеальными для обучения и тюнинга ИИ-моделей, краткосрочных экспериментов или для обработки пикового потока запросов, например, при запуске нового продукта, сообщила AWS. Хольгер Мюллер (Holger Mueller), аналитик компании Constellation Research Inc., отметил, что креативный подход AWS позволяет максимизировать эффективность имеющихся ресурсов ускорителей, которые сейчас пользуются пиковым спросом, а доступ к ним обходится дорого. По его словам, подход заимствован из эпохи мейнфреймов, и впервые был использован ещё в 1970-х годах, когда доступ распределялся по времени между сотнями пользователей с различными рабочими нагрузками. Клиенты могут использовать консоль AWS, CLI или SDK, чтобы найти и зарезервировать доступные кластеры. При использовании EC2 Capacity Blocks клиенты платят только за то время, которое они зарезервировали. Решение доступно в регионе AWS Восток США (Огайо). В дальнейшем число регионов и локальных зон AWS с доступностью этого решения будет расширено.

27.10.2023 [22:07], Владимир Мироненко

Рост выручки AWS в III квартале оказался ниже, чем у конкурентовAmazon объявила результаты III квартала 2023 года, завершившегося 30 сентября. Выручка компании за квартал выросла на 13 % до $143,1 млрд в годовом исчислении, превысив консенсус-прогноз аналитиков, опрошенных LSEG, равный $141,4 млрд. Чистая прибыль Amazon выросла более чем в три раза, составив $9,9 млрд или $0,94 на разводнённую акцию, тогда как годом ранее была равна $2,9 млрд ($0,28 на разводнённую акцию). Прогноз аналитиков равнялся $0,59 на разводнённую акцию. Показатель чистой прибыли включает и прибыль в размере около $1,2 млрд, связанную с инвестициями в производителя электромобилей Rivian Automotive Inc. В III квартале 2022 года прибыль компании от инвестиций составила $1,1 млрд. В IV квартале Amazon ожидает выручку в пределах от $160 до $167 млрд, то есть средний показатель ниже прогноза аналитиков Уолл-стрит в размере $166,6 млрд. Прогноз компании предполагает рост выручки на 9,6 % в годовом исчислении.

Источник изображения: AWS В III квартале облачное подразделение Amazon Web Services (AWS) не оправдало ожиданий: его выручка увеличилась на 12 %, составив $23,1 млрд, что ниже прогноза в $23,2 млрд. Это вызвало опасения у инвесторов по поводу того, что AWS теряет долю рынка в пользу конкурентов в лице Microsoft Azure и Google Cloud, объявивших о росте выручки на 29 и 22 % соответственно. Замедление темпов роста выручки финансовый директор Amazon Брайан Олсавски (Brian Olsavsky) объяснил тем, что клиенты по-прежнему занимаются «оптимизацией затрат», хотя, по его словам, этот процесс происходит уже не так активно, как раньше. Джим Хэйр (Jim Hare), вице-президент Gartner Inc., заявил, что эти цифры следует рассматривать в контексте текущего положения компаний. «Рост Google Cloud на 22 % основан на гораздо меньшем доходе, чем у AWS, — сказал он. — И хотя Microsoft объявила, что выручка Azure за квартал выросла на 29 %, она не приводит никаких цифр в долларах, поэтому сравнивать сопоставимые вещи сложнее». Генеральный директор AWS Энди Джесси (Andy Jassy) с оптимизмом смотрит на перспективы облачного подразделения, заявив, что «темп и объём закрытых сделок» сейчас набирают обороты: в сентябре компанией был подписан ряд крупных сделок, что отразится на результатах за IV квартал. Из-за позднего вступления в маркетинговую войну в области генеративного ИИ и явного лидерства Microsoft Azure в этом направлении AWS агрессивно пытается наверстать упущенное. Поскольку предприятия в разных секторах стремятся расширить использование ИИ-решений, основное внимание AWS будет уделять производственным нагрузкам. Инвестиции в инструменты ИИ, инфраструктуру и партнёрские отношения выгодно выделяют компанию среди конкурентов, отмечает SiliconANGLE. Например, AWS запустила сервис Bedrock, предлагающий доступ к базовым моделям (FM) как от Amazon, так и от ведущих провайдеров. Adidas, Booking.com, GoDaddy и др. уже начали использовать AWS для задач генеративного ИИ.

26.10.2023 [21:00], Руслан Авдеев

Amazon смогли заставить снизить громкость ЦОД после длительных протестов в ВирджинииАктивистам жилого района Грейт Оак (Great Oak), расположенного в пригороде Манассаса в штате Вирджиния (США), удалось добиться почти невозможного — как сообщает Datacenter Knowledge со ссылкой на местные СМИ, после длительных протестов Amazon была вынуждена потратить солидную сумму на разработку системы подавления гула, издававшегося системами вентиляции принадлежащих компании ЦОД. Нюанс в том, что ещё в 1989 году местные власти отказались от регулирования уровня шума промышленных систем кондиционирования, что вкупе с налоговыми льготами привлекло операторов ЦОД. По словам активистов, чтобы Amazon согласилась на переговоры, потребовались немалые усилия и обращение в СМИ. Первоначальные попытки Amazon заглушить шум не имели значимого успеха. Тем не менее, оказалось, что при желании дата-центры всегда можно сделать менее шумными, что бы ни говорил их оператор. В итоге громкость ЦОД Amazon удалось снизить на 10 дБ. Впрочем, жители продолжают жаловаться на металлический визг, предположительно из другого источника. В середине мая 2022 года жители пожаловались полиции на шум свежепостроенных ЦОД, поскольку громкость явно не соответствовала нормам округа. Причём ночью шум только усиливался, достигая 65 дБ. На шум, не дающий возможности заснуть, и возникшие проблемы со здоровьем жаловались и другие жители. Им пришлось звукоизолировать дома и нести иные траты, а некоторые начали задумываться о переезде. К концу мая наблюдательный совет округа связался с руководством Amazon, но в итоге переговоры с участием экспертов с обеих сторон растянулись более чем на год. Несмотря на противодействие Amazon, выяснилось, что проблема связана с системой воздушного охлаждения, включающей сотни вентиляционных труб с вентиляторами, расположенных на крышах зданий. Сначала в компании попытались заглушить шум с помощью ватных одеял, но когда у них ничего не вышло, Amazon обратилась к инженерам и в итоге создала более эффективную систему — воздуховоды удлинили на метр, а вентиляторы внутри заставили вращаться более медленно и синхронно. На работы ушло четыре месяца, но в результате уровень шума немедленно упал на 10 дБ, приблизительно до 50 дБ, что считается допустимым в данных условиях. Хотя в Amazon не уточнили стоимость проекта, по некоторым оценкам, основанным на неформальных беседах с представителями AWS, его реализация обошлась в $30 млн. Впрочем, сохраняется неприятный визг, исходящий из вентиляционных проёмов на стенах зданий. Не исключено, что он вызван вентиляторами вычислительного оборудования. Amazon обещает устранить и эту проблему, но тревога не покидает жителей Грейт Оак — скоро по соседству появятся новые ЦОД. Сама Amazon уже потратила $35 млрд на дата-центры в штате и собирается вложить ещё столько же.

25.10.2023 [22:43], Владимир Мироненко

Amazon анонсировала суверенное облако для ЕвропыAmazon объявила о предстоящем запуске независимого облака для Европы под названием AWS European Sovereign Cloud, предназначенного для госпредприятий, а также компаний из отраслей с жёсткими нормами регулирования оборота и конфиденциальности данных. Сервис разработан в соответствии с требованиями ЕС к локализации данных и нормативными документам, касающимися регулирования его деятельности. Новая структура будет физически и логически отделена от существующих регионов, но вместе с тем предоставляет клиентам уже знакомую функциональность облака AWS. Контроль над операциями и поддержкой AWS European Sovereign Cloud будут осуществлять только те сотрудники, которые проживают в ЕС.

Источник изображения: Pixabay Заказчики также смогут использовать другие сервисы, такие как AWS Outposts или выделенные локальные зоны AWS, для развёртывания своей европейской облачной инфраструктуры. Amazon сообщила что, AWS European Sovereign Cloud будет иметь несколько зон доступности с географически разнесённоё инфраструктурой. Первый регион появится в Германии. Ранее о запуске суверенного облачного сервиса EU Sovereign Cloud, предназначенного для Европейского союза (ЕС), объявила Oracle. В 2022 году Microsoft запустила сервис Cloud for Sovereignty, нацеленный на госсектор в ЕС, а Google Cloud предоставляет аналогичные решения в партнёрстве с местными игроками, например, T-Systems и Thales. Примечательно, что ранее AWS называла суверенное облако «маркетинговым термином больше, чем что-либо ещё». |

|