Материалы по тегу: llm

|

07.03.2024 [14:12], Владимир Мироненко

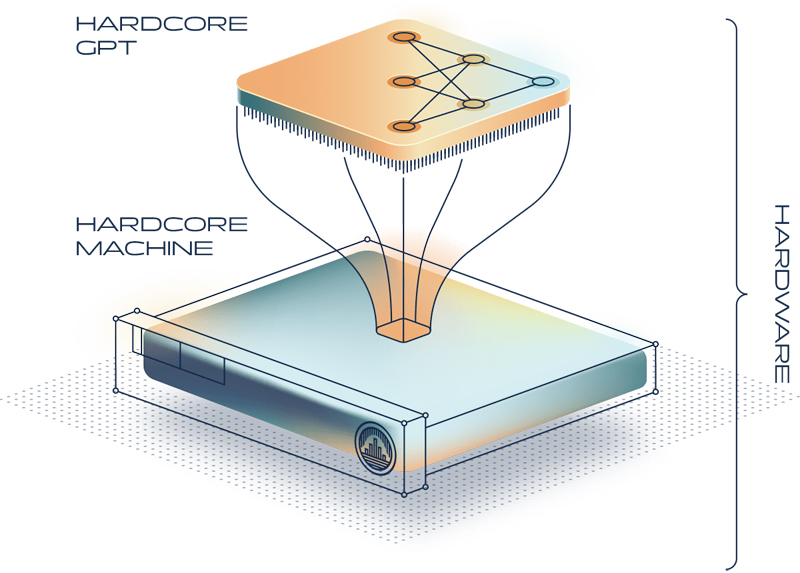

Индивидуальный подход: разработчик специализированных ИИ-чипов Taalas привлёк $50 млн инвестицийСтартап Taalas Inc., занимающийся разработкой специализированных чипов ИИ, объявил о выходе из скрытого режима (stealth mode) и привлечении $50 млн инвестиций в ходе двух раундов финансирования, которые возглавили Quiet Capital и венчурный капиталист Пьер Ламонд (Pierre Lamond). Taalas была основана выходцами из Tenstorrent, ещё одного разработчика ИИ-ускорителей. Практически все чипы ИИ оптимизированы для ускорения перемножения матриц, что необходимо для работы нейронных сетей, отметил ресурс SiliconANGLE. Некоторые чипы имеют дополнительные оптимизации, ориентированные на конкретные случаи использования ИИ. Например, ИИ-ускоритель NVIDIA H200 оснащён увеличенным объёмом высокоскоростной памяти для ускорения инференса больших языковых моделей (LLM). Taalas занимается дальнейшим развитием этой концепции. Как сообщил ресурс The Information, компания разрабатывает ускорители, которые не просто оптимизированы для обработки ИИ-нагрузок, а построены с учётом требований конкретной нейронной сети. Компания считает, что такой подход сделает её чипы значительно быстрее, чем ИИ-ускорители общего назначения от ведущих производителей.

Источник изображения: Taalas «Коммерческое использование ИИ требует 1000-кратного улучшения вычислительной мощности и эффективности — цель, которая недостижима с помощью нынешних поэтапных подходов, — заявил Любиша Бажич (Ljubisa Bajic), сооснователь и гендиректор Taalas. — Путь вперёд — реализовать внедрение моделей глубокого обучения в кремнии — это самый верный путь к устойчивому ИИ». Разработка собственного ускорителя может занять годы и потребовать сотни миллионов долларов инвестиций. Также создание чипов, оптимизированных для разных алгоритмов искусственного интеллекта, вероятно, будет сопряжено с серьезными техническими проблемами. С целью их решения компания разрабатывает автоматизированный рабочий процесс проектирования, который, по её словам, позволит ускорить вывод полупроводников на рынок. Один из разрабатываемых Taalas чипов будет содержать достаточно памяти для хранения «большой модели ИИ» без надобности во внешней оперативной памяти, что позволит ускорить обработку данных. Taalas планирует выпустить свой первый чип для больших языковых моделей в III квартале 2024 года и начать его поставку клиентам в I квартале 2025 года.

05.03.2024 [16:24], Владимир Мироненко

Forrester прогнозирует перемены во внедрении генеративного ИИ предприятиямиКомпания Forrester опубликовала исследование «The State Of Generative AI, 2024», посвящённое рынку ИИ в 2024 году с оценкой текущего состояния технологии генеративного ИИ c точки зрения спроса и предложения и её развёртывания. Также компания сообщила о грядущих переменах на рынке и указала факторы, которые предприятиям следует учитывать при подготовке к внедрению этой технологии. Аналитики отметили, что в отношении этой технологии по-прежнему широко распространена путаница и непонимание. И многочисленные объявления о новых партнёрствах, функциях, сервисах и продуктах, связанных с генеративным ИИ, эту путаницу лишь усиливают. Как сообщается, в сфере разработки больших языковых моделей (LLM) доминируют небольшое количество ведущих технологических компаний, поскольку создание фундаментальных моделей требует значительных инвестиций, многих лет разработки и инфраструктуры стоимостью миллионы долларов. Впрочем, на рынке присутствуют и небольшие компании, но это не повлияет на доминирование крупных игроков, по крайней мере, в ближайшем будущем. Согласно данным Forrester, более 90 % лиц, принимающих решения в области ИИ по всему миру, планируют внедрить генеративный ИИ для обслуживания клиентов и внутренних запросов. Что касается использования технологии в производстве, то её применение пока ограничено предприятиями высокого уровня. Компании возлагают большие надежды на технологию, при этом главными целями называются рост производительности, инновации и экономическая эффективность. Однако компаниям необходимо точно определить конечный результат своих инвестиций в генеративный ИИ, что приводит к более осторожному подходу при запуске внутренних сценариев использования с постепенным переходом к клиентским и другим внешним приложениям. Согласно опросу Forrester, широкому внедрению генеративного ИИ по-прежнему препятствует отсутствие навыков работы с ИИ (30 % респондентов), трудности с интеграцией технологии с существующей инфраструктурой (28 %), а также проблемы безопасности и конфиденциальности данных (28 %). Прежде чем ускорить внедрение генеративного ИИ, многие организации ждут, пока будет принята соответствующая нормативно-правовая база и появится больше ясности в отношении актуальности базовых моделей для их конкретных отраслей. Следует отметить, что технология генеративного ИИ по-прежнему не лишена недостатков, включая предвзятость и галлюцинации. Области, где уже нашли применение возможностям ИИ, включают повышение производительности сотрудников, поддержку клиентов и разработку ПО. Здесь ИИ, в частности, позволяет автоматизировать повторяющиеся задачи для оптимизации рабочих процессов. Исходя из данных, полученных в ходе исследования, Forester рекомендовала установить руководящие принципы и политику использования собственного ИИ (BYOAI). Поскольку большая часть ИИ, используемого в компаниях, создаётся сторонними поставщиками, необходимо задать стандарты для оценки генеративного ИИ в решениях поставщиков. Forrester также рекомендует руководителям сосредоточиться на приложениях, которые уже доказали свою эффективность. Кроме того, поскольку технология генеративного ИИ становится всё более сложной, компании должны подготовиться к обновлению своей стратегии ИИ с учётом новых стандартов и ограничений.

29.02.2024 [23:59], Владимир Мироненко

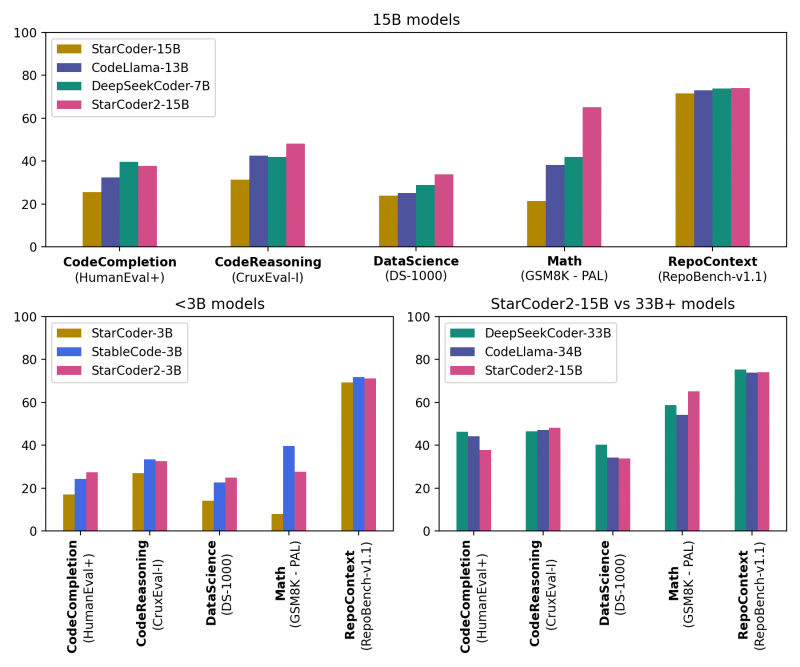

ServiceNow, Hugging Face и NVIDIA представили новое поколение ИИ-моделей StarCoder2 для генерации кодаКомпании ServiceNow, Hugging Face и NVIDIA представили семейство общедоступных больших языковых моделей (LLM) StarCoder2 для генерации кода, призванное помочь разработчикам использовать генеративный ИИ для создания корпоративных приложений. Семейство было разработано NVIDIA в сотрудничестве с исследовательским проектом BigCode, которым управляет ServiceNow, и Hugging Face, разработчиком открытой LLM-платформы. Модели StarCoder2 обучены 619 языкам программирования и могут быть дообучены на собственных данных и встроены в корпоративные приложения для выполнения специализированных задач, таких как генерация кода, управление рабочими процессами, обобщение текста и многое другое. Разработчики могут использовать автодополнение и обобщение кода, извлечение фрагментов кода и другие возможности. Набор StarCoder2 включает три модели: модель с 3 млрд параметров, обученная ServiceNow; модель с 7 млрд параметров, обученная Hugging Face; и модель с 15 млрд параметров, созданная NVIDIA с помощью NVIDIA NeMo. Варианты моделей с меньшим количеством параметров менее требовательны к вычислительной инфраструктуре, при этом модель StarCoder2 с 3 млрд параметров соответствует производительности исходной модели StarCoder с 15 млрд. параметров В основе StarCoder2 лежит новый набор данных Stack v2, который более чем в 7 раз больше, чем Stack v1. Кроме того, новые модели обучены работе с малораспространёнными языками вроде COBOL, «понимают» математику и могут обсуждать исходный код программ. Пользователи могут дообучить и настроить модели StarCoder2, используя данные, специфичные для отрасли или организации, с помощью NVIDIA NeMo или Hugging Face TRL. Разработчики смогут создавать продвинутых чат-ботов для решения более сложных задач обобщения или классификации и разрабатывать персонализированных помощников по программированию. Разработка ПО стала основной областью использования ИИ, чему отчасти способствовали такие инструменты как GitHub Copilot и AWS CodeWhisperer, отметил ресурс SiliconANGLE. Согласно недавнему опросу GitHub, 91 % разработчиков в США используют ИИ-инструменты для создания кода. Впрочем, опрос, проведённый CoderPad Inc., показал, что почти четверть разработчиков скептически относятся к ценности ИИ в работе, а 28 % и вовсе заявили, что их работодатель запрещает им пользоваться ИИ-инструментами. В числе причин негативного отношения — опасения, что ИИ-помощники создают неэффективный или уязвимый код, а также крадут интеллектуальную собственность, генерируя код на основе материалов, защищённых авторским правом, которые использовались при обучении модели. Создатели StarCoder2 подчёркивают, что модели были созданы с использованием данных Software Heritage, крупнейшей, по их словам, общедоступной коллекцию исходных кодов. В целях дальнейшего повышения прозрачности и сотрудничества вспомогательный код модели будет по-прежнему размещаться на странице проекта BigCode на GitHub. Он доступен по лицензии BigCode OpenRAIL-M, обеспечивающей бесплатный доступ и использование. Все модели StarCoder2 также будут доступны для загрузки с Hugging Face, а модель StarCoder2 с 15 млрд параметров доступна в составе NVIDIA AI Foundation.

29.02.2024 [13:01], Владимир Мироненко

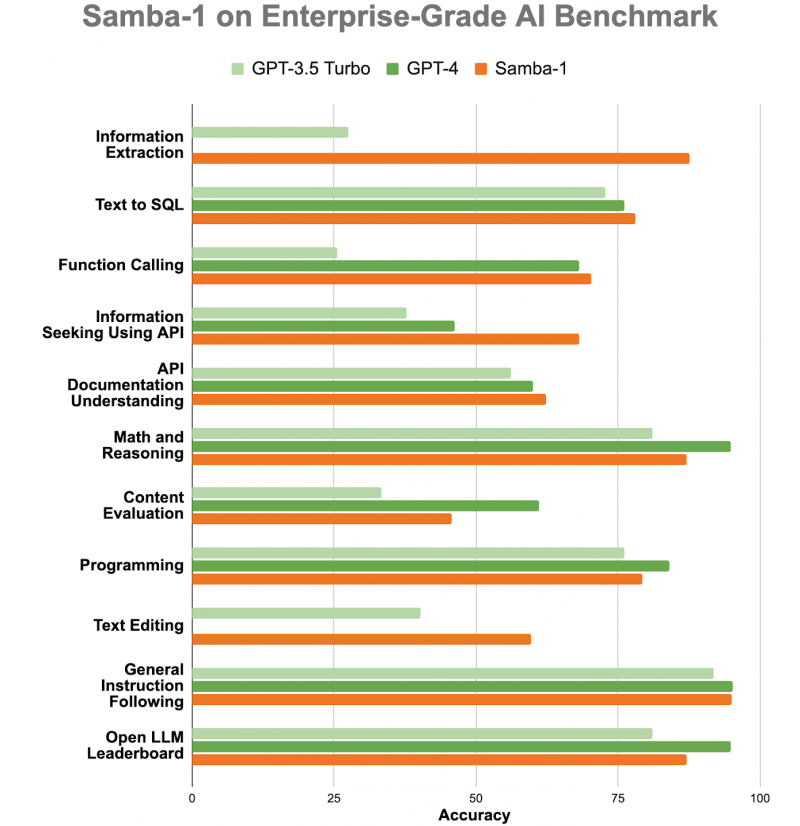

ИИ-консилиум: корпоративная LLM Samba-1 c 1 трлн параметров объединила более 50 открытых моделейСтартап SambaNova Systems представил Samba-1, модель генеративного ИИ с 1 трлн параметров, предназначенную для использования предприятиями. SambaNova описывает новую модель как «объединение экспертных архитектур» (Composition of Experts, CoE), которое включает более 50 открытых моделей генеративного ИИ высочайшего качества, в том числе Llama2 7B/13B/70B, Mistral 7B, DeepSeek Coder 1.3B/6.7B/33B, Falcon 40B, DePlot, CLIP, Llava. В частности, Llama 2 может генерировать текст, создавать программный код и решать математические задачи. Есть и более специализированные LLM, такие как DePlot от Google, которая может вводить информацию из диаграмм и других визуализаций данных в электронную таблицу. Samba-1 уже используется клиентами и партнёрами SambaNova, включая Accenture и NetApp. SambaNova позиционирует Samba-1 как первую модель с 1 трлн параметров для предприятий с регулируемой деятельностью, которая является приватной, безопасной и на порядок более эффективной, чем любая другая модель такого размера. Заказчик может установить контроль доступа к данным для отдельных пользователей. Желающие могут ознакомиться с работой модели. По словам главы SambaNova, Samba-1 оптимизирована для работы с чипом SN40L, выпущенным стартапом прошлой осенью. «Samba-1 способна конкурировать с GPT-4, но она лучше подходит для предприятий, поскольку её можно развернуть как локально, так и в частном облаке, чтобы клиенты могли точно настроить модель с использованием своих личных данных, не отдавая их в открытый доступ», — добавил он. SambaNova утверждает, что инференс этой модели обходится в десять раз дешевле, чем для конкурирующих LLM. Получив запрос, Samba-1 решает, какая из её внутренних моделей лучше всего приспособлена для его обработки, и поручает ей сгенерировать ответ. То есть активируется только одна из относительно небольших моделей, тогда как традиционные монолитные LLM требуют активации целиком. Стартап SambaNova привлёк около $1 млрд инвестиций от ряда компаний, включая Intel Capital и GV (инвестиционное подразделение Alphabet Inc). По итогам раунда финансирования в начале 2021 года рыночная стоимость стартапа оценивается в более чем $5 млрд.

28.02.2024 [13:10], Сергей Карасёв

ИИ-модели Mistral AI появятся на платформе Microsoft AzureКорпорация Microsoft объявила о заключении многолетнего партнёрского соглашения с французской компанией Mistral AI, которая специализируется на технологиях ИИ и разработке больших языковых моделей (LLM). В рамках договора Microsoft приобретёт небольшую долю в этом стартапе, оцениваемом приблизительно в €2 млрд. Сообщается, что Mistral AI сделает свои LLM доступными через облачную инфраструктуру Microsoft Azure. Речь, в частности, идёт о новой модели общего назначения Mistral Large. Она поддерживает французский, немецкий, испанский, итальянский и английский языки. Стороны намерены сотрудничать по трём ключевым направлениям. Одно из них — использование суперкомпьютерной инфраструктуры: Microsoft будет поддерживать Mistral AI с помощью платформы Azure AI, которая, как утверждается, обеспечивает «лучшую в своём классе производительность и масштабируемость» для обучения ИИ и задач инференса. Вторым направлением является вывод моделей Mistral AI на коммерческий рынок: доступ к LLM будет предоставляться по схеме MaaS (модель как услуга) на базе Azure AI Studio и Azure Machine Learning. Кроме того, Microsoft и Mistral AI намерены вести совместные исследования и разработки в области ИИ.

Источник изображения: pixabay.com «Мы очень рады начать партнёрские отношения с Microsoft. Благодаря передовой ИИ-инфраструктуре Azure мы достигнем новой вехи в развитии бизнеса и продвижении передовых решений», — сказал Артур Менш (Arthur Mensch), генеральный директор Mistral AI. Microsoft, которая вкладывает миллиарды долларов в компанию OpenAI, разработчика ИИ-бота ChatGPT, намерена инвестировать в Mistral AI около €15 млн. Это соглашение уже привлекло внимание со стороны Европейской комиссии. Антимонопольный регулятор ЕС хочет проверить условия сделки и оценивать её возможное влияние на рынок.

26.02.2024 [23:34], Владимир Мироненко

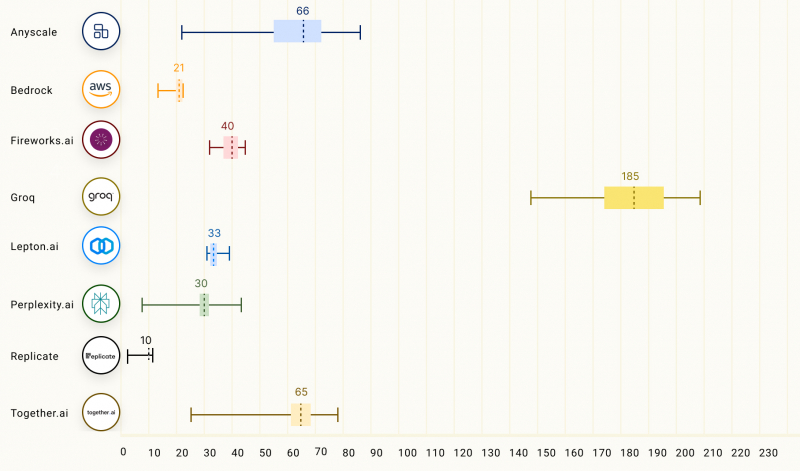

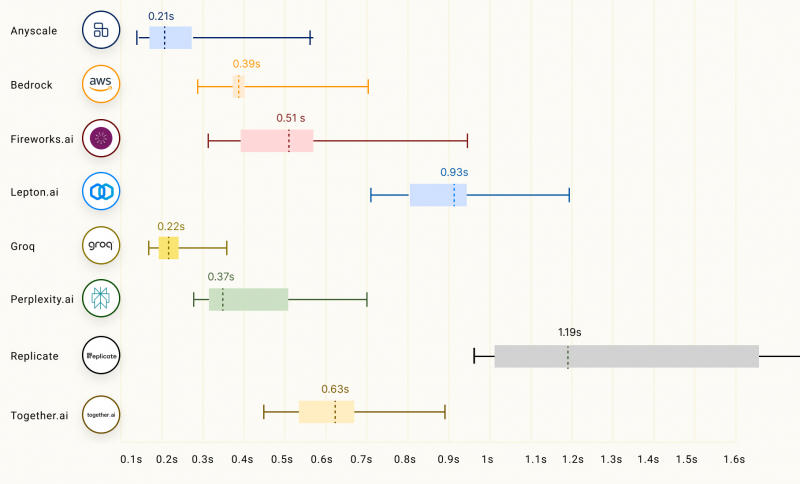

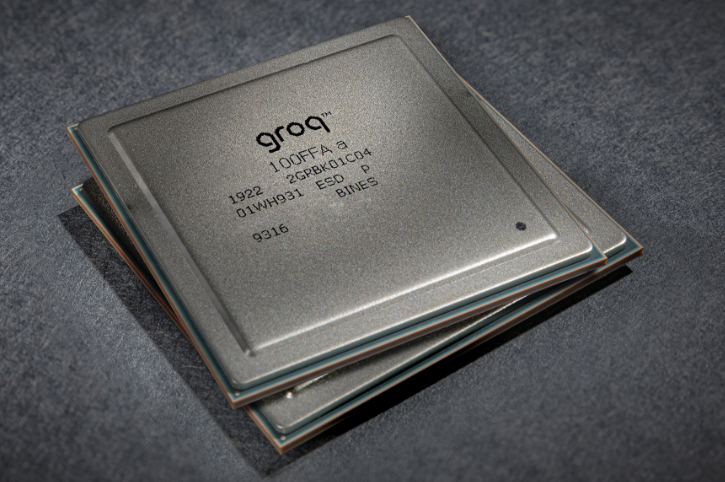

Groq LPU способен успешно конкурировать с ускорителями NVIDIA, AMD и IntelСтартап Groq сообщил о значительных достижениях в области инференса с использованием ускорителя LPU, разработанного для запуска больших языковых моделей (LLM), таких как GPT, Llama и Mistral. Groq LPU имеет один массивно-параллельный тензорный процессор TSP, который обеспечивает производительность до 750 TOPS INT8 и до 188 Тфлопс FP16. LPU Groq оснащён локальной SRAM объемом 230 Мбайт с пропускной способностью 80 Тбайт/с. Как сообщает компания, при запуске модели Mixtral 8x7B ускоритель LPU обеспечил скорость инференса 480 токенов в секунду, что является одним из ведущих показателей инференса в отрасли. В таких моделях, как Llama 2 70B с длиной контекста 4096 токенов, Groq может обеспечить скорость инференса 300 токенов/с, тогда как в меньшей модели Llama 2 7B с 2048 токенами контекста скорость инференса составляет 750 токенов/с.

Изображение: Groq Согласно рейтингу бенчмарка LLMPerf, LPU Groq превосходит результаты систем облачных провайдеров на базе традиционных ИИ-ускорителей в деле запуска LLM Llama в конфигурациях от 7 до 70 млрд параметров. Groq лидирует по скорости инференса и занимает второе место по показателю задержки. Для сравнения, бесплатный чат-бот ChatGPT на базе GPT-3.5 обеспечивает обработку около 40 токенов/с. Текущие LLM с открытым исходным кодом, такие как Mixtral 8x7B, могут превосходить GPT 3.5 в большинстве тестов, и теперь могут работать со скоростью почти 500 токенов/с. Опубликованные данные наглядно подтверждают, что предлагаемый Groq ускоритель LPU Groq значительно превосходит системы для инференса, предлагаемые NVIDIA, AMD и Intel, говорит компания. Groq не раскрывает имена своих заказчиков, но в настоящее время её ИИ-решения используются, например, Аргоннской национальной лабораторией Министерства энергетики США.

22.02.2024 [01:25], Владимир Мироненко

ИИ для защиты 5G: Nokia представила ассистента Telco GenAI, который поможет быстро выявить и нейтрализовать атаки на сети связиКомпания Nokia объявила о выходе телекоммуникационного ассистента на базе генеративного ИИ Telco GenAI, который будет интегрирован с облачным SaaS-решением для сетевой безопасности NetGuard Cybersecurity Dome, чтобы предоставить поставщикам услуг связи (CSP) и предприятиям возможность более быстрого и качественного обнаружения и разрешения проблем в условиях, когда киберпреступники всё чаще используют генеративный ИИ для более сложных атак на критическую инфраструктуру. NetGuard Cybersecurity Dome — это XDR-платформа Nokia, которая обеспечивает защиту сетей с помощью ИИ и машинного обучения. Nokia Telco GenAI будет интегрирован в платформу уже во II квартале. Он позволит ещё больше расширить возможности Cybersecurity Dome, быстро объединяя и интерпретируя огромные объёмы информации, связанной с киберугрозами, тем самым повышая эффективность функционирования Cybersecurity Dome при их выявлении и устранении. Nokia Telco GenAI использует сервис Microsoft Azure OpenAI для работы с большими языковыми моделями (LLM), которые были обучены на данных об архитектуре сетей 5G, методах обеспечения их безопасности и на опыте Nokia в сфере телекоммуникаций. Комплексное обучение предусматривало использование различных категорий информации, включая спецификации 3GPP и NIST, топологию 5G, охватывающую RAN, транспорт и ядро, а также MITRE ATT&CK и FiGHT (иерархия угроз). По оценкам Nokia, Telco GenAI позволит почти вдвое ускорить выявление и устранение угроз. Также предполагается существенное сокращение ложноположительных результатов и более эффективное и действенное выявление и обработку инцидентов кибербезопасности. По словам старшего вице-президента Nokia, интеграция NetGuard Cybersecurity Dome с новым ассистентом на базе генеративного ИИ обеспечит поставщикам услуг связи и предприятиям значительно большую гибкость в уменьшении последствий разрушительных атак.

21.02.2024 [15:35], Сергей Карасёв

MTS AI создала российскую большую языковую модель для анализа документов и звонковКомпания MTS AI, дочерняя структура МТС, разработала большую языковую модель (LLM) MTS AI Chat. Она, как утверждается, позволяет решать широкий спектр задач — от генерации и редактирования текстов до суммирования и анализа информации. Новая LLM ориентирована на корпоративный сектор. Среди сфер применения называются подбор персонала, маркетинг, обслуживание клиентов, подготовка финансовой документации и проверка отчётности, генерация обучающих материалов и пр. На базе MTS AI Chat могут создаваться внутренние системы поиска, чат-боты для ответов на вопросы, рекомендательные сервисы и пр.

Источник изображения: pixabay.com Как отмечает «Коммерсантъ», ссылаясь на информацию, полученную от МТС, в текущем виде LLM поддерживает только текстовые запросы, но компания работает над версией, которая сможет распознавать изображения и видеоматериалы. Кроме того, готовится сервис генерации и автодополнения программного кода. Участники рынка полагают, что при обучении модели MTS AI могла использовать обезличенные данные, которые собирают другие подразделения группы. В настоящее время LLM предлагается для развёртывания на оборудовании заказчика, но в перспективе ожидается выход публичной редакции. Пользователи смогут применять модель для составления должностных инструкций, извлечения информации из документов, формирования выжимок телефонных разговоров и пр. Нужно отметить, что собственные LLM создают и другие российские компании. Так, системный IT-интегратор «Норбит» недавно анонсировал модель Norbit GPT, также ориентированную на корпоративных клиентов. Она предназначена для генерации текстов, обобщения информации, обработки и анализа данных, а также для подготовки ответов на обращения пользователей в службу поддержки.

15.02.2024 [21:44], Сергей Карасёв

«Норбит» создал российскую большую языковую модель для быстрого внедрения ИИ в бизнес-процессыСистемный IT-интегратор «Норбит», входящий в группу «Ланит», сообщил о разработке собственной большой языковой модели (LLM), получившей название Norbit GPT. Решение, ориентированное на корпоративных пользователей, может быть развёрнуто как в облаке, так и в локальной инфраструктуре заказчика. Утверждается, что Norbit GPT позволяет компаниям быстро внедрять средства генеративного ИИ в свои бизнес-процессы. Использование таких инструментов может помочь повысить производительность, снизить издержки и получить конкурентные преимущества. Модель дообучена на большом массиве русскоязычных данных. При этом её можно кастомизировать под специфику и задачи клиента, используя корпоративные массивы информации — например, регламенты, библиотеки, сервисные обращения и др. Возможность развёртывания on-premise минимизирует риски утечки персональной и конфиденциальной информации. С помощью API модель можно интегрировать с информационными системами компании. Norbit GPT подходит для генерации текстов, обобщения информации, обработки и анализа данных, а также для подготовки ответов на обращения пользователей в службу поддержки или запросов в базу знаний компании. Таким образом, можно автоматизировать процесс выполнения рутинных задач, что поможет снизить нагрузку на сотрудников и повысить эффективность бизнес-процессов. В частности, LLM может оказывать помощь в подготовке маркетинговых материалов, написании писем, разработке программного кода, проверке документов, классификации резюме и пр. «GPT-технологии кардинально меняют бизнес, модифицируют подходы к созданию контента, управлению и решению рутинных задач. Если в ваших бизнес-процессах есть направления, в которых задействованы большие объёмы текстовых данных, мы можем предложить пилотный проект автоматизации на основе Norbit GPT и варианты его интеграции в корпоративную информационную инфраструктуру», — говорит «Норбит».

14.02.2024 [23:00], Сергей Карасёв

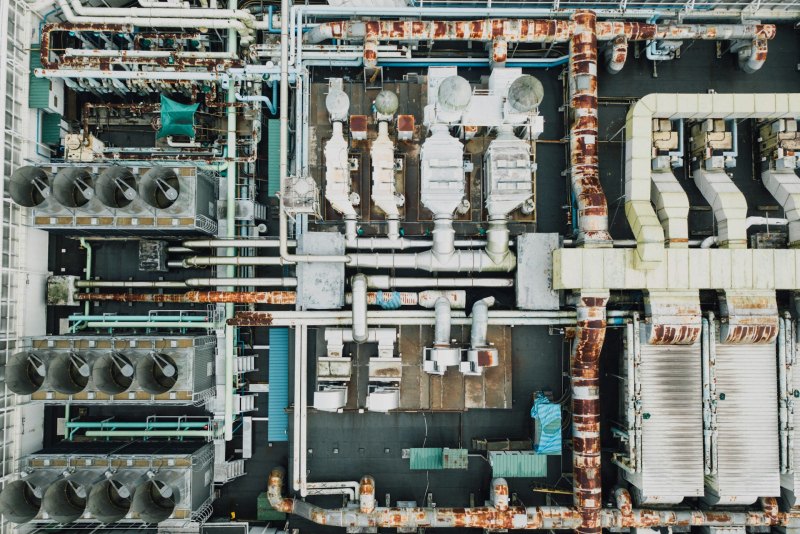

Поговорить с машинами: Nokia представила ИИ-помощника MX Workmate для промышленных работниковКомпания Nokia анонсировала специализированный набор инструментов MX Workmate, который позволяет работникам промышленных предприятий «общаться» с машинами. В основу решения положены технологии генеративного ИИ и большая языковая модель (LLM). Отмечается, что организации по всему миру сталкиваются с нехваткой квалифицированной рабочей силы. Исследование, проведённое консалтинговой фирмой Korn Ferry, говорит о том, что к 2030 году дефицит технических специалистов в глобальном масштабе может достичь 85 млн человек. Это эквивалентно $8,5 трлн потенциальных потерянных доходов. Внедрение ИИ-инструментов может частично облегчить кадровую проблему. ИИ-помощник MX Workmate использует машинные данные для генерации сообщений на естественном языке. Это облегчает взаимодействие сотрудников предприятий с различным оборудованием, а также повышает эффективность работы и безопасность. В частности, MX Workmate позволяет работникам в режиме реального времени получать понятную информацию о состоянии производства, объемах и качестве выпускаемой продукции и пр. Кроме того, система выдаёт рекомендации по улучшению показателей. Используя Nokia Team Comms, сотрудники смогут задавать вопросы помощнику. Быстро анализируя поступающую информацию, ИИ-инструмент может выдавать ранние предупреждения о возможных неисправностях или грядущих поломках. Это упростит профилактическое обслуживание и поможет избежать серьёзных сбоев оборудования, минимизировав тем самым время простоя. Благодаря непрерывной оценке рисков MX Workmate может оперативно генерировать инструкции для работников в случае возникновения чрезвычайной ситуации: таким образом, сотрудники предприятий смогут действовать максимально безопасно. В целом, как утверждается, Nokia MX Workmate — это первое решение на основе генеративного ИИ, разработанное специально для производственных площадок. Помощник обеспечивает контекстно-зависимый обмен информацией в режиме реального времени между работниками и сложными системами безопасным способом с использованием естественного человеческого языка. |

|