Материалы по тегу: amd

|

08.05.2024 [13:24], Сергей Карасёв

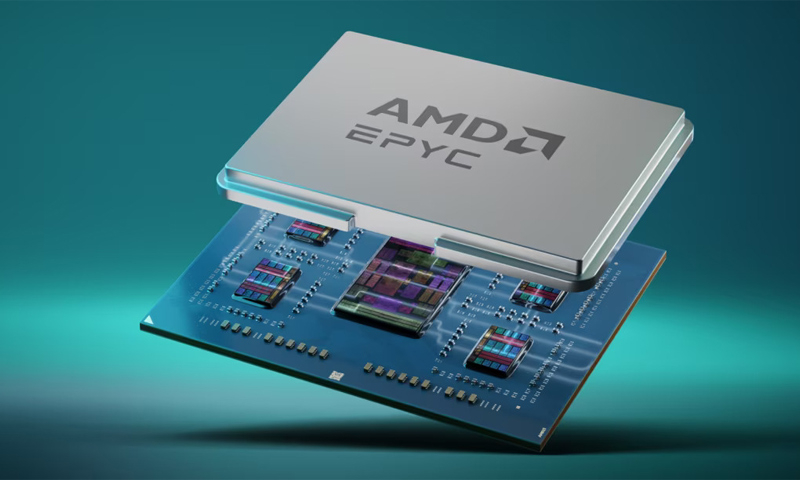

ИИ-суперкомпьютер в чемодане — GigaIO представила платформу GryfКомпания GigaIO совместно с SourceCode анонсировала вычислительную систему Gryf. Это, как утверждается, первый в мире суперкомпьютер для ИИ-нагрузок, выполненный в виде чемодана на колёсиках. Изделие имеет габариты 228,6 × 355,6 × 622,3 мм и весит около 25 кг. Применяется фирменная система интерконнекта FabreX на базе PCI Express. Конфигурация Gryf предусматривает использование модулей (Sled) четырёх типов: это вычислительный узел (Compute Sled), блок ускорителя (Accelerator Sled), узел хранения (Storage Sled) и сетевой блок (Network Sled). Они могут компоноваться в различных сочетаниях, но общее количество модулей в рамках одного экземпляра Gryf не превышает шести. В состав Compute Sled входят процессор AMD EPYC 7313 Milan (16C/32T; 3,0–3,7 ГГц; 155 Вт), 256 Гбайт DDR4-3200, системный накопитель NVMe M.2 SSD вместимостью 256 Гбайт и два 100GbE-порта QSFP56/QSFP28. Может применяться ОС Linux Rocky 8/9 или Ubuntu 20/24. В свою очередь, Accelerator Sled содержит ускоритель NVIDIA L40S (48 Гбайт). Модуль Storage Sled объединяет восемь накопителей NVMe E1.L SSD суммарной вместимостью 246 Гбайт. Наконец, Network Sled предоставляет два разъёма QSFP56 100GbE и шесть 25GbE-портов SFP28. Вся система получает питание от двух блоков мощностью 2500 Вт каждый. Применены шесть вентиляторов охлаждения диаметром 60 мм. Диапазон рабочих температур — от 10 до +32 °C. Одно устройство Gryf обеспечивает производительность до 91,6 Тфлопс FP32, до 733 Тфлопс FP16 и до 1466 Тфлопс FP8. При этом в единый комплекс могут быть связаны до пяти экземпляров Gryf, что позволяет масштабировать быстродействие для выполнения тех или иных задач.

06.05.2024 [20:05], Сергей Карасёв

AMD начала поставки образцов процессоров EPYC TurinКомпания AMD, по сообщению ресурса AnandTech, обнародовала свежую информацию о планах по выпуску серверных процессов EPYC Turin (7005) на архитектуре Zen 5. Говорится, что образцы этих чипов уже поставляются клиентам, тогда как их официальный выход на рынок состоится во II половине текущего года. По имеющейся информации, изделия EPYC Turin будут использовать существующий сокет SP5 (LGA 6096). Готовятся обычные (Zen 5) и «облачные» (Zen 5c) варианты. В первом случае будут задействованы 16 вычислительных чиплетов CCD (до восьми ядер в каждом), что в сумме даст до 128 ядер. Для «облачных» версий предусмотрено наличие 12 чиплетов CCD (до 16 ядер в каждом), а суммарное количество ядер Zen 5с составит до 192 (384 потока). Как отметила глава AMD Лиза Су (Lisa Su), по сравнению с процессорами предыдущего поколения EPYC Turin обеспечат значительное увеличение производительности и энергоэффективности, что позволит компании укрепить позиции на серверном рынке. По её словам, для новой платформы партнёры AMD проектируют примерно на 30 % больше систем, нежели для EPYC Genoa. Вместе с тем, подчеркивает Су, изделия этих двух поколений какое-то время будут сосуществовать, что поможет клиентам выработать оптимальную стратегию обновления инфраструктуры. По мнению руководителя AMD, переход с Genoa на Turin займёт меньше времени, чем это было в случае Milan и Genoa. В корпоративном секторе, по словам госпожи Су, AMD тесно сотрудничает с Dell, HPE, Lenovo, Supermicro и другими разработчиками серверов. В текущем квартале начнётся массовое производство ряда ИИ-платформ на базе ускорителей Instinct MI300X. AMD прогнозирует, что выручка от поставок GPU-решений для дата-центров в 2024 году превысит $4 млрд. Еще в январе компания называла цифру в $3,5 млрд. Таким образом, AMD рассчитывает на существенное увеличение продаж продуктов для ЦОД.

04.05.2024 [17:55], Владимир Мироненко

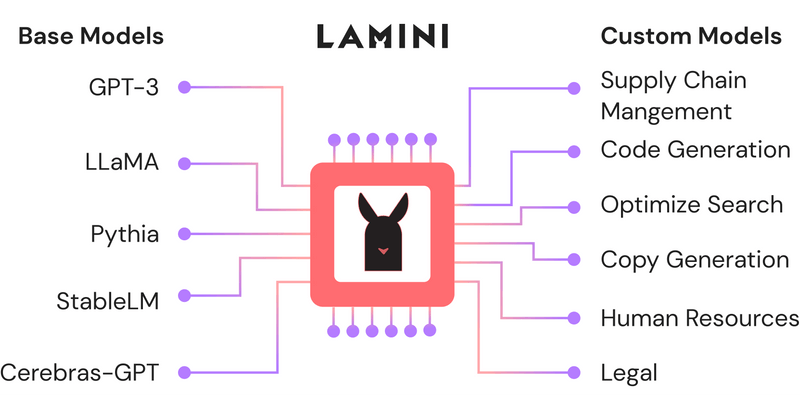

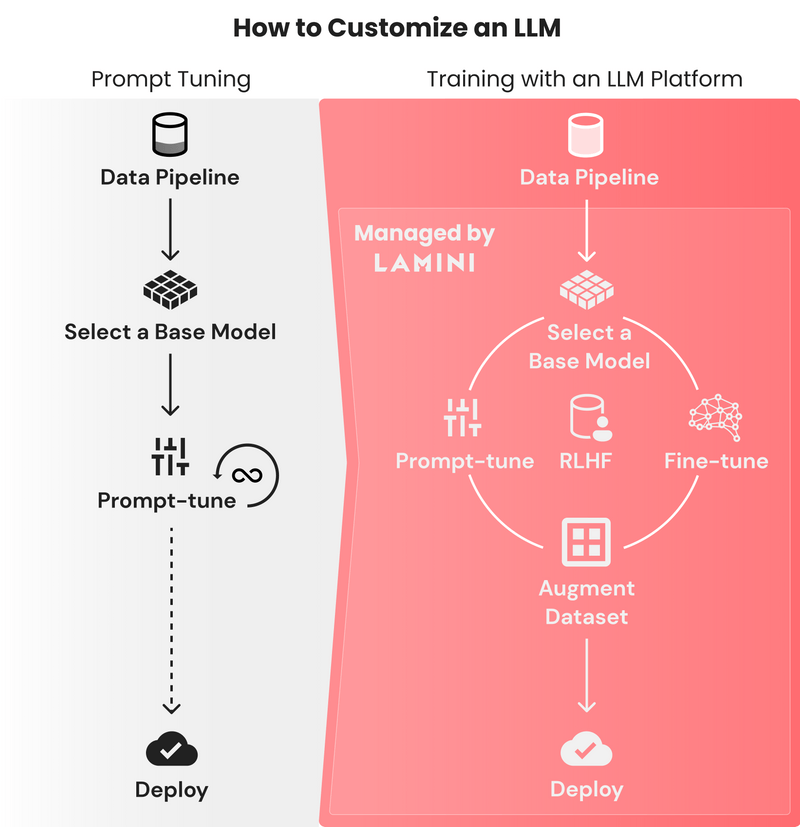

PowerML привлекла $25 млн на развитие ИИ-платформы Lamini, в том числе от AMD и Louis VuittonСтартап PowerML Inc., разработчик платформы Lamini для обучения и развёртывания ИИ-моделей, сообщил о привлечении $25 млн в ходе двух раундов финансирования. В раундах приняли участие компании Amplify Partners, возглавившая раунд Series A, First Round Capital, возглавившая Seed-раунд, AMD Ventures, пионер ИИ Эндрю Ын (Andrew Ng), соучредитель OpenAI Андрей Карпати (Andrej Karpathy), руководители Dropbox Inc., Figma Inc. и LVMH, материнской компании Louis Vuitton. Разработанная PowerML программная платформа предназначена для обучения и запуска больших языковых моделей (LLM) на ускорителях AMD или NVIDIA как в облачных, так и в локальных средах. В последнем случае можно развернуть Lamini в изолированной инфраструктуре. Платформа была создана с расчётом на крупномасштабные ИИ-проекты, которым может потребоваться более 1000 ускорителей.

Источник изображений: Lamini Одной из наиболее сложных задач, связанных с обучением LLM, является настройка гиперпараметров. Lamini предоставляет готовые наборы гиперпараметров, устраняя необходимость всё настраивать с нуля. Вместе с тем остаётся возможность определения пользовательских настроек LLM. Платформа также может использоваться для точной настройки уже обученных моделей ИИ под конкретную задачу. Lamini использует подход PEFT, который позволяет значительно сократить количество изменений параметров, а также снизить стоимость адаптации LLM к выполнению новых задач. Вместе с тем Lamini поддерживает методику RAG (Retrieval Augmented Generation), которая позволяет дообучать модель на собственных данных без изменения кода. Заодно Lamini предоставляет панель мониторинга, которая позволяет разработчикам сравнивать корректность точной настройки своих ИИ-моделей с исходной версией.  PowerML также упрощает развёртывание готовых ИИ-моделей, предоставляя различные настройки инференса и позволяя управлять стилем генерации, форматом выводимых данных и т.д. Компания утверждает, что её платформа в инференс-задачах более экономична по сравнению с проприетарными LLM-платформами, такими как Claude 3. Полученные инвестиции PowerML планирует использовать для найма большего количества сотрудников и расширения своей инфраструктуры ИИ, в частности, за счёт ускорителей большего количества ускорителей AMD, поскольку стартап делает ставку на решения AMD: ускорители Instinct и стек ROCm. Компания также планирует разработать «более глубокую техническую оптимизацию» для рабочих нагрузок машинного обучения.

03.05.2024 [10:15], Владимир Мироненко

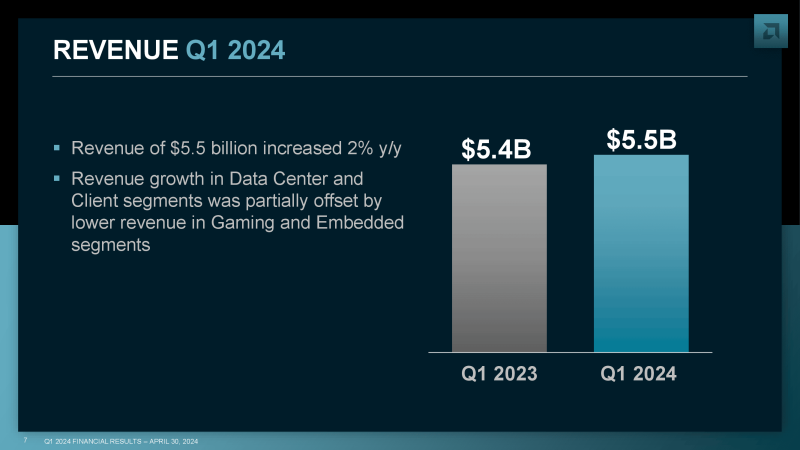

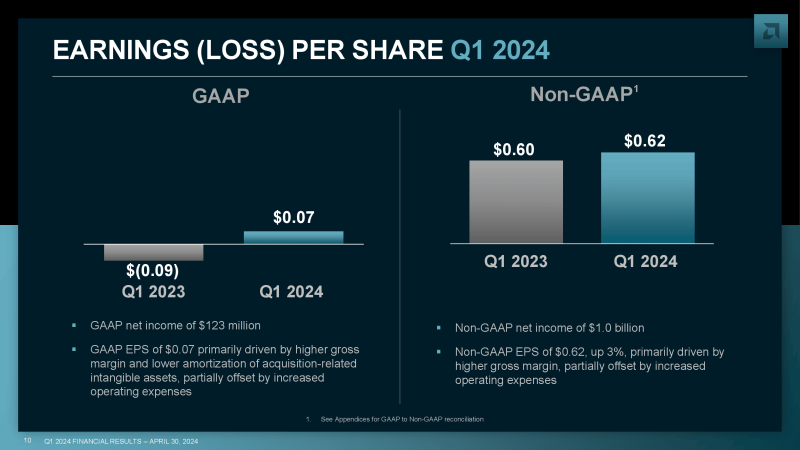

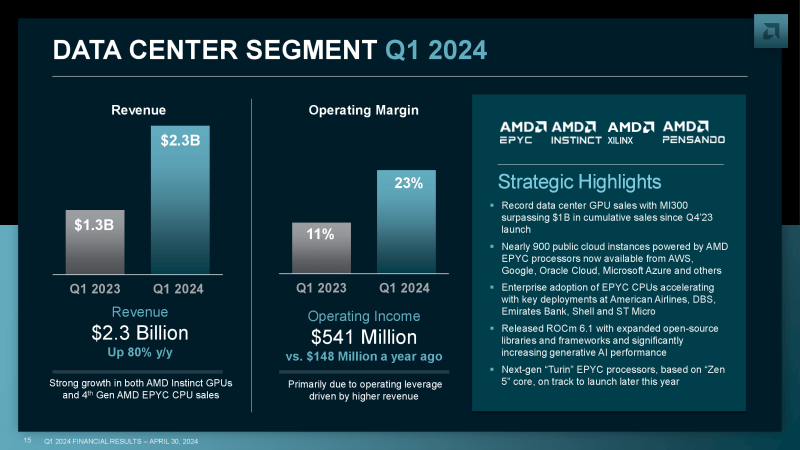

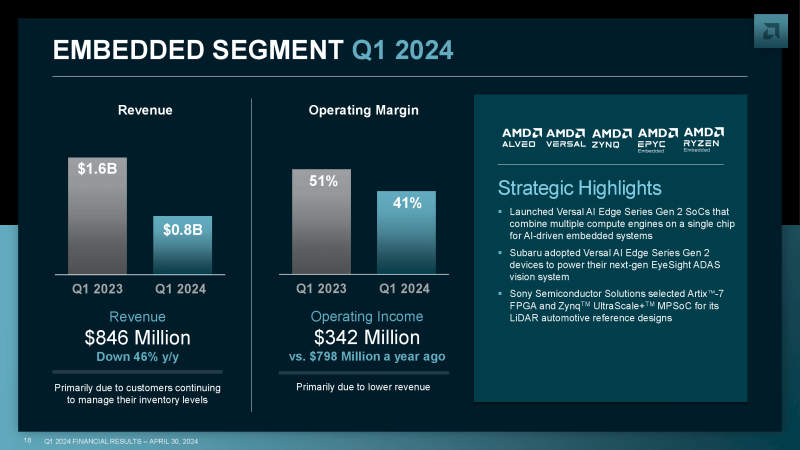

Результаты AMD в I квартале оправдали прогнозы аналитиков, но акции упали — инвесторы ожидают большего ростаAMD объявила результаты I квартала 2024 года. Несмотря на то, что основные показатели компании были выше или в рамках прогнозов Уолл-стрит, её акции упали более чем на 7 % после закрытия торговой сессии, поскольку прогноз на год по выпуску ускорителей ИИ оказался ниже ожиданий инвесторов. Выручка AMD выросла год к году на 2 % до $5,47 млрд, что чуть выше прогноза аналитиков Уолл-стрит в размере $5,46 млрд. Чистая прибыль (GAAP) компании составила $123 млн, или $0,07 на акцию, тогда как годом ранее у неё были убытки в $139 млн, или –$0,09 на акцию. Большую часть выручки компания получила благодаря подразделениям по выпуску продуктов для ЦОД, включая серверные процессоры и ИИ-ускорители, и клиентских решений, увеличившим показатели год к году на 80 % и 85 % до $2,3 млрд и $1,4 млрд соответственно. По обеим категориям компания превысила прогноз аналитиков Уолл-стрит, ожидавших выручку по сегменту продуктов для ЦОД в размере $2,27 млрд и $1,29 млрд по сегменту клиентских решений. Компания сообщила, что рост выручки в сегменте продукции для ЦОД был достигнут благодаря высокому спросу на ускорители AMD Instinct и серверные процессоры EPYC. Гендиректор AMD Лиза Су (Lisa Su) отметила высокий спрос на ИИ-ускоритель MI300, который, по её словам, продолжает расти. Она добавила, что значительно выросли поставки MI300 гиперскейлерам Microsoft, Meta✴ и Oracle. «В долгосрочной перспективе мы всё более тесно сотрудничаем с нашими облачными и корпоративными клиентами, поскольку мы расширяем и ускоряем наши планы по аппаратному и программному обеспечению для ИИ, а также увеличиваем выпуск GPU для ЦОД», — заявила Лиза Су. Су добавила, что AMD также совместно с такими производителями серверов, как Dell, HPE, Supermicro и Lenovo, занимается разработкой новых систем на базе MI300. По её словам, выпуск этих систем в текущем квартале будет увеличен. В связи с высоким спросом на ускорители для ИИ-серверов компания увеличила прогноз по их выпуску в 2024 году до $4 млрд с предыдущего прогноза в $3,5 млрд, но, по всей видимости, инвесторы ожидали ещё большего повышения, что привело к падению акций AMD. В других сегментах бизнеса AMD отмечен более слабый спрос. Выручка игрового сегмента, поставляющего чипы для игровых консолей, упала на 48 % до $922 млн, что ниже прогноза аналитиков, опрошенных StreetAccount, равного $969 млн. Выручка сегмента встраиваемых систем, в основном поставляющего продукты Xilinx, приобретённой в 2022 году, упала на 46 % до $846 млн при прогнозе Уолл-стрит в $942 млн. AMD заявила, что ожидает получить в текущем квартале выручку $5,4–$6 млрд, что соответствует прогнозу Уолл-стрит и означает рост год к году примерно на 6 %.

30.04.2024 [12:39], Сергей Карасёв

Утилита llamafile для быстрого запуска ИИ-моделей получила расширенную поддержку ускорителей AMD и свежих LLMКомпания Mozilla анонсировала обновлённую версию инструмента llamafile с индексом 0.8.1. В данном релизе устранены ошибки, из-за которых происходило некорректное распознавание ускорителей AMD на базе GPU. Кроме того, реализованы некоторые другие изменения. Напомним, llamafile даёт возможность упаковать веса большой языковой модели (LLM) в исполняемый файл, который без установки можно запустить практически на любой современной платформе. Поддерживаются архитектуры x86-64 и ARM64, а также системы macOS, Windows, Linux, FreeBSD, OpenBSD и NetBSD. Как отмечается, изначально в llamafile корректно определялись только числовые идентификаторы графических блоков AMD GFX, из-за чего возникали сбои при использовании определённого оборудования AMD Instinct/Radeon. Например, ускоритель Instinct MI250 имеет обозначение GFX90A IP, и символ «A» ранее не распознавался должным образом. В результате, при работе с такими GPU происходили ошибки. Теперь данная проблема устранена.

Источник изображения: AMD Кроме того, в llamafile 0.8.1 имеется поддержка модели Phi-3 Mini 4k, а также LLaMA3, Grok, Mixtral 8x22b и Command-R. Производительность F16 повышена приблизительно на 20 % на платформе Raspberry Pi 5, примерно на 30 % — на Intel Skylake и на 60 % — на Apple M2.

26.04.2024 [11:46], Сергей Карасёв

HPE построила самый мощный в Польше суперкомпьютер Helios производительностью 35 ПфлопсКомпания HPE сообщила о создании нового суперкомпьютера под названием Helios для Академического компьютерного центра Cyfronet Научно-технического университета AGH в Кракове (Польша). Вычислительный комплекс будет использоваться для решения ресурсоёмких задач, связанных с ИИ. На сегодняшний день Helios — самая высокопроизводительная система в Польше. Она обеспечивает теоретическую пиковую производительность на уровне 35 Пфлопс, что более чем в четыре раза превосходит показатель предыдущего флагманского суперкомпьютера Cyfronet. Пиковое быстродействие на ИИ-операциях достигает 1,8 Эфлопс. В основу Helios положены узлы HPE Cray EX. Комплекс состоит из трёх сегментов. Один из них предназначен для традиционных вычислений, еще один — для рабочих нагрузок, связанных с обработкой больших данных. Третий сегмент оптимизирован для ИИ-задач: он использует суперчипы NVIDIA. Суперкомпьютер планируется применять при реализации проектов в области химии, медицины, создания передовых материалов, астрономии и защиты окружающей среды. Раздел общего назначения использует процессоры AMD EPYC поколения Genoa. Общее количество вычислительных ядер Zen 4 составляет 75 264, объём оперативной памяти DDR5 — 200 Тбайт. Сегмент для работы с большими данными основан на платформе HPE Cray Supercomputing XD665 с чипами EPYC Genoa, памятью DDR5-4800, быстрыми накопителями NVMe и ускорителями NVIDIA H100, суммарное количество которых равно 24.

Источник изображения: HPE Наконец, ИИ-раздел объединяет 440 суперчипов NVIDIA GH200 Grace Hopper для компьютерного моделирования с интенсивным использованием графики, поддержки приложений на основе генеративного ИИ и пр. Все компоненты вычислительного комплекса связаны друг с другом посредством 200G-интерконнекта HPE Slingshot. Комплекс Helios оснащён Lustre-хранилищем общей вместимостью 17,5 Пбайт на базе HPE Cray ClusterStor E1000.

24.04.2024 [14:37], Сергей Карасёв

AMD: использование чиплетной архитектуры в процессорах EPYC помогает сократить выбросы парниковых газовДжастин Мюррилл (Justin Murrill), директор по корпоративной ответственности AMD, заявил, что решение компании использовать чиплетную архитектуру в процессорах EPYC позволило снизить глобальные выбросы парниковых газов на десятки тысяч тонн в год. AMD начала внедрение чиплетов около семи лет назад. Применение многокристальной архитектуры вместо монолитных изделий обеспечивает ряд преимуществ. В частности, достигается лучшая гибкость при проектировании изделий благодаря возможности комбинировать различные модули. Кроме того, повышается эффективность управления тепловыделением.

Источник изображения: AMD AMD создаёт процессоры EPYC путём компоновки вычислительных чиплетов CCD вокруг унифицированного чиплета IOD, выполняющего роль хаба ввода-вывода. Компания заявляет, что использование нескольких отдельных чиплетов вместо монолитного кристалла даёт возможность повысить процент выхода годной продукции в расчёте на одну кремниевую пластину. Дело в том, что в случае выявления дефекта отбраковывается сравнительно небольшой чип, а не крупное изделие. В результате сокращаются затраты на производство, снижаются энергетические и сырьевые потери. По словам Мюррилла, изготовление процессоров EPYC четвёртого поколения с восемью отдельными вычислительными чиплетами вместо одного монолитного кристалла позволило избежать 50 тыс. т выбросов CO2 в 2023 году. Однако нужно отметить, что это собственная оценка AMD, основанная на теоретических расчётах. Некоторые участники рынка также говорят о недостатках чиплетной компоновки. Среди минусов, в частности, называется необходимость использования высокоскоростных внутричиповых соединений. Кроме того, меньшее количество микросхем означает меньшее количество межсоединений и, следовательно, меньшую сложность и потенциально более высокую производительность.

20.04.2024 [20:50], Сергей Карасёв

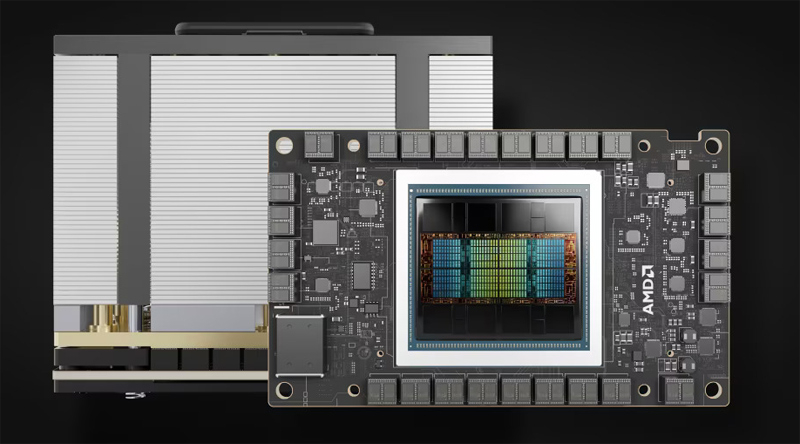

ИИ-облако TensorWave получит 20 тыс. ускорителей AMD Instinct MI300XВ то время как многие операторы облачных платформ и дата-центров закупают ускорители NVIDIA H100 для задач ИИ и НРС, стартап TensorWave, по сообщению ресурса The Register, сделал выбор в пользу решений AMD. Ожидается, что такой подход позволит ускорить развёртывание сервисов и снизить стоимость услуг для заказчиков. Системы класса bare metal будут предлагаться для аренды на определённый период времени по цене от $1/ч/GPU. TensorWave приступила к созданию облачной ИИ-системы на базе ускорителей Instinct MI300X. К концу 2024 года TensorWave планирует установить около 20 тыс. ускорителей MI300X на двух объектах, объединённых RoCE-фабрикой. В 2025-м, как ожидается, будут введены в эксплуатацию дополнительные мощности с СЖО. В дальнейшем планируется внедрение технологии GigaIO FabreX на базе PCIe 5.0, позволяющей объединить до 5750 ускорителей в одном домене с более чем 1 Пбайт памяти НВМ.

Источник изображения: AMD TensorWave использует системы с восемью ускорителями MI300X в одном узле. В одной стойке будут располагаться четыре таких узла. Упомянуто применение системы охлаждения с теплообменниками на задней двери. Судя по фотографиям, стартап использует 8U-серверы Supermicro AS-8125GS-TNMR2. Расчётная мощность составляет приблизительно 40 кВт на стойку. В долгосрочной перспективе TensorWave нацелена на внедрение технологии прямого жидкостного охлаждения чипов, что позволит повысить мощность и плотность размещения оборудования. Соучредитель TensorWave Джефф Татарчук (Jeff Tatarchuk) отмечает, что применение MI300X обеспечивает ряд преимуществ перед изделиями NVIDIA. Это отсутствие столь серьёзного дефицита, более высокая производительность и меньшая стоимость аренды для потребителей облачных ИИ-услуг. Однако, по словам Татарчука, препятствием при коммерциализации сервисов на базе ускорителей AMD может стать то, что потенциальные клиенты выражают неуверенность по поводу возможностей MI300X в сравнении с H100.

13.04.2024 [23:00], Сергей Карасёв

«Ростех» начал поставки серверов и обновлённого интерконнекта «Ангара» для отечественных суперкомпьютеров

amd

epyc

hardware

hpc

ангара

импортозамещение

интерконнект

коммутатор

ницэвт

россия

ростех

сделано в россии

сервер

суперкомпьютер

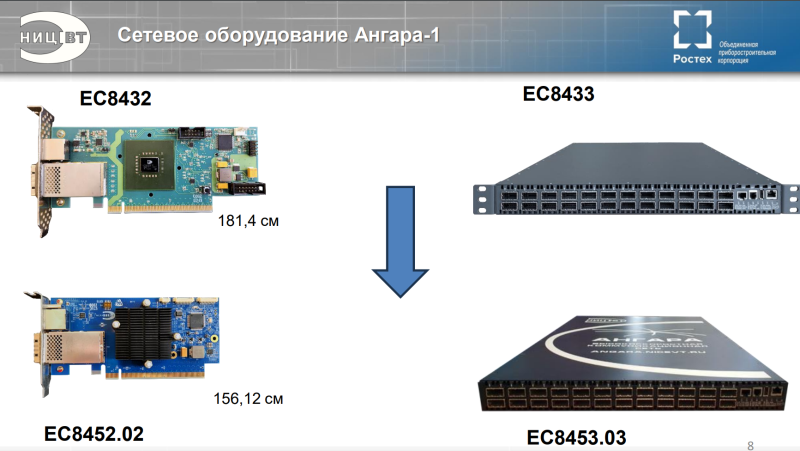

Государственная корпорация «Ростех» объявила о начале поставок оборудования нового поколения для создания отечественных суперкомпьютеров. Речь идёт о высокопроизводительных серверах, 24-портовых коммутаторах и адаптерах интерконнекта «Ангара». В сообщении «Ростеха» говорится, что оборудование стало более компактным по сравнению с предыдущими модификациями. Адаптеры «Ангара» обеспечивают объединение серверов в единый вычислительный кластер для проведения расчётов с высокоинтенсивным обменом информацией и низкими задержками. Новинка разработана специалистами Научно-исследовательского центра электронной вычислительной техники (НИЦЭВТ) в составе холдинга «Росэлектроника» госкорпорации «Ростех». На сайте НИЦЭВТ представлено изделие ЕС8431. Это FHFL-карта с интерфейсом PCIe 2.0 x16, которая обеспечивает до шести (или до восьми при использовании платы расширения) портов для соединения с соседними узлами. Пропускная способность достигает 75 Гбит/с на порт, задержка — 130 нс на хоп. Применяются Samtec-кабели. Поддерживаются топологии сети «кольцо», 2D, 3D и 4D-тор (либо решётка), причём возможно масштабирование до 32 тыс. узлов. Энергопотребление — 30 Вт. Также доступен низкопрофильный 15-Вт адаптер ЕС8432, который по характеристикам в целом повторяет ЕС8431, но имеет только один порт (CXP). Он ориентирован на работу с коммутаторами. И НИЦЭВТ как раз предлагает такое решение — изделие ЕС8433 типоразмера 1U. Оно располагает 24 портами с пропускной способностью до 75 Гбит/с. Возможно масштабирование до 2 тыс. узлов. Энергопотребление не превышает 150 Вт. На мероприятии «Суперкомпьютерные дни в России 2023» НИЦЭВТ также анонсировал более компактный вариант адаптера ЕС8452.02 и 24-портовый коммутатор ЕС8453.03. В сообщении «Ростеха» не уточняется, о каких именно продуктах идёт речь. В маркетплейсе госкорпорации рекомендованная розничная цена коммутатора ЕС8433 составляет 2,8 млн руб., а адаптеров ЕС8431 и ЕС8432 — 396 тыс. руб. и 300 тыс. руб. соответственно. В ассортименте НИЦЭВТ также значится сервер общего назначения Server-NICEVT-044 SP3 на платформе AMD. Он может оснащаться одним или двумя процессорами EPYC Naples/Rome/Milan (от 8 до 48 ядер), до 1 Тбайт RAM, двумя блоками питания с возможностью горячей замены. Возможна установка SSD суммарной вместимостью до 10 Тбайт и HDD общей ёмкостью до 80 Тбайт. Форм-фактор — 2U. Рекомендованная розничная цена составляет 1,2 млн руб. «Мы произвели первые поставки нового поколения сетевого оборудования линейки "Ангара", разработка которого завершилась в 2023 году. Техника установлена на территории двух научно-исследовательских организаций. Устройства позволяют ещё более эффективно выполнять задачи по созданию современных российских суперкомпьютеров для решения сложных научных задач. Сегодня именно от такого оборудования во многом зависит успех и скорость научных изысканий, а значит — и развитие отечественной промышленности», — говорит генеральный директор НИЦЭВТ.

11.04.2024 [14:47], Сергей Карасёв

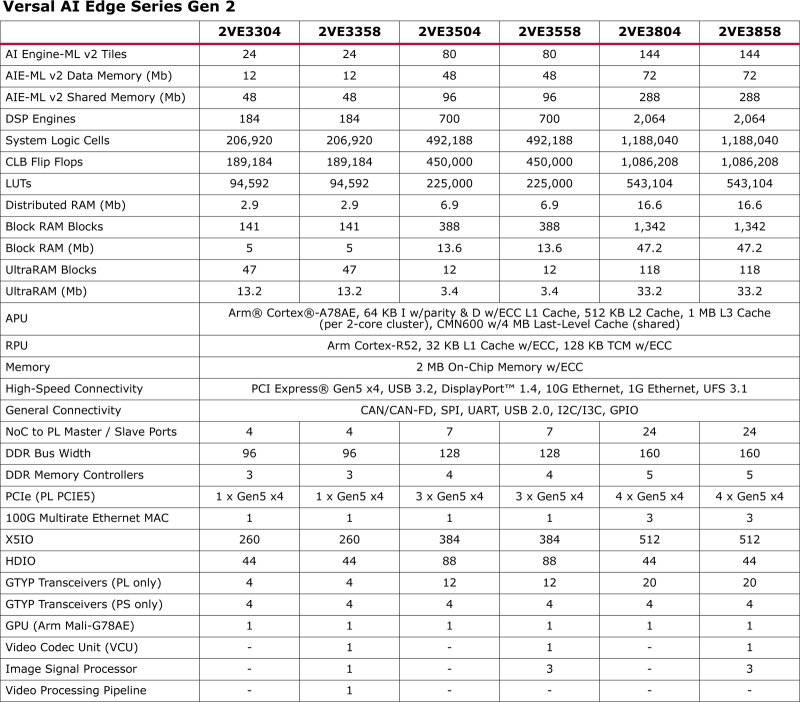

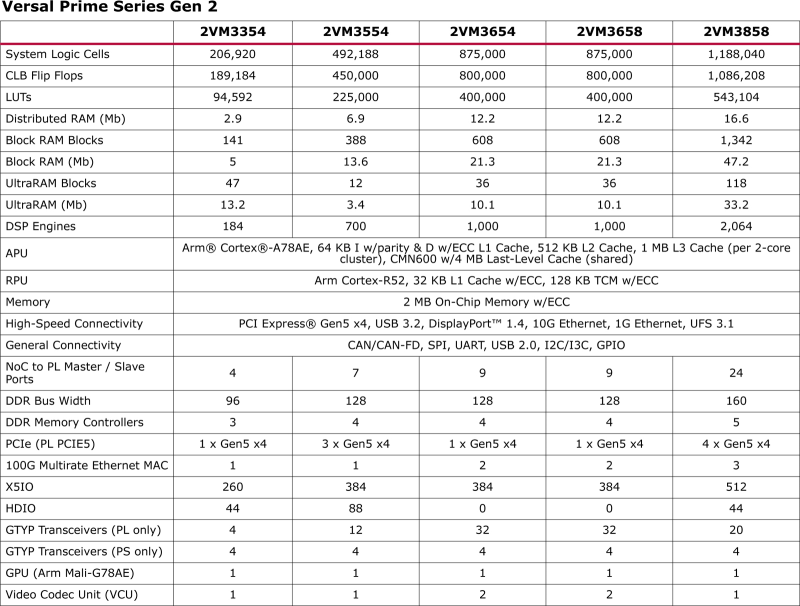

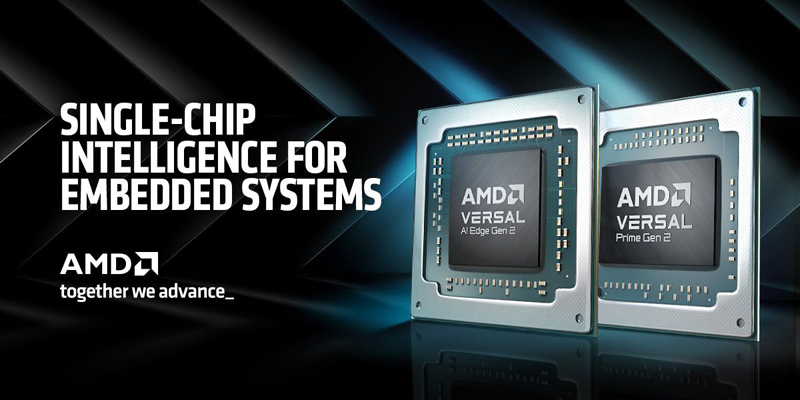

AMD представила гибридные FPGA Versal Gen 2 для встраиваемых систем с ИИКомпания AMD анонсировала так называемые адаптивные SoC семейства Versal второго поколения (Gen 2), предназначенные для встраиваемых систем со средствами ИИ. Утверждается, что чипы обеспечивают до трёх раз более высокий показатель производительности TOPS/Вт по сравнению с решениями Versal AI Edge первого поколения. Дебютировали чипы серий Versal AI Edge Gen 2 и Versal Prime Gen 2. Изделия первого семейства, как утверждается, содержат оптимальный набор блоков для решения задач на встраиваемых системах с ИИ: это предварительная обработка данных с помощью программируемой логики FPGA, инференс и постобработка с использованием ядер Arm.

Источник изображений: AMD Производительность INT8 у чипов Versal AI Edge Gen 2 в зависимости от модификации варьируется от 31 до 185 TOPS, быстродействие MX6 — от 61 до 370 TOPS. В составе процессора приложений задействованы ядра Arm Cortex-A78AE, количество которых может составлять 4 или 8. Кроме того, используются 4 или 10 ядер реального времени Arm Cortex-R52. Заявлена поддержка интерфейсов PCI Express 5.0 x4, USB 3.2, DisplayPort 1.4, 10GbE и 1GbE, UFS 3.1, CAN/CAN-FD, SPI, UART, USB 2.0, I2C/I3C, GPIO.

В свою очередь, решения Versal Prime Gen 2 предназначены для ускорения задач в традиционных встраиваемых системах, которые не работают с ИИ-приложениями. Они объединяют до восьми ядер Arm Cortex-A78AE и до 10 ядер реального времени Arm Cortex-R52. Набор поддерживаемых интерфейсов аналогичен изделиям Versal AI Edge Gen 2. Говорится о возможности многоканальной обработки видео в формате 8K. Отмечается, что новые процессоры лягут в основу систем для автомобильной, аэрокосмической и оборонной отраслей, промышленности, а также сфер машиностроения, здравоохранения, вещания и пр. Чипы позволяют разрабатывать высокопроизводительные продукты для периферийных вычислений. |

|