Материалы по тегу: ram

|

05.05.2024 [13:59], Сергей Карасёв

SK hynix продала всю память HBM, запланированную к выпуску в 2024–2025 гг.Компания SK hynix, по сообщению The Register, получила заказы на весь объём памяти HBM, запланированный к выпуску в 2024 году, и на основную часть этих чипов, которые будут произведены в 2025-м. Спрос на изделия HBM быстро растёт на фоне стремительного развития ИИ-рынка. SK hynix объявила на пресс-конференции в своей штаб-квартире в Ичхоне (Южная Корея) о намерении расширить производство микросхем HBM. Генеральный директор компании Квак Но-чжун (Kwak Noh-jung) заявил, что выпуск изделий данного типа удастся значительно нарастить после завершения строительства новых предприятий в Южной Корее и США.

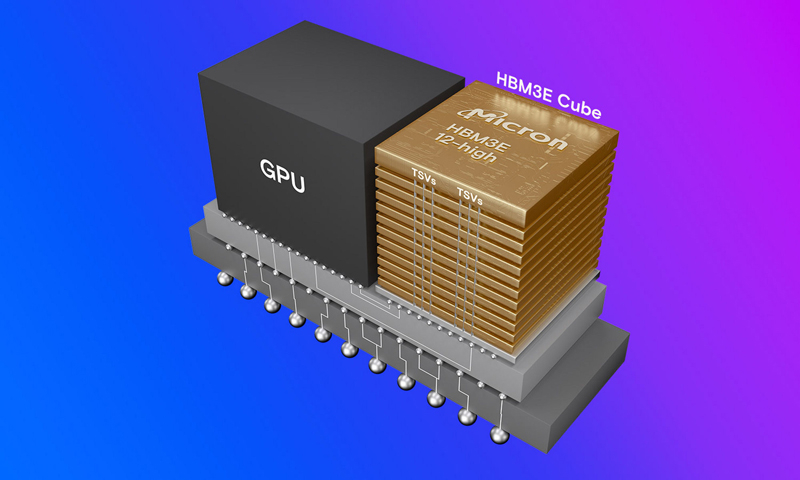

Источник изображения: SK hynix SK hynix является основным поставщиком памяти HBM для ускорителей NVIDIA, с поставками которых наблюдаются сложности из-за высокого спроса со стороны облачных провайдеров и операторов дата-центров, ориентированных на ИИ-нагрузки. Квак Но-чжун прогнозирует, что в среднесрочной и долгосрочной перспективе среднегодовой прирост потребности в чипах HBM будет составлять около 60 %. Это связано с увеличением объёмов генерируемых данных и повышением сложности ИИ-моделей. До конца мая SK hynix планирует предоставить клиентам образцы памяти HBM пятого поколения — 12-слойные изделия HBM3E. Массовый выпуск такой продукции компания наметила на III квартал 2024 года. Недавно SK hynix заявила, что планирует инвестировать более $14,5 млрд в новый корейский завод M15X по производству чипов памяти. Первоначально планировалось, что это предприятие будет выпускать изделия NAND, но затем было решено переориентировать его мощности под выпуск DRAM. В марте сообщалось, что компания Micron Technology, приступившая в феврале к массовому производству памяти HBM3E, уже получила контракты на весь объём поставок этих изделий до конца 2024 года, а также на большую часть поставок в 2025 году.

02.05.2024 [15:33], Алексей Разин

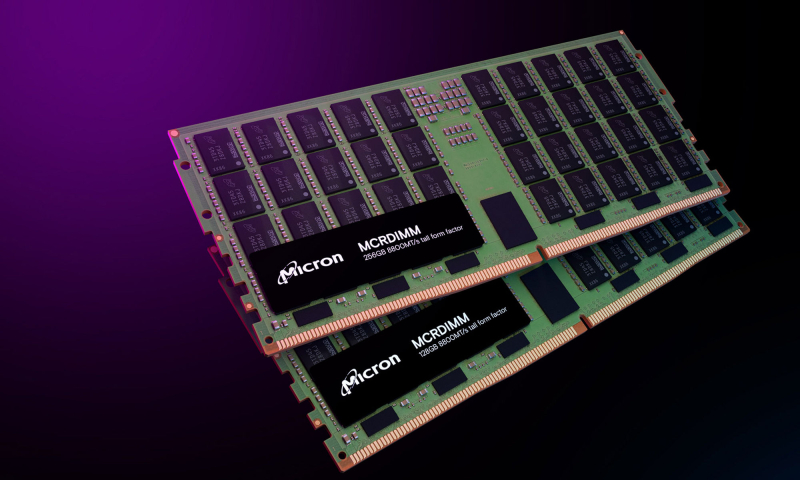

Micron начала поставки RDIMM-модулей DDR5 объёмом 128 Гбайт на базе 32-Гбит чиповПредставив чипы памяти типа DDR5 ёмкостью 32 Гбит ещё прошлой осенью, компания Micron Technology только сейчас сертифицировала модули RDIMM объёмом 128 Гбайт на основе этих чипов на совместимость с оборудованием ключевых игроков серверного рынка. Клиенты Micron смогут получить такие модули памяти в июне. Также компания объявила о поставках восьмиярусных стеков памяти HBM3E. Американский производитель памяти подчёркивает, что и 128-Гбайт модули DDR5-5600 RDIMM, и HBM3E-память Hi-8 наилучшим образом проявят себя в серверной инфраструктуре, ориентированной на обслуживание ИИ-систем. Кого именно из производителей ускорителей вычислений Micron снабжает памятью типа HBM3E, не уточняется, но конкурирующие Samsung и SK hynix уже готовы поставлять клиентам 12-ярусные чипы HBM3E. Впрочем, ещё в феврале Micron сообщил о готовности начать во II квартале поставки чипов HBM3E объёмом 24 Гбайт для ускорителей NVIDIA H200.

Источник изображения: Micron Technology Серверные модули DDR5 объёмом 128 Гбайт со скоростью 5600 МТ/с на основе монолитных 32-Гбит чипов памяти, по данным Micron, позволяют на 45 % поднять плотность хранения данных в пересчёте на один контакт, на 22 % поднять энергетическую эффективность, и на 16 % снизить задержки при передаче информации по сравнению с немонолитными чипами DDR5. Micron отметила, что в этом году начнёт поставки модулей со скоростью 4800, 5600 и 6400 MT/с, а в будущем намерена предложить решения со скоростью до 8000 MT/с. AMD и Intel подтвердили совместимость новых модулей Micron со своими современными серверными платформами. Со следующего месяца Micron начнёт продавать новую память через своих торговых партнёров.

11.04.2024 [22:27], Алексей Степин

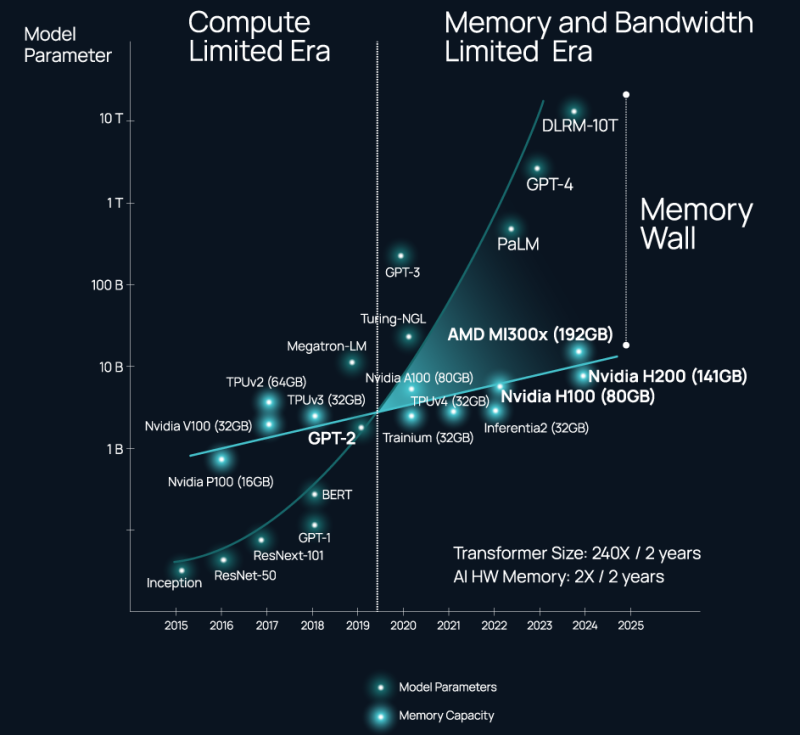

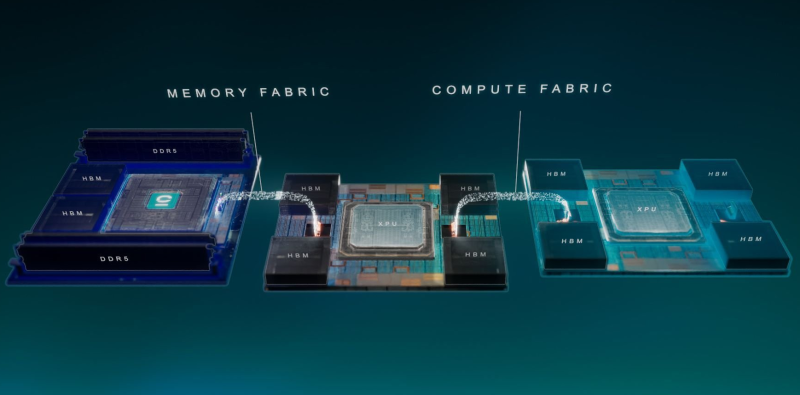

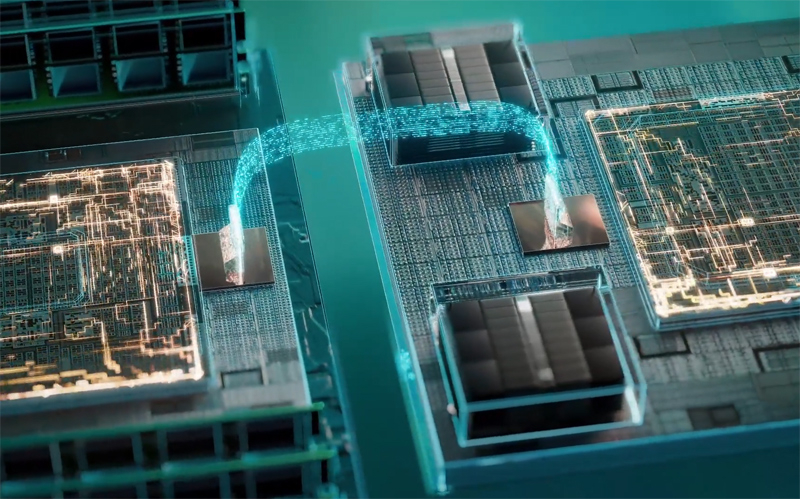

ИИ-ускорители NVIDIA являются самими дорогими в мире контроллерами памяти — Celestial AI предлагает связать оптикой HBM, DDR5 и процессорыВ 2024 году нельзя пожаловаться на отсутствие подходящего интерконнекта, если целью является «сшивка» в единую систему сотен, тысяч или даже десятков тысяч ускорителей. Есть NVIDIA NVLink и InfiniBand. Google использует оптические коммутаторы OCS, AMD вскоре выведет Infinity Fabric на межузловой уровень, да и старый добрый Ethernet отнюдь не собирается сдавать позиций и обретает новую жизнь в виде Ultra Ethernet. Проблема не в наличии и выборе подходящего интерконнекта, а в резкой потере пропускной способности за пределами упаковки чипа (т.н. Memory Wall). Да, память HBM быстра, но намертво привязана к вычислительным ресурсам, а в итоге, как отметил глава Celestial AI в комментарии изданию The Next Platform, индустрия ИИ использует ускорители NVIDIA в качестве самых дорогих в мире контроллеров памяти. Celestial AI ещё в прошлом году объявила, что ставит своей целью создание универсального «умного» интерконнекта на основе фотоники, который смог бы использоваться во всех нишах, требующих активного обмена большими потоками данных, от межкристалльной (chip-to-chip) до межузловой (node-to-node). Недавно она получила дополнительный пакет инвестиций объёмом $175 млн.

Источник изображений здесь и далее: Celestial AI Технология, названная Photonic Fabric, если верить заявлениям Celestial AI, способна в 25 раз увеличить пропускную способность и объёмы доступной памяти при на порядок меньшем энергопотреблении в сравнении с существующими системами соединений. Развивается она в трёх направлениях: чиплеты, интерпозеры и оптический аналог технологии Intel EMIB под названием OMIB. Наиболее простым способом интеграции своей технологии Celestial AI справедливо считает чиплеты. В настоящее время разработанный компанией модуль обеспечивает пропускную способность за пределами чипа на уровне 14,4 Тбит/с (1,8 Тбайт/с), а по размерам он немного уступает стандартной сборке HBM. Но это лишь первое поколение: во втором поколении Photonic Fabric 56-Гбит/с SerDes-блоки SerDes будут заменены на блоки класса 112 Гбит/с (PAM4). Поскольку речь идёт о системах с дезагрегацией ресурсов, проблему быстрого доступа к большому объёму памяти Celestial AI предлагает решить следующим образом: новый чиплет, содержащий помимо интерконнекта две сборки HBM общим объёмом 72 Гбайт, получит также поддержку четырёх DDR5 DIMM суммарным объёмом до 2 Тбайт. С использованием 5-нм техпроцесса такой чиплет сможет легко превратить HBM в быстрый сквозной кеш (write through) для DDR5. Фактически речь идёт об относительно простом и сравнительно доступном способе превратить любой процессор с чиплетной компоновкой в дезагрегированный аналог Intel Xeon Max или NVIDIA Grace Hopper. При этом латентность при удалённом обращении к памяти не превысит 120 нс, а энергозатраты в данном случае составят на порядок меньшую величину, нежели в случае с NVLink — всего 6,2 пДж/бит против 62,5 пДж/бит у NVIDIA. Таким образом, с использованием новых чиплетных контроллеров памяти становятся реальными системы, где все чипы, от CPU до сетевых процессоров и ускорителей, будут объединены единым фотонным интерконнектом и при этом будут иметь общий пул памяти DDR5 большого объёма с эффективным HBM-кешированием. По словам Celestial AI, она уже сотрудничает с некоторыми гиперскейлерами и с одним «крупным производителем процессоров». По словам руководителя Celestial AI, образцы чиплетов с поддержкой Photonic Fabric появятся во II половине 2025 года, а массовое внедрение начнется уже в 2027 году. Однако это может оказаться гонкой на выживание: Ayar Labs, другой разработчик фотоники, получившая поддержку со стороны Intel, уже показала прототип процессора с интегрированным фотонным интерконнектом. А Lightmatter ещё в декабре получила финансирование в объёме $155 млн на разработку фотонного интерпозера Passage и якобы уже сотрудничает с клиентами, заинтересованными в создании суперкомпьютера с 300 тыс. узлов. Нельзя сбрасывать со счетов и Eliyan, предлагающую вообще отказаться от технологии интерпозеров и заменить её на контроллеры физического уровня NuLink.

08.04.2024 [09:48], Сергей Карасёв

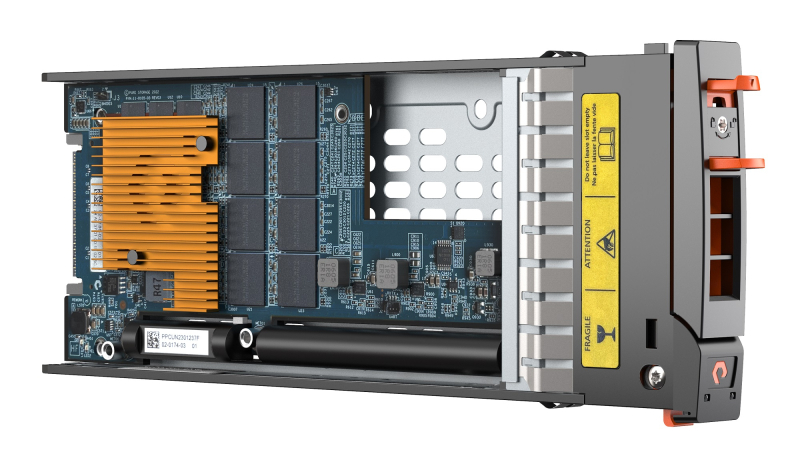

CXL из коробки: Samsung представила стоечный массив памяти CMM-BКомпания Samsung анонсировала решение под названием CXL Memory Module — Box (CMM-B): это массив модулей памяти CXL, предназначенный для монтажа в стойку. Новинка совместима с решениями Supermicro Plug and Play. В состав CMM-B входят восемь пулов CXL-памяти на базе модулей E3.S CMM-D (PCIe 5.0) ёмкостью 2 Тбайт каждый. Таким образом, суммарный объём достигает 16 Тбайт. В составе стойки доступ к этому массиву могут получать три сервера Supermicro. Такая архитектура позволяет выделять необходимый объём памяти в соответствии с текущими нагрузками, устраняя узкие места в вычислительных системах. Через консоль SCMC (Samsung Cognos Management Console) можно отслеживать распределение памяти.

Источник изображений: Samsung Устройство CMM-B выполнено в формате 4U. Заявлена совместимость со стандартами CXL 1.1/2.0. Пропускная способность достигает 60 Гбайт/с, тогда как задержка находится на уровне 596 нс. С точки зрения «чистой» производительности один модуль CMM-B работает медленнее, чем двухканальная подсистема оперативной памяти DDR5-4800. Тем не менее, устройство значительно быстрее, чем даже наиболее передовые SSD.  Представленная стоечная система разработана в тесном сотрудничестве с Supermicro. В состав решения, помимо CMM-B и трёх серверов, входит PCIe-коммутатор. Система предназначена для приложений, которым требуется большой объём памяти, таких как ИИ, анализ массивов информации и in-memory базы данных. CMM-B позволяет динамически выделять необходимую память системе, когда она необходима ей. Благодаря этому повышается гибкость использования инфраструктуры и снижаются энергетические затраты, говорят создатели.

24.03.2024 [02:06], Сергей Карасёв

Micron показала модули памяти MCR DIMM DDR5-8800 ёмкостью 256 ГбайтКомпания Micron, по сообщению ресурса Tom's Hardware, продемонстрировала на конференции NVIDIA GTC 2024 модули оперативной памяти MCR DIMM ёмкостью 256 Гбайт для серверов следующего поколения, в том числе для систем, построенных на процессорах Intel Xeon Granite Rapids. Модули имеют увеличенную высоту, но Micron также намерена выпустить варианты стандартной высоты для серверов типоразмера 1U. Изделия соответствуют стандарту DDR5-8800. С каждой стороны модуля расположены по 40 чипов памяти. Заявленное энергопотребление изделия составляет 20 Вт, тогда как у RDIMM объёмом 128 Гбайт при использовании профиля DDR5-4800 оно равно 10 Вт. Новые изделия Micron позволяют оснащать серверы 3 Тбайт памяти при наличии 12 слотов ОЗУ и 6 Тбайт при наличии 24 слотов. MCR DIMM использует специальный буфер между DRAM и CPU, который позволяет двум физическим рангам функционировать так, как если бы они были двумя отдельными модулями памяти, работающими параллельно. Это позволяет извлекать из памяти вдвое больше данных за каждый такт, а также увеличить скорость обмена информацией с CPU. Таким образом, можно одновременно поднять и ёмкость, и производительность памяти. SK hynix также поддерживает MCR DIMM, а вот AMD и JEDEC готовят альтернативный стандарт MRDIMM, который тоже поддерживает создание высокоёмких модулей DDR5-8800. Впрочем, концептуально оба решения восходят к OMI/DDIMM от IBM и даже FB-DIMM.

23.03.2024 [22:29], Владимир Мироненко

Micron уже продала всю HBM3E-память, которую выпустит в 2024 году и распределила заказы на 2025 годКомпания Micron Technology, приступившая в феврале к массовому производству передовой памяти HBM3E, сообщила, что уже имеет на руках контракты на весь объём поставок до конца 2024 года, а также на большую часть поставок в 2025 году. Память Micron HBM3E (Micron называет её HBM3 Gen2) одной из первых получила сертификацию для использования в ускорителях NVIDIA (G)H200, так что, по всей видимости, Micron станет ключевым поставщиком для NVIDIA, пишет AnandTech. «Наша HBM распродана на 2024 календарный год и подавляющая часть наших поставок на 2025 год уже распределена, — сообщил глава Micron Санджей Мехротра (Sanjay Mehrotra) в комментариях к отчёту за II квартал 2024 финансового года. Первый продукт HBM3E от Micron представляет собой сборку 8-Hi ёмкостью 24 Гбайт с 1024-бит интерфейсом и общей пропускной способностью 1,2 Тбайт/с. NVIDIA H200 использует шесть таких модулей. Micron также начала поставки образцов сборок 12-Hi ёмкостью 36 Гбайт.

Источник изображения: Micron В отчёте за II квартал 2024 финансового года Micron похвасталась результатами, которые оказались значительно выше прогнозов. Напомним, что до этого у компании были убытки пять кварталов подряд. В отчётном квартале Micron получила выручку в размере $5,82 млрд, превысив на 58 % на результат II квартала 2023 финансового года, равный $3,69 млрд, и на 23 % — результат предыдущего квартала, равный $4,73 млрд. При этом доля в общей выручке продаж DRAM составила 71 %, NAND — 27 %. Поставки подразделения сетевых и вычислительных решений (Compute and Networking, CNBU) выросли год к году на 59 % до $2,2 млрд, мобильного подразделения (Mobile, MBU) — на 69 % до $1,6 млрд, у подразделения встраиваемых решений (Embedded, EBU) зафиксирован рост на 28 % до $1,11 млрд, у подразделения решений для СХД — рост на 79 % до $905 млн. Компания сообщила о прибыли в размере $793 млн или $0,71 на акцию, в то время как годом ранее у неё были убытки (GAAP) в $2,31 млрд или $2,12 на акцию. Скорректированная прибыль (non-GAAP) составила $0,42 на акцию по сравнению с убытком в $1,91 на акцию годом ранее. Согласно прогнозу аналитиков, опрошенных FactSet, у Micron должны были быть убытки (non-GAAP) в размере $0,25 на акцию при выручке в $5,35 млрд. В текущем квартале Micron ожидает получить скорректированную прибыль (non-GAAP) в размере $0,42 на акцию при выручке в $6,6 млрд. Аналитики Уолл-стрит прогнозируют в III финансовом квартале прибыль (non-GAAP) в размере $0,09 на акцию при выручке в $6 млрд.

16.03.2024 [23:19], Сергей Карасёв

Pure Storage: рост ёмкости SSD будет ограничен возможностями DRAMКомпания Pure Storage, специализирующаяся на All-Flash СХД, считает, что дальнейшее увеличение вместимости SSD будет сопряжено с рядом трудностей, продиктованных необходимостью применения DRAM. Об этом, как сообщает ресурс Blocks & Files, рассказал Шон Роузмарин (Shawn Rosemarin), вице-президент Pure по исследованиям и разработкам. По его словам, коммерческим SSD требуется примерно 1 Гбайт DRAM на каждый 1 Тбайт флеш-памяти. Наличие DRAM необходимо для подсистемы Flash Translation Layer (FTL). По словам Роузмарина, для накопителя ёмкостью 30 Тбайт требуется 30 Гбайт DRAM, для 75 Тбайт — 75 Гбайт и т. д. Таким образом, для SSD вместимостью, например, 128 Тбайт нужно 128 Гбайт DRAM, а это уже сопоставимо с объёмом ОЗУ в сервере. Роузмарин отмечает, что увеличение вместимости корпоративных SSD свыше 30 Тбайт будет проблематично. Во-первых, DRAM заметно дороже NAND, что приведёт к значительному росту стоимости SSD. Во-вторых, из-за увеличения объёма DRAM возрастает энергопотребление, что не только поднимет стоимость владения, но и ухудшит надёжность накопителя. В результате по мере роста вместимости SSD заказчики могут столкнуться с серьёзным увеличением затрат. Роузмарин заявляет, что единственный способ обойти указанные проблемы — найти более экономичную и менее энергозатратную альтернативу DRAM. Необходимые функции, по его словам, могут быть перенесены непосредственно на ПО СХД. Именно такой подход Pure реализует со своими проприетарными накопителями DFM (Direct Flash Module), последняя модификация которых имеет ёмкость 75 Тбайт. В этих устройствах отсутствует зависимость от DRAM на уровне накопителей. Компания намерена выпустить DFM ёмкостью 150 Тбайт в 2025 году, а на 300 Тбайт — ориентировочно в 2026-м. В дальнейшие планы входит создание изделий вместимостью 600 Тбайт и 1,2 Пбайт. Аналогичного подхода придерживается и IBM в своих накопителях FlashCore Modules (FCM).

28.02.2024 [14:04], Сергей Карасёв

В Samsung разработаны первые в отрасли 12-слойные чипы HBM3E ёмкостью 36 ГбайтКомпания Samsung Electronics объявила о разработке первых в отрасли чипов высокопроизводительной памяти HBM3E в виде 12-ярусных стеков общей ёмкостью 36 Гбайт. Изделия ориентированы на применение в системах ИИ с большой вычислительной нагрузкой. Новые чипы Samsung HBM3E обеспечивают пропускную способность до 1280 Гбайт/с. По этому показателю, как утверждается, решения более чем на 50 % превосходят доступные на рынке 8-слойные стеки HBM3. При изготовлении чипов Samsung применяет технологию термокомпрессии в комплексе с диэлектрической плёнкой. В результате, суммарная высота полученных 12-слойных изделий эквивалентна высоте 8-слойных. Samsung добилась наименьших в отрасли зазоров в стеке — всего 7 мкм, а также устранила пустоты между слоями. Это позволило поднять плотность вертикальной компоновки более чем на 20 % по сравнению с 8-слойными продуктами HBM3. Кроме того, при производстве стеков Samsung использует между слоями памяти контактные выступы разного размера. Небольшие выступы служат для передачи сигналов, тогда как более крупные улучшают отвод тепла. Такой подход, по заявлениям Samsung, также способствует снижению доли брака. В целом, как утверждается, внедрение 12-слойной памяти HBM3E по сравнению с 8-слойными изделиями даёт возможность увеличить скорость обучения ИИ-моделей на 34 %, тогда как количество одновременно обслуживаемых пользователей систем инференса может вырасти в 11,5 раз. Пробные поставки новых чипов уже начались, а массовое производство намечено на I половину 2024 года. Нужно отметить, что буквально на днях компания Micron объявила о начале массового производства 8-слойной памяти HBM3E на 24 Гбайт с пропускной способностью более 1,2 Тбайт/с. Кроме того, Micron уже в марте начнёт распространять образцы 12-ярусных чипов HBM3E ёмкостью 36 Гбайт.

27.02.2024 [13:25], Сергей Карасёв

Micron начала массовое производство памяти HBM3E для ускорителей NVIDIA H200Компания Micron Technology объявила о начале массового производства передовой памяти HBM3E. Речь идёт об изделиях ёмкостью 24 Гбайт, предназначенных для ИИ-ускорителей NVIDIA H200, которые появятся на коммерческом рынке во II квартале нынешнего года. Чипы Micron HBM3E выполнены в виде 8-ярусного стека. Заявленная скорость передачи данных превышает 9,2 Гбит/с на контакт, а общая пропускную способность сборки превосходит 1,2 Тбайт/с. Вместе с тем, как утверждается, изделия потребляют примерно на 30 % меньше энергии по сравнению с решениями конкурентов. Micron подчёркивает, что чипы HBM3E объёмом 24 Гбайт позволяют дата-центрам беспрепятственно масштабировать различные ИИ-нагрузки — от обучения сложных нейронных сетей до ускорения инференса. Изделия выполнены по технологии 1β (1-бета) — самому передовому техпроцессу компании. Кроме того, применены другие современные методики упаковки чипов, включая усовершенствованную технологию сквозных соединений TSV (Through-Silicon Via). Micron также сообщила, что уже в марте нынешнего года начнёт распространять образцы 12-ярусных чипов HBM3E ёмкостью 36 Гбайт. Они, как и изделия на 24 Гбайт, обеспечат пропускную способность свыше 1,2 Тбайт/с при высокой энергетической эффективности.

10.02.2024 [14:50], Сергей Карасёв

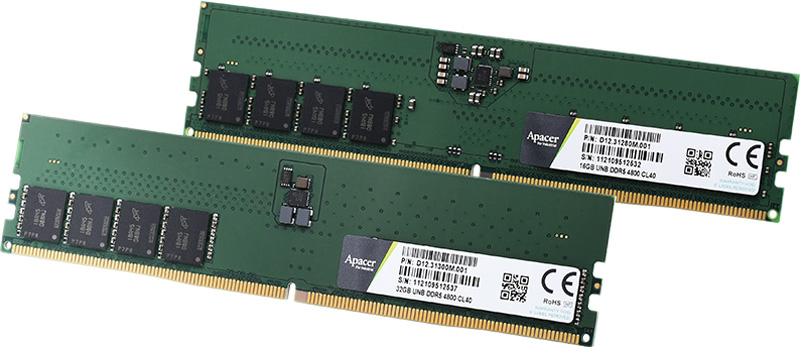

Apacer выпустила экологичные бессвинцовые модули ОЗУ для индустриального сектораКомпания Apacer, сообщила о доступности, как утверждается, первых в мире модулей оперативной памяти стандарта DDR5, компоненты которых полностью не содержат свинца. Изделия превосходят требования действующей директивы защиты окружающей среды RoHS, принятой Европейским союзом. Отмечается, что обычные модули ОЗУ, представленные на рынке, содержат свинец в своих резисторных элементах. Вместе с тем во всём миру принимаются всё более жёсткие экологические нормы, требующие в том числе отказа от применения этого тяжёлого металла.

Источник изображения: Apacer Чтобы решить указанную проблему, компания Apacer после длительного периода исследований и разработок успешно создала полностью бессвинцовые модули памяти с резисторными компонентами нового типа. Эти решения в полной мере соответствуют стандартам RoHS без потери производительности. В семействе представлены модули (ECC) UDIMM, (ECC) SO-DIMM и RDIMM стандарта DDR5-4800/5600. Напряжение питания во всех случаях равно 1,1 В; диапазон рабочих температур простирается от 0 до +85 °C. Изделия UDIMM и SO-DIMM доступны в вариантах ёмкостью 8, 16 и 32 Гбайт, а ECC UDIMM и ECC SO-DIMM — 16 и 32 Гбайт. В случае RDIMM объём варьируется от 16 до 128 Гбайт. В качестве сфер применения модулей названы оборона, автоматизация производства, здравоохранение, Интернет вещей, серверы, сетевое оборудование и пр. |

|