Материалы по тегу: cloud

|

13.05.2024 [22:33], Владимир Мироненко

Ресурсы в обмен на технологии: Alibaba Cloud предлагает ИИ-стартапам GPU-мощности за долю в компанииКитайский гигант электронной коммерции Alibaba по примеру Microsoft, финансировавшей успешный ИИ-стартап OpenAI, пытается расширить своё присутствие на рынке ИИ-технологий с помощью инвестиций в китайские стартапы в области генеративного ИИ. Разница лишь в том, что Alibaba предлагает большей частью не традиционное финансирование деньгами, а кредиты на использование своей облачной инфраструктуры для обучения ИИ-моделей, пишет газета Financial Times. В числе стартапов, пользующихся поддержкой Alibaba, газета назвала Moonshot, Zhipu, MiniMax и 01.ai, которые разрабатывают локальные версии американских приложений, таких как ChatGPT и чат-бот-аватар Character.ai. Так, в феврале этого года Alibaba возглавила раунд финансирования Moonshot AI, разработчика ИИ-решений для компаний в сфере электронной коммерции, включая чат-бот Kimi AI, привлёкшего $1 млрд инвестиций, после чего его рыночная стоимость оценивалась в $2,5 млрд. По словам источников Financial Times, Alibaba инвестировала в Moonshot AI $800 млн, но лишь чуть больше половины было предоставлено деньгами, а остальная часть поступила в виде кредитов на облачные вычисления. Как утверждают источники, в течение 2023 года глава Alibaba Эдди Юнмин У (Eddie Yongming Wu) лично контролировал выделение инвестиций четырём ведущим ИИ-стартапам Китая, что говорит о том, какое значение компания придаёт этому направлению. После отказа из-за санкций США от амбициозного плана реструктуризации, предполагавшего проведение IPO облачным подразделением, на фоне растущей конкуренцией со стороны ByteDance и PDD Holdings на своём основном рынке электронной коммерции, Alibaba пытается найти новые драйверы роста. После отмены реструктуризации Эдди Юнмин У взял под личный контроль облачный бизнес, сделав ставку на ИИ в скорректированной стратегии по стимулированию роста компании. Порядок выделения инвестиций Alibaba в Moonshot повторяет подход Microsoft и Amazon, согласно которому денежные средства передаются ИИ-стартапам при условии, что те будут использовать их для обучения и запуска моделей в облаках Azure и AWS соответственно. Разница заключается в том, что в случае Alibaba напрямую деньги никогда не передаются китайским стартапам. Вместо этого они хранятся на условном депонировании, который компания может считать поступающим доходом. «Предоставление вычислений на самом деле более ценно, чем наличные, — заявил китайский эксперт в области ИИ. — Из-за нехватки чипов очень сложно получить доступ к кластеру Alibaba из 10 тыс. ускорителей». Alibaba Cloud и другие игроки успели приобрести крупные объёмы современных ускорителей NVIDIA, в том числе урезанные A800 и H800, прежде чем США ввели ограничения. И теперь компания стремится извлечь из владения ими выгоду, прежде чем они устареют. Крупнейшие интернет-компании Китая, в том числе Alibaba, Meituan, Xiaohongshu и Tencent, играют огромную роль в финансировании новой волны ИИ-стартапов по сравнению с предыдущим поколением стартапов, где доминировали компании SenseTime и Megvii, специализирующиеся на разработке решений для распознавания лиц и видеонаблюдения.

11.05.2024 [00:11], Сергей Карасёв

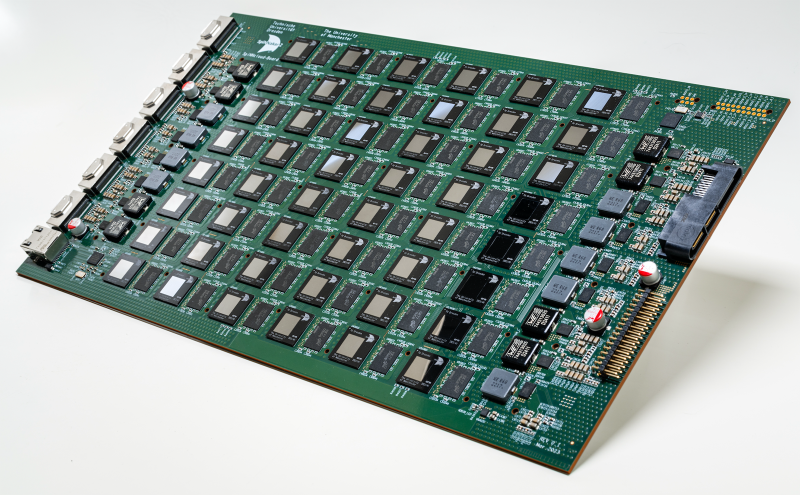

SpiNNcloud представила первый коммерческий «нейроморфный суперкомпьютер» SpiNNaker2 на базе ArmКомпания SpiNNcloud Systems анонсировала «нейроморфный суперкомпьютер» — гибридную высокопроизводительную вычислительную ИИ-систему, основанную, по словам компании, на принципах работы человеческого мозга. Утверждается, что это первое коммерчески доступное решение данного типа. Изделие базируется на архитектуре, разработанной Стивом Фербером (Steve Furber), одним из создателей оригинального процессора Arm. Идея заключается в применении большого количества маломощных чипов для более эффективной обработки ИИ-задач и других рабочих нагрузок. SpiNNaker2 представляет собой специализированную серверную плату с 48 чипами, каждый из которых насчитывает 152 ядра Arm. Таким образом, общее количество ядер составляет 7296. В состав чипов также входят различные дополнительные узлы, включая распределённые GPU-подобные блоки для ускорения обработки нейроморфных, гибридных и обычных моделей ИИ. В одну стойку могут монтироваться до 90 плат SpiNNaker2. Масштабирование осуществляется путём объединения таких стоек в кластер. В результате, как утверждается, возможно эмулирование в реальном времени как минимум 10 млрд взаимосвязанных нейронов. На операциях машинного обучения производительность может достигать 0,3 Эопс (1018 операций в секунду). Для сравнения — исследовательский нейроморфный компьютер Intel Hala Point поддерживает до 1,15 млрд нейронов и производительность до 30 Попс. От традиционных ИИ-платформ на базе GPU новое решение отличается универсальностью, говорит компания. Благодаря использованию многочисленных асинхронных блоков с низким энергопотреблением достигается более эффективное управление рабочими нагрузками. Со II половины 2024 года изделия SpiNNaker2 будут доступны в составе облачной платформы. В I половине 2025-го планируется организовать поставки самостоятельных систем. В число первых заказчиков SpiNNaker2 вошли Национальные лаборатории Сандия (Sandia National Laboratories), Технический университет Мюнхена (TUM) и Гёттингенский университет (Universität Göttingen).

09.05.2024 [23:56], Владимир Мироненко

Red Hat представила ИИ-дистрибутив RHEL AI, который требует минимум 320 Гбайт GPU-памяти

ibm

ibm cloud

linux

llm

open source

openshift

red hat

red hat enterprise linux

software

ии

разработка

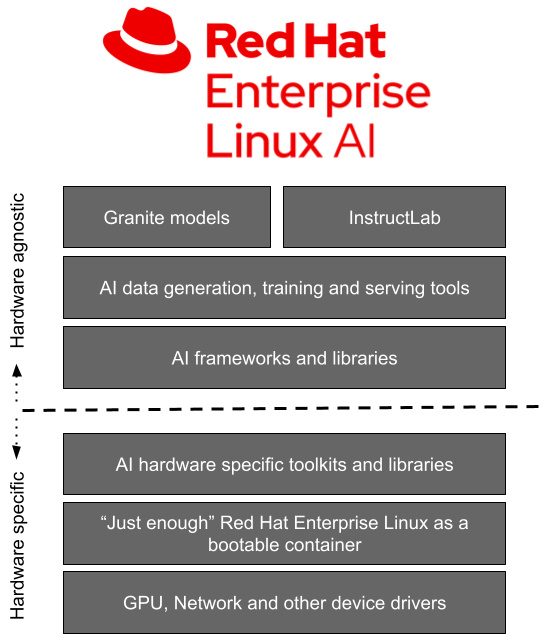

Red Hat представила Red Hat Enterprise Linux AI (RHEL AI), базовую платформу, которая позволит более эффективно разрабатывать, тестировать и запускать генеративные модели искусственного интеллекта (ИИ) для поддержки корпоративных приложений. Фактически это специализированный дистрибутив, включающий базовые модели, инструменты для работы с ними и необходимые драйверы.

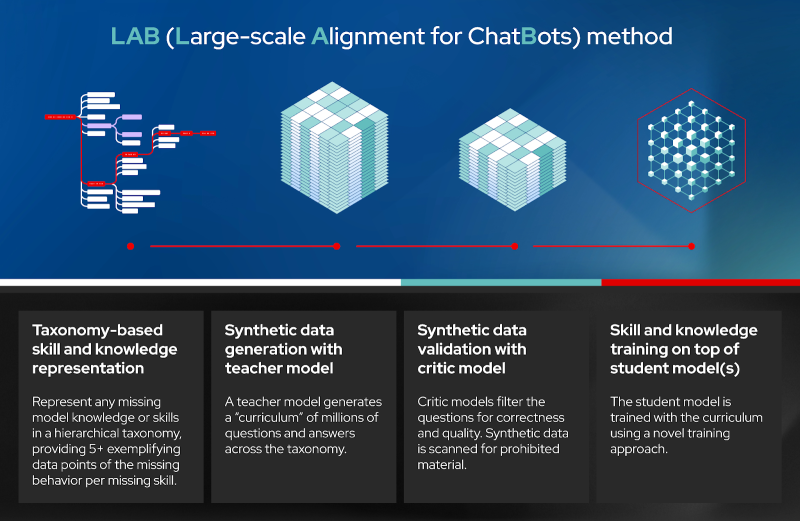

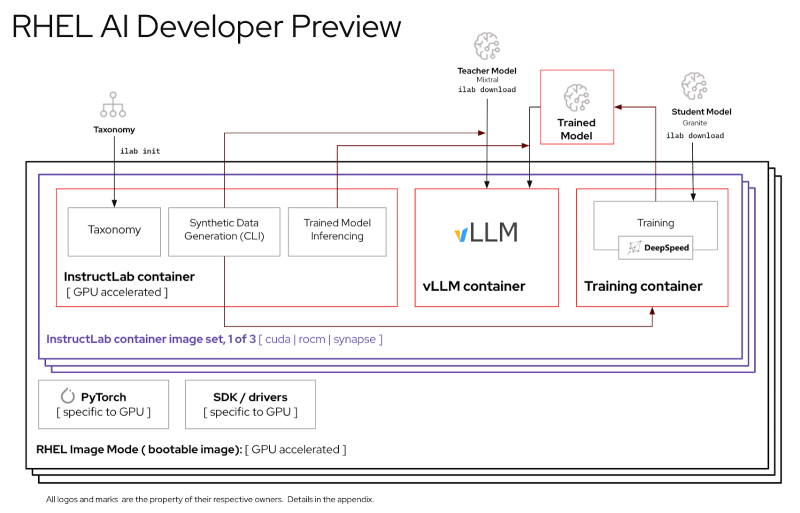

Источник изображений: Red Hat Доступная сейчас в качестве превью для разработчиков, платформа RHEL AI включает в себя семейство больших языковых моделей (LLM) IBM Granite, недавно ставших доступными под лицензией Apache 2.0, инструментом тюнинга и доработки моделей InstructLab посредством методики LAB (Large-Scale Alignment for Chatbots), а также различные библиотеки и фреймворки.  Решение представляется в виде готового для развёртывания образа и является частью MLOps-платформы OpenShift AI. По словам Red Hat, RHEL AI предоставляет поддерживаемую, готовую к корпоративному использованию среду для работы с ИИ-моделями на аппаратных платформах AMD, Intel и NVIDIA. По словам компании, open source подход позволит устранить препятствия на пути реализации стратегии в области ИИ, такие как недостаток навыков обработки данных и финансовых возможностей. Основная цель RHEL AI и проекта InstructLab — предоставить экспертам в предметной области возможность напрямую вносить свой вклад в большие языковые модели, используя свои знания и навыки. Новая платформа позволит им более эффективно создавать приложения с использованием ИИ, например, чат-боты. Впоследствии при наличии подписки RHEL AI компания предложит поддержку корпоративного уровня на протяжении всего жизненного цикла продукта, начиная с модели Granite 7B и ПО и заканчивая возможным возмещение ущерба в отношении интеллектуальной собственности. «Опираясь на инфраструктуру GPU, доступную в IBM Cloud, которая используется для обучения моделей Granite и поддержки InstructLab, IBM Cloud получит поддержку RHEL AI и OpenShift AI. Эта интеграция позволит предприятиям легче внедрять генеративный ИИ в свои критически важные приложения», — отметила компания. При этом прямо сейчас для запуска RHEL AI требуются весьма производительные сертифицированные системы с ускорителями, имеющими минимум 320 Гбайт памяти, а также хранилищем ёмкостью от 200 Гбайт. Среди протестированных указаны серверы Dell с четырьмя NVIDIA H100, Lenovo с восемью AMD Instinct MI300X, а также инстансы IBM Cloud GX3. Вскоре обещана поддержка инстансов AWS EC2 P5 с NVIDIA H100 и ускорителей Intel.

09.05.2024 [21:40], Владимир Мироненко

Google Cloud случайно удалила частное облако австралийского пенсионного фонда UniSuper. И запасное тожеОколо недели более полумиллиона участников австралийского пенсионного фонда UniSuper не имели доступа к своим аккаунтам из-за сбоя, который привёл к удалению частного облака фонда в Google Cloud, пишет The Guardian. Главы UniSuper и Google Cloud выступили с совместным заявлением, согласно которому это был «отдельный, “единственный в своем роде случай”, который никогда раньше не происходил ни с одним из клиентов Google Cloud во всем мире». В Google Cloud отметили, что «сбой произошёл из-за беспрецедентной последовательности событий, в результате которых непреднамеренная неправильная конфигурация во время предоставления услуг частного облака UniSuper в конечном итоге привела к удалению подписки фонда на частное облако». Облачный провайдер заявил, что выявил события, которые привели к этому сбою, и принял меры, чтобы это больше не повторилось.

Источник изображения: UniSuper UniSuper дублирует данные в двух географических регионах, чтобы восстановить работу в случае потери одного из них. Но поскольку была удалена облачная подписка фонда целиком, это привело к потере в обоих облачных регионах. К счастью, фонд имел резервные копии у другого провайдера, поэтому данные удалось восстановить. Ранее UniSuper распределял рабочие нагрузки между сервисами Azure и двумя собственными ЦОД, но в прошлом году перенёс большую часть нагрузок на платформу Google Cloud Platform. UniSuper управляет средствами на сумму около $125 млрд. К полудню четверга по австралийскому времени облачная инфраструктура UniSuper восстановила работу, а участники фонда получили доступ к своим аккаунтам. Вместе с тем балансы счетов пока не будут обновляться, хотя, как сообщается, часть операций уже доступна, а финансы участников не пострадали. Google также заверила членов UniSuper, что сбой не был вызван кибератакой и, следовательно, их конфиденциальные данные не были раскрыты неавторизованным лицам. Сбои облачных сервисов случались и раньше, причём с ним сталкивались и основные провайдеры, включая AWS и Microsoft Azure. Но они справлялись с проблемами довольно быстро, чего не произошло в случае с UniSuper. Это может нанести ущерб Google с репутационной точки зрения и вызвать у клиентов недоверие к компании как поставщику услуг, говорит глава EEITrend. «На устранение сбоя в облаке UniSuper в Google Cloud в Австралии ушло необычно много времени, что негативно влияет на репутацию Google Cloud в регионе», — отметил он.

07.05.2024 [17:30], Руслан Авдеев

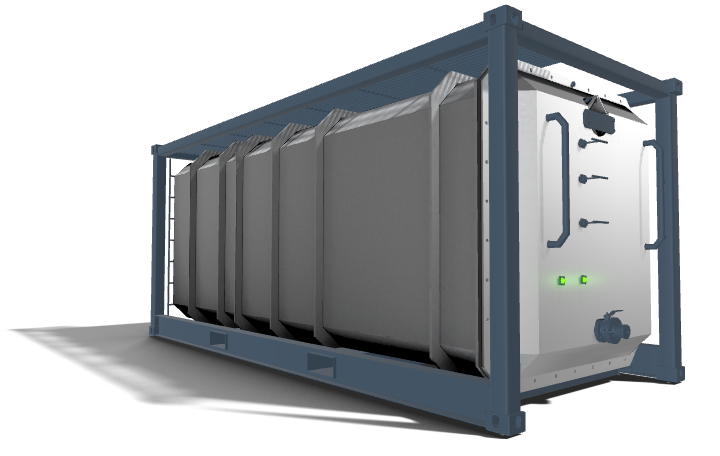

Subsea Cloud предложила протестировать её подводный дата-центр у берегов НорвегииОператор глубоководных дата-центров Subsea Cloud предложил потенциальным клиентам оценить возможности своего ЦОД в течение 90 дней. Как сообщает The Register, так компания пытается привлечь новых пользователей — если в последние три года дорогостоящие испытания проводились индивидуально, то теперь доступ к необычным дата-центрам упростится. В Subsea заявляют, её дата-центры имеют на 40 % меньше углеродных выбросов, а операционные расходы для клиентов на 30 % меньше в сравнении с наземными ЦОД. Наконец, затрат энергии и воды на охлаждение вовсе нет. Изюминка Subsea Cloud в том, что компания предлагает не просто подводные, а именно глубоководные (до 3000 м) решения. В 2022 году компания сообщала о внедрении первого коммерческого подводного проекта в районе Порт-Анджелеса (штат Вашингтон), дополнительные ЦОД планировалось развернуть в Мексиканском заливе и Северном море. В рамках Project OTTO компания предложит протетсировать возможности своего ЦОД недалеко от юго-западного побережья Норвегии. Первая фаза стартует в октябре. Участникам будут доступны тестовые периоди длительностью 30, 60 и 90 дней. При этом поучаствовать в тестировании можно только один раз — за исключением случаев, когда потенциальные клиенты захотят значительно изменить аппаратную составляющую своего оборудования, что потребует дальнейших тестов. О стоимости тестирования ничего не говорится, но компания предупреждает, что в случае отказать подписать соглашение о дальнейшем развёртывании мощностей продление тестирования не будет доступно. Базовый модуль Subsea Cloud представляет собой ёмкость размерами 6,1 × 2,6 м, практически тех же габаритов, что и стандартный 20-футовый контейнер — в нём можно разместить до 16 стоек мощностью до 150 кВт каждая (суммарно до 1,5 МВт) или 826 серверов. Для охлаждения используется погружная СЖО. Компания может предоставить клиентам и собственные серверы. В целом конфигурация ЦОД рассчитана на высокоплотное размещение энергоёмких систем, например, для ИИ- и HPC-нагрузок. Срок службы модуля составляет 25–30 лет.

Источник изображения: Subsea Cloud Подводные ЦОД пытаются внедрять не впервые. Microsoft в течение нескольких лет развивала Project Natick. Этот проект был признан успешным, но коммерциализировать компания его не стала в отличие от аналогичного проекта Highlander в Китае. Одним из сдерживающих клиентов факторов является отсутствие лёгкого доступа к оборудованию в подводных дата-центрах. По словам Subsea Cloud на то, чтобы добраться до модуля и заменить или обслужить серверы, уйдёт 4–16 часов. В Subsea Cloud рассчитывают на сотрудничество с офшорными ветряными электростанциями — это обеспечит подводным ЦОД удобный доступ к возобновляемой энергии. Кроме того, компания намерена подключать свои подводные кампусы непосредственно к подводным ВОЛС. При этом в компании подчёркивают, что общая стоимость обслуживания значительно ниже, чем у обычных ЦОД. Правда, сама же говорит, что экономически целесообразно развёртывание не менее 20 модулей.

30.04.2024 [13:02], Сергей Карасёв

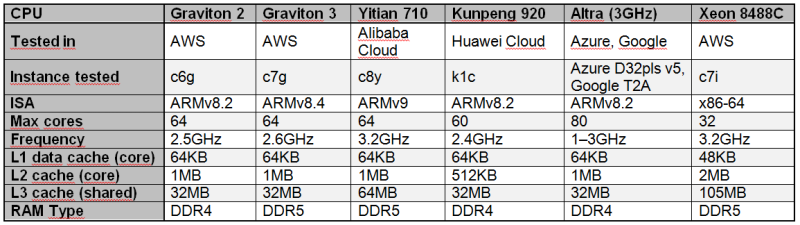

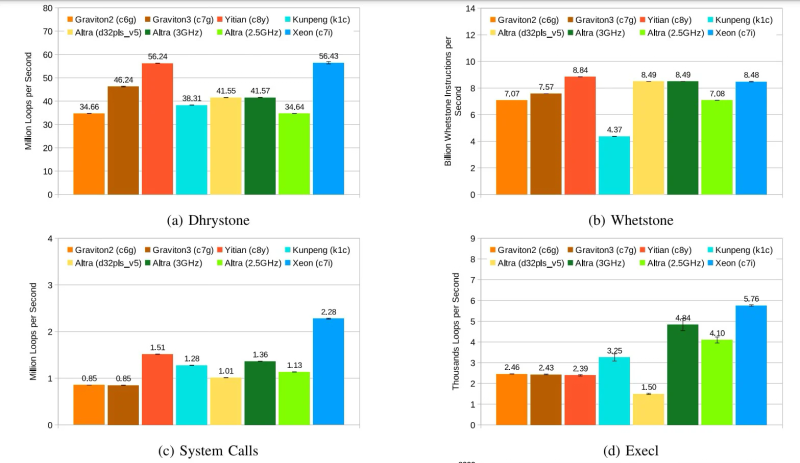

Alibaba Yitian 710 признан самым быстрым облачным Arm-процессором в ряде бенчмарковСогласно результатам исследования, обнародованным Институтом инженеров электротехники и электроники (IEEE) в журнале Transactions on Cloud Computing, процессор Alibaba Yitian 710 на сегодняшний день является самым производительным серверным чипом с архитектурой Arm из тех, которые доступны в составе различных облачных платформ, передаёт The Register. Изделие Yitian 710 было создано подразделением T-Head специально для нужд Alibaba Cloud и дебютировало в 2021 году. Этот 5-нм процессор на базе Armv9 насчитывает до 128 ядер с частотой до 3,2 ГГц. Обеспечивается поддержка восьми каналов памяти DDR5 и 96 линий PCIe 5.0. При этом чипы отличаются высокой энергетической эффективностью. Alibaba Cloud рассчитывала перенести пятую часть своих мощностей на собственные Arm-чипы к 2025 году. В ходе исследования чип Yitian 710 в конфигурации с 64 ядрами сравнивался с Arm-процессорами Amazon Graviton 2/3 (64 ядра), Huawei Kunpeng 920 (60 ядер) и Ampere Altra (80 ядер), а также с х86-чипом Intel Xeon Platinum 8488C поколения Sapphire Rapids. Тестирование проводилось в различных облачных средах, включая Amazon Web Services (AWS), Alibaba Cloud, Huawei Cloud, Microsoft Azure, Google Cloud Platform. Оценивалось быстродействие при выполнении различных задач: классические бенчмарки Dhrystone и Whetstone, ряд системных вызовов ядра и вызовов execl, скорость копирования файлов, показатель UnixBench, подписи и аутентификация с использованием криптографического алгоритма RSA 2048, а также работа с СУБД. Как отмечается, практически во всех перечисленных тестах процессор Alibaba опережал конкурирующие чипы с архитектурой Arm. В задачах Whetstone изделие Yitian 710 также превзошло процессор Xeon Platinum и чип Altra. Вместе с тем Graviton 3 показал превосходство в тесте Redis. Тем не менее, Yitian 710 сохранил своё преимущество в двух из трёх задач RocksDB. В плане эффективности чипам Arm требуется больше системных вызовов, чем их конкурентам Intel. Но в некоторых сценариях использования решения Arm всё равно оказываются более предпочтительными.

30.04.2024 [11:27], Сергей Карасёв

M1Cloud предложил частные облака для среднего и крупного бизнесаСервис-провайдер M1Cloud (Stack Group) анонсировал новую услугу, в рамках которой предприятиям среднего и крупного бизнеса предлагается построение частного облака на выделенном оборудовании. Сервис ориентирован прежде всего на те организации, которые переносят информационные системы из собственного дата-центра на облачную платформу. Новая услуга предполагает, что выделяемые ресурсы использует исключительно организация — заказчик. Это обеспечивает высокий уровень безопасности и гарантирует максимальную производительность, стабильность и надёжность работы IT-служб компании. «Частное облако гибко интегрируется в имеющийся IT-ландшафт. В ходе проработки архитектуры решения сервис-провайдер M1Cloud подбирает нужные технологии и сервисы, объём вычислительных ресурсов с учётом необходимой производительности и доступности данных», — говорит провайдер. В состав частного облака входит вычислительный кластер с серверами. Ещё один компонент — СХД с накопителями разного типа: это могут быть HDD с интерфейсом SATA/SAS, а также SSD. Администрирование и поддержка осуществляются экспертной технической службой M1Cloud. Дополнительно могут быть настроены аудит действий администратора и мониторинг инфраструктуры, шифрование накопителей, микросегментация сети для виртуальных машин и роутинг с существующей сетью организации. По желанию заказчика могут быть определены гранулярные права доступа и роли пользователей. Предусмотрены различные варианты маршрутизации сетей и портал для самостоятельной настройки резервного копирования. Отмечается, что частные облака формируются под конкретные задачи клиента, а архитектура таких решений максимально соответствует специфики операционных процессов и особенностям отрасли. В результате, заказчик получает наиболее эффективную облачную среду, оптимизированную с точки зрения оборудования и финансовых возможностей бизнеса.

29.04.2024 [20:11], Владимир Мироненко

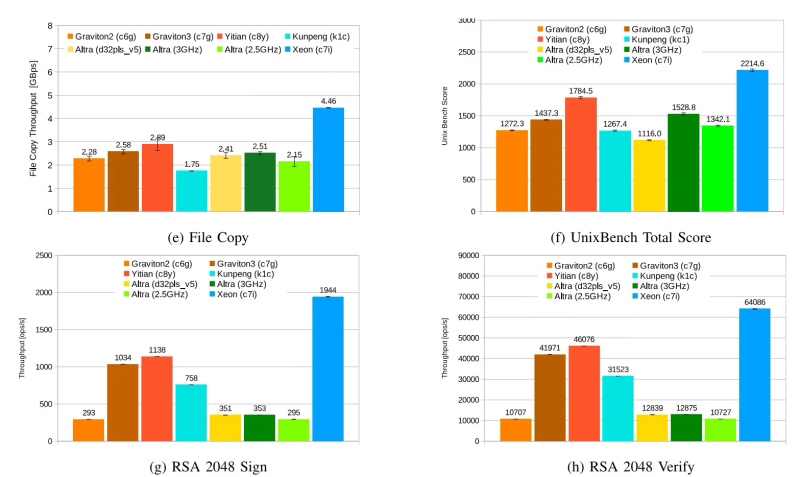

Выручка Yandex Cloud выросла в I квартале 2024 года на 58 % благодаря росту спроса на облачные сервисыМКПАО «Яндекс», российская частная независимая IT-компания, объявила неаудированные финансовые результаты за I квартал 2024 года. Выручка в I квартале 2024 года выросла на 40 % год к году до 228,3 млрд руб., чистая прибыль увеличилась на 47 % до 19,4 млрд руб. Ещё больше вырос скорректированный показатель EBITDA — на 107 % до 37,6 млрд руб. Также увеличился штат сотрудников компании, составивший на конец отчётного периода 25,9 тыс. человек, что на 20 % больше, чем годом ранее. Чтобы лучше отражать операционные показатели, начиная с I квартала 2024 года «Яндекс» внёс ряд изменений в структуру сегментов. Помимо, например, облачной платформы Yandex Cloud сегмент «Прочих бизнес-юнитов и инициатив» теперь включает направление разработки беспилотных автомобилей (Yandex SDG), «Яндекс 360», «Яндекс Образование» («Яндекс Практикум» и другие образовательные инициативы), «Устройства и Алису», «Финтех» (в том числе «Яндекс Пэй» и «Яндекс ID») и другие экспериментальные продукты, а также корпоративные расходы, не относящиеся к сегментам напрямую. В I квартале 2024 года этот сегмент принёс компании выручку в размере 22,8 млрд руб. (рост год к году на 69 %). Вместе с тем убыток по скорректированному показателю EBITDA составил 9,3 млрд руб., что на 64 % больше, чем в прошлом году. Рентабельность скорректированного показателя EBITDA/(убыток) равна −40,8 % (убыток на 1,2 п.п. меньше год к году). Как отмечено в пресс-релизе, рост выручки связан в основном с увеличением доходов направлений «Финтеха» и Yandex Cloud, а также «Устройств и Алисы». Выручка Yandex Cloud увеличилась на 58 % год к году благодаря расширению спектра предоставляемых услуг и увеличению доли на рынке на фоне растущего спроса на облачные сервисы «Яндекса». Рост убытка по скорректированному показателю EBITDA в абсолютных значениях в основном обусловлен инвестициями в рост бизнесов, а также увеличением нераспределённых корпоративных расходов, которые были частично скомпенсированы результатами Yandex Cloud. Убыток по скорректированному показателю EBITDA «Прочих бизнес-юнитов и инициатив» в проценте от выручки сегмента уменьшился на 1,2 п.п. благодаря улучшению операционной эффективности по ряду направлений, включая «Финтех».

11.04.2024 [17:57], Владимир Мироненко

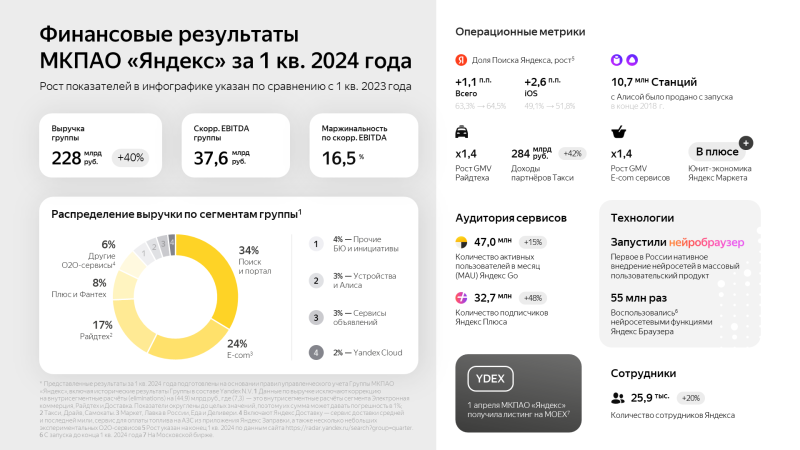

Yandex Cloud запустила облачные сервисы для пользователей в Казахстане и Центральной Азии на базе ЦОД в КарагандеОблачная платформа Yandex Cloud объявила о запуске нового региона kz1 на базе ЦОД в Казахстане, благодаря чему пользователям республики и Центральной Азии стал доступен широкий выбор облачных сервисов и технологий Yandex. Тарификация сервисов производится в тенге. А для развития IT-рынка в Казахстане компания выделила гранты 74 компаниям на сумму свыше 160 млн тенге в рамках программы Yandex Cloud Boost. Компании региона получили возможность использовать решения Yandex Cloud для хранения и обработки данных, технологии искусственного интеллекта (ИИ), машинного обучения, а также различные инструменты для разработки, тестирования и запуска собственных цифровых продуктов. ЦОД с серверной инфраструктурой находится в Караганде, а офисы компании — в Астане и Алматы. В казахстанском офисе работает команда технических специалистов и экспертов. С помощью сервиса распознавания и синтеза речи Yandex SpeechKit с поддержкой казахского и узбекского языков компании смогут создавать голосовых помощников и роботов для кол-центров. Также они смогут использовать решения для хранения, обработки и анализа данных, средства мониторинга и управления ресурсами облака, а также решения для обеспечения безопасности облачной инфраструктуры Yandex Cloud. Запуск нового региона выполнен в рамках долгосрочной стратегии развития Yandex Cloud в Казахстане и Центральной Азии. Как сообщает компания, её сервисы и решения уже используют в своей работе десятки казахстанских компаний крупного и среднего бизнеса, стартапы и организации государственного сектора, включая Kolesa Group, Technodom, Бухта, HR Messenger, TargetAI, 1Fit, Demetra и Rocket Firm.

10.04.2024 [01:30], Алексей Степин

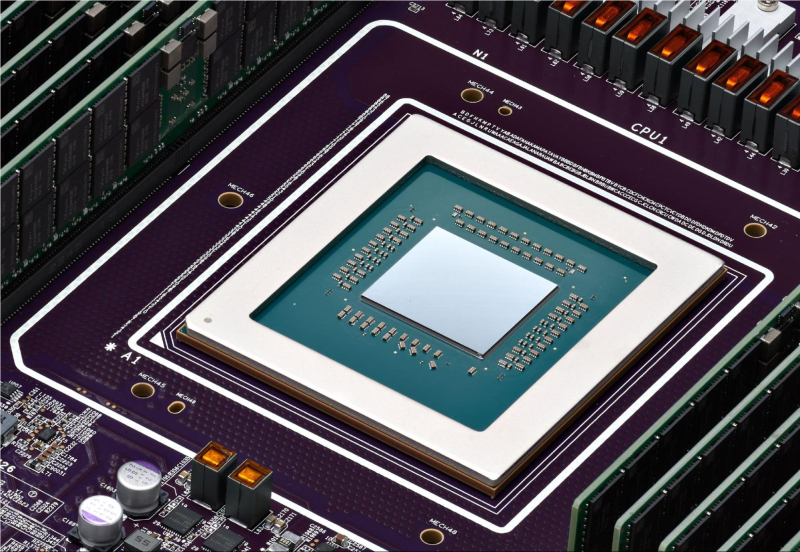

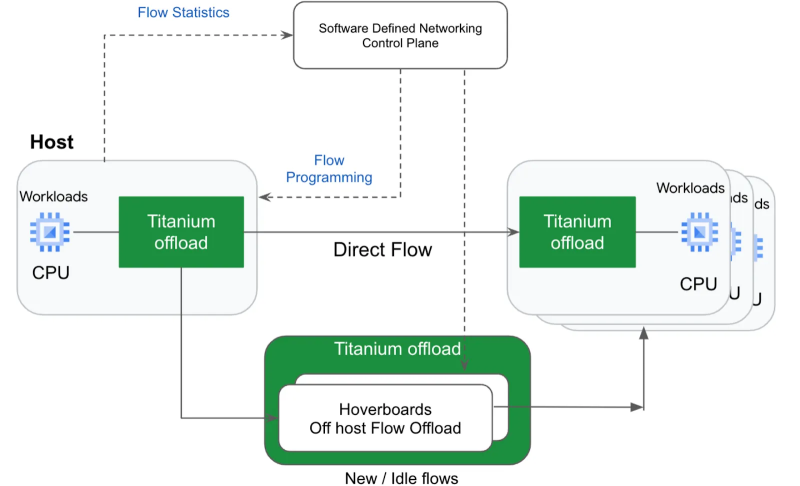

Google анонсировала Axion, свой первый серверный Arm-процессорКомпания Google объявила о выпуске собственного процессора для своих ЦОД. В основу новинки, получившей имя Axion, легла архитектура Arm, что ставит её в один ряд с Amazon Graviton, Alibaba Yitian и Microsoft Cobalt. Это не первый процессор, разработанный Google: c 2015 года компания успела создать пять поколений ИИ-ускорителей Tensor Processing Units (TPU), а в 2018 она представила процессор Video Coding Unit (VCU) Argos для транскодирования видео. Но Axion стал первым чипом Google, который подпадает под определение «процессор общего назначения». При его создании компания сделала упор не только на энергоэффективность, но и на высокий уровень производительности, достаточный для использования в современных серверах. В основу Axion легли Armv9-ядра Neoverse V2 (Demeter). Этот же дизайн используется в AWS Graviton4 и NVIDIA Grace. К сожалению, архитектурных подробностей Google пока не раскрывает, известно лишь, что ядра Neoverse V2 работают совместно с фирменными контроллерами Titanium. Последние отвечают за работу с сетью, защиту и разгрузку IO-операций при работе с блочным хранилищем Hyperdisk, то есть чем-то напоминают AWS Nitro. При этом Google вложилась в SystemReady Virtual Environment (VE), чтобы упростить перенос нагрузок на новые чипы как для себя, так и для пользователей облака. Если верить разработчикам, на момент анонса Google инстансы на базе Axion минимум на 30 % производительнее инстансов на базе самых быстрых Arm-процессоров других вендоров, а по сравнению с сопоставимыми по классу x86-процессорами преимущество может достигать и 50 % при 60 % выигрыше в энергоэффективности. Судя по всему, Axion ранее был известен под кодовым именем Cypress. А ещё один Arm-процессор Google Maple, который, по слухам, являлся наследником почивших Marvell ThunderX, в серию, видимо, не пошёл. Сама компания уже начала переводить на Axion сервисы BigTable, Spanner, BigQuery, Blobstore, Pub/Sub, Google Earth Engine и YouTube Ads. Ряд клиентов и партнёров Google уже оценили Axion по достоинству. Виртуальные машины с новыми процессорами будут доступны в ближайшие месяцы. Они же будут доступны и в Kubernetes Engine, Dataproc, Dataflow, Cloud Batch и т.д. |

|