Материалы по тегу: nvidia

|

21.03.2024 [00:51], Владимир Мироненко

Облачный ИИ-суперкомпьютер AWS Project Ceiba получит 21 тыс. суперчипов NVIDIA GB200

aws

b100

dgx cloud

gb200

gtc 2024

hardware

nvidia

ии

инференс

информационная безопасность

облако

суперкомпьютер

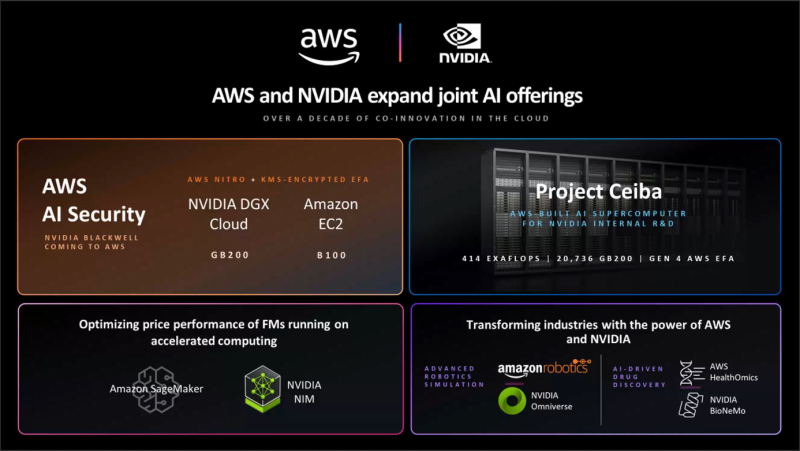

Amazon Web Services (AWS) и NVIDIA объявили о расширении сотрудничества, в рамках которого ускорители GB200 и B100 вскоре появятся в облаке AWS. Кроме того, компании объявили об интеграции Amazon SageMaker с NVIDIA NIM для предоставления клиентам более быстрого и дешёвого инференса, о появлении в AWS HealthOmics новых базовых моделей NVIDIA BioNeMo, а также о поддержке AWS обновлённой платформы NVIDIA AI Enterprise. Сотрудничество двух компаний позволило объединить в единую инфраструктуру их новейшие технологии, в том числе многоузловые системы на базе чипов NVIDIA Blackwell, ПО для ИИ, AWS Nitro, сервис управления ключами AWS Key Management Service (AWS KMS), сетевые адаптеры Elastic Fabric (EFA) и кластеры EC2 UltraCluster. Предложенная инфраструктура и инструменты позволят клиентам создавать и запускать LLM с несколькими триллионами параметров быстрее, в больших масштабах и с меньшими затратами, чем позволяли EC2-инстансы с ускорителями NVIDIA прошлого поколения. AWS предложит кластеры EC2 UltraClusters из суперускорителей GB200 NVL72, которые позволят объединить тысячи чипов GB200. GB200 будут доступны и в составе инстансов NVIDIA DGX Cloud. AWS также предложит EC2 UltraClusters с ускорителями B100. Amazon отмечает, что сочетание AWS Nitro и NVIDIA GB200 ещё больше повысит защиту ИИ-моделей: GB200 обеспечивает шифрование NVLink, EFA шифрует данные при передаче между узлами кластера, а KMS позволяет централизованно управлять ключами шифрования. Аппаратный гипервизор AWS Nitro, как и прежде, разгружает CPU узлов, беря на себя обработку IO-операций, а также защищает код и данные во время работы с ними. Эта возможность, доступная только в сервисах AWS, была проверена и подтверждена NCC Group. Инстансы с GB200 поддерживают анклавы AWS Nitro Enclaves, что позволяет напрямую взаимодействовать с ускорителем и данными в изолированной и защищённой среде, доступа к которой нет даже у сотрудников Amazon. Чипы Blackwell будут использоваться в обновлённом облачном суперкомпьютере AWS Project Ceiba, который будет использоваться NVIDIA для исследований и разработок в области LLM, генерация изображений/видео/3D, моделирования, цифровой биологии, робототехники, беспилотных авто, предсказания климата и т.д. Эта первая в своём роде машина на базе GB200 NVL72 будет состоять из 20 736 суперчипов GB200, причём каждый из них получит 800-Гбит/с EFA-подключение. Пиковая FP8-производительность системы составит 414 Эфлопс.

20.03.2024 [15:25], Руслан Авдеев

BNY Mellon стал первым транснациональным банком, внедрившим ИИ-суперкомпьютер NVIDIA на базе DGX SuperPOD H100Банк Bank of New York Mellon Corporation (BNY Mellon) стал первой структурой подобного профиля и масштаба, приступившей к внедрению собственного ИИ-суперкомпьютера на основе систем NVIDIA. Банку получил кластер DGX SuperPOD из нескольких десятков систем DGX H100, объединённых интерконнектом NVIDIA InfiniBand. Основанный в 2007 году в результате слияния The Bank of New York и Mellon Financial Corporation банк намерен использовать новый суперкомпьютер вкупе с NVIDIA AI Enterprise для создания и внедрения ИИ-приложений и управления ИИ-инфраструктурой своего бизнеса. Банк уже использует более 20 ИИ-решений, в том числе для прогнозирования в сфере депозитов, автоматизации платежей, предиктивной торговой аналитики и т.д. Всего же компания нашла более 600 вариантов использования ИИ в своей банковской системе. Как заявляют в руководстве BNY Mellon, внедрение ИИ-суперкомпьютера увеличит возможности по обработке данных и запуску ИИ-проектов, помогающих управлять активами клиентов и обеспечивать их защиту. Компания пока не сообщила, где будет расположен суперкомпьютер и его полные характеристики. Ранее банку принадлежал дата-центр в Нью-Джерси, также он управлял IT-объектами в Пенсильвании и Теннесси.

20.03.2024 [02:17], Владимир Мироненко

Oracle и NVIDIA предложат суверенные ИИ-фабрики

dgx cloud

gb200

gtc 2024

nvidia

oracle

oracle cloud platform

software

ии

конфиденциальность

облако

частное облако

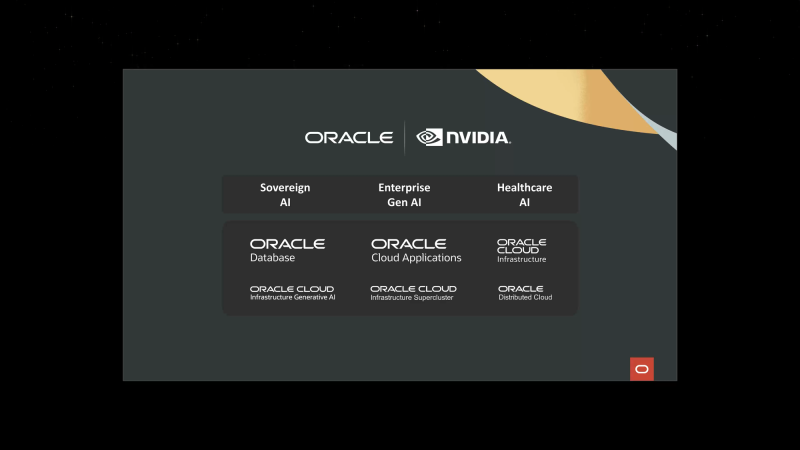

Oracle и NVIDIA объявили о расширении сотрудничества для предоставления суверенного ИИ клиентам по всему миру — программно-аппаратные решения обеих компаний позволят правительствам и предприятиями формировать ИИ-фабрики, говорится в пресс-релизе. Облачные сервисы Oracle используют ряд платформ NVIDIA, включая аппаратную инфраструктуру и программную платформу NVIDIA AI Enterprise, в том числе недавно анонсированные микросервисы вывода NVIDIA NIM. Такие ИИ-фабрики позволят развернуть облачные сервисы, работающие локально и размещённые в безопасных кампусах на территории страны или организации. Сочетание полнофункциональной ИИ-платформы NVIDIA с корпоративным ИИ-инструментами Oracle, которые можно развернуть в выделенном регионе OCI, позволит получить современное ИИ-решение с повышенным уровенем контроля, защиты и безопасности. По словам Oracle, компания является единственным гиперскейлером, способным предоставлять ИИ-решения и полноценные облачные услуги локально и в любом месте. Oracle также задействует чипы NVIDIA Blackwell (GB200 и B200) в OCI Supercluster и OCI Compute. OCI Supercluster станет значительно быстрее благодаря новым bare metal-инстансам, RDMA-сети со сверхмалой задержкой и высокопроизводительному хранилищу. В OCI появятся и сервисы NVIDIA NIM и CUDA-X, а также NVIDIA NeMo Retriever. Наконец, в DGX Cloud on OCI станут доступны инстансы на базе суперускорителей GB200 NVL72 для работы с LLM с триллионами параметров. Полный кластер DGX Cloud будет включать более 20 тыс. ускорителей GB200, интерконнект NVLink 5 и сеть NVIDIA InfiniBand XDR.

20.03.2024 [01:00], Владимир Мироненко

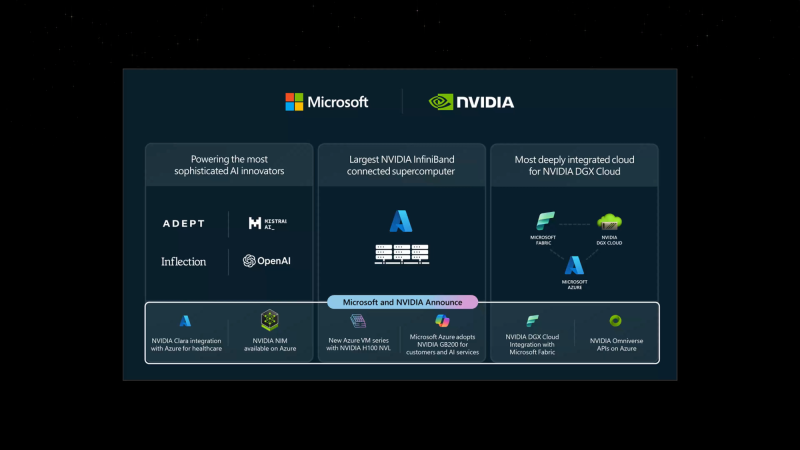

Microsoft и NVIDIA объявили об интеграции своих решений для ускорения внедрения генеративного ИИ на предприятияхMicrosoft и NVIDIA объявили о расширении давнего сотрудничество с целью внедрения новейших технологий генеративного ИИ NVIDIA и Omniverse в Microsoft Azure и ИИ-сервисы Azure, Microsoft Fabric и Microsoft 365. Сатья Наделла (Satya Nadella), председатель и гендиректор Microsoft заявил, что все новые инициативы, от внедрения ускорителей GB200 Grace Blackwell в Azure до новой интеграции между DGX Cloud и Microsoft Fabric, обеспечат клиентам наиболее полные платформы и инструменты на всех уровнях стека Copilot, от «кремния» до ПО, и позволят создать им новые прорывные ИИ-приложения. Microsoft станет одной из первых, кто развернёт в облаке ускорители GB200 и вкупе с InfiniBand-интерконнектом на базе Quantum-X800, предоставив новейшие базовые модели с триллионом параметров. Заодно компания объявила о доступности инстансов Azure NC H100 v5 на базе H100 NVL. Серия NC среднего уровня, предназначенная для обучения и инференса, предлагает клиентам два класса виртуальных машин с одним или двумя PCIe-ускорителями H100 (94 Гбайт). Кроме того, компания предложит комплексный набор решений на базе Microsoft Azure, NVIDIA DGX Cloud и NVIDIA Clara поставщикам медицинских сервисов, фармацевтическим и биотехнологическим компаниям, а также разработчикам медицинского оборудования. А индустриальные компании получат в своё распоряжение API NVIDIA Omniverse Cloud. Наконеw, в Azure AI и Azure Marketplace станут доступны микросервисы инференса NVIDIA NIM.

19.03.2024 [22:37], Сергей Карасёв

HPE выпустила локальный суперкомпьютер для генеративного ИИКомпания HPE сообщила о доступности модульной суперкомпьютерной системы для генеративного ИИ. Платформа, предназначенная для локального размещения в инфраструктуре заказчика, построена на суперчипах NVIDIA GH200 Grace Hopper. О подготовке системы HPE заявила в ноябре 2023 года. В её основу положены серверы ProLiant DL380a Gen11. В общей сложности могут быть задействованы до 168 суперчипов GH200. Кроме того, применяются Ethernet-платформа NVIDIA Spectrum-X и DPU NVIDIA BlueField-3. Решение дополнено платформой машинного обучения и аналитическим программным обеспечением HPE, платформой для работы с ИИ-приложениями NVIDIA AI Enterprise 5.0, которая включает микросервисы на базе загружаемых программных контейнеров, а также сервисом NVIDIA NeMo Retriever и другими библиотеками для обработки данных и ИИ. Суперкомпьютерная система ориентирована на крупные предприятия, исследовательские институты и правительственные учреждения. Утверждается, что в конфигурации с 16 узлами комплекс может оптимизировать модель Llama 2 с 70 млрд параметров всего за 6 минут. Высокая производительность позволяет клиентам повысить продуктивность бизнеса с помощью приложений генеративного ИИ, таких как виртуальные помощники, умные чат-боты и средства корпоративного поиска. При этом софт HPE Machine Learning Inference позволит предприятиям быстро и безопасно развертывать масштабные модели машинного обучения. Компания HPE также сообщила о намерении выпустить продукты следующего поколения, использующие аппаратные решения NVIDIA на базе архитектуры Blackwell. Речь идёт о гибридных суперчипах GB200, а также изделиях HGX B200 и HGXB100. Подробности о новых системах будут раскрыты позднее.

19.03.2024 [22:31], Сергей Карасёв

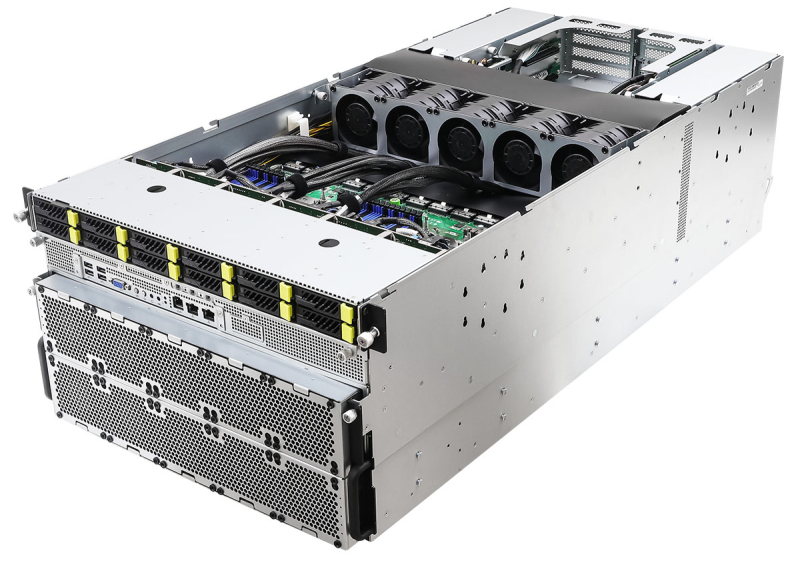

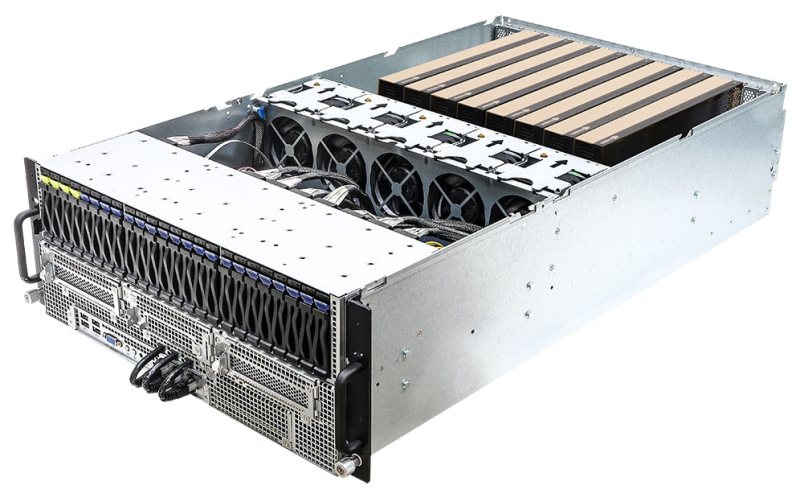

ASRock Rack представила серверы с поддержкой ускорителей NVIDIA Blackwell и HopperКомпания ASRock Rack на конференции GTC 2024 анонсировала свои самые мощные серверы для обучения ИИ-моделей — системы 6U8X-EGS2 NVIDIA H100 и 6U8X-EGS2 NVIDIA H200. Кроме того, дебютировали решения с поддержкой новейших ускорителей NVIDIA Blackwell. Серверы 6U8X-EGS2 NVIDIA H100 и 6U8X-EGS2 NVIDIA H200 выполнены в форм-факторе 6U. Они рассчитаны на установку восьми ускорителей NVIDIA H100 и H200 соответственно. Возможно использование двух процессоров Intel Xeon Sapphire Rapids или Xeon Emerald Rapids с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5-5600, 12 отсеков для SFF-накопителей NVMe с интерфейсом PCIe 5.0 x4 (четыре также имеют поддержку SATA), два коннектора М.2 2280/22110 (PCIe 3.0 x4), восемь слотов HHHL PCIe5.0 x16 и пять слотов FHHL PCIe5.0 x16. Питание обеспечивают восемь блоков мощностью 3000 Вт с сертификатом 80 PLUS Platinum/Titanium. ASRock Rack также представила двухсокетный barebone-сервер 4UMGX с поддержкой восьми ускорителей NVIDIA H100 NVL или H200 в форм-факторе 4U. Система может комплектоваться шестью DPU NVIDIA BlueField-3 или шестью сетевыми адаптерами NVIDIA ConnectX-7. Модель 4UMGX также поддерживает ускорители NVIDIA Blackwell. В основу сервера положена модульная архитектура NVIDIA MGX, предназначенная для создания ИИ-систем на базе CPU, GPU и DPU. Кроме того, дебютировали двухсокетные 4U серверы 4U8G-EGS2, 4U10G-EGS2, 4U8G-GENOA2 и 4U10G-GENOA2. Первые два рассчитаны на чипы Intel Xeon Sapphire Rapids или Xeon Emerald Rapids, два других — на процессоры AMD EPYC 9004 (Genoa). Они могут оснащаться ускорителями NVIDIA H100 NVL и H200 NVL, а в перспективе — NVIDIA Blackwell. Устройства 4U8G поддерживают восемь двухслотовых карт FHFL с интерфейсом PCIe 5.0 x16, решения 4U10G — десять. Intel-системы снабжены 32 слотами для модулей памяти DDR5, AMD-модели — 24-мя. ASRock Rack также готовит суперускоритель GB200 NVL72, серверы с поддержкой конфигурации NVIDIA HGX B200 8-GPU и другие решения на основе аппаратных компонентов NVIDIA.

19.03.2024 [03:18], Владимир Мироненко

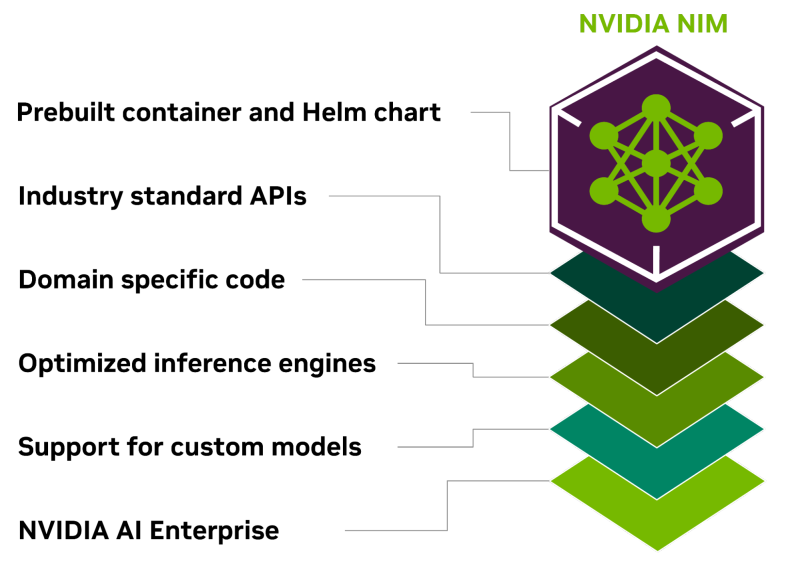

Всё своё ношу с собой: NVIDIA представила контейнеры NIM для быстрого развёртывания оптимизированных ИИ-моделейКомпания NVIDIA представила микросервис NIM, входящий в платформу NVIDIA AI Enterprise 5.0 и предназначенный для оптимизации запуска различных популярных моделей ИИ от NVIDIA и её партнёров. NVIDIA NIM позволяет развёртывать ИИ-модели в различных инфраструктурах: от локальных рабочих станций до облаков. Предварительно созданные контейнеры и Helm Chart'ы с оптимизированными моделями тщательно проверяются и тестируются на различных аппаратных платформах NVIDIA, у поставщиков облачных услуг и на дистрибутивах Kubernetes. Это обеспечивает поддержку всех сред с ускорителями NVIDIA и гарантирует, что компании смогут развёртывать свои приложения генеративного ИИ где угодно, сохраняя полный контроль над своими приложениями и данными, которые они обрабатывают. Разработчики могут получить доступ к моделям посредством стандартизированных API, что упрощает разработку и обновление приложений. NIM также может использоваться для оптимизации исполнения специализированных решений, поскольку не только использует NVIDIA CUDA, но и предлагает адаптацию для различных областей, таких как большие языковые модели (LLM), визуальные модели (VLM), а также модели речи, изображений, видео, 3D, разработки лекарств, медицинской визуализации и т.д. NIM использует оптимизированные механизмы инференса для каждой модели и конфигурации оборудования, обеспечивая наилучшую задержку и пропускную способность и позволяя более просто и быстро масштабироваться по мере роста нагрузок. В то же время NIM позволяет дообучить и настроить модели на собственных данных, поскольку можно не только воспользоваться облачными API NVIDIA для доступа к готовым моделями, но и самостоятельно развернуть NIM в Kubernetes-средах у крупных облачных провайдеров или локально, что сокращает время разработки, сложность и стоимость подобных проектов и позволяет интегрировать NIM в существующие приложения без необходимости глубокой настройки или специальных знаний.

19.03.2024 [02:16], Владимир Мироненко

NVIDIA AI Enterprise 5.0 предложит микросервисы, которые ускорят развёртывание ИИNVIDIA представила свежую версию платформы для работы с ИИ-приложениями NVIDIA AI Enterprise 5.0, которая включает микросервисы на базе загружаемых программных контейнеров для быстрого развёртывания приложений генеративного ИИ. NVIDIA отметила, что уже микросервисы адаптируются ведущими поставщиками ПО и платформ кибербезопасности, а все функции AI Enterprise 5.0 вскоре будут доступны в облачных маркетплейсах AWS, Google Cloud, Microsoft Azure и Oracle Cloud. Микросервисы позиционируются компанией как эффективный инструмент для создания разработчиками современных корпоративных приложений в глобальном масштабе. Работая прямо в браузере, разработчики могут используют для создания приложений облачные API. NVIDIA AI Enterprise 5.0 теперь включает предназначенные для развёртывания моделей ИИ микросервисы NIM и микросервисы CUDA-X. Сюда входит и NVIDIA cuOpt, ИИ-микросервис для задачи логистики, который позволяет значительно ускорить оптимизации маршрута и расширить возможности динамического принятия решений, снижая затраты, экономя время и позволяя сократить выбросы CO2.

Источник изображения: NVIDIA NIM оптимизирует инференс-нагрузки для различных популярных моделей ИИ от NVIDIA и партнёров. Используя ПО NVIDIA для инференса, включая Triton Inference Server, TensorRT и TensorRT-LLM, NIM позволяет сократить развёртывание моделей с недель до минут и вместе с тем обеспечивает безопасность и управляемость в соответствии с отраслевыми стандартами, а также совместимость с инструментами управления корпоративного уровня. В настоящее время компания работает над расширением возможностей AI Enterprise. С выходом версии NVIDIA AI Enterprise 5.0 платформа получила ряд дополнений. В частности, она теперь включает NVIDIA AI Workbench, набор инструментов для разработчиков, обеспечивающих быструю загрузку, настройку и запуск проектов генеративного ИИ. ПО теперь общедоступно и поддерживается NVIDIA. NVIDIA AI Enterprise 5.0 также теперь поддерживает платформу Red Hat OpenStack. Кроме того, в NVIDIA AI Enterprise 5.0 расширена поддержка широкого спектра новейших ускорителей NVIDIA, сетевого оборудования и ПО для виртуализации.

19.03.2024 [01:40], Сергей Карасёв

NVIDIA запустила облачную платформу Quantum Cloud для квантово-классического моделированияКомпания NVIDIA объявила о запуске платформы облачных микросервисов Quantum Cloud, которая поможет учёным и разработчикам проводить исследования в сфере квантовых вычислений для различных областей, включая химию, биологию и материаловедение. В основу Quantum Cloud легла NVIDIA CUDA Quantum — открытая платформа, предназначенная для интеграции и программирования CPU, GPU и квантовых процессоров (QPU). Она даёт возможность выполнять сложные симуляции квантовых схем. На базе микросервисов Quantum Cloud пользователи смогут непосредственно в облаке создавать и тестировать новые квантовые алгоритмы и приложения. Это могут быть, в частности, гибридные квантово-классические системы. Утверждается, что Quantum Cloud обладает развитыми возможностями и поддерживает интеграцию стороннего ПО для ускорения научных исследований. В состав Quantum Cloud входит компонент Generative Quantum Eigensolver, разработанный в сотрудничестве с Университетом Торонто: он использует большие языковые модели (LLM), позволяющие квантовому компьютеру быстрее находить энергию основного состояния молекулы. Интеграция решений израильского стартапа Classiq помогает исследователям создавать большие и сложные квантовые программы, а также проводить глубокий анализ квантовых схем. В свою очередь, инструмент QC Ware Promethium решает сложные задачи квантовой химии, такие как молекулярное моделирование. «Квантовые системы представляют собой следующий революционный рубеж в сфере вычислений. Quantum Cloud устраняет барьеры на пути изучения этой преобразующей технологии и позволяет любому учёному в мире использовать возможности квантовых вычислений и воплощать свои идеи в реальность», — говорит Тим Коста (Tim Costa), руководитель NVIDIA по направлению HPC и квантовых вычислений.

19.03.2024 [01:37], Сергей Карасёв

NVIDIA и Siemens внедрят генеративный ИИ в промышленное проектирование и производство

gtc 2024

nvidia

omniverse

siemens

software

ии

облако

производство

промышленность

разработка

цифровой двойник

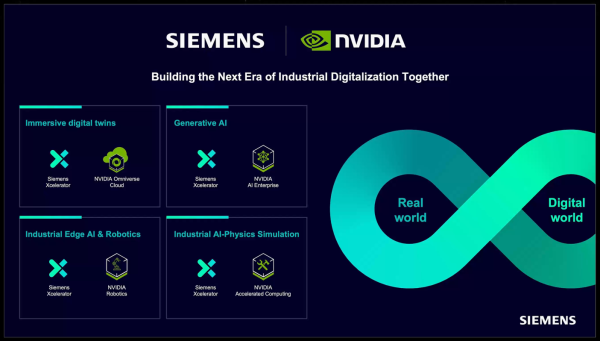

Компании NVIDIA и Siemens сообщили о расширении сотрудничества с целью внедрения иммерсивной визуализации и генеративного ИИ в промышленное проектирование и производство. В частности, Siemens интегрирует новый программный интерфейс NVIDIA Omniverse Cloud API в свою платформу Xcelerator. Напомним, Omniverse Cloud представляет собой комплексный пакет облачных сервисов, позволяющих проектировать, публиковать, эксплуатировать и тестировать приложения метавселенной вне зависимости от местонахождения. В свою очередь, Xcelerator — интегрированный пакет ПО и сервисов для разработки приложений. NVIDIA и Siemens совмещают платформы Omniverse и Xcelerator, выводя промышленную автоматизацию на новый уровень. Партнёры объединяют обширную промышленную экосистему Xcelerator и физически точный механизм создания виртуального мира в реальном времени с поддержкой ИИ. Это позволяет создавать точные реалистичные цифровые двойники. В рамках сотрудничества Siemens, в частности, интегрирует NVIDIA Omniverse Cloud API в состав Teamcenter X (входит в Xcelerator). Облачная система Teamcenter X предоставляет пользователям безопасный доступ к данным управления жизненным циклом изделия (PLM) из любой точки мира, с любого устройства и в любое время. Благодаря использованию API Omniverse могут быть ускорены различные рабочие процессы при создании цифровых двойников, такие как изменение условий освещения, применение тех или иных материалов и пр. Отмечается, что традиционно компании в значительной степени полагались на физические прототипы при реализации крупномасштабных промышленных проектов. Такой подход является дорогостоящим, ограничивает инновации и замедляет время выхода решений на рынок. Совместная инициатива Siemens и NVIDIA позволяет устранить указанные препятствия путём создания фотореалистичных цифровых двойников, учитывающих физику реального мира. Это означает, что такие компании, как HD Hyundai (занимается судостроением, тяжёлым оборудованием и машиностроением), могут унифицировать и визуализировать сложные инженерные проекты непосредственно в Teamcenter X. В частности, API USD Query позволяет пользователям Teamcenter X перемещаться и взаимодействовать с физически точными объектами, тогда как API USD Notify обеспечивает автоматическое обновление дизайна и сцен в режиме реального времени. В дальнейшем Siemens планирует внедрить технологии NVIDIA и в другие продукты Xcelerator. |

|