Материалы по тегу: amd

|

25.01.2024 [14:41], Сергей Карасёв

Для звёзд — Xeon, для гравитации — EPYC: Lenovo обновила HPC-кластер Кардиффского университетаКомпания Lenovo поставила в Кардиффский университет в Великобритании 90 серверов ThinkSystem, которые позволили поднять производительность кластера Hawk HPC приблизительно в два раза. Система применяется для решения сложных задач в таких областях, как астрофизика и наука о жизни. Lenovo и британский поставщик IT-решений Logicalis предоставили HPC-ресурсы для двух исследовательских групп в Кардиффском университете. Одна из них — научная коллаборация, участвующая в проекте лазерно-интерферометрической гравитационно-волновой обсерватории (LIGO). Эта инициатива нацелена на обнаружение гравитационных волн. Сообщается, что для проекта LIGO компания Lenovo предоставила 75 серверов ThinkSystem SR645, оснащённых процессорами AMD EPYC Genoa. Эти системы поддерживают до 6 Тбайт оперативной памяти DDR5-4800 в виде 24 модулей и до трёх ускорителей PCIe (2 × PCIe 5.0 и 1 × PCIe 4.0). Отмечается, что установка серверов позволила удвоить вычислительные мощности, доступные исследователям. Вторая исследовательская группа в Кардиффском университете, изучающая процессы звёздообразования, получила 15 серверов Lenovo ThinkSystem SR630 на платформе Intel Xeon Sapphire Rapids и два сервера хранения ThinkSystem SR650 с возможностью установки 20 накопителей LFF или 40 накопителей SFF. Группа сосредоточена на анализе спиральных галактик, таких как наш Млечный Путь. Приобретённые серверы помогут в выполнении сложных задач моделирования.

24.01.2024 [13:55], Сергей Карасёв

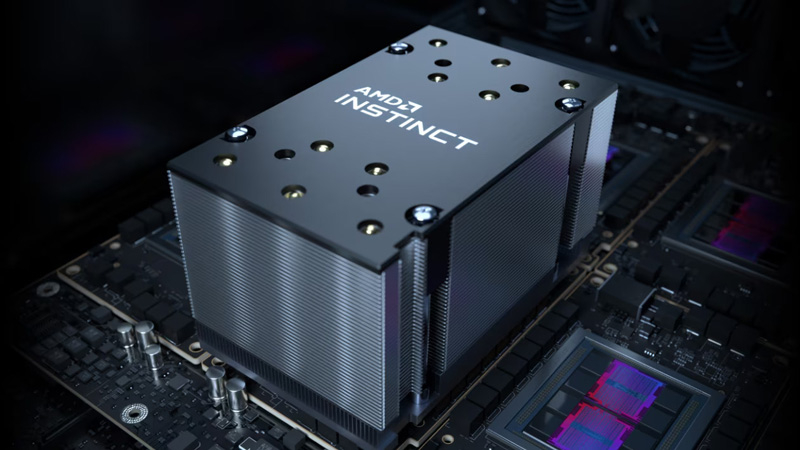

Итальянская нефтегазовая компания Eni получит 600-Пфлопс суперкомпьютер HPC6 на базе AMD Instinct MI250XИтальянская нефтегазовая компания Eni, по сообщению ресурса Inside HPC, заказала суперкомпьютер HPE Cray EX4000 на аппаратной платформе AMD. Быстродействие этой машины, как ожидается, составит около 600 Пфлопс. Известно, что в состав системы, получившей название HPC6, войдут 3472 узла, каждый из которых получит 64-ядерный процессор AMD EPYC и четыре ускорителя AMD Instinct MI250X. Таким образом, общее количество ускорителей составит 13 888. Судя по всему, компания смогла достаточно полно адаптировать своё ПО для работы на современных ускорителях AMD, эксперименты с которыми она начала ещё несколько лет назад. Комплекс будет использовать хранилище HPE Cray ClusterStor E1000 с интерконнектом HPE Slingshot. Узлы суперкомпьютера будут организованы в 28 стоек. Предусмотрено применение технологии прямого жидкостного охлаждения, которая, по заявлениям Eni, рассеивает 96 % вырабатываемого тепла. Максимальная потребляемая мощность — 10,17 МВт.

Источник изображения: AMD Новый суперкомпьютер разместится в ЦОД Eni Green Data Center в Феррера-Эрбоньоне, который, как утверждается, является одним из самых энергоэффективных и экологически чистых вычислительных центров в Европе. По производительности HPC6 значительно превзойдёт комплексы HPC4 и HPC5, совокупная вычислительная мощность которых составляет 70 Пфлопс. При производительности 600 Пфлопс система HPC6 займёт второе место в текущем списке TOP500 самых мощных суперкомпьютеров мира.

23.01.2024 [14:39], Сергей Карасёв

Shell установила в дата-центре в Техасе модули погружного охлаждения GRCКомпания Shell, по сообщению ресурса Datacenter Dynamics, установила резервуары иммерсионного (погружного) охлаждения GRC в своём техасском ЦОД в Хьюстоне. Они используются для отвода тепла от кластерного оборудования Penguin Solutions на основе процессоров AMD. Установки GRC S10 Duo смонтированы в ЦОД Skybox компании Element Critical. Каждый из модулей S10 Duo может вмещать оборудование мощностью до 200 кВт (100 кВт на стойку стандарта 42U) с использованием тёплой воды с температурой около +32 °C. При снижении температуры воды до +7 °C производительность каждой системы GRC может быть увеличена практически в два раза. По имеющейся информации, Shell установила в техасском дата-центре 864 двухпроцессорных сервера (судя по логотипам, это системы Penguin Solutions) с 96-ядерными чипами AMD Epyc 9654 Genoa. Таким образом, в общей сложности задействованы 1728 процессоров и 165 888 ядер. В ЦОД используются как минимум шесть погружных модулей S10 Duo.

Источник изображения: GRC via Datacenter Dynamics Сама Shell, как и многие другие нефтяные компании, разрабатывает специальные жидкости для систем погружного охлаждения, предназначенных для применения вместе с вычислительным оборудованием высокой плотности. Например, состав Shell S3 X производится из природного газа. Ещё в конце 2022 года Shell присоединилась к программе GRC ElectroSafe по сертификации альтернативных жидкостей для систем погружного охлаждения. Речь идёт о диэлектрических составах, которые должны соответствовать определённым требованиям в плане экологичности, эффективности и безопасности.

23.01.2024 [13:48], Сергей Карасёв

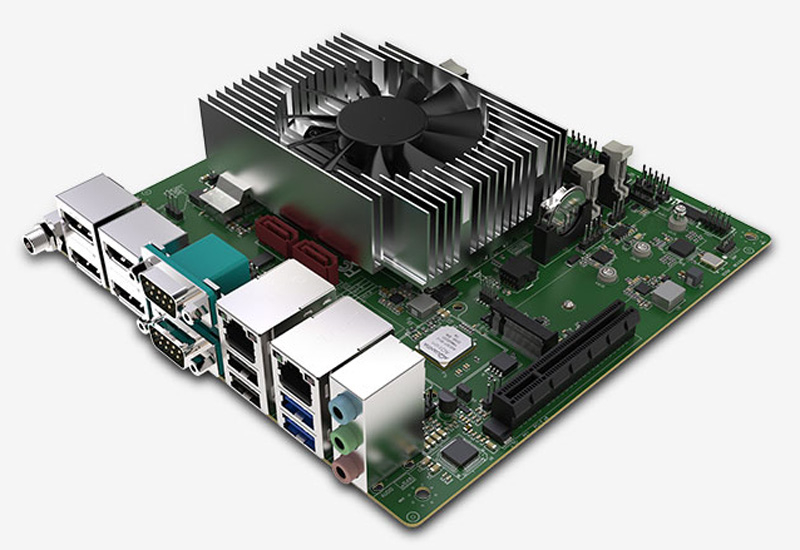

Sapphire выпустила плату Edge IPC-FP6: mini-ITX с AMD Ryzen Embedded V2000 и 10GbEКомпания Sapphire представила компактную материнскую плату Edge IPC-FP6, предназначенную для создания периферийных устройств, медицинского оборудования, тонких клиентов и различных терминалов. Новинка построена на платформе AMD Ryzen Embedded V2000. Максимальная комплектация включает процессор V2748 (8C/16T; 2,9–4,15 ГГц; 45 Вт). Доступны два слота SO-DIMM для модулей DDR4-3200 (ECC/Non-ECC) суммарным объёмом до 64 Гбайт. Плата выполнена в формате mini-ITX с габаритами 170 × 170 мм. Для подключения накопителей есть два порта SATA-3, а также коннектор M.2 Key M 2242/2260/2280 с поддержкой интерфейса PCIe x4. Предусмотрены разъём M.2 Key E 2230 (PCIe x1; USB 2.0) для модуля беспроводной связи и слот PCIe x8 для карты расширения. В оснащение входят сетевые контроллеры 10GbE (Marvell AQC107) и 1GbE (Realtek RTL8111H) с гнёздами RJ-45. За безопасность отвечает чип Infineon SLB9670 TPM 2.0.

Источник изображения: Sapphire Среди доступных интерфейсов есть четыре порта DP 1.4 (плюс один eDP), по два порта USB 3.1 Gen2 Type-A и USB 2.0, набор аудиогнёзд, два последовательных порта RS232/422/485 DB9, а также гнездо для подачи питания (12–19 В). Через коннекторы на плате можно задействовать дополнительно четыре порта USB 2.0 и два последовательных порта. В зависимости от установленного процессора новинка комплектуется различными активными кулерами. Говорится о совместимости с Windows 10 и Ubuntu 20.04.1.

14.01.2024 [21:18], Владимир Мироненко

Учёные ORNL сумели обучить LLM с 1 трлн параметров, задействовав всего 3072 ускорителя AMD Instinct MI250XКоманда специалистов Национальной лаборатории Ок-Ридж обучила большую языковую модель (LLM) с 1 трлн параметров на суперкомпьютере Frontier, используя лишь 3072 из имеющихся 37 888 ускорителей. LLM такого масштаба сравнима по возможностям с OpenAI GPT4. Кроме того, учёные смогли обучить LLM со 175 млрд параметров, задействовав всего лишь 1024 ускорителя. При обучении LLM с миллиардами параметров требуются значительные вычислительные ресурсы и большой объём памяти. Учёные ORNL занялись исследованием вопроса оптимизации этого процесса и изучили различные фреймворки, методы работы с данными и параллелизацией обучение, оценив их влияние на память, задержку коммуникаций и уровень эффективности использования ускорителей.

Источник изображения: ORNL Прорыва удалось достичь благодаря точной настройке гиперпараметров и оптимизации всего процесса обучения. Команда Frontier провела исчерпывающие тесты с различными параметрами, и в итоге стал возможен процесс обучения LLM с 1 трлн параметров с использованием всего 3 тыс. ускорителей AMD Instinct MI250X. Задача осложнялась тем, что для работы с ними используется ROCm, тогда как для подавляющего большинства ИИ-инструментов требуется поддержка NVIDIA CUDA. Результаты показали, что фактическая пропускная способность ускорителей составила 31,96 % для модели с 1 трлн параметров и 36,14 % для модели с 17 млрд параметров. Кроме того, для обеих моделей исследователи достигли 100-процентной эффективности слабого масштабирования и высокой эффективности сильного масштабирования: 89 % для модели со 175 млрд параметров и 87 % для модели с 1 трлн параметров. Впрочем, в исследовании не уточняется, сколько времени ушло на обучение этих моделей.

08.01.2024 [00:28], Алексей Степин

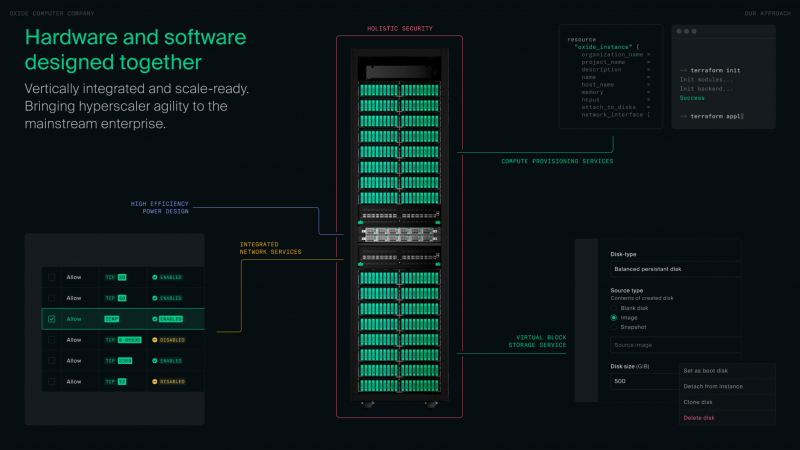

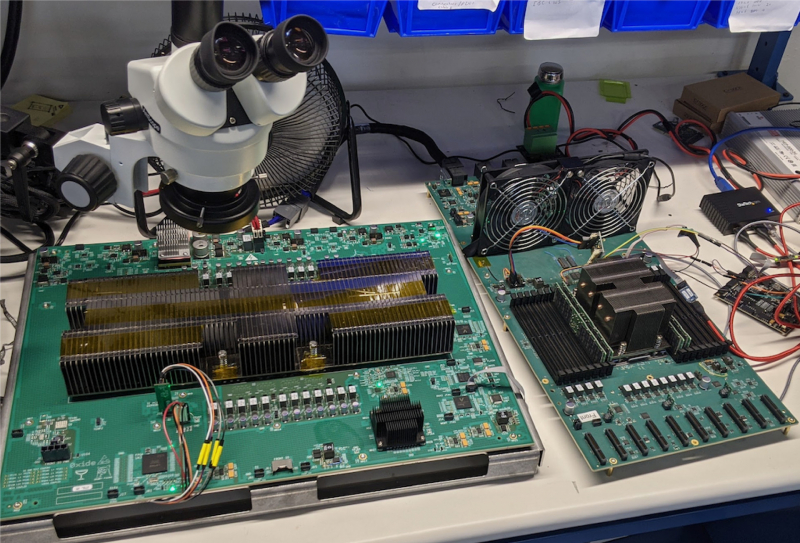

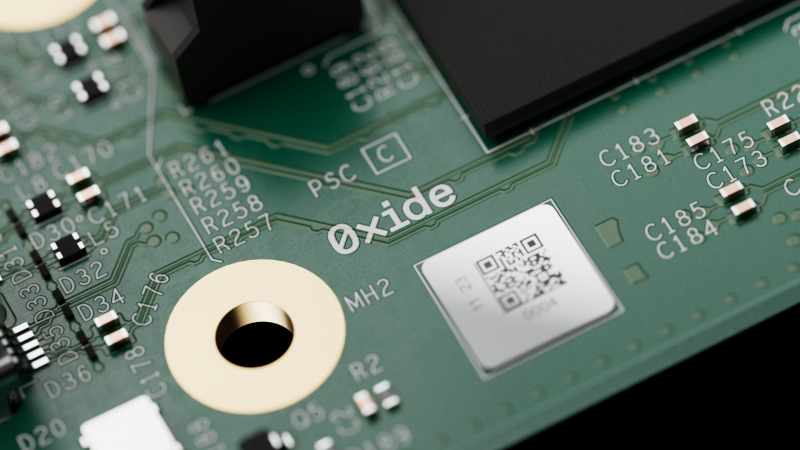

Oxide Cloud Computer: переизобретая облакоПубличные облака очень популярны, но не всегда в должной мере отвечают поставленным целям и задачам компании. В то же время, классическая серверная инфраструктура дорога в содержании, хлопотна в настройке и не всегда безопасна — не в последнюю очередь из-за фрагментированности программных и аппаратных архитектур, уходящей корнями в далёкое прошлое. Компания Oxide Computer заявила, что разработанная ею интегрированная платформа должна вернуть компьютерным системам нового поколения холизм, присущий самым ранним вычислительным решениям, когда аппаратное и программное обеспечение создавалось совместно и с взаимным учётом особенностей. Разлад, по мнению Oxide, начался в этой сфере давно — с появлением BIOS, отделившей «железо» от системного ПО. В дальнейшем этот разрыв только нарастал, как и степень закрытости компонентов вкупе со всё большим и большим количеством слоёв абстракций. Появление UEFI лишь усугубило эту проблему. Причём речь здесь не только о прошивках: можно вспомнить SMM и интеграцию в процессоры «вспомогательных ядер», обслуживающих I/O-подсистемы, но полностью скрытых от системного ПО. По мнению Oxide, такой подход представляет серьёзную угрозу безопасности, поскольку со стороны «железа» операционной системе доступно всё меньше информации об истинных аппаратных возможностях и ресурсах сервера. Появление BIOS с открытым кодом проблемы не решает — вспомогательные аппаратные компоненты сегодня не просто слишком сложны, но и работают под управлением проприетарных прошивок, а информации в открытом доступе о них крайне мало. Крупные гиперскейлеры борются с этой фрагментацией путём создания собственных, уникальных решений. Oxide Computer же решила распространить этот подход на традиционный корпоративный рынок. В своих новых системах компания отказалась не только от традиционных прошивок BIOS и UEFI, но и от использования закрытых BMC и сервисных процессоров, равно как и блоков Root-of-Trust (RoT). Вместо них используются чипы STM32H753 и LP55S28, работающие под управлением специально разработанной для этих целей операционной системы Hubris, полностью открытой, написанной на языке Rust. Полностью избавиться от проприетарности на платформе AMD невозможно, поскольку Platform Security Processor (PSP) отвечает за старт и инициализацию процессора и памяти. Но вот дальнейший процесс загрузки управляется не BIOS/UEFI, а фирменной открытой ОС Helios, часть которой «живёт» в SPI-памяти. Helios является своего рода наследницей illumos, восходящей ещё к OpenSolaris. Стек включает гипервизор bhyve, Propolis для работы с VMM, а также Omicron для управления всей платформой в целом на уровне стойки. Естественно, для подсистемы хранения задействованы ZFS-пулы. Результатом работ Oxide стала платформа под названием Cloud Computer. Для неё не просто было разработано уникальное программное обеспечение — практически с нуля была создана и вся аппаратная часть, от вычислительных узлов до сетевых коммутаторов и подсистемы питания. Об этом компания рассказывает в своём блоге. При этом практически вся программная часть этого программно-аппаратного комплекса открыта, но вот аппаратную часть кому-то со стороны просто так повторить вряд ли удастся. Oxide позиционирует Cloud Computer в качестве универсальной платформы для частных облаков, обеспечивающей единство архитектуры и удобства конфигурирования с гибкостью и простотой использования публичных облаков. По словам компании, развёртывание облака на базе Oxide Cloud Computer занимает считаные часы, что является заслугой в том числе и уникальной архитектуры новинки. Фактически для первичного запуска системы достаточно подключить питание и сеть. Платформа (фактически готовая стойка) может включать в себя 16, 24 или 32 вычислительных узла на базе 64-ядерных процессоров AMD EPYC 7713P (Milan) с 512 или 1 Тбайт RAM, что даёт до 2048 ядер и до 32 Тбайт памяти на стойку. Каждый узел имеет 10 U.2-отсеков и комплектуется NVMe SSD объёмом 3,2 Тбайт, так что суммарный объём хранилища может достигать 931,5 Тбайт. В качестве интерконнекта используется 100GbE, в состав системы входит два программируемых коммутатора на базе Intel Tofino 2 (12,8 Тбит/с). В них также применяется ПО Oxide, написанное на P4. Подсистема хранения использует OpenZFS для построения распределённого блочного хранилища и реализует проактивную защиту данных, быстрое снятие снимков, их преобразование в дисковые образы и обратно, а также многое другое. Шифрование данных обеспечивается на всех уровнях, а за безопасность и хранение ключей отвечает фирменный RoT-контроллер, упомянутый ранее. Полка питания содержит 6 БП (5+1), максимальная потребляемая стойкой мощность не превышает 15 кВт. Питание у системы трёхфазное. Высота стойки Oxide составляет 2354 мм, ширина — стандартные 600 мм, глубина — 1060 мм. Платформа может генерировать почти 61500 BTU/час и нуждается в соответствующем воздушном охлаждении. Система работоспособна при температурах окружающей среды в пределах от +2 до +35 °C при относительно влажности не выше 80 %. Масса стойки составляет до 1145 кг.

26.12.2023 [15:39], Сергей Карасёв

AAEON представила модуль COM Express Type 6 на базе AMD Ryzen Embedded R2000Компания AAEON выпустила модуль COM-R2KC6 формата COM Express Type 6 — первое изделие данного типа с процессором AMD Ryzen Embedded R2000. Новинка предназначена для создания IoT-устройств, промышленных и робототехнических систем, медицинского оборудования, платформ машинного зрения и пр. Плата имеет размеры 95 × 95 мм. Доступны модификации с чипом R2544 (четыре ядра; восемь потоков; 3,35 ГГц; 45 Вт), R2514 (четыре ядра; восемь потоков; 2,1 ГГц; 15 Вт) и R2314 (четыре ядра; четыре потока; 2,1 ГГц; 15 Вт). Задействован графический контроллер AMD Radeon Vega 8 или Vega 6. Предусмотрены два слота SO-DIMM для модулей оперативной памяти DDR4-3200 суммарным объёмом до 32 Гбайт. Для подключения накопителей есть два порта SATA-3. В оснащение входит сетевой контроллер Intel I226-LM/IT стандарта 2.5GbE. Среди доступных интерфейсов упомянуты 8 × USB 2.0, 2 × USB 3.2 (10 Гбит/с), 1 × USB 3.2 (5 Гбит/с), 6 × PCIe 3.0, 2 × UART, 8 × GPIO, SPI, LPC, SM-Bus, I2C. Возможен вывод изображения одновременно на четыре дисплея с разрешением до 3840 × 2160 пикселей (1 × eDP и 3 × DDI). Диапазон рабочих температур простирается от 0 до +60 °C. Гарантирована совместимость с Windows 10 и Linux Ubuntu 22.04.2/Kernel 5.19.0-32. Питание — AT/ATX (12 В). За безопасность отвечает чип TPM 2.0.

23.12.2023 [14:43], Сергей Карасёв

ASRock представила Linux-инструмент AI QuickSet для быстрой установки ИИ-приложений на ПК с AMD Radeon RX 7900Компания ASRock сообщила о выпуске программного инструмента AI QuickSet для Linux, который позволяет быстро загружать, устанавливать и настраивать приложения ИИ. Ранее этот софт был доступен только для Windows 10/11. AI QuickSet предоставляет удобный и понятный интерфейс для поиска, скачивания, установки и конфигурирования различных ИИ-средств и компонентов (вроде TensorFlow и PyTorch), а также специализированных библиотек. В процессе работы AI QuickSet запрашивает у пользователя параметры функционирования ИИ-приложения или активирует конфигурацию по умолчанию. Это, как заявляется, гарантирует оптимальную работу программ, а пользователям не приходится углубляться в сложные ручные настройки. Linux-версия AI QuickSet совместима с Ubuntu 22.04.3 Desktop. Говорится, что инструмент задействует возможности ускорителей AMD серии Radeon RX 7900 и программного стека AMD ROCm. Поддерживаются различные приложения и модели open source, включая Image/Manga Translator, Stable Diffusion CLI, Ultralytics YOLOv8 и др.

Источник изображения: ASRock Для использования AI QuickSet необходим компьютер с процессором Intel Core 14/13-го поколения или AMD Ryzen серий 7000/5000. Говорится о совместимости с материнскими платами Intel серии 700/600 и AMD серии 600/500. Объём оперативной памяти должен составлять не менее 32 Гбайт. Требуется наличие ускорителя ASRock AMD Radeon серии RX 7000 (версия для Windows) или AMD Radeon серии RX 7900 (вариант для Linux).

21.12.2023 [14:51], Сергей Карасёв

Германия построит суперкомпьютер Herder экзафлопсного уровняЦентр высокопроизводительных вычислений HLRS в Штутгарте (Германия) объявил о заключении соглашения с компанией HPE по созданию двух новых суперкомпьютеров — систем Hunter и Herder. Они, как утверждается, предоставят «инфраструктуру мирового класса» для моделирования, ИИ, анализа данных и других ресурсоёмких задач в различных областях. Hunter заменит нынешний флагманский суперкомпьютер HLRS под названием Hawk. В основу Hunter ляжет платформа HPE Cray EX4000: в общей сложности планируется задействовать 136 таких узлов, каждый из которых будет оснащён четырьмя адаптерами HPE Slingshot. Архитектура Hunter предусматривает применение СХД нового поколения Cray ClusterStor, специально разработанной с учётом жёстких требований к вводу/выводу. Кроме того, будет задействована среда HPE Cray Programming Environment, которая предоставляет полный набор инструментов для разработки, портирования, отладки и настройки приложений.

Источник изображения: HLRS Суперкомпьютер Hunter получит ускорители AMD Instinct MI300A. Утверждается, что это позволит сократить энергопотребление по сравнению с Hawk примерно на 80 % при пиковой производительности. Быстродействие Hunter составит около 39 Пфлопс против 26 Пфлопс у Hawk. Систему планируется ввести в эксплуатацию в 2025 году. Суперкомпьютер экзафлопсного класса Herder заработает не ранее 2027 года. Архитектура предусматривает применение ускорителей, но окончательная конфигурация комплекса будет определена только к концу 2025-го. Общая стоимость Hunter и Herder оценивается в €115 млн. Финансирование будет осуществляться через Центр суперкомпьютеров Гаусса (GCS), альянс трёх национальных суперкомпьютерных центров Германии. Половину средств предоставит Федеральное министерство образования и исследований Германии (BMBF), оставшуюся часть — Министерство науки, исследований и искусств земли Баден-Вюртемберг. Нужно отметить, что в 2024 году в Юлихском исследовательском центре (FZJ) в Германии заработает вычислительный комплекс Jupiter — первый европейский суперкомпьютер экзафлопсного класса. Кроме того, систему такого уровня намерена создать Великобритания.

19.12.2023 [14:40], Руслан Авдеев

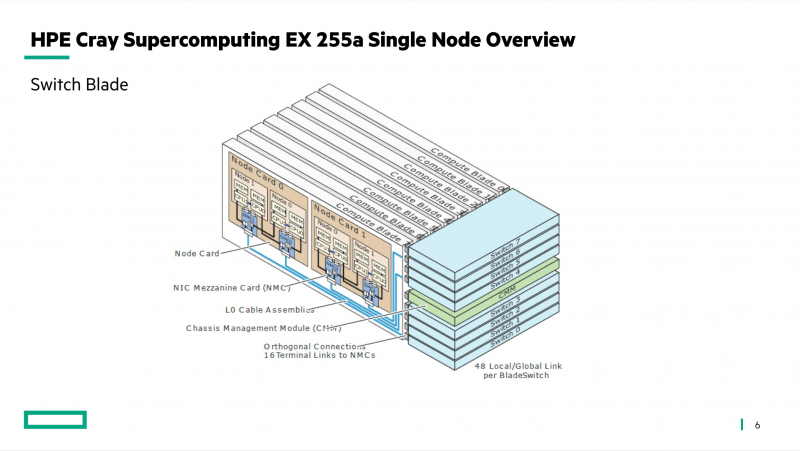

Пентагон получил 9-Пфлопс суперкомпьютер Carpenter: 280 тыс. ядер AMD и 563 Тбайт RAMАмериканское военное ведомство ввело в эксплуатацию новый суперкомпьютер. По данным Datacenter Dynamics, Центр исследований и разработок армии США (ERDC) представил систему Carpenter производительностью 9 Пфлопс, названную в честь капрала Уильяма Кайла Карпентера (William Cyle Carpenter). Впервые ERDC поделился планами строительства нового суперкомпьютера в августе прошлого года, изначально ожидалось, что машина получит по два чипа на узел, каждый со 192 ядрами и 384 Гбайт памяти, и 200G-интерконнект. Суперкомпьютер построен в лаборатории Army Computing Lab в Виксбурге (Миссисипи). Система, базирующаяся на платформе HPE Cray EX4000, оснащена 277 248 вычислительными ядрами AMD EPYC и 563 Тбайт памяти. О наличии каких-либо ускорителей не сообщается. Первый суперкомпьютер ERDC получил в 1990 году, а в 1992 году центр начал реализацию проекта High Performance Computing Modernization Program (HPCMP). В частности, она позволяет учёным Пентагона получать доступ к мощностям для разработки, тестирования и оценки оборонных систем. В ведении ERDC также находятся суперкомпьютеры Freeman и Onyx. Последний должны были «отправить на покой» ещё в августе этого года, но он всё ещё числится в ноябрьском списке TOP500, равно как и система Topaz 2015 года. |

|