Лента новостей

|

21.04.2024 [20:52], Сергей Карасёв

Евросоюз занялся изучением политики Broadcom в отношении лицензирования продуктов VMwareАнтимонопольный орган Европейского союза, по сообщению Reuters, направил запросы в корпорацию Broadcom по поводу изменения условий лицензирования продуктов VMware. Жалобы на Broadcom поступили от ряда отраслевых групп, которые в числе прочего указывают на резкий рост стоимости ПО VMware. После поглощения корпорацией Broadcom компании VMware клиенты последней столкнулись с рядом сложностей. В частности, Broadcom отменила бессрочные лицензии VMware, а также перевела все решения на подписную модель. Упразднены скидки и изменена схема взаимодействия с партнёрами. Бизнес VMware реорганизован с формированием четырёх ключевых подразделений. Закрыты более 50 продуктов; кроме того, прекращено распространение бесплатных версий гипервизора vSphere ESXi 7.x и ESXi 8.x. При этом сама Broadcom признаёт, что изменения в политике лицензирования ПО VMware вызывают беспокойство у клиентов и партнёров.

Источник изображения: VMware Сообщается, что бельгийская ассоциация бизнес-пользователей Beltug, некоммерческая организация Cigref, в которую входят крупнейшие французские компании и государственные предприятия, а также голландская CIO Platform Nederland и немецкая VOICE Germany направили жалобы на Broadcom главе антимонопольной службы ЕС Маргрете Вестагер (Margrethe Vestager), комиссару Евросоюза по вопросам внутреннего рынка Тьерри Бретону (Thierry Breton) и председателю Еврокомиссии Урсуле фон дер Ляйен (Ursula von der Leyen). В обращениях говорится о внезапных изменениях политики Broadcom, которые привели к резкому росту цен на софт VMware, запрету на перепродажу лицензий и отказу от бессрочных лицензий. Торговая организация CISPE, в состав которой входят Amazon и 26 небольших облачных провайдеров ЕС, также пожаловались на то, что Broadcom в одностороннем порядке изменила условия лицензирования ПО VMware. «Европейская комиссия получила информацию, позволяющую предположить, что Broadcom меняет условия лицензирования и поддержки ПО VMware», — заявил представитель регулятора. Вместе с тем генеральный директор Broadcom Хок Тан (Hock Tan) говорит, что изменения направлены «на ускорение инноваций, более эффективное удовлетворение потребностей клиентов и упрощение бизнес-операций». По его словам, значительно снижены цены на продукты VMware Cloud Foundation (VCF): утверждается, что клиенты, использующие это комплексное решение, могут сэкономить до половины затрат.

21.04.2024 [20:51], Сергей Карасёв

Власти Японии потратят $470 млн на создание ИИ-суперкомпьютера нового поколенияПравительство Японии, по сообщению ресурса Nikkei, профинансирует создание мощного НРС-комплекса, предназначенного для решения ресурсоёмких задач, связанных с ИИ. В общей сложности на проект будет выделено ¥72,5 млрд , или приблизительно $470 млн. В проектировании системы примут участие пять компаний, включая телекоммуникационного оператора KDDI и поставщика облачных услуг Sakura Internet. Отмечается, что Министерство экономики, торговли и промышленности Японии (METI) компенсируют до половины затрат, которые понесут разработчики суперкомпьютера. В частности, Sakura получит ¥50,1 млрд ($324 млн) государственных средств, а KDDI — ¥10,2 млрд (около $66 млн). В настоящее время японские компании и госорганизации в значительной степени полагаются на американских гиперскейлеров, таких как AWS и Microsoft Azure, которые сдавать позиции не собираются и активно инвестируют в развитие инфраструктуры в Японии, в том числе для ИИ. Предполагается, что создание собственного мощного ИИ-комплекса позволит снизить зависимость от иностранных технологий, а также улучшить конкурентоспособность Японии на мировом рынке. Технические детали проекта пока не раскрываются.

Источник изображения: pixabay.com В 2020 году японский суперкомпьютер Fugaku на базе процессоров с архитектурой Arm возглавил глобальный рейтинг TOP500 самых производительных НРС-систем мира. Сейчас его быстродействие составляет около 442 Пфлопс. Однако с момента запуска комплекс Fugaku опустился на четвёртое место в списке TOP500, уступив трём американским суперкомпьютерам — Frontier, Aurora и Eagle, у которых производительность достигает соответственно 1,19 Эфлопс, 585 Пфлопс и 561 Пфлопс. В июле 2023 года METI объявило о планах по развёртыванию суперкомпьютера для генеративного ИИ в новом исследовательском центре Японского национального института передовых технических наук и технологии (AIST). В создании этой системы также принимают участие специалисты Sakura Internet. Кроме того, в Японии запланировано строительство суперкомпьютера ABCI-Q с 2000 ускорителей NVIDIA H100 для исследований в области квантовых вычислений.

20.04.2024 [21:35], Руслан Авдеев

Спрос на электроэнергию в районе Чикаго взлетит на 900 % из-за ИИ ЦОДРазвитие ИИ-систем станет драйвером стремительного роста энергопотребления в районе Чикаго. Глава Exelon Corp. Кальвин Батлер (Calvin Butler) заявил, что ожидается взлёт спроса на электричество для дата-центров на уровне 900 %. Сейчас на территории подразделения Exelon Commonwealth Edison Co. проводятся инженерные исследования, связанные с 25 новыми проектами ЦОД, которые будут совокупно потреблять около 5 ГВт энергии. Для сравнения — сегодня в локальной энергосистеме на ЦОД приходится около 400 МВт. Батлер рассчитывает на завершение до 80 % запланированных проектов строительства новых кампусов. По его словам, операторов ЦОД привлекают низкие тарифы Commonwealth Edison, безуглеродное производство электричества атомными реакторами и налоговые льготы штата Иллинойс. Компании предстоит убедиться, что система сможет справиться с дополнительными нагрузками. Быстро растущий спрос невозможно будет удовлетворить немедленно. Новые дата-центры поначалу будут забирать избыточные мощности из региональной сети, потом получать энергию из других районов и лишь затем — от вновь построенных электростанций. Энергокомпании и регуляторы США отмечают самый масштабный рост спроса на энергию за последние годы. Помимо дата-центров для ИИ-задач, много энергии требуют заводы, строящиеся в рамках программы реиндустриализации, электромобили, тепловые насосы и т.д. Недоступность энергии, по данным Cushman & Wakefield, ограничивает строительство ЦОД. Тем не менее в компании рассматривают Чикаго как ключевой для США рынок, уступающий лишь развитым хабам вроде т.н. «Аллеи дата-центров» в Вирджинии, Атланте и Далласу.

20.04.2024 [20:50], Сергей Карасёв

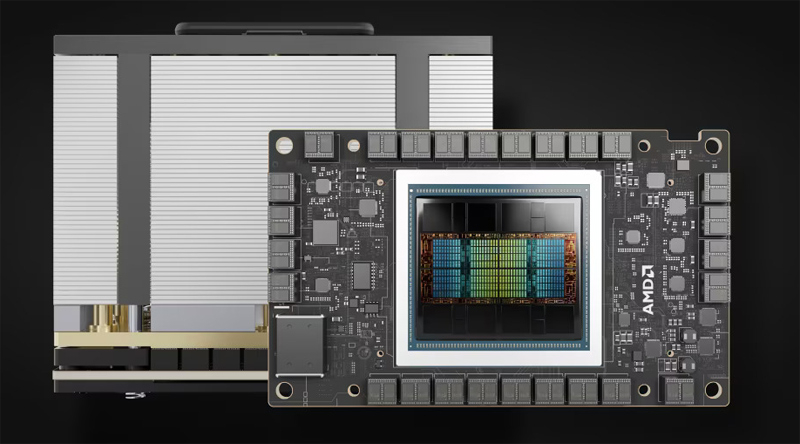

ИИ-облако TensorWave получит 20 тыс. ускорителей AMD Instinct MI300XВ то время как многие операторы облачных платформ и дата-центров закупают ускорители NVIDIA H100 для задач ИИ и НРС, стартап TensorWave, по сообщению ресурса The Register, сделал выбор в пользу решений AMD. Ожидается, что такой подход позволит ускорить развёртывание сервисов и снизить стоимость услуг для заказчиков. Системы класса bare metal будут предлагаться для аренды на определённый период времени по цене от $1/ч/GPU. TensorWave приступила к созданию облачной ИИ-системы на базе ускорителей Instinct MI300X. К концу 2024 года TensorWave планирует установить около 20 тыс. ускорителей MI300X на двух объектах, объединённых RoCE-фабрикой. В 2025-м, как ожидается, будут введены в эксплуатацию дополнительные мощности с СЖО. В дальнейшем планируется внедрение технологии GigaIO FabreX на базе PCIe 5.0, позволяющей объединить до 5750 ускорителей в одном домене с более чем 1 Пбайт памяти НВМ.

Источник изображения: AMD TensorWave использует системы с восемью ускорителями MI300X в одном узле. В одной стойке будут располагаться четыре таких узла. Упомянуто применение системы охлаждения с теплообменниками на задней двери. Судя по фотографиям, стартап использует 8U-серверы Supermicro AS-8125GS-TNMR2. Расчётная мощность составляет приблизительно 40 кВт на стойку. В долгосрочной перспективе TensorWave нацелена на внедрение технологии прямого жидкостного охлаждения чипов, что позволит повысить мощность и плотность размещения оборудования. Соучредитель TensorWave Джефф Татарчук (Jeff Tatarchuk) отмечает, что применение MI300X обеспечивает ряд преимуществ перед изделиями NVIDIA. Это отсутствие столь серьёзного дефицита, более высокая производительность и меньшая стоимость аренды для потребителей облачных ИИ-услуг. Однако, по словам Татарчука, препятствием при коммерциализации сервисов на базе ускорителей AMD может стать то, что потенциальные клиенты выражают неуверенность по поводу возможностей MI300X в сравнении с H100.

20.04.2024 [20:37], Сергей Карасёв

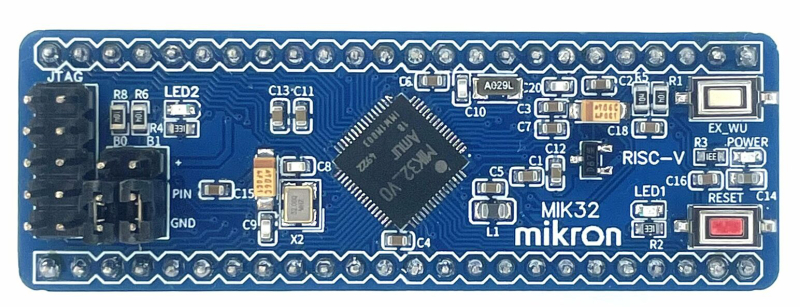

«Микрон» представил российский ПЛК на базе RISC-V для автоматизации критических инфраструктурКомпания «Микрон» (входит в ГК «Элемент») представила прототип первого в России программируемого логического контроллера (ПЛК) на базе «MIK32 Амур» с открытой архитектурой RISC-V. Новинка предназначена для автоматизации критических инфраструктур. Изделие «MIK32 Амур» содержит ядро RISC-V, однократно программируемую память (ПЗУ на 256 бит), ОЗУ ёмкостью 16 Кбайт, а также ПЗУ (EEPROM; 8 Кбайт). Предусмотрены 12-битные АЦП и ЦАП с частотой дискретизации до 1 МГц, датчик температуры, часы реального времени с поддержкой полного календаря. Новый ПЛК, как утверждается, ориентирован прежде всего на те сферы, где требуется обеспечение бесперебойной работы оборудования. Это топливно-энергетические инфраструктуры, светотехника, охранные системы, решения для сектора машиностроения, системы водоснабжения и пр. Изделие обладает следующими техническими характеристиками:

Говорится, что новая разработка снижает зависимость от импортных компонентов и предоставляет возможность в короткие сроки обеспечить российским защищённым решением объекты критической инфраструктуры. Сроки начала массовых поставок изделия не уточняются.

20.04.2024 [20:33], Сергей Карасёв

«Группа Астра» создала компанию «Иксдата» по выпуску ПАК для высоконагруженных СУБД и анализа данных«Группа Астра», по сообщению «Интерфакса», сформировала дочернюю компанию «Иксдата», которая займётся созданием программно-аппаратных комплексов (ПАК) для высоконагруженных систем и платформ анализа данных. Предполагается, что на новых решениях будет применяться ПО «Тантор Лабс» (входит в «Группу Астра»). Генеральным директором «Иксдата» назначен Вадим Яценко, который занимает аналогичную должность в «Тантор Лабс». По его словам, создание новой структуры необходимо для соблюдения требований регуляторов. В частности, для включения ПАК в Реестр российской радиоэлектронной продукции Минпромторга необходимо иметь собственную производственную площадку. «Тантор Лабс» для организации выпуска ПАК не подходит, поскольку в её сферу деятельности входит только разработка ПО. «Для того чтобы собирать и организовывать производство ПАК с нашей СУБД Tantor, нам необходимо юрлицо с другими ОКВЭД. Для удовлетворения требований регулятора и было создано новое юрлицо», — говорит Яценко. Вместе с тем «Иксдата» не будет заниматься непосредственно производством аппаратных решений. Для этих задач планируется привлечь OEM-партнёров, в числе которых называются «Аквариус», Yadro, Kraftway, Delta Solutions и др.

Источник изображения: «Тантор Лабс» В этом году «Тантор Лабс» и группа «Аквариус» представили ПАК Tantor XData. Аппаратная часть данной платформы включает серверы на процессорах Intel Xeon Cascade Lake-SP, AMD EPYC, Baikal-S или Kunpeng 920. Программная составляющая объединяет серверную ОС Astra Linux Special Edition, три связанных репликацией экземпляра СУБД Tantor Special Edition, а также модули Tantor Appliance Manager и Backman. Компоненты ПАК Tantor XData включены в реестры Минпромторга России и Минцифры России. По всей видимости, компания «Иксдата» займётся дальнейшей разработкой систем Tantor XData. Отмечается, что для «Группы Астра» развитие СУБД в плане создания решений для управления и анализа данными, включая ПАК, является одним из наиболее перспективных направлений бизнеса. Ожидается, что такие продукты обеспечат рост финансовых показателей — выручки и чистой прибыли — в три раза в течение ближайших двух лет. Среди прочих новых инициатив называются разработка и запуск различных облачных услуг для крупного и среднего бизнеса.

20.04.2024 [13:01], Сергей Карасёв

AWS закрыла службу Snowmobile по транспортировке данных на фурахОблачная платформа Amazon Web Services (AWS), по сообщению ресурса Datacenter Dynamics, закрыла сервис Snowmobile, в рамках которого предлагались услуги по физической транспортировке огромных массивов данных на грузовиках. Теперь в семействе AWS Snow доступны только предложения Snowball и Snowcone. Служба Snowmobile была запущена в 2016 году. Идея заключалась в том, что клиенты могли перемещать свои данные в облако AWS на фурах, вместо использования традиционных сетевых каналов. В случае массивов, исчисляющихся петабайтами, это обеспечивало значительный выигрыш во времени. Для Snowmobile использовались грузовики со 45-футовыми контейнерами с системами хранения общей вместимостью 100 Пбайт. Для загрузки данных из ЦОД клиента применялись линии с общей пропускной способностью на уровне 1 Тбит/с. При такой скорости заполнить весь доступный объём накопителей Snowmobile можно было примерно за 10 дней. После этого информация транспортировалась в ближайший регион AWS, где выгружалась на серверы облачного провайдера. Перемещение каждой фуры отслеживалось посредством GPS с возможностью передачи телеметрии через сотовые и спутниковые каналы. Стоимость услуг оценивалась в $0,005 за 1 Гбайт в месяц. Таким образом, для заказчиков, которым нужно было переместить в облако 100 Пбайт информации, услуга обходилась в $500 тыс. Как сообщили в AWS, решение о закрытии Snowmobile связано с тем, что с момента её запуска появились другие сервисы и функции, которые сделали перемещение данных в облако удобнее, быстрее и дешевле для клиентов. Это, в частности, устройство Snowball Edge размером с чемодан, которое может быть оснащено быстрыми SSD-накопителями, а также более компактное решение Snowcone.

20.04.2024 [12:49], Руслан Авдеев

Oracle инвестирует $8 млрд в облака и ИИ в Японии, а Fujitsu станет одним из ключевых партнёровOracle Corporation Japan объявила о намерении инвестировать более $8 млрд в следующие десять лет в облачные вычисления и ИИ-инфраструктуру в Японии. Как сообщает Media Newswire, благодаря новым вложениям будет расширено присутствие Oracle Cloud Infrastructure (OCI) в стране, дополнительно примут меры для обеспечения требуемого государством «цифрового суверенитета» Японии. В частности, Oracle намерена существенно расширить в Японии штат локальных команд и организовать деятельность в соответствии с требованиями регуляторов к обеспечению местного цифрового суверенитета. В планах — расширение поддержки облачных регионов в Токио и Осаке, запущенных в 2019–2020 гг., а также платформ Oracle Alloy и OCI Dedicated Region. В результате правительственные органы и бизнесы по всей стране смогут беспрепятственно использовать Oracle Cloud с суверенными ИИ-решениями. Сервисы будут работать в пределах границ страны или на собственных мощностях организаций. Так, Fujitsu выбрала платформу Oracle Alloy для внедрения суверенных облачных сервисов. При этом пользовательские облака на платформе совместимы с собственными облаками Oracle, в результате чего клиентам будут доступны ресурсы гиперскейлеров. Используя Alloy, Fujitsu расширит внедрение своего гибридного предложения Fujitsu Uvance. Компания станет использовать Oracle Alloy в своих дата-центрах в Японии, что обеспечит её клиентам доступ к более 100 облачных сервисов Oracle с соблюдением требований к безопасности и обеспечению цифрового суверенитета. Как сообщают в самой Fujitsu, компания будет использовать накопленный на японском рынке опыт для расширения бизнеса с применением Oracle Alloy на другие рынки. Fujitsu уже присутствует в 35 странах. Сделку анонсировали вскоре после того, как Oracle объявила о крупных инвестициях в Японии. Ранее Fujitsu и Oracle уже заключили соглашение, благодаря которому облачные сервисы Oracle должны были предоставляться в ЦОД Fujitsu, предусмотрена и связь с облаком Fujitsu — K5. В прошлом году Oracle анонсировала расширение 66 существующих дата-центров и постройке 100 новых по всему миру, только в этом году капитальные расходы на это должны составить $7–$7,5 млрд.

20.04.2024 [12:17], Сергей Карасёв

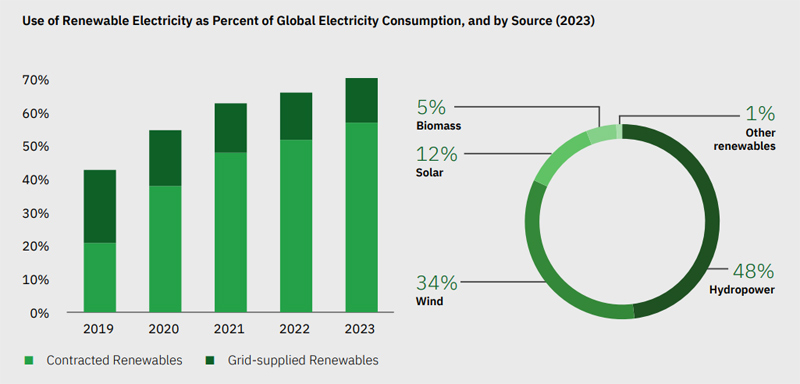

Дата-центры IBM на 74 % переведены на энергию из возобновляемых источниковКомпания IBM опубликовала очередной отчёт ESG об экологическом, социальном и корпоративном управлении. В нём в числе прочего говорится о дальнейшей реализации проектов, направленных на повышение энергоэффективности дата-центров, а также о переходе на энергию из возобновляемых источников. В 2023 году IBM увеличила потребление «зелёной» электроэнергии до приблизительно 1,322 ТВт·ч. Это составляет 70,6 % от общих энергетических нужд корпорации. Годом ранее доля энергии из возобновляемых источников составляла примерно 65,9 %. В отчёте сказано, что дата-центры IBM к концу 2023-го были на 74 % переведены на «зелёную» электроэнергию. В 2022 году этот показатель равнялся 66 %. На сегодняшний день IBM управляет 60 площадками ЦОД по всему миру. Из них 28 дата-центров целиком переведены на энергию из возобновляемых источников. Положительная динамика 2023 года обусловлена прежде всего расширением использования возобновляемых источников энергии в подразделениях корпорации в Индии и в двух облачных дата-центрах IBM в США.

Источник изображения: IBM Компания продолжает реализацию проектов, направленных на повышение энергоэффективности охлаждающего и IT-оборудования, модернизацию систем освещения и оптимизацию операционной эффективности. IBM рассчитывает на 75 % перейти на энергию из возобновляемых источников к 2025 году и на 90 % — к 2030-му. По итогам 2023 года средневзвешенный показатель PUE у IBM составил 1,46, тогда как в 2019-м он составлял 1,55. Компания работает над повышением эффективности охлаждения ЦОД на 20 % к 2025 году по сравнению с базовыми значениями, зафиксированными в 2019 году. Плюс к этому корпорация оптимизирует затраты энергии на освещение и поддержание микроклимата на своих объектах, включая офисные помещения.

20.04.2024 [01:10], Владимир Мироненко

Schneider Electric ведёт переговоры о покупке Bentley SystemsФранцузская корпорация Schneider Electric сообщила в пятницу о ведении переговоров с разработчиком ПО для проектирования инфраструктур Bentley Systems Inc. из Экстона (штат Пенсильвания, США) о возможности его поглощения, пишет агентство Bloomberg. Корпорация пояснила, что переговоры находятся на ранней стадии, добавив, что их проведение обусловлено её стратегией по наращиванию своего потенциала в области промышленных технологий. Компания Bentley Systems производит ПО для инженерных и строительных проектов — от мостов и аэропортов до коммунальных предприятий и шахт. А Schneider Electric — одна из старейших и крупнейших промышленных компаний Франции, являющаяся поставщиком ПО и оборудования для зданий, ЦОД и заводов. За последние пять лет цена акций Schneider Electric утроилась, и её рыночная стоимость выросла до рекордной величины в €120,5 млрд. Французская корпорация также выросла за счёт ряда приобретений на протяжении многих лет, включая покупку в два этапа британского разработчика ПО Aveva за £10,6 млрд. С учётом чистого долга стоимость Bentley Systems оценивается примерно в $18,5 млрд. В случае её приобретения Schneider Electric по этой цене, сделка станет одной из крупнейших покупок в США из числа когда-либо совершенных французской компанией. Среди компаний, выразивших заинтересованность в сделке с Bentley Systems, числятся Schneider Electric и Cadence Design Systems, сообщил один из источников Reuters. Согласно данным газеты Wall Street Journal, Schneider Electric объединит своё подразделение по разработке ПО с Bentley Systems, которая останется публичной компанией. |

|