Лента новостей

|

19.04.2024 [15:14], Руслан Авдеев

5 ГВт уже есть, ещё 2,5 ГВт на подходе: Microsoft стремительно наращивает ёмкость ЦОД и скупает ИИ-ускорителиMicrosoft вынашивает масштабные планы для рынка дата-центров. Согласно закрытым документам, поступившим в распоряжение Business Insider, компания связывает наращивание активности с бумом ИИ-технологий и намерена кратно увеличить ёмкость своих новых ЦОД ещё до конца текущего календарного года. С июля 2023 года (начала текущего фискального года), Microsoft ввела в эксплуатацию новые ЦОД на 500 МВт. Судя по попавшим в руки журналистов документам команды Microsoft Cloud Operations and Innovation, в I половине текущего фискального года общая ёмкость ЦОД Microsoft преодолела отметку 5 ГВт. Бум на рынке ЦОД подогревается развитием генеративных ИИ-систем, а Microsoft является одним из лидеров новой отрасли благодаря сотрудничеству со стартапом OpenAI и использованием её большой языковой модели (LLM) GPT-4. В целом на тренировку и отладку разных моделей уходит огромное количество электроэнергии и вычислительных ресурсов с использованием тысяч ИИ-ускорителей. По мнению экспертов, имеющиеся у Microsoft 5 ГВт полностью освоены — это сопоставимо с мощностями всего Гонконга или Португалии. Тем не менее, компания не намерена останавливаться на достигнутом. Во II половине текущего фискального года (до середины 2024-го календарного) компания намерена добавить вдвое большую ёмкость новых ЦОД (1 ГВт). В I половине 2025 фискального года (до конца 2024-го) — втрое большую (1,5 ГВт). Другими словами, каждый месяц IT-гигант должен добавлять порядка 200 МВт. Как считает экспертное сообщество, компания или рассчитывает на огромный спрос в будущем или просто хочет «застолбить» доступную энергию, которая иначе может достаться конкурентам. С учётом роста углеродных выбросов и водопотребления, к оператору ЦОД возникает у экспертов ряд вопросов относительно экоустойчивости проектов. В самой Microsoft информацию не комментируют. Сообщается, что компания закупила во II половине прошлого года «рекордное количество» ускорителей для своих ИИ-проектов, более чем вдвое увеличив установленное количество, хотя точных значений не называется. В этот период число использованных ускорителей увеличилось в 39 ЦОД, так что теперь у компании есть ИИ-кластеры в 98 локациях по всему миру. В недавнем описании вакансии директора по управлению активами также упоминается, что компания заключила сделки о приобретении 20 ГВт возобновляемой энергии. На реализацию таких проектов иногда уходят годы, поэтому соглашения о покупке энергии (PPA) нередко заключаются на 10 лет. Например, на период до 2032 года Microsoft намерена закупить посредством PPA 9,5 ГВт у солнечных электростанций Qcells — приблизительно по 1,5 ГВт ежегодно. Заодно компания развивает направление малых модульных реакторов (SMR) и подписала соглашение с Helion Energy о закупке электричества с термоядерных реакторов к 2028 году. Также Microsoft активно инвестирует в захват углерода из атмосферы, в своё время пообещав к 2030 году стать «углеродно-нейтральной», а в последующие годы — «углеродно-отрицательной». Так, компания заплатила ClimeWorks для удаления из атмосферы 11,4 тыс. т углерода, а также Running Tide для устранения 12 тыс. т, Carbon Streaming — 10 тыс. т ежегодно и Heirloom — 300 тыс. т. Rомпания и сама патентует технологии удаления углекислоты из атмосферы, в частности — с помощью «мусорного» тепла ЦОД.

19.04.2024 [13:11], Сергей Карасёв

HPE обвинила китайскую Inspur в нарушении серверных патентов и обходе санкций СШАКорпорация HPE, по сообщению The Register, подала в суд на Inspur Group: крупнейший в Китае и один из крупнейших производителей серверов в мире обвиняется в незаконном использовании ряда запатентованных технологий. Иск направлен в инстанцию Северного округа Калифорнии (США). Истцы заявляют, что Inspur нарушила пять патентов HPE. Речь в них идёт, в частности, о методах и системах для управления массивами хранения, средствах определения энергопотребления в IT-сетях, инструментах эмуляции устройств и пр. Утверждается, что Inspur на протяжении нескольких лет игнорировала неоднократные предложения обсудить лицензирование технологий НРЕ. В судебных документах говорится, что в состав Inspire Group входит ряд дочерних компаний, работающих под разными названиями. В число ответчиков включены Inspur Group, Inspur Electronic Information Industry (IEIT Systems), Aivres Systems (ранее известна как Inspur Systems), Betapex (прежнее название — Inspur Asset Holdings), Inspur USA и KAYTUS Singapore Pte. Сама Inspour Group неоднократно попадала под санкции США. Одной из причин смены названий некоторых структур, как отмечается в иске, является то, что в марте 2023 года Inspur Group была внесена в санкционный список Министерства торговли США. Компаниям из этого перечня необходимо получить лицензию от американского правительства для ведения бизнеса в США. Вместо этого, как утверждается в жалобе, Inspur Group просто поменяла имена дочерних компаний, чтобы продолжить продавать свое IT-оборудование на американском рынке. Вместе с тем, как считает НРЕ, компания Inspur продолжает продавать продукты, нарушающие патенты, под другими названиями. Например, сервер Aivres 5280M6, по сути, представляет собой переименованную версию Inspur IR5280M6. Оба решения имеют схожие названия, одни и те же изображения и идентичные технические характеристики. В целом, как говорится в иске, Inspur «нарушила многочисленные патенты HPE». Из-за того, что китайский производитель не ответил на предложения о лицензировании технологий, HPE будет отставить права на интеллектуальную собственность в судебном порядке. О выдвигаемых требованиях ничего не сообщается.

19.04.2024 [10:20], Сергей Карасёв

ИИ на воде: Cerebras установит оборудование в плавучем дата-центре NautilusАмериканский стартап Cerebras Systems, занимающийся разработкой ИИ-ускорителей, по сообщению Datacenter Dynamics, арендует площади в дата-центре на барже Nautilus Data Technologies в Калифорнии. В этом плавучем ЦОД применяется запатентованная технология жидкостного охлаждения Nautilus, основанная на использовании забортной воды. Ранее Nautilus объявила, что неназванная компания в области ИИ подписала договор аренды на площадке в Стоктоне в конце 2023 года. Теперь выясняется, что этим клиентом является стартап Cerebras, который проектирует интегрированные чипы WSE (Wafer Scale Engine) размером с кремниевую пластину с сотнями тысяч ядер для работы с крупными ИИ-моделями. Дата-центр Nautilus в Стоктоне обладает мощностью 6,5 МВт и предлагает до 55 кВт на стойку. Заявленный уровень PUE — 1,15 вне зависимости от времени года или погодных условий. На объекте установлены резервные генераторы с запасом топлива, которого хватит на 26 часов работы при максимальной нагрузке. Забор воды для охлаждения осуществляется из реки Сан-Хоакин. Обеспечивается круглосуточный мониторинг территории усилиями местной службы безопасности, а также патрулирование наземных и водных путей Министерством внутренней безопасности, Береговой охраной США и Департаментом шерифа округа Сан-Хоакин. В рамках подписанного договора Cerebras арендует 2,5 МВт. В ЦОД будут размещены системы Cerebras CS-3 на основе ускорителей WSE-3. Эти изделия насчитывают 4 трлн транзисторов, содержат 900 тыс. ядер и 44 Гбайт памяти SRAM. Заявленная производительность достигает 125 Пфлопс в FP16-вычислениях.

19.04.2024 [09:10], Сергей Карасёв

Tesla столкнулась с трудностями при строительстве дата-центра для ИИ-суперкомпьютера DojoКомпания Tesla, по сообщению ресурса The Information, не укладывается в намеченный график строительства ЦОД в Остине (Техас, США), в котором планируется разместить узлы ИИ-суперкомпьютера Dojo стоимостью $1 млрд. Эта площадка будет использоваться для решения сложных задач в области ИИ и машинного обучения, в частности, связанных с системами автопилотирования. К строительству дата-центра, о котором идёт речь, компания Илона Маска приступила в октябре 2023 года. Известно, что по своей конструкции этот ЦОД будет напоминать бункер. Однако, как стало известно, при возведении комплекса Tesla столкнулась с рядом трудностей. В середине апреля Маск посетил строительную площадку и «пришёл в ярость» из-за увиденного. Вопреки ожиданиям, у объекта отсутствуют большая часть первого этажа и крыша. Наблюдаются сложности с доставкой необходимых материалов, из-за чего возникают задержки при строительстве. Кроме того, ситуация усугубляется из-за того, что основанная Маском компания Boring Company должна проложить под площадкой ЦОД туннель для передвижения электрических пикапов Cybertruck, но эти работы не выполнены. Поэтому невозможно полноценное завершение возведения даже первого этажа.

Источник изображения: Tesla После своего визита Маск уволил директора по строительной инфраструктуре проекта. После этого Tesla сократила более 14 тыс. сотрудников — свыше 10 % от своего штата, насчитывавшего около 140 тыс. человек. Кроме того, компанию покинули несколько топ-менеджеров. О сроках завершения строительства ЦОД в Остине ничего не сообщается. Возникшие задержки, как считается, отражают более широкие проблемы в автомобильной отрасли.

19.04.2024 [07:57], Сергей Карасёв

Создание российского аналога GitHub предложено отменить, а средства направить на поддержку open sourceМинцифры РФ, по сообщению газеты «Коммерсантъ», направило в правительство предложения о пересмотре проекта по созданию национального репозитория открытого кода, который изначально задумывался в качестве аналога популярного GitHub. Новую платформу планировалось запустить до конца апреля 2024-го, но реализовать проект в указанные сроки не удалось. Потребность в отечественном репозитории кода возникла, когда GitHub начал блокировать аккаунты российских разработчиков. В мае 2023-го Минцифры опубликовало список участников эксперимента по созданию аналога GitHub: в него вошли «Базальт СПО» (разработчик операционной системы ALT Linux), «Ред Софт» («Ред ОС») и др. На реализацию проекта планировалось направить более 1,3 млрд руб., которые с 2007-го остаются невостребованными на счетах фонда «Росинфокоминвест». Но эти деньги так и не были выделены, и в марте 2024-го стало известно, что инициатива заморожена. А теперь и вовсе говорится, что разработка репозитория может быть отменена. Вместо этого Минцифры предлагает использовать один из уже действующих сервисов, а указанные средства использовать для поддержки наиболее востребованных проектов в сфере open source и для создания новых IT-продуктов.

Источник изображения: pixabay.com При этом обязательным условием для получения финансовой помощи станет размещение разрабатываемых продуктов в российских репозиториях открытого ПО. «Решено выбрать один из уже существующих общедоступных отечественных репозиториев вместо создания новой площадки»,— заявили в Минцифры. На сегодняшний день в России действуют несколько репозиториев кода. Это, в частности, Mos.Hub правительства Москвы, «РТК-Феникс» и «Лукоморье» от «Ростелекома», «Сфера» от T1, GitFlame от «Иннополиса», GitVerse от «Сбера» и др. Какой из этих сервисов будет выбран для продолжения эксперимента, не уточняется. Участники рынка полагают, что наиболее вероятным претендентом является «РТК-Феникс».

19.04.2024 [07:46], Сергей Карасёв

«Росэлектроника» представила ПАК для суперкомпьютеров с интерконнектом «Ангара»Холдинг «Росэлектроника», входящий в госкорпорацию «Ростех», анонсировал отечественный программно-аппаратный комплекс (ПАК) под названием «Базис», предназначенный для развёртывания облачных сервисов и платформ НРС. Система, как утверждается, может масштабироваться до нескольких сотен узлов. ПАК разработан специалистами Научно-исследовательского центра электронной вычислительной техники (НИЦЭВТ) в составе «Росэлектроники». Решение состоит из трёх серверов общего назначения, каждый из которых может насчитывать до 128 вычислительных ядер и нести на борту до 2 Тбайт оперативной памяти. Отмечается, что системные платы для серверов имеют отечественное происхождение: они спроектированы и произведены в НИЦЭВТ. Более подробно характеристики не раскрываются. Платформа «Базис» использует обновлённую версию российского интерконнекта «Ангара». Достигается пропускная способность до 75 Гбит/с. Разработчики подчёркивают, что сетевое оборудование обеспечивает высокоинтенсивный обмен данными между серверами со сверхнизкой задержкой.

Источник изображения: «Росэлектроника» «Базис» включён в Единый реестр телекоммуникационного и радиоэлектронного оборудования российского происхождения Минпромторга России. На основе ПАК могут создаваться центры обработки и хранения данных, виртуализированные офисы, виртуальные машины, системы для обработки графических приложений, а также суперкомпьютеры для нестандартных расчётов, говорится в сообщении. Благодаря возможностям масштабирования платформа может поддерживать тысячи виртуальных рабочих мест. «Область применения нового программно-аппаратного комплекса очень широка. Например, наши технологии легко справятся с задачей создания виртуализированных инженерных рабочих мест с поддержкой аппаратной обработки 3D-графики. А высокая пропускная способность канала передачи данных и гибкая система масштабирования позволяют проводить сложнейшие вычислительные операции. Наши специалисты готовы рассчитать и адаптировать наш новый ПАК под конкретные задачи и потребности заказчика», — говорит генеральный директор НИЦЭВТ.

18.04.2024 [21:59], Руслан Авдеев

Поддать жару: в Джорджии для питания новых ИИ ЦОД разрешили построить дополнительные ТЭСЭнергетическая компания Georgia Power (GP) получила добро от властей штата Джорджии на увеличение генерирующих мощностей. По данным Datacenter Dynamics, расширение ожидается как за счёт электростанций на возобновляемой энергии, так и на ископаемом топливе. На такие компромиссы пришлось пойти с учётом растущего спроса на электричество со стороны дата-центров. Местный регулятор Georgia Public Service Commission (PSC) подавляющим большинством голосов одобрил планы Georgia Power, предусматривающие генерацию ещё 1,4 ГВт. В процессе задействуют три новых генератора на природном газе или нефти, а также солнечные электростанции — несмотря на то, что против выступили местные сторонники «чистой» энергии. Дополнительно получено разрешение на закупку энергии с газовой электростанции во Флориде и 750 МВт у родственной Mississippi Power Co.

Источник изображения: Ivo Lukacovic/unsplash.com По данным Georgia Power, в последние несколько лет законтрактованный спрос вырос на 6,2 ГВт, из которых 80 % приходится на дата-центры. В прошлом году в Джорджии выросли цены на электричество для бытовых потребителей, поскольку цены на ископаемое топливо были выше, чем ожидалось. По мнению сторонников «зелёной» энергии, хотя пока ископаемое топливо позволяет получать более дешёвую энергию, цены на газ волатильны и со временем снова значительно вырастут. Помимо генераторов на ископаемом топливе, Georgia Power намерена ввести в эксплуатацию солнечные элементы питания на 500 МВт с энергохранилищами уже к концу 2026 года, а к 2027-му добавить ещё одно хранилище энергии. Стоимость всех энергопроектов составит $3 млрд. Некоторые противники проекта жалуются, что генераторы имеют ресурс для работы в течение почти 50 лет, другими словами — Джорджию надолго привязывают к ископаемому топливу. В Джорджии насчитывается 74 дата-центра, большинство из которых расположены в районе Атланты. В числе провайдеров — Digital Realty, Centersquare (ранее Cyxtera/Evoque), Flexential, T5 data Centers, CoreSite, Equinix, DataBank, DC Blox, 365 Data Centers, QTS и EdgeConneX. Только в 2024 году Microsoft приобрела в штате 55 га для своих дата-центров, ещё 174 га купила Amazon. Cвой кампус планирует построить и Meta✴. Другие проекты реализуют Strategic Real Estate Partners и DC Blox.

18.04.2024 [21:35], Владимир Мироненко

Не по средствам: большинство госкомпаний не имеет планов и возможностей перейти на отечественное ПОУ более половины госзаказчиков и госкомпаний нет реальных планов перехода на использование российское ПО, сообщил директор Центра компетенций по импортозамещению в сфере ИКТ (ЦКИТ) Илья Массух на годовом собрании участников АРПП «Отечественный софт», о чем пишет «Интерфакс». Согласно опросу ЦКИТ, об отсутствии реальных планов импортозамещения сообщили 61 % госорганов и 75 % госкомпаний. Как выяснилось, у подавляющего большинства участников опроса (72 % госорганов и 92 % госкомпаний) нет средств для финансирования задекларированных планов по переходу на российское ПО или целевых субсидий для реализации соответствующих проектов (91 % и 78 % соответственно). Также заказчики сообщили об отсутствии инфраструктуры для тестирования отечественного ПО (68 % и 62 %).

Источник изображения: Pixabay Вместе с тем, по данным ЦКИТ, крупнейшие госкомпании из перечня 91-р (97 юрлиц) в течение последних пяти лет наращивали затраты на приобретение софта, включая российский. В 2022 году они израсходовали на покупку ПО 295 млрд руб., включая 203 млрд руб. на российское ПО, а в 2023 году их затраты выросли до 344 млрд руб. (290 млрд руб. на российское ПО). В 2024 году этот показатель должен увеличиться до 370 млрд руб. (334 млрд руб.). Напомним, что 12 июня 2023 года президент Владимир Путин подписал поручение госкомпаниям обеспечить к 1 января 2025 года переход на использование российских ОС, офисного ПО, СУБД и систем виртуализации. В эти же сроки, по решению правительства, объекты критической информационной инфраструктуры (КИИ) должны перейти на преимущественное использование российского ПО.

18.04.2024 [16:38], Руслан Авдеев

Сбой Microsoft Azure в Южной Африке был вызван массовым повреждением подводных кабелей сразу на двух побережьях континентаВ марте облако Microsoft Azure в Южной Африке пострадало от масштабного сбоя. Datacenter Dynamics сообщает, что его причиной стали повреждения кабелей, проложенных по морскому дну. Как информируют в Microsoft, нарушения в работе 14 и 15 марта произошли в северном и восточном облачных регионах Azure в стране. Позже выяснилось, что причиной стали повреждения кабелей как у восточного, так и у западного побережий Африки. В Microsoft заявляют, что в ЮАР у компании работала схема резервирования 4x — весь трафик в регион и из него шёл четырьмя отдельными путями на случай, если одна из магистралей пострадает. Даже если будут повреждены три из четырёх маршрутов, облако всё равно должно нормально функционировать. Однако в этм случае ущерб был нанесён «трём с половиной из четырёх» маршрутов, так что у Microsoft не осталось возможностей организовать стабильную работу. Первая проблема возникла в Красном море. Сегодня предполагается, что причиной повреждения кабелей стал корабль, своим якорем буквально вспахавший участок морского дна. Microsoft регулярно проводит моделирование возможных инцидентов и отрабатывает меры борьбы с ними. После сбоя на восточном побережье компания занялась наладкой обходных маршрутов, так что работы уже велись к моменту второго сбоя. Следующий обрыв произошёл из-за сейсмической активности у западного побережья Африки недалеко от Ганы. Он оставил Microsoft без достаточной пропускной способности. К месту обрыва были отправлены ремонтные корабли из Кейптауна. Хотя обрывы кабелей происходят довольно часто, именно подводные линии чинить намного сложнее — иногда они находятся в тысячах километрах от любого порта, а специальных ремонтных судов во всём мире очень мало. Если на ремонт наземного кабеля обычно уходит от четырёх до шести часов, то морского — недели, если не больше. После второго инцидента Microsoft ускорила прокладку пятого маршрута, от Йоханнесбурга к облачному региону в ОАЭ. Кроме того, инвестировано более $100 млн в расширение пропускной способности с помощью собственного оборудования Microsoft. Ещё одной мерой стал перенос edge-площадки из Нигерии в ЮАР — местным клиентам Microsoft придётся перенаправлять трафик в другие облачные регионы. После того, как кабели починят, площадка в Нигерии вернётся к нормальной работе. Наконец, Microsoft пользуется услугами брокера для аренды необходимой пропускной способности, который и решает, какие сервисы будут получать ресурсы в приоритетном порядке. В феврале 2024 года Microsoft анонсировала планы строительства нового кампуса ЦОД в Центурионе (Южная Африка). Компания стала первым облачным провайдером, зашедшим в страну, ещё в 2019 году она открыла два региона Azure в Йоханнесбурге и Кейптауне. Впрочем, в 2021 году облако в последнем исключили из перечня активных, переклассифицировав в «регион резервного доступа».

18.04.2024 [15:16], Андрей Крупин

Состоялся релиз новой версии операционной системы Kaspersky Thin Client для тонких клиентов

kasperskyos

software

информационная безопасность

лаборатория касперского

операционная система

сделано в россии

тонкий клиент

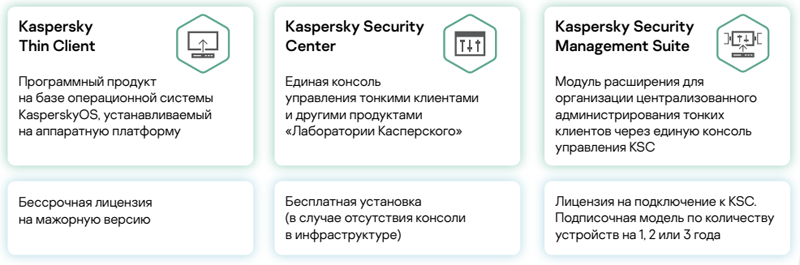

«Лаборатория Касперского» сообщила о выпуске обновлённой операционной системы для тонких клиентов — Kaspersky Thin Client 2.0. Kaspersky Thin Client представляет собой защищённую на уровне архитектуры платформу на базе KasperskyOS, которая может быть использована в организациях с большой филиальной сетью и географически распределённой инфраструктурой бизнеса. Для централизованного и безопасного управления инфраструктурой тонких клиентов используется единая консоль Kaspersky Security Center. Также она применяется для управления и другими продуктами «Лаборатории Касперского». Для подключения тонких клиентов к консоли предусмотрен модуль расширения Kaspersky Security Management Suite.

Источник изображения: «Лаборатория Касперского» Включённые в состав новой версии Kaspersky Thin Client инструменты позволяют подключаться к удалённым средам, развёрнутым на платформе Citrix Workspace и инфраструктуре VMware Horizon, с использованием технологии HTML5. Также ОС поддерживает подключение к отдельным бизнес-приложениям на инфраструктуре Microsoft Remote Desktop Services, Windows Server и терминальных серверах, работающих под управлением Windows 10/11. В числе прочих изменений отмечается возросшая скорость доставки приложений на удалённый рабочий стол и обновлений ОС — благодаря компактному размеру образа платформы. В дополнение к этому Kaspersky Thin Client 2.0 получила поддержку аудиоконференций и возможность печати документов из гостевой операционной системы. Доработкам также подвергся дизайн панели подключения к удалённой среде, появилась возможность персонализированной настройки интерфейса. Кроме того, в уведомлениях теперь отображаются детализированные сообщения об ошибках с советами по их устранению, сама система уведомлений расширена. |

|