AWS объявила об общедоступности недорогих и высокопроизводительных инференс-инстансов Amazon EC2 Inf2 для генеративного ИИ. Новинки используют фирменные ИИ-ускорители Inferentia2. Как утверждает AWS, это самый экономичный и энергоэффективный вариант запуска моделей генеративного ИИ, таких как GPT-J или Open Pre-Trained Transformer (OPT).

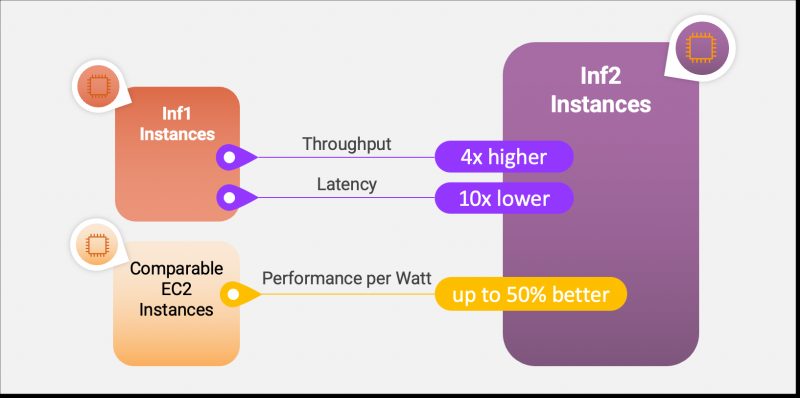

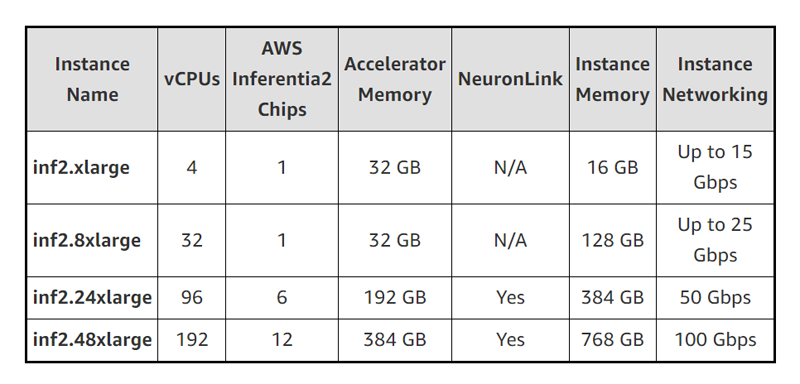

По сравнению с инстансами Amazon EC2 Inf1 инстансы Inf2 обеспечивают до 4 раз более высокую пропускную способность и до 10 раз меньшую задержку (в таких же пределах ускорители Inferentia2 превосходят Inferentia). В настоящее время доступно четыре варианта инстансов Inf2, имеющих до 12 ускорителей AWS Inferentia2 со 192 vCPU, связанных интерконнектом NeuronLink v2. Их совокупная вычислительная мощность достигает 2,3 Пфлопс (BF16 или FP16).

Инстансы Inf2 предлагают до 384 Гбайт общей памяти, по 32 Гбайт памяти HBM у каждого чипе Inferentia2, и общую пропускную способность памяти (ПСП) 9,8 Тбайт/с. Такая ПСП особенно важна для для исполнения больших языковых моделей (LLM). А поскольку чипы AWS Inferentia2 специально созданы для ИИ-нагрузок DL, инстансы Inf2 показывают не менее чем на 50 % лучшее соотношение производительности на Ватт по сравнению с другими сопоставимыми EC2-инстансами.

Как и ускоритель AWS Trainium, AWS Inferentia2 имеет два блока NeuronCore-v2, стеки HBM и выделенные механизмы коллективных вычислений для распараллеливания нагрузки на нескольких ускорителях. NeuronCore-v2 включает аппаратные движки для скалярных, векторных и тензорных (матричных) вычислений, а также 512-бит блок GPSIMD, блоки DSP, SRAM и некоторые другие узкоспециализированные движки. Ускоритель поддерживает выполнение кастомных обработчиков (C/C++, PyTorch).

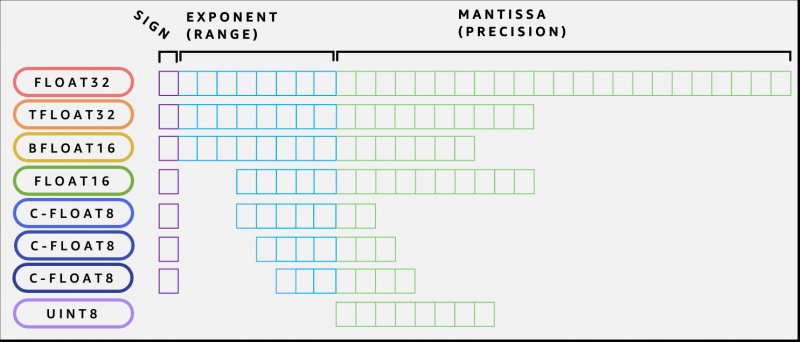

AWS Inferentia2 поддерживает широкий спектр типов данных, включая FP32, TF32, BF16, FP16 и UINT8, позволяя выбрать наиболее подходящий тип данных для своих рабочих нагрузок. Он также поддерживает новый настраиваемый тип данных FP8 (cFP8), который особенно актуален для больших моделей. По словам компании, такие гибкость и реконфигурируемость чипа позволяют добиться максимальной эффективности выполнения ИИ-нагрузок.

Источник: